近年、プログラミングの分野で人工知能(AI)がますます広く使用されていますが、その能力には依然として特定の制限があります。最近、BuzzFeedのシニアデータサイエンティストであるMax Woolfは、一連の実験を通じて、AIによって生成されたコードの品質が、大規模な言語モデル(LLMS)のヒントを継続的に提供することで大幅に改善できることを発見しました。この発見は、テクノロジーサークルでの熱烈な議論を引き起こしただけでなく、多くのAI科学者の注目を集め、AIプログラミングにおける反復的最適化と迅速な単語設計の重要性をさらに強調しました。

Woolfの実験では、彼はAIモデルClaude3.5Sonnetを研究オブジェクトとして選択しました。実験の最初のステップは、モデルが比較的単純なプログラミングの問題を解決できるようにすることです。各桁の合計の最小値と最大値の違いを見つける方法は、100万のランダム整数で30です。タスクを受信した後、クロードは要件を満たすコードを迅速に生成しましたが、ウルフはこのコードに改善の余地がまだあると考えています。

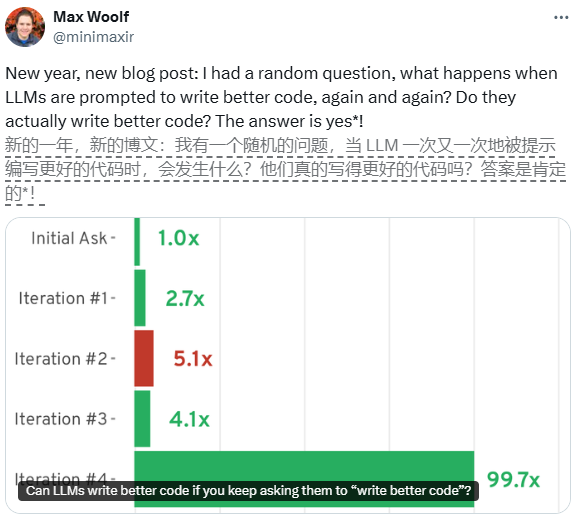

コードをさらに最適化するために、WoolfはClaudeにコードの各世代の後に繰り返し最適化するように依頼することにしました。最初の反復の後、クロードはコードをオブジェクト指向のPythonクラスにリファクタリングし、2つの重要な最適化を実装し、コードを2.7倍高速に増加させました。 2回目の反復では、クロードはさらにマルチスレッド処理とベクトル化されたコンピューティングを導入しました。これにより、最終的にコードは基本バージョンよりも5.1倍高速で実行できました。

ただし、反復の数が増えると、コードの品質の向上は徐々に遅くなります。このモデルは、その後の反復でJITコンピレーションや非同期プログラミングなどのより複雑な手法を試みましたが、これらの最適化は予想されるパフォーマンスの改善をもたらさず、場合によってはパフォーマンスの低下にさえつながりました。この現象は、反復的なヒントは初期段階でコードの品質を大幅に改善できるが、特定のレベルに達した後、その効果は徐々に弱まることを示しています。

Woolfの実験は、プログラミングの分野におけるAIの大きな可能性を実証するだけでなく、実際のアプリケーションにおけるその限界も明らかにしています。 AIは反復的にコードを最適化できますが、迅速な単語を設計するときにパフォーマンスと複雑さのバランスをとる方法は、詳細に議論する必要がある問題です。この研究は、将来のAIプログラミングの新しいアイデアを提供し、AIは全能ではないことを思い出させます。合理的な使用と最適化戦略が重要です。