Meta Fair, UC Berkeley 및 New York University 연구팀은 LLM (Lange Language Models)의 교육 규정 준수 및 대응 품질을 크게 향상시키기 위해 Thinking Preverence Optimization (TPO)이라는 새로운 기술을 개발하는 데 협력했습니다. 답변을 직접 제공하는 전통적인 LLM과 달리 TPO 기술을 사용하면 모델이 답장하기 전에 내부적으로 생각하고 반영하여보다 정확하고 일관된 답변을 생성 할 수 있습니다. 이 혁신은 모델을 사용자에게 중간 단계를 보여주지 않고 사고 프로세스를 최적화하여 궁극적으로 개선 된 체인 사고 (COT) 추론 방법을 통해 응답 품질을 향상시킵니다.

TPO 기술의 핵심은 개선 된 체인 사고 (COT) 추론 방법입니다. 이 접근법은 모델이 훈련 중에 "생각하고 답변"하도록 권장하여 최종 답변을 제공하기 전에보다 체계적인 내면의 사고 과정을 구축 할 수 있도록 권장합니다. 전통적인 COT 신호는 때때로 정확도를 줄이고 명확한 사고 단계가 없기 때문에 훈련하기가 매우 까다로워집니다. 또한 TPO는 모델이 사용자에게 중간 단계를 노출시키지 않고도 사고 과정을 최적화하고 단순화 할 수 있도록함으로써 이러한 과제를 성공적으로 극복합니다.

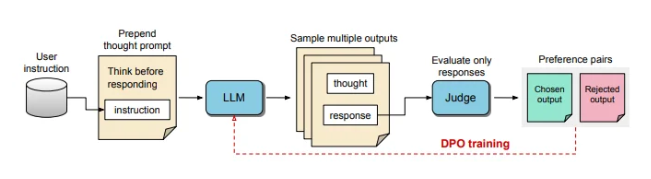

TPO 교육 과정에서 먼저 큰 언어 모델에 여러 아이디어를 생성 한 다음 최종 답변을 정렬하십시오. 그런 다음 이러한 출력은 "심사 위원"모델에 의해 평가되어 최상의 성과와 최악의 성과 답변을 선택합니다. 이러한 평가 결과는 모델의 응답 품질을 지속적으로 향상시키기 위해 직접 환경 설정 최적화 (DPO)를위한 "선택"및 "거부"쌍으로 사용됩니다.

TPO는 교육 프롬프트를 조정함으로써 모델이 대답하기 전에 내부적으로 생각하도록 권장합니다. 이 프로세스는 모델을 안내하여 답변을 최적화하여보다 명확하고 관련성이 높습니다. 궁극적으로, 평가는 최종 답변 만 점수를 매기는 LLM 기반 판단 모델에 의해 수행되므로 모델이 숨겨진 사고 단계와 독립적으로 답변의 품질을 향상시키는 데 도움이됩니다. TPO는 또한 직접 선호도 최적화를 사용하여 숨겨진 사고를 포함하는 우선 및 거부 답변을 만들고 여러 라운드의 훈련 후 모델의 내부 프로세스를 더욱 세분화합니다.

Alpacaeval 및 Arena-Hard의 벤치 마크에서 TPO 방법은 전통적인 응답 기준보다 우수했으며 "사고 팁"의 LLAMA-3-8B 비조장 모델보다 우수했습니다. 이 방법의 반복 교육은 사고 생성 기능을 최적화하여 궁극적으로 여러 기준 모델을 능가합니다. TPO는 논리 및 수학적 작업에 적합 할뿐만 아니라 마케팅 및 건강 지침과 같은 창의적인 분야에서 작업을 따르는 데 큰 노력을 기울이고 있음을 언급 할 가치가 있습니다.

AI와 로봇 공학 전문가 인 Karan Verma는 소셜 플랫폼 X에 대한 "Thinking LLM"이라는 개념에 대한 그의 견해를 공유했으며, 더 많은 치료 효과를 가져올 수있는 의료 응용 분야에서 이러한 혁신의 잠재력을 기대했습니다 .

이 구조화 된 내부 사고 프로세스를 통해 모델은 복잡한 지침을보다 효과적으로 처리 할 수 있으며, 인간이 특정 사고 데이터를 제공 할 필요없이 다단계 추론과 세심한 이해가 필요한 영역에서 적용을 더 확장 할 수 있습니다. 이 연구는 TPO가 다양한 상황에서 대형 언어 모델을보다 유연하고 효율적으로 만들 수있는 잠재력을 가지고 있으며, 이는 유연성과 응답 생성의 깊이에 대한 요구 사항이 높은 영역에 적합합니다.

TPO 기술의 발전은 대형 언어 모델에 더 강력한 추론과 이해력을 가져 왔으며, 특히 복잡한 사고 과정이 필요한 작업에서 다양한 분야에서 새로운 가능성을 열어주었습니다.