カリフォルニア州バークレーとニューヨーク大学の研究チームは、大規模な言語モデル(LLM)の命令コンプライアンスと応答品質を大幅に向上させるために、思考優先最適化(TPO)と呼ばれる新しいテクノロジーの開発について協力しています。回答を直接提供する従来のLLMとは異なり、TPOテクノロジーにより、モデルは返信する前に内部的に考えることと反射を可能にし、それにより、より正確で一貫した答えを生成します。このイノベーションは、ユーザーに中級の手順を表示せずに思考プロセスを最適化するようにモデルを導き、最終的には改善されたチェーン思考(COT)推論方法を通じて応答の品質を向上させます。

TPOテクノロジーの中核は、改良されたチェーン思考(COT)推論方法です。このアプローチは、モデルがトレーニング中に「考えて回答」することを奨励し、最終的な答えを提供する前に、より組織化された内的思考プロセスを構築するのに役立ちます。従来のCOTキューは、精度が低下することがあり、明確な思考の手順がないためにトレーニングするのが非常に難しい場合があります。また、TPOは、ユーザーに中間ステップを公開することなく、モデルが思考プロセスを最適化および簡素化できるようにすることで、これらの課題を克服します。

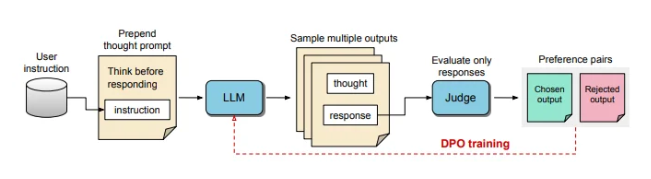

TPOトレーニングプロセス中に、最初に大規模な言語モデルに複数のアイデアを生成するように促し、次に最終的な回答を整理します。これらの出力は、「Judger」モデルによって評価され、最高のパフォーマンスと最悪のパフォーマンスの回答を選択します。これらの評価結果は、モデルの応答品質を継続的に改善するために、直接優先最適化(DPO)のために「選択」および「拒否」ペアとして使用されます。

トレーニングプロンプトを調整することにより、TPOは、回答する前にモデルを内部的に考えるよう奨励します。このプロセスは、モデルをガイドして、回答を最適化して、より明確かつより関連性の高いものにします。最終的に、この評価は、最終的な答えのみをスコアリングするLLMベースの判断モデルによって行われ、それによってモデルが隠された思考ステップとは無関係に答えの品質を改善するのに役立ちます。 TPOはまた、直接的な優先最適化を使用して、隠された思考を含む優先および拒否の回答を作成し、複数回のトレーニングの後、モデルの内部プロセスをさらに改善します。

アルパカエバルとアリーナハードのベンチマークでは、TPOメソッドは従来の応答ベースラインよりも優れており、「思考のヒント」のラマ-3-8Bインスレクトモデルよりも優れていました。この方法の反復トレーニングは、思考生成能力を最適化し、最終的に複数のベースラインモデルを上回ります。 TPOは論理や数学のタスクに適しているだけでなく、タスクに従うためのマーケティングや健康指示などの創造的な分野でも多大な努力をしていることに言及する価値があります。

AIとロボット工学の専門家であるKaran Vermaは、ソーシャルプラットフォームXで「LLMを思う」という概念についての意見を共有し、より多くの患者をもたらす医療アプリケーションのこの革新の可能性を楽しみにしています。

この構造化された内部思考プロセスにより、モデルは複雑な命令をより効果的に処理することができ、人間が特定の思考データを提供する必要なく、マルチレベルの推論と綿密な理解を必要とする領域でのアプリケーションをさらに拡大することができます。この研究は、TPOが、反応生成の柔軟性と深さのために高い要件がある領域に適した、多様なコンテキストで大規模な言語モデルをより柔軟で効率的にする可能性があることを示しています。

TPOテクノロジーのブレークスルーの進歩は、特に複雑な思考プロセスを必要とするタスクで、さまざまな分野でのアプリケーションの新しい可能性を大規模な言語モデルに強くし、理解をもたらしました。