논문의 공식 코드 " 글라이더 : 글로벌 및 지역 교육 중심 전문가 라우터 ". 우리의 코드베이스는 phatgoose에 기반을두고 있습니다.

GLIDER -LORA와 같은 전문 전문가 모음을 통해 Held-in/-out 작업을 동시에 배달하십시오!

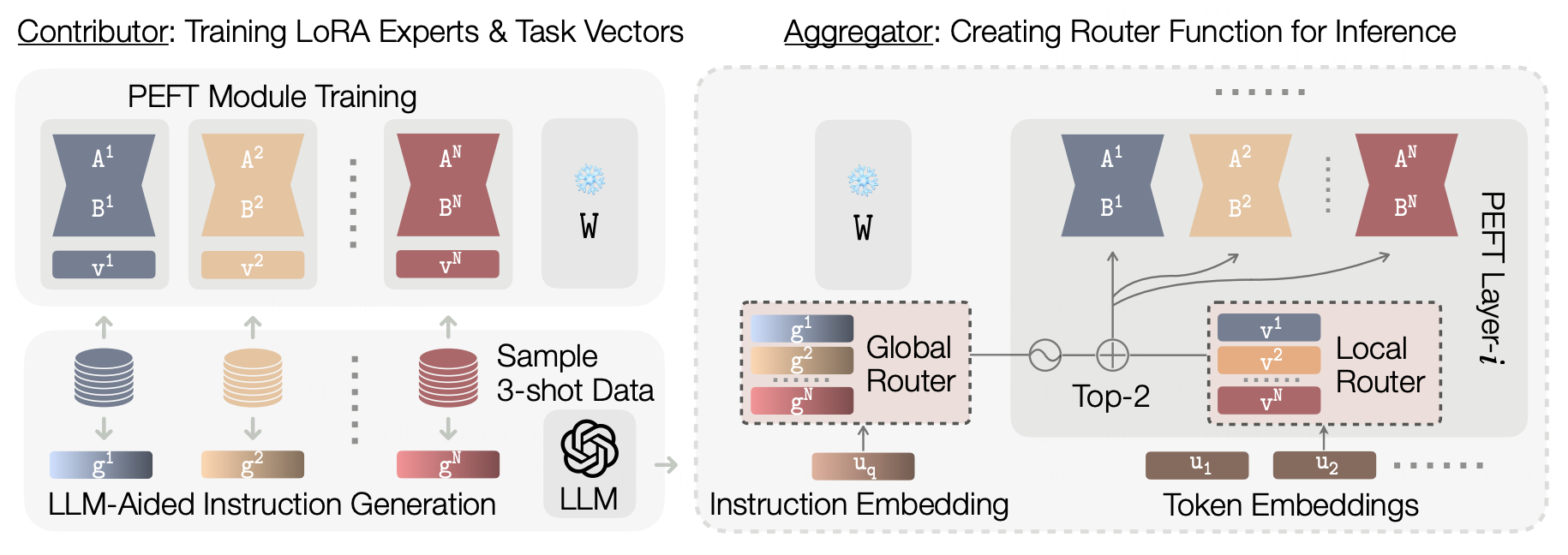

수행자 미리 훈련 된 모델의 가용성은 특정 도메인에 특화된 미세 조정 된 전문가 모델의 확산을 가져 왔습니다. 이를 통해 전문가 모듈을 사용하여 성능 또는 일반화가 향상된 집계 시스템을 생성하는 것을 목표로 강력하고 적응 형 라우팅 기반 "Model Moerging"메소드를 생성 할 수있었습니다. 그러나 기존의 무어 방법은 종종 보류 작업에 대한 성능을 희생하여 보이지 않는 작업에 대한 일반화의 우선 순위를 정해 실제 배포 시나리오에서 실제 적용 가능성을 제한합니다. 우리는 현재 토큰 수준의 라우팅 메커니즘이 입력 작업의 글로벌 시맨틱 컨텍스트를 무시한다는 것을 관찰합니다. 이 토큰 별 독립성은 라우팅 결정이 작업의 의미 론적 특성을 통합하지 못하기 때문에 보류 작업에 대한 효과적인 전문가 선택을 방해합니다. 이를 해결하기 위해 우리는 의미 론적 글로벌 라우터와 학습 된 로컬 라우터를 포함하는 다중 규모 라우팅 메커니즘을 통합하는 글로벌 및 로컬 교육 중심 전문가 라우터 (Glider)를 제안합니다. 글로벌 라우터는 Semantic 관련 상황에 대한 LLM의 고급 추론 기능을 활용하여 전문가 선택을 향상시킵니다. 입력 쿼리 및 LLM이 주어지면 라우터는 모든 계층에서 가장 관련성이 높은 전문가의 검색을 안내하는 시맨틱 작업 지침을 생성합니다. 이 글로벌 지침은 각 모듈 내의 토큰 수준의 라우팅 결정을 용이하게하는 로컬 라우터에 의해 보완되어 보이지 않는 작업에서 더 미세한 제어 및 성능을 향상시킬 수 있습니다. T0 및 FLAN 작업에 T5 기반 모델을 사용한 실험은 Glider가 실질적으로 개선 된 보류 성능을 달성하면서 유지되는 작업에 대한 강력한 일반화를 유지한다는 것을 보여줍니다. 우리는 또한 글라이더의 구성 요소에 더 깊이 뛰어 들기 위해 절제 실험을 수행합니다. 우리의 실험은 무너진 방법에 대한 LLM 중심 시맨틱 추론을 활용하는 다중 규모 라우팅의 중요성을 강조합니다.

conda create -n glider python=3.9

conda activate glider

conda install git-lfs

pip install -r requirements.txt

pip uninstall peft -y cd src && mkdir saved_runs && cd saved_runs

git lfs install

# Glider LLM-Generated task embeddings

git clone https://huggingface.co/MoE-UNC/gpt-generated-instruction-nomic-embeddings

# P3 LoRA checkpoints (derived from Phatgoose)

git clone https://huggingface.co/MoE-UNC/p3-lora-checkpoints

# FLAN LoRA checkpoints (derived from Phatgoose)

git clone https://huggingface.co/MoE-UNC/flan-lora-checkpoints

# Baseline- Arrow checkpoints

git clone https://huggingface.co/MoE-UNC/p3-lora-checkpoints-arrow

# Baseline - Merged Experts checkpoints (derived from Phatgoose)

git clone https://huggingface.co/MoE-UNC/phatgoose-checkpoints 결과를 재현하려면 src/scripts/paper-eval.sh 에서 명령 및 댓글을 확인하십시오.

@misc { li2024glidergloballocalinstructiondriven ,

title = { Glider: Global and Local Instruction-Driven Expert Router } ,

author = { Pingzhi Li and Prateek Yadav and Jaehong Yoon and Jie Peng and Yi-Lin Sung and Mohit Bansal and Tianlong Chen } ,

year = { 2024 } ,

eprint = { 2410.07172 } ,

archivePrefix = { arXiv } ,

primaryClass = { cs.LG } ,

url = { https://arxiv.org/abs/2410.07172 } ,

}