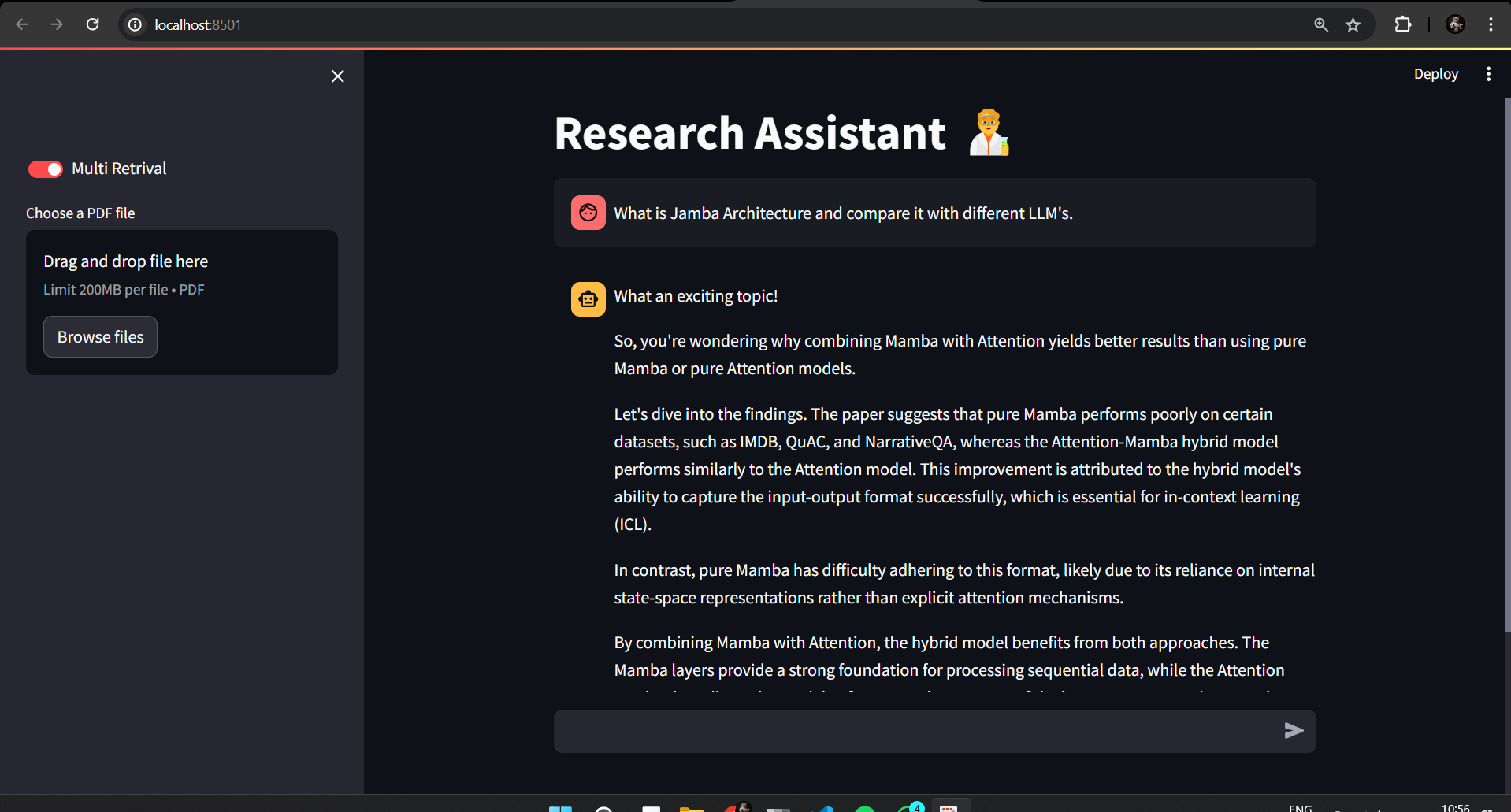

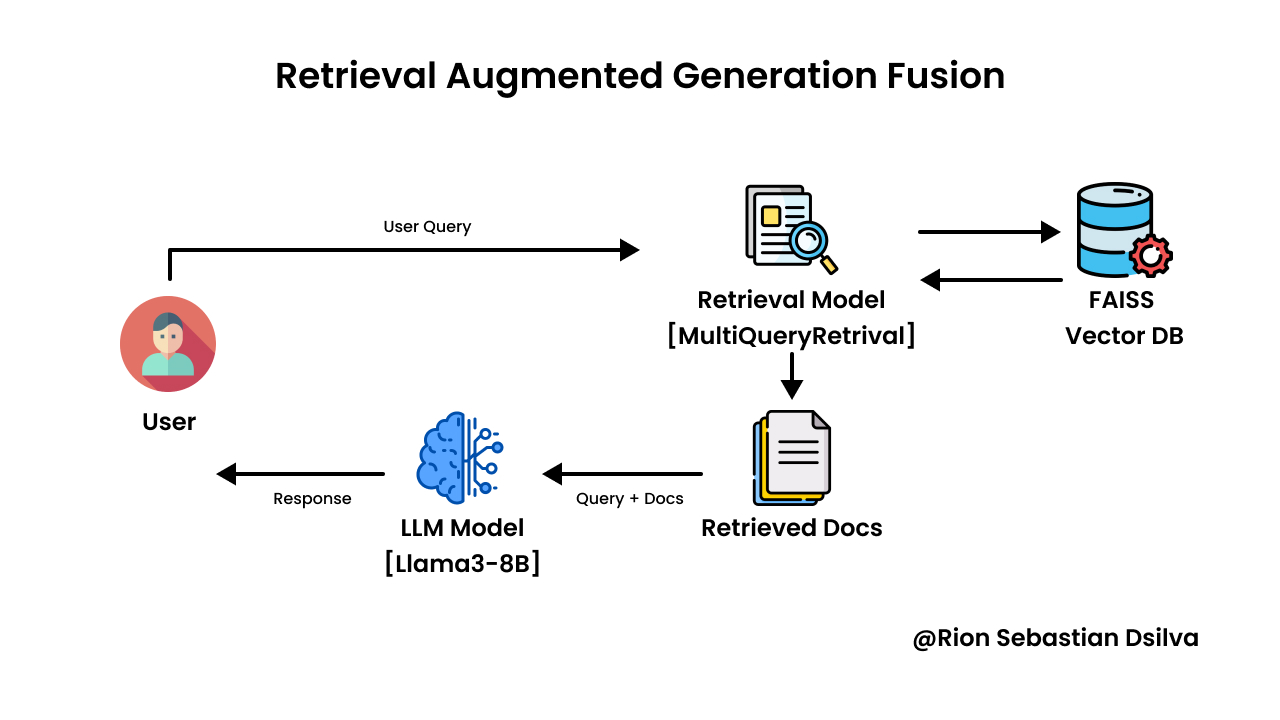

Ollama, Langchain, LLAMA3-8B, FAISS 및 MISTRAL-7B를 사용한 오프라인 검색 증기 생성 퓨전 (Rag-Fusion) 애플리케이션

참조 용지 -https://arxiv.org/pdf/2402.03367

이 프로젝트는 효율적인 로컬 리소스를 활용하여 텍스트 생성 및 검색을위한 완전한 오프라인 래그 퓨전 응용 프로그램을 구현합니다.

- 오프라인 작동 : 인터넷 연결없이 전적으로 실행되므로 제한되거나 신뢰할 수없는 네트워크 액세스가있는 시나리오에 이상적입니다.

- 제로 비용 : 무료로 이용 가능한 오픈 소스 도구를 활용하여 인프라 비용을 최소화합니다.

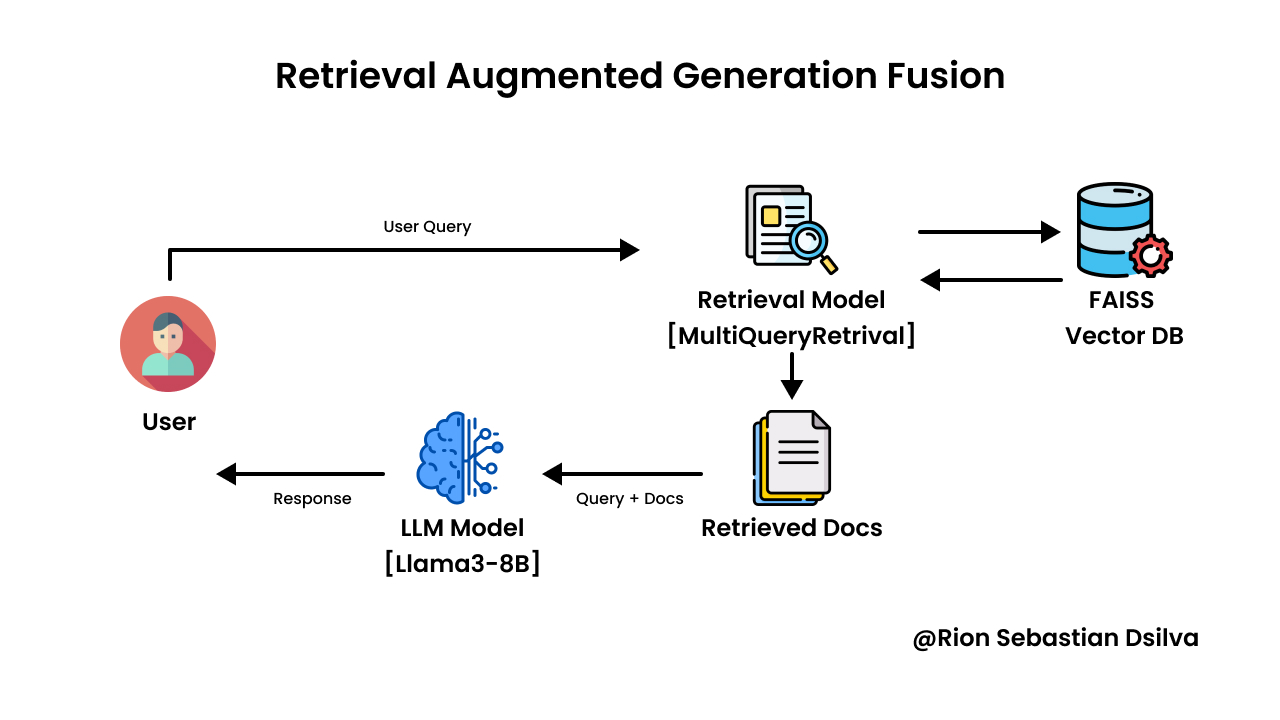

- LLAMA3-8B LLM을 가진 Ollama : 강력한 LLAMA3 큰 언어 모델의 오프라인 실행을 위해 Ollama를 사용하여 효과적인 텍스트 생성을 가능하게합니다.

- FAISS 벡터 데이터베이스 : 고성능 오프라인 벡터 데이터베이스 인 FAISS를 활용하여 문서 임베딩을 효율적으로 저장하고 검색합니다.

- 포옹 얼굴 임베딩 : 텍스트 데이터의 의미 론적 표현을 위해 포옹 얼굴에서 미리 훈련 된 임베드를 통합합니다.

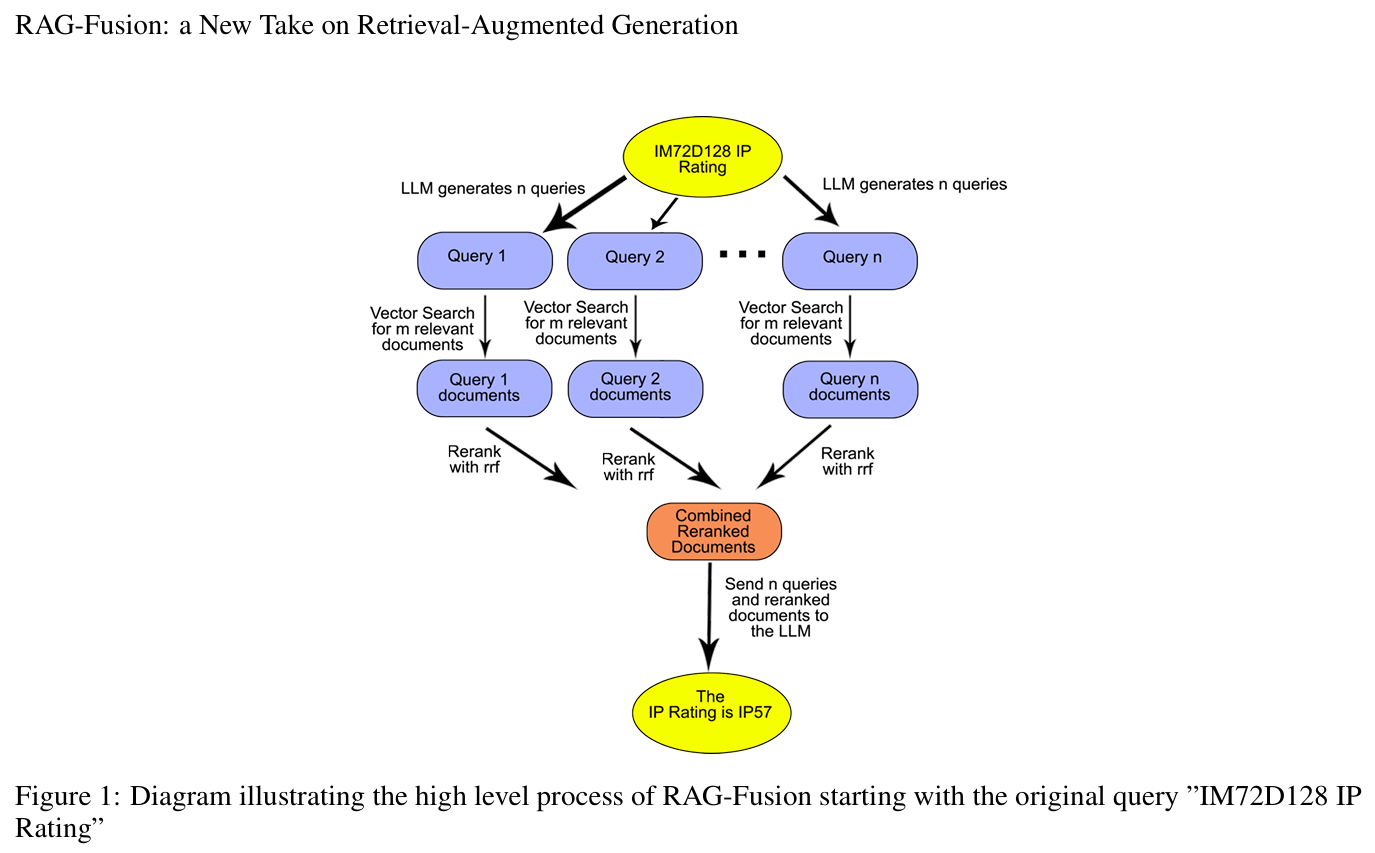

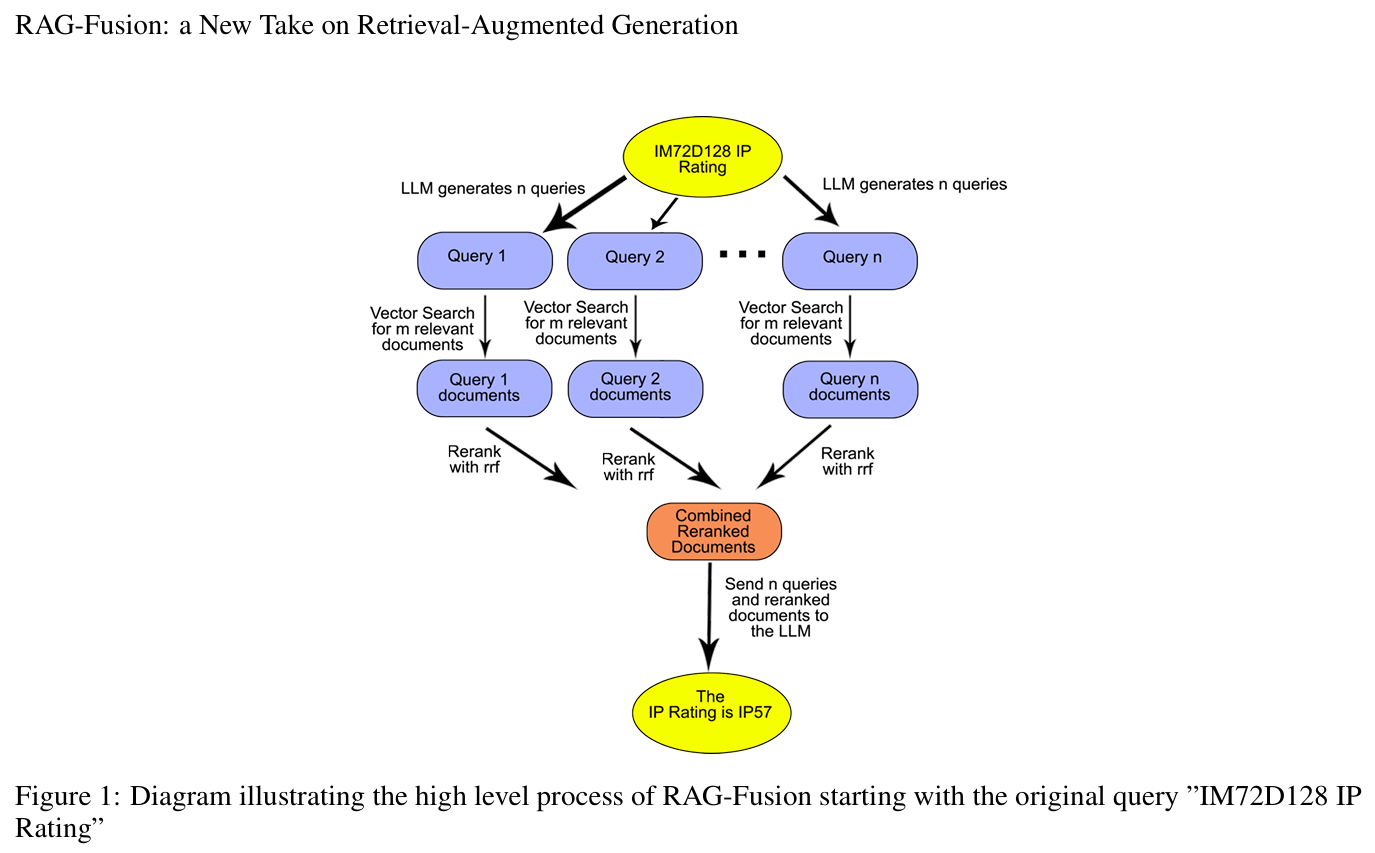

- MultiqueryRertiever : LLM을 사용하여 주어진 사용자 입력 쿼리에 대한 다른 관점에서 여러 쿼리를 생성하여 프롬프트 튜닝 프로세스를 자동화합니다.

시작하기

터미널에서 다음 명령을 실행하십시오.

이 저장소를 복제하십시오.

git clone https://github.com/RionDsilvaCS/research-assistant-rag-fusion.git

필요한 종속성을 설치하십시오 (Git Dir 내부에 있는지 확인하십시오)

pip install -r requirements.txt

나만의 벡터 DB를 만듭니다

프로젝트 설정 구성 Ollama가 장치에서 실행되도록하십시오. https://ollama.com/download

https://ollama.com/library/llama3

https://ollama.com/library/mistral

이제 Everthying은 달릴 준비가되었습니다

오프라인 래그 퓨전 파이프 라인

이러한 강력한 이점으로 연구 효율성을 높이십시오.

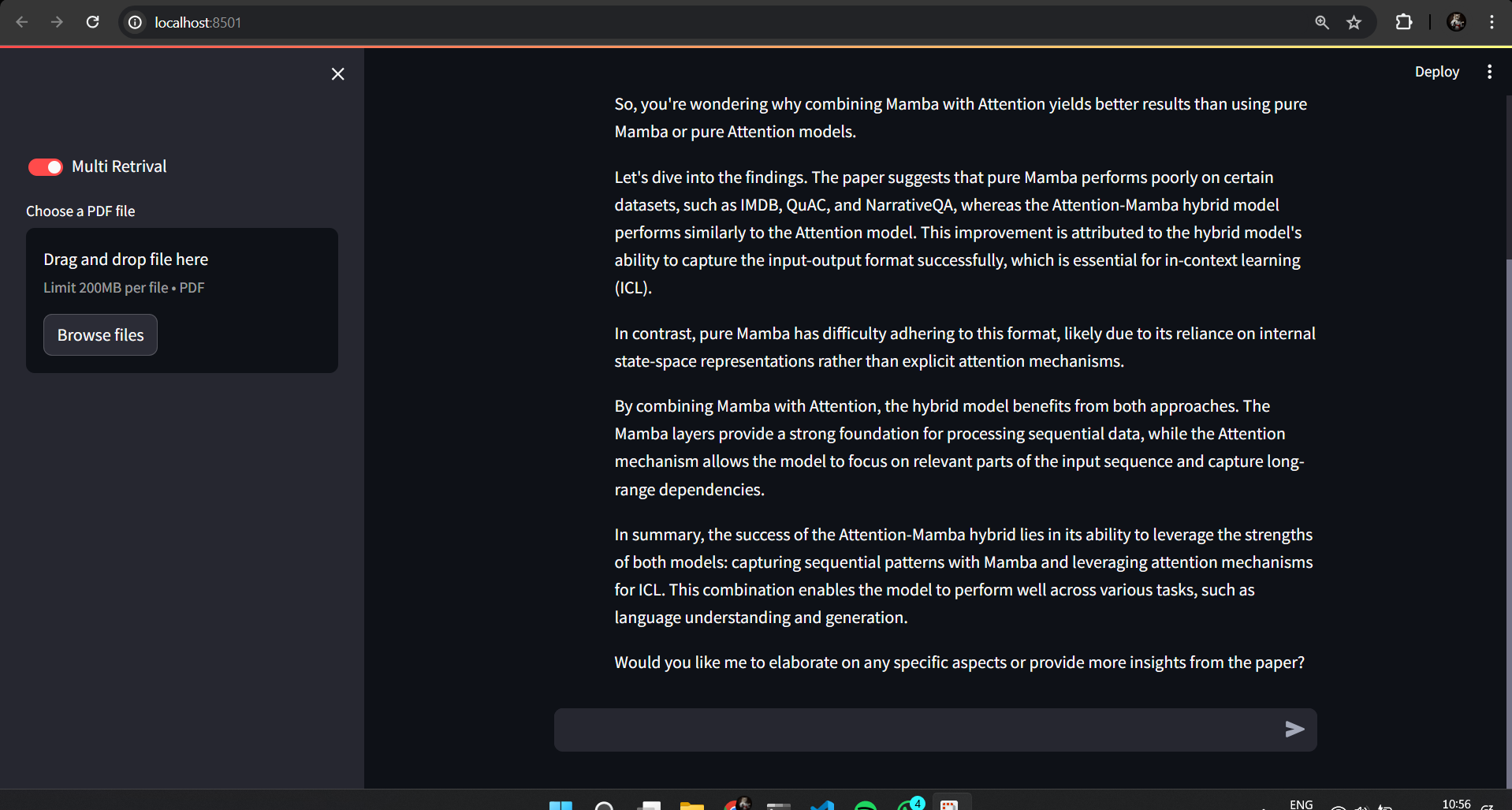

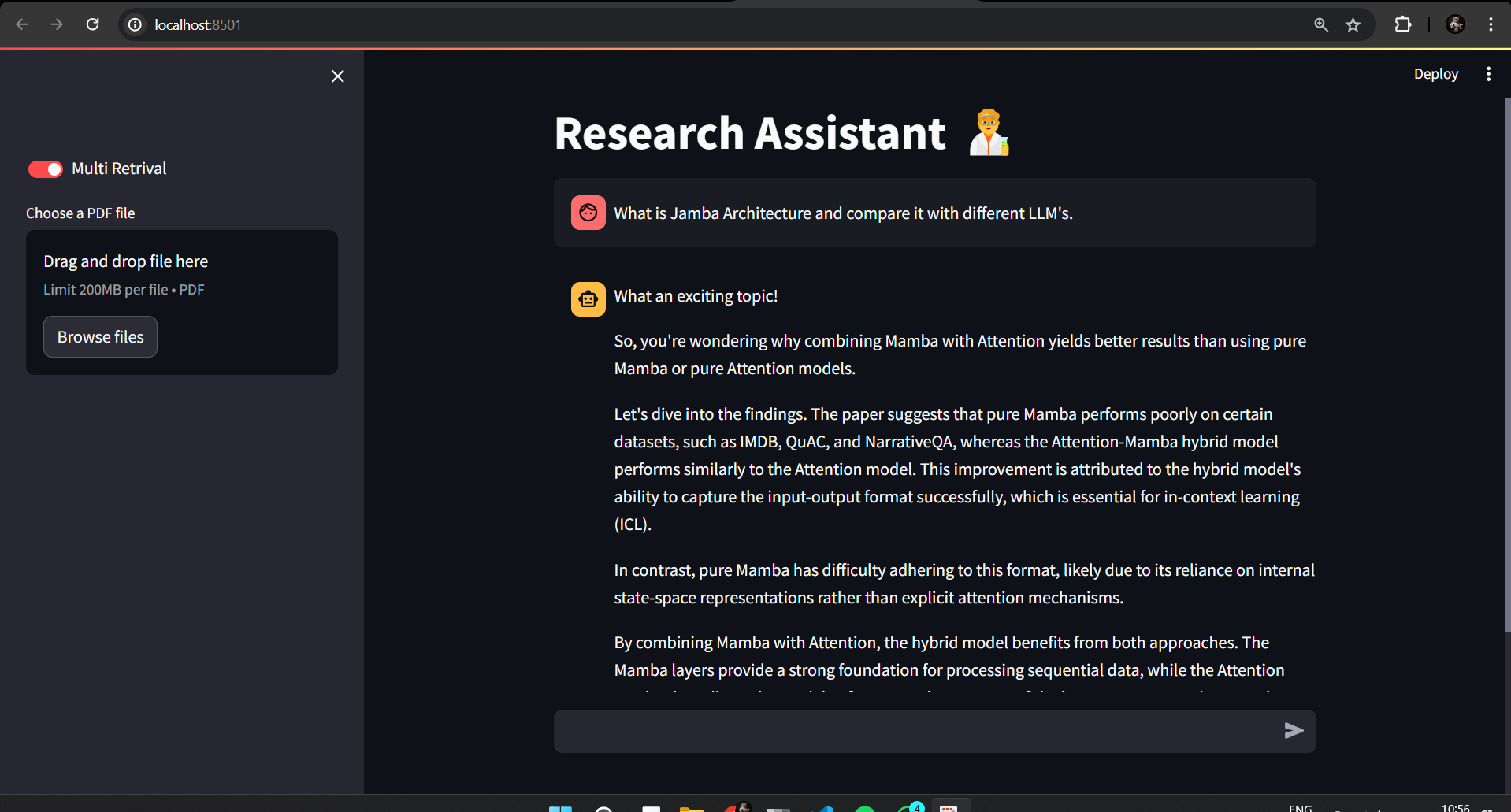

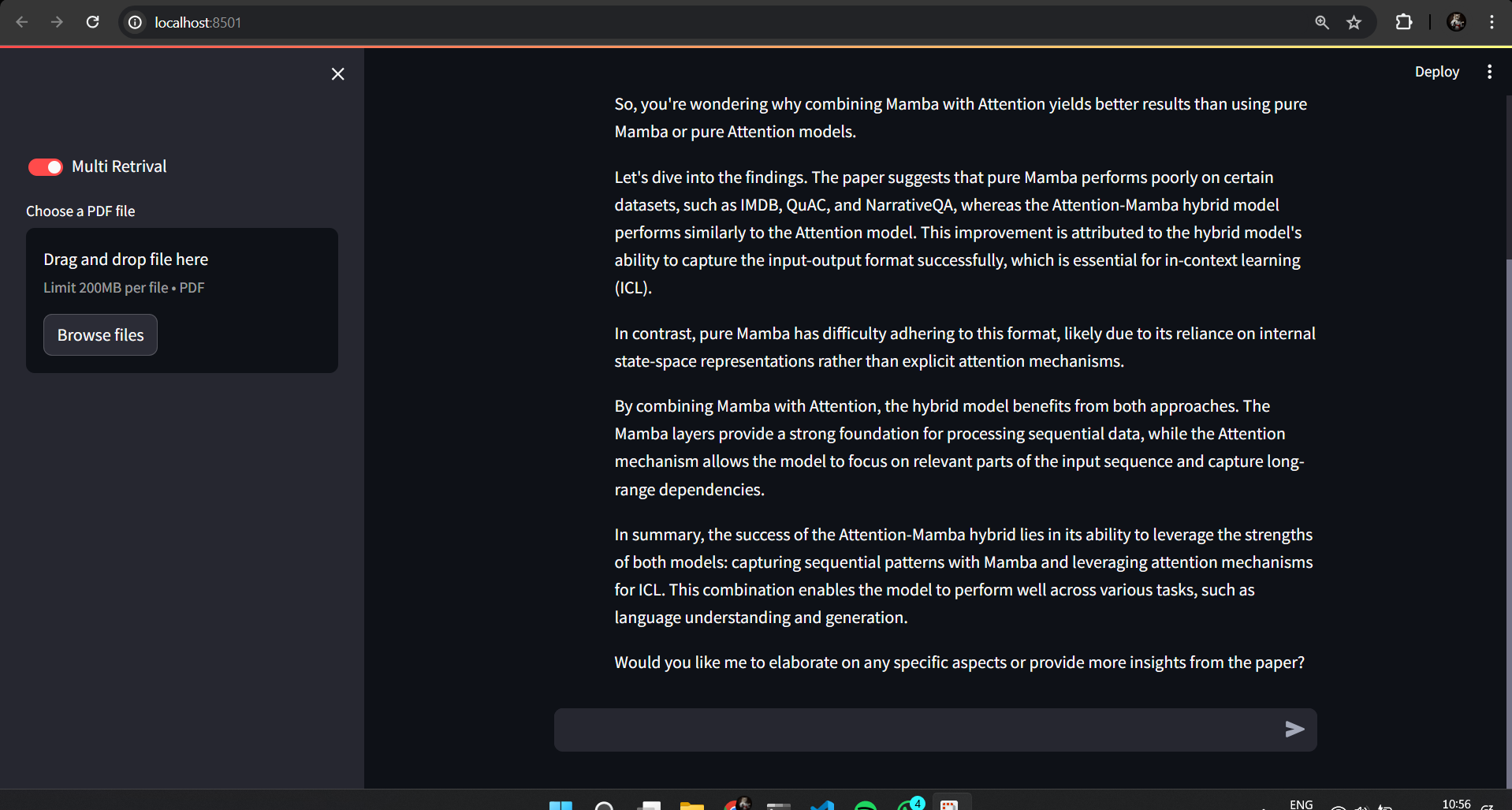

이 Rag-Fusion Powered Research Assistant는 리서치 게임을 향상시키기위한 다양한 이점을 제공합니다.

- 향상된 정확도와 포괄적 성 : Rag-Fusion은 쿼리가 연구 코퍼스에서 가장 관련성이 높은 정보를 검색하여 주제에 대한 더 깊은 이해를 촉진합니다.

- Spark New Research Avenues : Langchain을 사용한 다중 세대는 숨겨진 연결을 밝히고 다양한 관점을 탐색하여 혁신적인 연구 가능성을 이끌어냅니다.

- 중단없는 워크 플로 : 원활하게 오프라인으로 작업하십시오! 벡터 스토어는 연구 데이터에 쉽게 액세스 할 수 있도록하여 인터넷 연결이 필요하지 않습니다.

- 비용 효율적인 솔루션 : 이 프로젝트에 사용 된 모든 기술은 오픈 소스이며 라이센스 비용이없는 강력한 연구 도구입니다.

- 연구 생산성 향상 : 관련 정보를 쉽게 검색하고 새로운 통찰력을 얻고 분석 및 탐색을위한 귀중한 시간을 확보하여 연구 프로세스를 간소화합니다.

- 오프라인 영감 : 이 연구 보조원은 끊임없는 동반자가되어 인터넷 연결 없이도 영감을주고 연구 여행을 안내 할 준비가되어 있습니다.

이러한 이점은 연구원들에게 더 큰 효율성을 달성하고 새로운 연구 길을 열고 궁극적으로 해당 분야에 상당한 기여를 할 수 있도록 권한을 부여했습니다.

날 따라 오세요

github @riondsilvacs · linkedin @rion dsilva · twitter @rion_dsilva_cs