AMDの最新のStrix Point APUシリーズプロセッサは、AI Big Language Model(LLM)アプリケーションで大きな利点を示し、Intel Lunar Lakeシリーズよりも優れています。モバイルプラットフォーム向けに設計された一連のプロセッサは、AIワークロードの需要の高まりを満たすために、より高いパフォーマンスと低レイテンシを提供するように設計されています。 AMDは、LLMタスクの処理においてRyzen AIプロセッサの優れたパフォーマンスを強調し、LM Studioツールを起動して、大規模な言語モデルの使用とユーザーのしきい値の使用を簡素化します。

最近、AMDは最新のStrix Point APUシリーズをリリースし、AI Big Language Model(LLM)アプリケーションでのこのシリーズの優れたパフォーマンスを強調し、IntelのLunar Lakeシリーズプロセッサをはるかに超えています。 AIワークロードに対する需要の増加に伴い、ハードウェアの競争はますます激しくなっています。市場に対処するために、AMDは、より高いパフォーマンスとレイテンシのために設計されたモバイルプラットフォーム向けに設計されたAIプロセッサを発売しました。

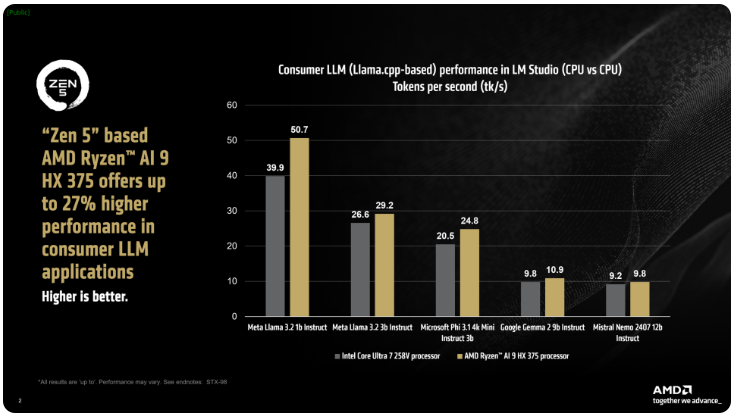

AMDは、IXポイントシリーズのRyzen AI300プロセッサは、AI LLMタスクの処理時に1秒あたりのトークンの数を大幅に増加させる可能性があり、Ryzen AI9375はIntelのコアUltra258Vと比較して27%のパフォーマンス改善を持っていると述べました。コアUltra7VはL Lakeファミリーで最速のモデルではありませんが、そのコアとスレッドカウントは、この地域でのAMD製品の競争力を示しています。

AMDのLM Studio Toolは、Llama.cppフレームワークに基づいた消費者向けアプリケーションであり、大規模な言語モデルの使用を簡素化するように設計されています。このフレームワークはX86CPUのパフォーマンスを最適化し、LLMを実行するためにGPUを必要としませんが、GPUを使用すると処理速度をさらに高速化できます。テストによると、Ryzen AI9HX375は、メタラマ3.21Bの指示モデルで35倍低いレイテンシを達成し、比較して50.7トークンを処理できます。

それだけでなく、Strix Point APUには、RDNA3.5に基づいた強力なRadeon統合グラフィックカードも装備されています。RDNA3.5は、ULKAN APIを介してタスクをIGPUにオフロードし、LLMのパフォーマンスをさらに向上させます。 Change Graphics Memory(VGM)テクノロジーを使用して、Ryzen AI300プロセッサはメモリ割り当てを最適化し、エネルギー効率を向上させ、最終的に最大60%のパフォーマンス改善を達成できます。

比較テストで、AMDはIntel AI Playgroundプラットフォームで同じ設定を使用し、Ryzen AI9HX375がMistral7B instruct0.3モデルでは、Core Ultra7258VよりもMicrosoft Phi3.1よりも87%速く、13%速いことを発見しました。それにもかかわらず、Lunar Lake RangeのフラッグシップコアUltra9288Vと比較した場合、結果はさらに興味深いものになります。現在、AMDは、LM Studioを通じて大規模な言語モデルの使用をより人気のあるものにすることに焦点を当てており、より多くの技術的なユーザーが簡単に開始できるようにすることを目指しています。

キーポイント:

AMD Strix Point Apusは、AI LLMアプリケーションのIntel Lunar Lakeよりも27%のパフォーマンスを向上させます。

Ryzen AI9HX375は、メタラマ3.2モデルで3.5倍低いレイテンシを実行します。

LM Studioツールは、大規模な言語モデルを使用しやすく、非技術的なユーザーに適しているように設計されています。

要するに、AI LLMアプリケーションフィールドでのAMD Strix Point APUシリーズの強力なパフォーマンスと使いやすいLMスタジオツールは、AIハードウェア市場におけるAMDのアクティブなレイアウトと競争力を示し、消費者がより便利になります効率的なAIエクスペリエンス。