Les derniers processeurs STRIX POINT APU d'AMD présentent des avantages importants dans les applications de modèle de langage Big Language (LLM) et surpassent la série Intel Lunar Lake. Conçu pour les plates-formes mobiles, la série de processeurs est conçue pour fournir des performances plus élevées et une latence plus faible pour répondre à la demande croissante de charges de travail de l'IA. AMD met l'accent sur les performances exceptionnelles des processeurs Ryzen AI dans la gestion des tâches LLM, et lance LM Studio Tools pour simplifier l'utilisation de modèles de gros langues et de seuils utilisateur inférieurs.

Récemment, AMD a publié sa dernière série STRIX POINT APU, soulignant les performances exceptionnelles de cette série dans les applications de modèle Big Language (LLM), dépassant de loin les processeurs de la série Lunar Lake d'Intel. Avec la demande croissante de charges de travail de l'IA, la concurrence pour le matériel devient de plus en plus féroce. Pour faire face au marché, AMD a lancé des processeurs d'IA conçus pour les plates-formes mobiles, conçues pour des performances plus élevées et une latence plus faible.

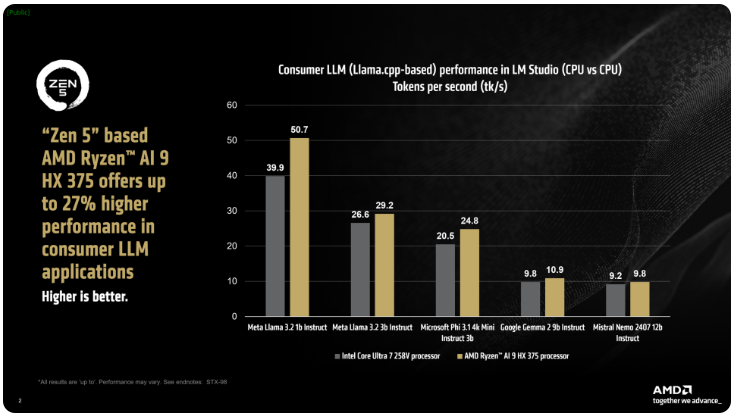

AMD a déclaré que les processeurs Ryzen AI300 de la série IX Point peuvent considérablement augmenter le nombre de jetons traités par seconde lors du traitement des tâches AI LLM, et le Ryzen AI9375 a une amélioration des performances de 27% par rapport au principal Ultra258V d'Intel. Bien que le noyau ultra7v ne soit pas le modèle le plus rapide de la famille L Lake, son noyau et son nombre de fils sont proches des processeurs Lunar Lake haut de gamme, montrant la compétitivité des produits AMD dans cette zone.

L'outil Studio LM d'AMD est une application axée sur les consommateurs basée sur le cadre LLAMA.CPP, conçu pour simplifier l'utilisation de modèles de grande langue. Ce cadre optimise les performances de X86CPUS, et bien qu'il ne nécessite pas de GPU pour exécuter LLM, l'utilisation des GPU peut accélérer davantage les vitesses de traitement. Selon les tests, le Ryzen AI9HX375 peut obtenir une latence 35 fois plus faible dans le modèle d'instruction Meta Llama3.21b, et le processus de 50,7 jetons par seconde.

Non seulement cela, l'APU Strix Point est également équipé d'une puissante carte graphique intégrée Radeon basée sur RDNA3.5, qui décharge les tâches à l'IGPU via l'API Ulkan, améliorant davantage les performances de LLM. En utilisant la technologie de mémoire graphique (VGM) de changement, le processeur Ryzen AI300 peut optimiser l'allocation de la mémoire, améliorer l'efficacité énergétique et finalement obtenir une amélioration des performances pouvant atteindre 60%.

Dans les tests de comparaison, AMD a utilisé les mêmes paramètres sur la plate-forme Intel AI Playground et a constaté que le Ryzen AI9HX375 était 87% plus rapide sur Microsoft PHI3.1 que le principal Ultra7258V et 13% plus rapidement dans le modèle Mistral7B instruct0.3. Néanmoins, les résultats seront encore plus intéressants par rapport au noyau phare Ultra9288V dans la gamme Lunar Lake. Actuellement, AMD se concentre sur la réalisation de modèles de grands langues plus populaires via LM Studio, visant à faciliter le démarrage des utilisateurs plus non techniques.

Points clés:

AMD Strix Point APUS améliore les performances de 27% par rapport au lac Intel Lunar dans les applications AI LLM.

Le Ryzen AI9HX375 effectue une latence 3,5 fois plus faible dans le modèle Meta Llama3.2.

L'outil LM Studio est conçu pour faciliter l'utilisation de grands modèles de langage et adaptés aux utilisateurs non techniques.

En bref, les performances solides de la série AMD Strix Point APU dans le champ d'application AI LLM et les outils de studio LM faciles à utiliser indiquent la disposition active et la compétitivité d'AMD sur le marché du matériel d'IA, ce qui permet aux consommateurs de plus pratiques et une expérience d'IA efficace.