Une étude récente dirigée par Yann LeCun, scientifique en chef de l'IA de Meta, a révélé comment l'intelligence artificielle développe la compréhension de la physique de base en regardant des vidéos. L'étude, réalisée par des scientifiques de Meta Fair, de l'Université de Paris et d'Ehess, montre que les systèmes d'IA peuvent acquérir des connaissances physiques intuitives grâce à l'apprentissage auto-supervisé sans règles prédéfinies.

L'équipe de recherche a adopté une nouvelle approche appelée l'architecture de prédiction intégrée vidéo (V-Jepa), qui fonctionne plus étroitement à la méthode de traitement de l'information du cerveau humain que les modèles d'IA génératifs tels que Sora d'Openai. V-Jepa ne poursuit pas la génération de prédictions de pixels parfaites, mais se concentre sur la réalisation des prédictions dans un espace de représentation abstrait. De cette façon, les systèmes d'IA peuvent apprendre des concepts physiques de base.

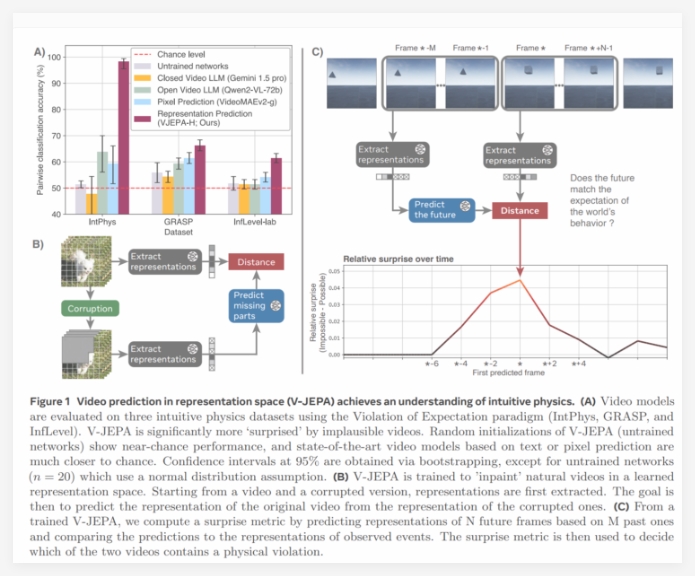

Dans l'étude, l'équipe a emprunté une méthode d'évaluation de la «violation des attentes» de la psychologie du développement, qui a été initialement utilisée pour tester les capacités de compréhension physique des nourrissons. Les chercheurs montrent l'IA de deux scénarios similaires - l'un physiquement possible et l'autre physiquement impossible (par exemple, une balle passe par un mur), et la capacité de compréhension physique de l'IA peut être évaluée en mesurant sa réponse à ces violations physiques.

Le V-Jepa a été testé sur trois ensembles de données: INTPHYS (concepts physiques de base), GRASP (interactions complexes) et en régime alimentaire (environnement réaliste). Les résultats montrent que le V-Jepa fonctionne particulièrement bien dans la constance d'objets, la continuité et la cohérence de la forme, tandis que les grands modèles de langage multimodal tels que Gemini1.5pro et Qwen2-VL-72B fonctionnent presque comparables aux suppositions aléatoires.

L'efficacité de l'apprentissage V-Jepa est également accrocheuse. Le système peut maîtriser les concepts de la physique de base en regardant simplement 128 heures de vidéo. De plus, même le petit modèle avec 115 millions de paramètres a montré de solides résultats. La recherche montre que V-Jepa est en mesure d'identifier efficacement les modèles de mouvement et d'identifier des événements physiquement déraisonnables avec une grande précision, jetant les bases de l'IA pour vraiment comprendre l'avenir du monde.

Cette étude remet en question une hypothèse fondamentale dans de nombreuses études d'IA que les systèmes nécessitent des «connaissances de base» prédéfinies pour comprendre les lois de la physique. Les résultats de V-Jepa montrent que l’apprentissage par observation peut aider l’IA à acquérir des connaissances dans ce domaine, semblable au processus par lequel les nourrissons, les primates et même les jeunes oiseaux comprennent la physique. La recherche est conforme à l'exploration à long terme de Meta de l'architecture JEPA, visant à créer un modèle mondial complet qui permet aux systèmes d'IA autonomes d'avoir une compréhension plus approfondie de leur environnement.

La recherche montre que l'IA apprend les connaissances physiques par vidéo sans règles prédéfinies. V-Jepa surpasse les modèles de grands langues dans la compréhension de la physique et montre des capacités d'apprentissage plus fortes. Meta pilote de nouvelles directions de développement de l'IA, visant à créer un modèle de compréhension environnementale plus complet.