La technologie de génération de vidéos a fait des progrès significatifs ces dernières années, mais les modèles existants ont encore des limites à la capture de phénomènes complexes de mouvement et de physiques. L'équipe de recherche de Meta a proposé le cadre VideoJam, visant à améliorer l'expressivité de mouvement des modèles de génération de vidéos grâce à une représentation conjointe de mouvement d'apparence.

Dans le domaine de la génération de vidéos, malgré des progrès significatifs ces dernières années, les modèles génératifs existants ont toujours du mal à capturer des phénomènes de mouvement, dynamiques et physiques complexes en réalité. Cette limitation provient principalement des objectifs traditionnels de reconstruction des pixels, qui tendent à améliorer le réalisme de l'apparence et à ignorer la cohérence du mouvement.

Pour résoudre ce problème, l'équipe de recherche de Meta a proposé un nouveau cadre appelé VideoJam, qui vise à injecter des priors de mouvement efficaces dans des modèles générateurs de vidéos en encourageant les modèles à apprendre des représentations conjointes de mouvement d'apparence.

Le framework VideoJam contient deux unités complémentaires. Pendant la phase de formation, le cadre étend l'objectif de prédire à la fois les pixels générés et le mouvement correspondant, à la fois à partir d'une seule représentation d'apprentissage.

Au cours de la phase de raisonnement, l'équipe de recherche a introduit un mécanisme appelé "guidage intrinsèque" qui guide le processus de génération vers une direction de mouvement cohérente en utilisant la propre prédiction de mouvement en évolution du modèle comme signal de guidage dynamique. Il convient de noter que VideoJam peut être appliqué à n'importe quel modèle de génération de vidéos sans modifier les données de formation ou prolonger le modèle.

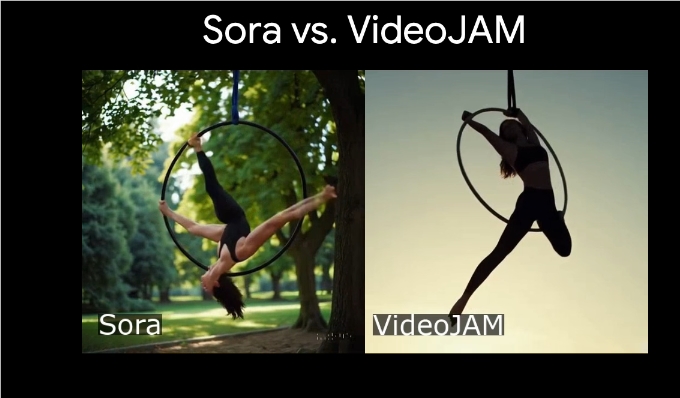

VideoJam s'est avéré être un niveau de pointe de l'industrie en cohérence de mouvement, dépassant plusieurs modèles propriétaires hautement compétitifs tout en améliorant la qualité visuelle des images générées. Les résultats de cette étude mettent l'accent sur la relation complémentaire entre l'apparence et le mouvement, ce qui peut améliorer considérablement l'effet visuel et la cohérence de mouvement de la génération de vidéos lorsque les deux sont efficacement combinés.

En outre, l'équipe de recherche a démontré l'excellente performance de VideoJam-30B dans la génération de types de sports complexes, y compris des scènes telles que les skaters sauter et les danseurs de ballet qui tournent sur le lac. En comparant le modèle de bibase DIT-30B, l'étude a révélé que VideoJam a considérablement amélioré la génération de qualité de mouvement.

Entrée du projet: https://hila-chefer.github.io/videojam-paper.github.io/

Points clés:

VideoJam Framework améliore l'expressivité de mouvement des modèles de génération de vidéos grâce à une représentation conjointe de mouvement d'apparence.

Pendant l'entraînement, VideoJam peut prédire les pixels et le mouvement simultanément, améliorant la cohérence du contenu généré.

Il a été prouvé que VideoJam dépasse plusieurs modèles compétitifs en cohérence de mouvement et en qualité visuelle.

Le cadre VideoJam de Meta a apporté de nouvelles percées à la technologie de génération de vidéos.