Un article sur l’évaluation de l’IA médicale a révélé de manière inattendue la taille des paramètres de plusieurs grands modèles de langage, suscitant une inquiétude généralisée dans l’industrie. Cet article publié par Microsoft prend comme base le test de référence du domaine médical MEDEC et estime les paramètres des modèles d'OpenAI, d'Anthropic et d'autres sociétés, y compris des modèles tels que la série GPT-4 d'OpenAI et Claude 3.5 Sonnet d'Anthropic. Il existe des différences entre les échelles de paramètres mentionnées dans le document et les informations publiques. Par exemple, l'échelle de paramètres de GPT-4 est très différente des données précédemment annoncées par NVIDIA. Cela a déclenché une discussion animée dans l'industrie sur l'architecture et la technique des modèles. force, et a une fois de plus déclenché l'inquiétude des gens concernant les modèles d'IA. Réflexions sur la confidentialité des paramètres.

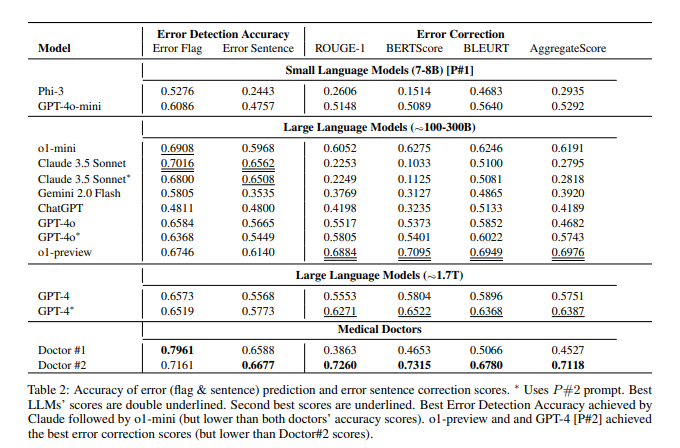

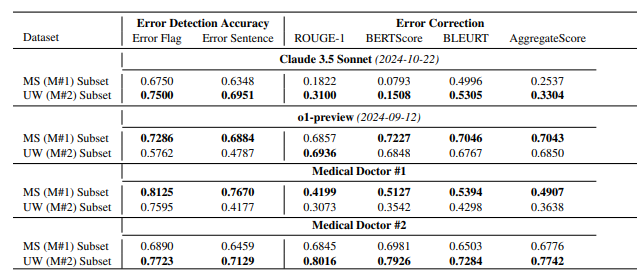

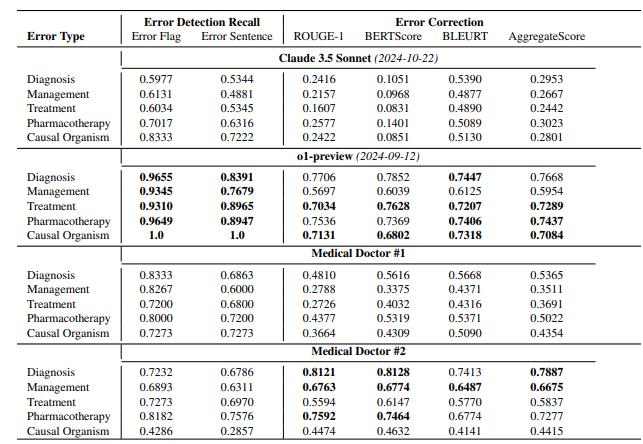

Selon l'article, le modèle o1-preview d'OpenAI a environ 300 B de paramètres, GPT-4o en a environ 200 B et GPT-4o-mini n'en a que 8 B, la taille des paramètres de Claude3.5Sonnet est d'environ 175 B ; Les résultats des tests MEDEC montrent que Claude3.5Sonnet fonctionne bien en matière de détection d'erreurs, avec un score allant jusqu'à 70,16. Les paramètres de Google Gemini ne sont pas mentionnés dans le document. Cela peut être dû au fait que Gemini utilise le TPU au lieu du GPU NVIDIA, ce qui rend difficile l'estimation précise de la vitesse de génération des jetons. Les informations sur les paramètres « divulguées » dans le document, ainsi que les résultats de l'évaluation des performances du modèle, fournissent une référence précieuse permettant à l'industrie de réfléchir en profondeur à la voie technologique des grands modèles, à la concurrence commerciale et aux orientations de développement futures.

Ce n'est pas la première fois que Microsoft « divulgue » des informations sur les paramètres du modèle dans des documents. En octobre de l'année dernière, Microsoft a divulgué la taille du paramètre 20B de GPT-3.5-Turbo dans un article, mais a ensuite supprimé cette information dans une version mise à jour. Cette « fuite » répétée a conduit à des spéculations parmi les initiés de l'industrie quant à savoir si elle avait une intention spécifique.

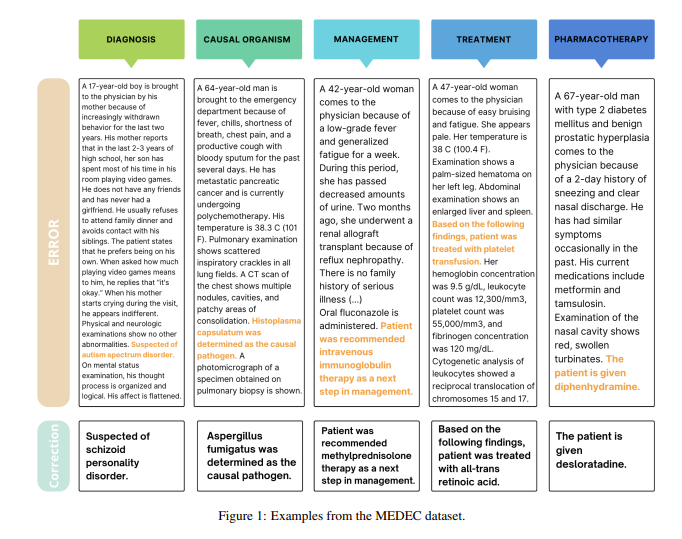

Il est à noter que l'objectif principal de cet article est d'introduire une référence dans le domaine médical appelée MEDEC. L'équipe de recherche a analysé 488 notes cliniques provenant de trois hôpitaux américains et évalué la capacité des principaux modèles à identifier et à corriger les erreurs de documentation médicale. Les résultats du test montrent que Claude3.5Sonnet est en tête des autres modèles en matière de détection d'erreurs avec un score de 70,16.

Il y a un débat animé dans l’industrie sur l’authenticité de ces données. Certains pensent que si Claude3.5Sonnet parvient à obtenir d'excellentes performances avec un nombre de paramètres réduit, cela mettra en valeur la force technique d'Anthropic. Certains analystes estiment également que certaines estimations de paramètres sont raisonnables grâce à l’inférence de tarification par modèle.

Ce qui est particulièrement remarquable, c'est que l'article estime uniquement les paramètres des modèles traditionnels, mais ne mentionne pas les paramètres spécifiques de Google Gemini. Certains analystes pensent que cela pourrait être lié à l'utilisation par Gemini du TPU au lieu du GPU NVIDIA, ce qui rend difficile l'estimation précise de la vitesse de génération des jetons.

À mesure qu’OpenAI dilue progressivement son engagement envers l’open source, les informations essentielles telles que les paramètres du modèle pourraient continuer à faire l’objet d’une attention continue dans l’industrie. Cette fuite inattendue a une fois de plus déclenché une réflexion approfondie sur l'architecture des modèles d'IA, les itinéraires techniques et la concurrence commerciale.

Références :

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probably_around_8b_active/

Dans l'ensemble, bien que les informations sur les paramètres du modèle « divulguées » dans cet article ne constituent pas le contenu principal de la recherche de l'article, elles ont déclenché des discussions approfondies dans l'industrie sur l'échelle des grands paramètres du modèle, la sélection des itinéraires techniques et le paysage de la concurrence commerciale, fournissant une base pour le développement futur du domaine de l'intelligence artificielle Fournit de nouvelles orientations de réflexion.