كشفت ورقة بحثية عن تقييم الذكاء الاصطناعي الطبي بشكل غير متوقع عن أحجام المعلمات للعديد من نماذج اللغات الكبيرة، مما تسبب في قلق واسع النطاق في الصناعة. تأخذ هذه الورقة البحثية الصادرة عن Microsoft اختبار MEDEC القياسي للمجال الطبي باعتباره جوهر الاختبار وتقدر معلمات النموذج لشركة OpenAI وAnthropic وغيرها من الشركات، بما في ذلك نماذج مثل سلسلة GPT-4 من OpenAI وAnthropic's Claude 3.5 Sonnet. هناك اختلافات بين مقاييس المعلمات المذكورة في الورقة والمعلومات العامة، على سبيل المثال، يختلف مقياس معلمات GPT-4 تمامًا عن البيانات التي أعلنت عنها NVIDIA مسبقًا، وقد أثار هذا نقاشًا ساخنًا في الصناعة حول بنية النموذج والتقنية القوة، وأثارت مرة أخرى قلق الناس بشأن نماذج الذكاء الاصطناعي بشأن سرية المعلمات.

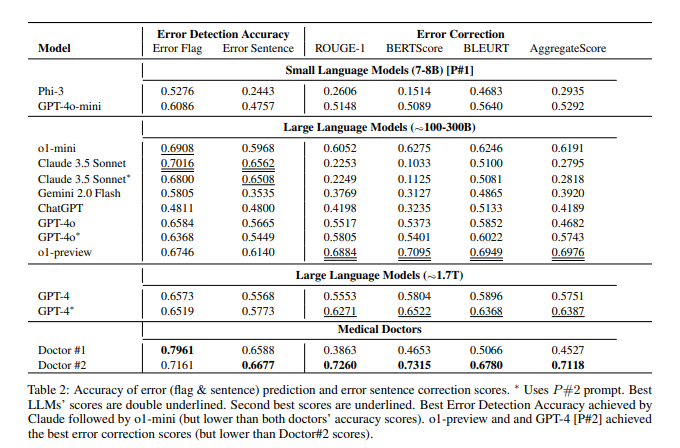

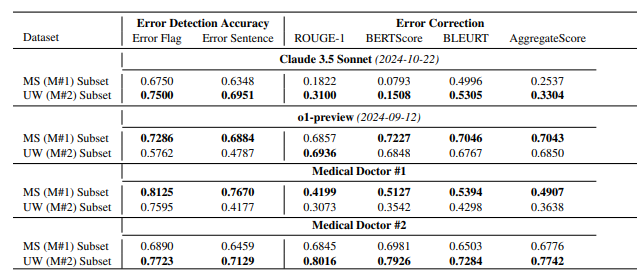

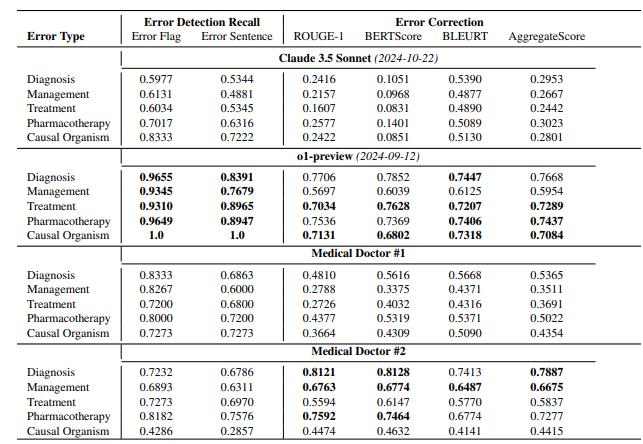

وفقًا للورقة البحثية، يحتوي نموذج معاينة o1 الخاص بـ OpenAI على حوالي 300 بايت من المعلمات، ويحتوي GPT-4o على حوالي 200 بايت، ويحتوي GPT-4o-mini على 8 بايت فقط؛ ويبلغ حجم معلمة Claude3.5Sonnet حوالي 175 بايت. تظهر نتائج اختبار MEDEC أن Claude3.5Sonnet يؤدي أداءً جيدًا في اكتشاف الأخطاء، حيث سجل درجة عالية تصل إلى 70.16. لم يتم ذكر معلمات Google Gemini في الورقة، وقد يكون هذا بسبب استخدام Gemini لـ TPU بدلاً من NVIDIA GPU، مما يجعل من الصعب تقدير سرعة إنشاء الرمز المميز بدقة. توفر معلومات المعلمات "المتسربة" في الورقة، بالإضافة إلى نتائج تقييم أداء النموذج، مرجعًا قيمًا للصناعة للتفكير بعمق في مسار تكنولوجيا النماذج الكبيرة، والمنافسة التجارية، واتجاهات التطوير المستقبلية.

ليست هذه هي المرة الأولى التي تقوم فيها Microsoft "بتسريب" معلومات معلمات النموذج في الأوراق. في أكتوبر من العام الماضي، كشفت Microsoft عن حجم المعلمة 20B لـ GPT-3.5-Turbo في ورقة، لكنها حذفت هذه المعلومات لاحقًا في إصدار محدث. وقد أدى هذا "التسرب" المتكرر إلى تكهنات بين المطلعين على الصناعة حول ما إذا كان لديه نية محددة.

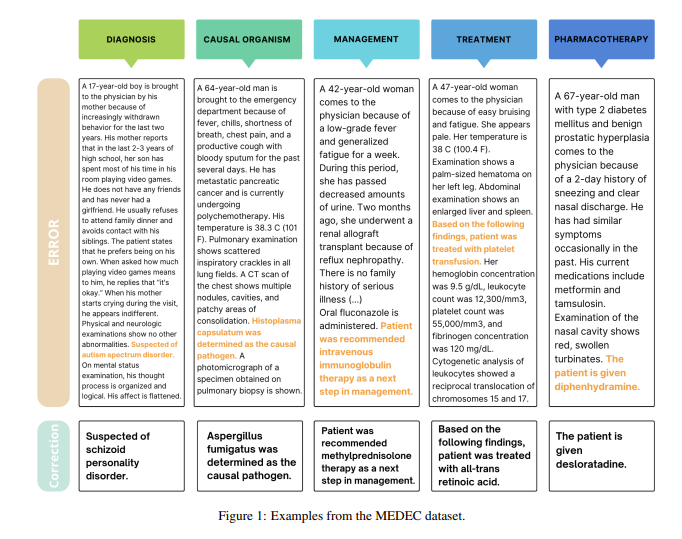

ومن الجدير بالذكر أن الغرض الرئيسي من هذه الورقة هو تقديم معيار في المجال الطبي يسمى MEDEC. قام فريق البحث بتحليل 488 ملاحظة سريرية من ثلاثة مستشفيات أمريكية وقام بتقييم قدرة النماذج الرئيسية على تحديد أخطاء التوثيق الطبي وتصحيحها. تظهر نتائج الاختبار أن Claude3.5Sonnet يتصدر النماذج الأخرى في اكتشاف الأخطاء بدرجة 70.16.

هناك نقاش ساخن في الصناعة حول صحة هذه البيانات. يعتقد بعض الأشخاص أنه إذا حقق Claude3.5Sonnet أداءً ممتازًا مع عدد أقل من المعلمات، فإن هذا سوف يسلط الضوء على القوة التقنية لـ Anthropic. يعتقد بعض المحللين أيضًا أن بعض تقديرات المعلمات معقولة من خلال استنتاج التسعير النموذجي.

ما هو جدير بالملاحظة بشكل خاص هو أن الورقة تقدر فقط معلمات النماذج السائدة، ولكنها لا تذكر المعلمات المحددة لـ Google Gemini. يعتقد بعض المحللين أن هذا قد يكون مرتبطًا باستخدام Gemini لـ TPU بدلاً من NVIDIA GPU، مما يجعل من الصعب تقدير سرعة إنشاء الرمز المميز بدقة.

نظرًا لأن OpenAI تعمل تدريجيًا على تخفيف التزامها بالمصادر المفتوحة، فقد تستمر المعلومات الأساسية مثل معلمات النموذج في أن تصبح محور الاهتمام المستمر في الصناعة. أثار هذا التسرب غير المتوقع مرة أخرى تفكير الأشخاص المتعمق حول بنية نماذج الذكاء الاصطناعي والمسارات التقنية والمنافسة التجارية.

مراجع:

https://arxiv.org/pdf/2412.19260

https://x.com/Yuchenj_UW/status/1874507299303379428

https://www.reddit.com/r/LocalLLaMA/comments/1f1vpyt/why_gpt_4o_mini_is_probously_around_8b_active/

بشكل عام، على الرغم من أن معلومات معلمات النموذج "المتسربة" في هذه الورقة ليست المحتوى الرئيسي لبحث الورقة، إلا أنها أثارت مناقشات متعمقة في الصناعة حول حجم معلمات النموذج الكبيرة، واختيار المسارات التقنية، و مشهد المنافسة التجارية، الذي يوفر أساسًا للتطور المستقبلي في مجال الذكاء الاصطناعي، يوفر اتجاهات فكرية جديدة.