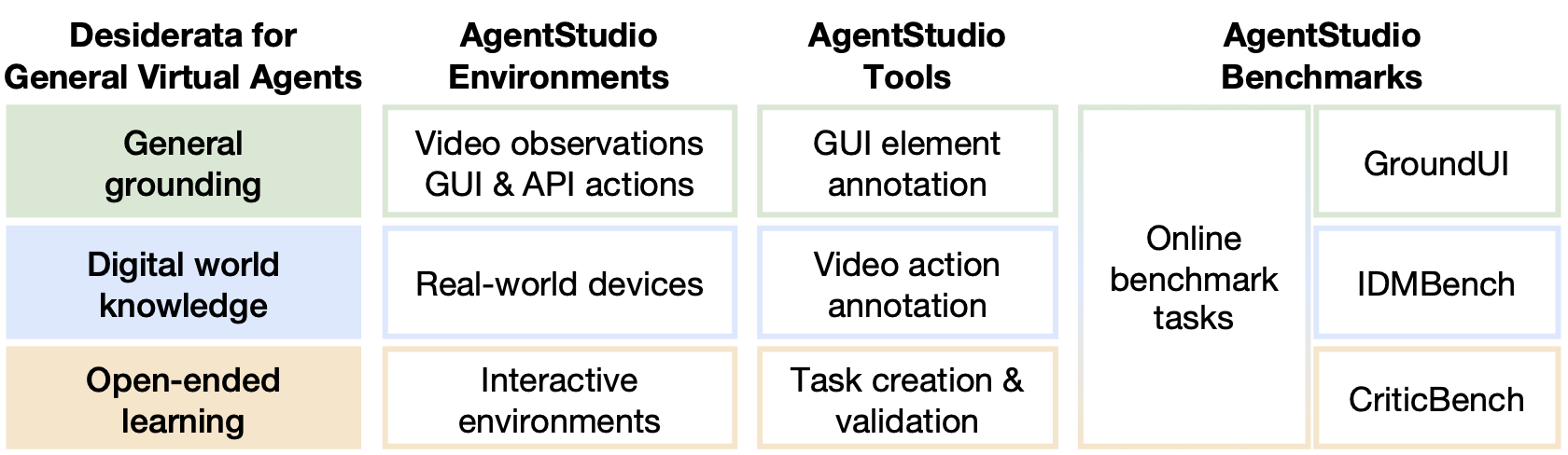

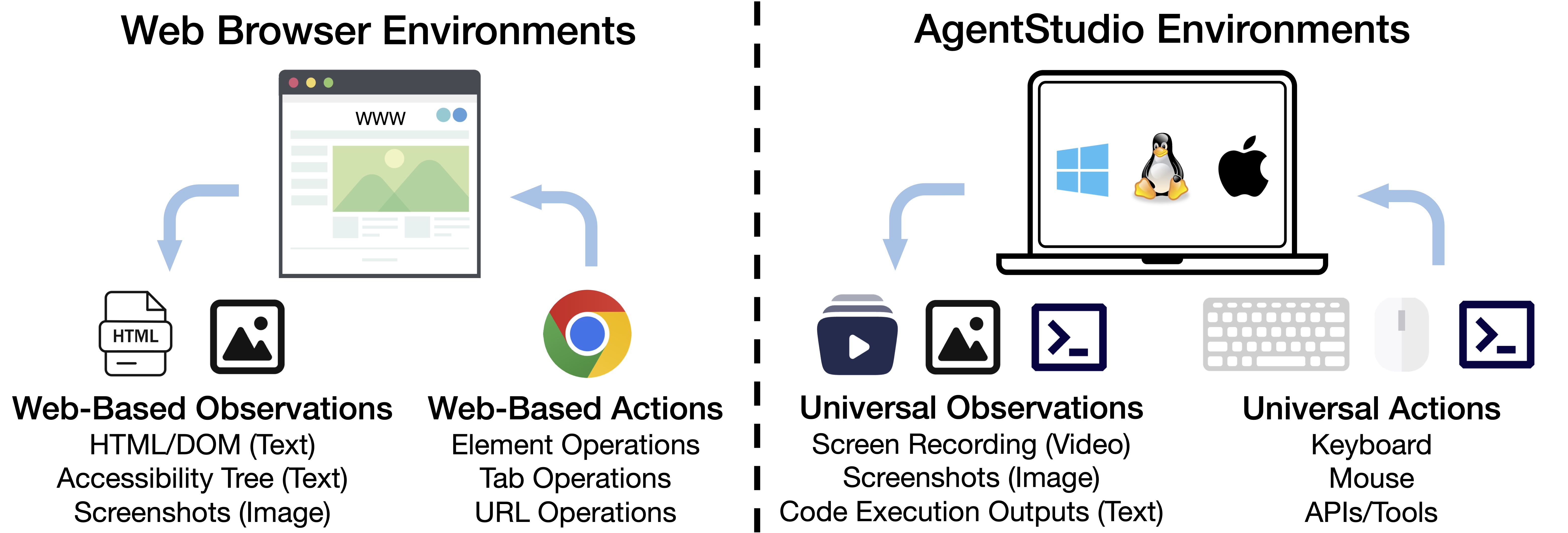

AgentStudio est une trinité d'environnements, d'outils et de repères pour que les agents virtuels généraux interagissent avec tout logiciel informatique. AgentStudio cible le desiderata pour des agents virtuels robustes, généraux et ouverts en fournissant:

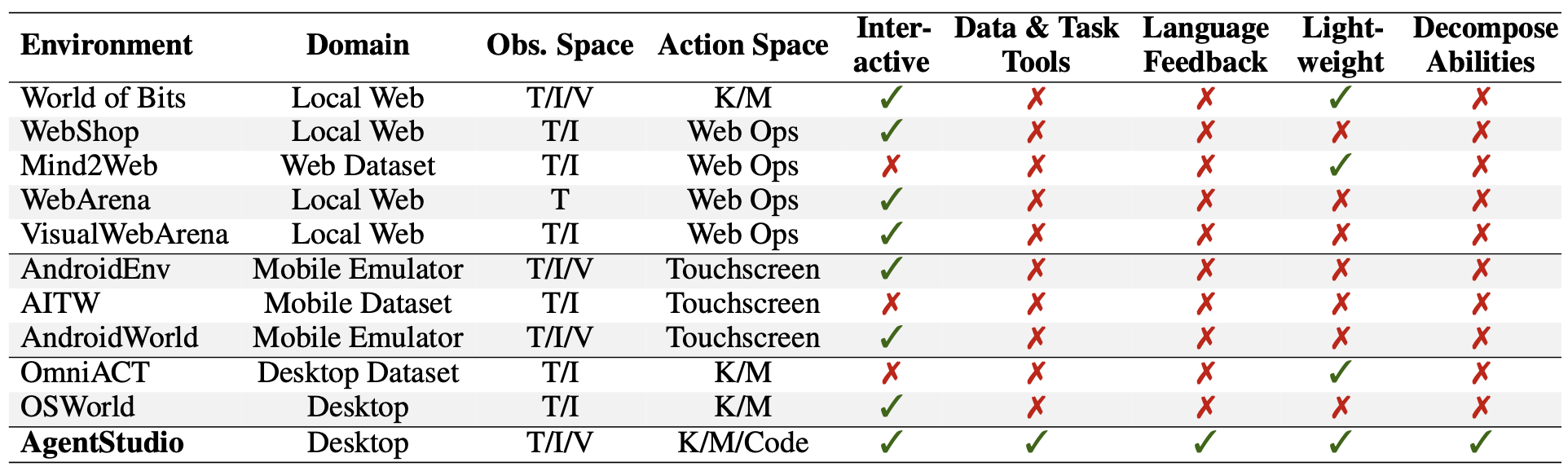

Comparaisons avec les travaux existants:

Installation des exigences:

apt-get install gnome-screenshot xclip xdotool # If using Ubuntu 22.04

conda create --name agent-studio python=3.11 -y

conda activate agent-studio

pip install -e ' .[client] ' Toutes les touches API confidentielles doivent être stockées dans agent_studio/config/api_key.json , par exemple, clé API OpenAI, clé API Claude, clé API GEMINI, etc. Nous avons fourni un exemple de configuration dans agent_studio/config/api_key_template.json .

AgentStudio fournit les espaces d'observation et d'action les plus génériques, qui étend considérablement l'espace de tâche, permettant de développer et d'évaluer les agents dans des paramètres du monde réel. Nous présentons une suite de référence composée de 205 tâches. Ces tâches couvrent les usages d'API tels que le terminal et le logiciel Gmail et GUI comme le code vs. Veuillez en savoir plus dans EVAL_ONLINE_BENCHMARKS / Readme.md. Les fichiers liés à la tâche sont disponibles sur notre page de projet.

Pour obtenir des informations plus approfondies sur les capacités des agents au-delà des performances globales mesurées par les tâches de référence en ligne, nous développons trois ensembles de données à l'aide d'agentStudio: Groundui, Idmbench et CriticBench. Ces ensembles de données ciblent la mise à la terre générale de l'interface utilisateur, l'apprentissage des vidéos et la détection du succès. Plus de détails sont fournis dans EVAL_AGENT_DESIDERATA / Readme.md. Toutes les données sont disponibles sur notre page de projet.

Pour faciliter le développement et l'évaluation des agents dans l'environnement AgentStudio, nous fournissons trois outils pour:

Ces outils, combinés à l'environnement réaliste de l'agentStudio, contribuent à la génération de données riches et structurées pour la formation et l'évaluation des agents. Veuillez vous référer à DOCS / ANNOTate_ground_ui.md pour l'outil d'annotation GUI, agent_studio / enregistreur / readme.md pour l'outil d'annotation vidéo-action, et EVAL_ONLINE_BENCHMARKS / readme.md pour la création / validation des tâches.

Les contributions et les commentaires de tout le monde sur la façon d'en faire un meilleur outil sont plus que bienvenues. Veuillez consulter contribution.md pour savoir comment vous impliquer.

Nous tenons à remercier les projets suivants pour leur inspiration et leurs contributions à la communauté open source: interprète ouvert, webarena, berceau, synapse, seleclick, screenagent, osworld, etc.

Si vous trouvez AgentStudio utile, veuillez citer notre article:

@article { zheng2024agentstudio ,

title = { AgentStudio: A Toolkit for Building General Virtual Agents } ,

author = { Longtao Zheng and Zhiyuan Huang and Zhenghai Xue and Xinrun Wang and Bo An and Shuicheng Yan } ,

journal = { arXiv preprint arXiv:2403.17918 } ,

year = { 2024 }

}