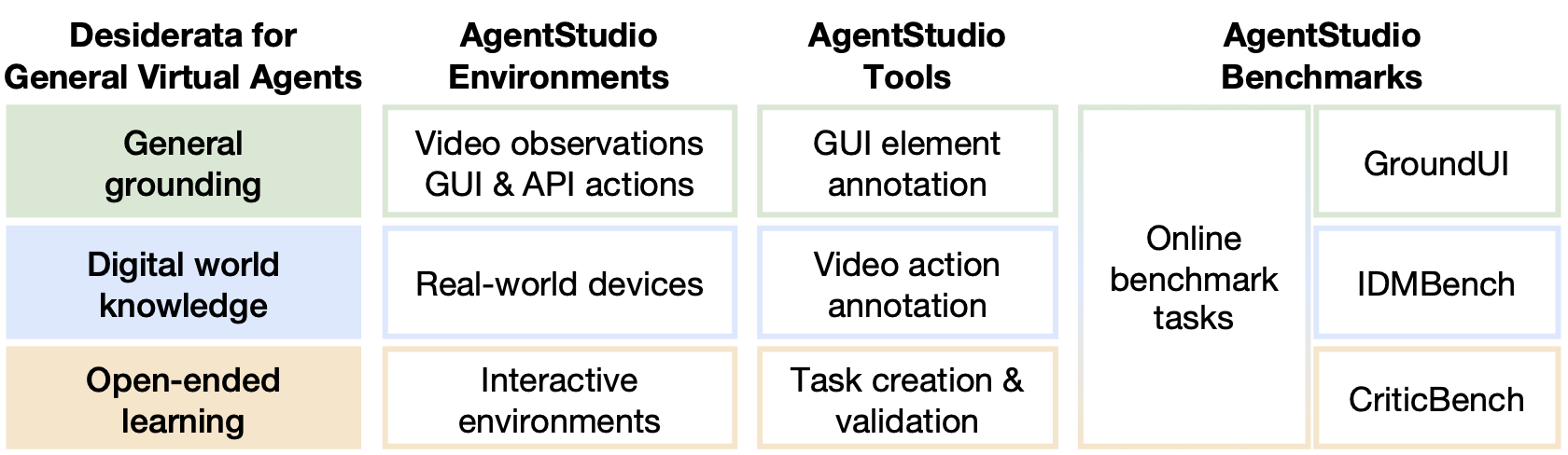

AgentStudio ist eine Dreifaltigkeit von Umgebungen, Tools und Benchmarks, in denen allgemeine virtuelle Agenten mit jeder Computersoftware interagieren können. AgentStudio richtet sich an die Desiderata für robuste, allgemeine und offene virtuelle Agenten, indem Sie:

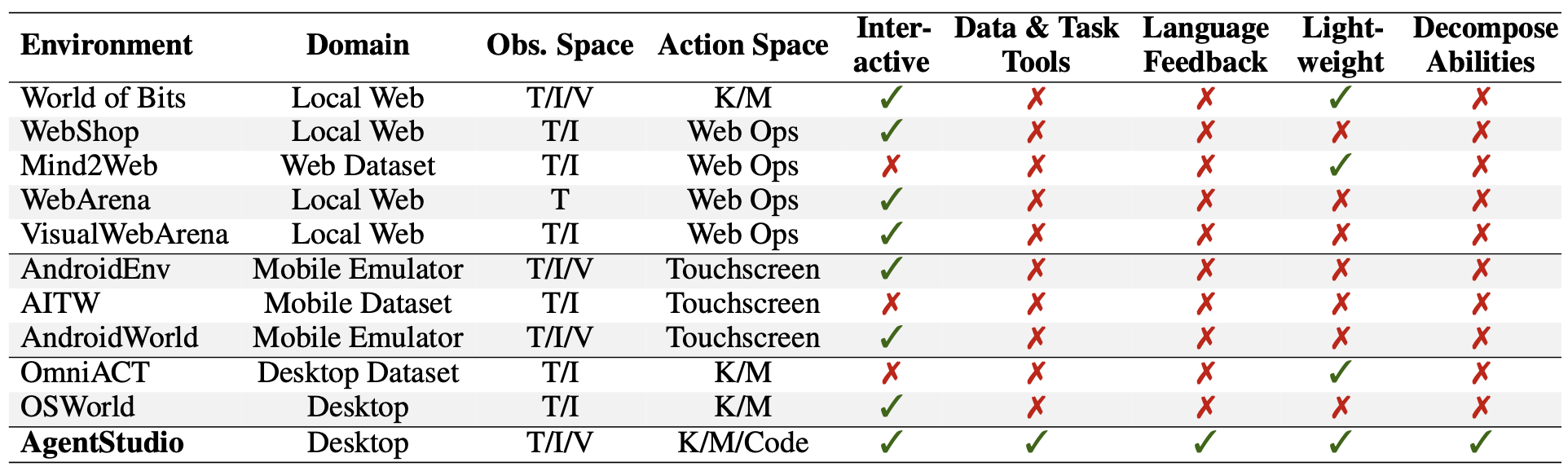

Vergleiche mit vorhandenen Arbeiten:

Anforderungen installieren:

apt-get install gnome-screenshot xclip xdotool # If using Ubuntu 22.04

conda create --name agent-studio python=3.11 -y

conda activate agent-studio

pip install -e ' .[client] ' Alle vertraulichen API -Schlüssel sollten in agent_studio/config/api_key.json agent_studio/config/api_key_template.json , z.

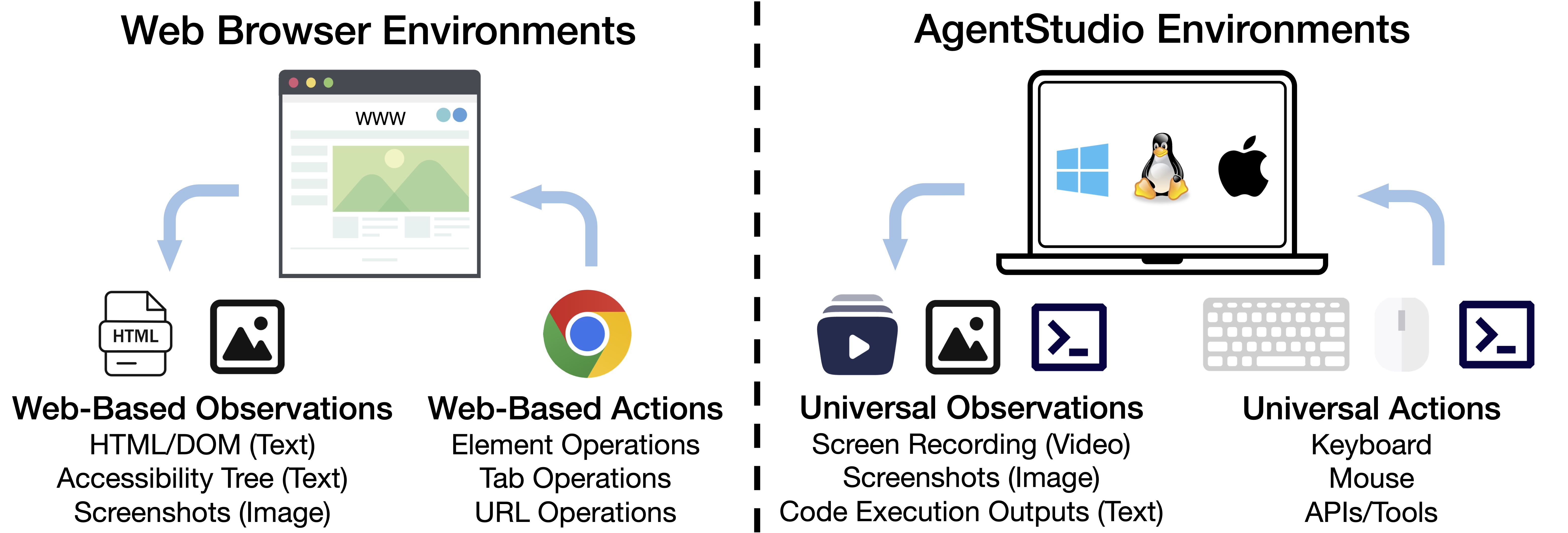

AgentStudio bietet die allgemeinsten Beobachtungs- und Aktionsräume, die den Aufgabenraum erheblich erweitern und die Entwicklung und Bewertung von Wirkstoffen in realen Einstellungen ermöglichen. Wir stellen eine Benchmark -Suite vor, die aus 205 Aufgaben besteht. Diese Aufgaben umfassen API -Verwendungen wie Terminal- und Google Mail- und GUI -Software wie VS -Code. Weitere Informationen finden Sie in Eval_online_Benchmarks/Readme.md. Die aufgabenbezogenen Dateien sind auf unserer Projektseite verfügbar.

Um tiefere Einblicke in Agentenfunktionen zu erhalten, die über die Gesamtleistung hinausgehen, die durch Online -Benchmark -Aufgaben gemessen werden, entwickeln wir drei Datensätze mit AgentStudio: Groundui, Idmbench und Criticbench. Diese Datensätze zielen auf allgemeine UI -Erdung, Lernen aus Videos und Erfolgserkennung ab. Weitere Details finden Sie in eval_agent_desiderata/readme.md. Alle Daten sind auf unserer Projektseite verfügbar.

Um die Entwicklung und Bewertung von Agenten in der AgentStudio -Umgebung zu erleichtern, bieten wir drei Instrumente für:

Diese Tools, kombiniert mit der realistischen Umgebung von AgentStudio, tragen zur Erzeugung reichhaltiger, strukturierter Daten für das Training und die Bewertung von Agenten bei. Weitere Informationen zum GUI-Annotation-Tool, Agent_Studio/Recorder/Readme.md finden Sie unter DOCS/Annotate_ground_ui.md für das Video-Action-Annotation-Tool und die Aufgabenerstellung/Validierung für das Video-Action-Annotation-Tool und Eval_online_Benchmarks/Readme.md.

Beiträge und Feedback von allen, wie man dies zu einem besseren Tool macht, sind mehr als willkommen. Bitte lesen Sie den Beitrag zu, um sich zu engagieren.

Wir möchten uns bei den folgenden Projekten für ihre Inspiration und Beiträge zur Open-Source-Community bedanken: Open Interpreter, Webarena, Cradle, Synapse, Seclick, Screenagent, Osworld usw.

Wenn Sie AgentStudio nützlich finden, zitieren Sie bitte unser Papier:

@article { zheng2024agentstudio ,

title = { AgentStudio: A Toolkit for Building General Virtual Agents } ,

author = { Longtao Zheng and Zhiyuan Huang and Zhenghai Xue and Xinrun Wang and Bo An and Shuicheng Yan } ,

journal = { arXiv preprint arXiv:2403.17918 } ,

year = { 2024 }

}