Ce référentiel contient du code d'inférence pour une prédiction précise de la fonction et de la structure des anticorps à l'aide du modèle de langage d'anticorps bio-inspiré

conda env create -f environment.yml

conda activate BALM

Les poids pré-formés du baume peuvent être téléchargés à partir du lien Google Drive: Balm prétrainé

from modeling_balm import BALMForMaskedLM

from ba_position_embedding import get_anarci_pos

from transformers import EsmTokenizer

import torch

# an antibody sequence example

input_seq = "AVQLQESGGGLVQAGGSLRLSCTVSARTSSSHDMGWFRQAPGKEREFVAAISWSGGTTNYVDSVKGRFDISKDNAKNAVYLQMNSLKPEDTAVYYCAAKWRPLRYSDNPSNSDYNYWGQGTQVTVSS"

tokenizer = EsmTokenizer.from_pretrained("./tokenizer/vocab.txt", do_lower_case=False, model_max_length=168)

tokenizer_input = tokenizer(input_seq, truncation=True, padding="max_length", return_tensors="pt")

# generate position_ids

tokenizer_input.update(get_anarci_pos(input_seq))

with torch.no_grad():

# please download from Google drive link before

model = BALMForMaskedLM.from_pretrained("./pretrained-BALM/")

# on CPU device

outputs = model(**tokenizer_input, return_dict=True, output_hidden_states=True, output_attentions=True)

# final hidden layer representation [batch_sz * max_length * hidden_size]

final_hidden_layer = outputs.hidden_states[-1]

# final hidden layer sequence representation [batch_sz * hidden_size]

final_seq_embedding = final_hidden_layer[:, 0, :]

# final layer attention map [batch_sz * num_head * max_length * max_length]

final_attention_map = outputs.attentions[-1]

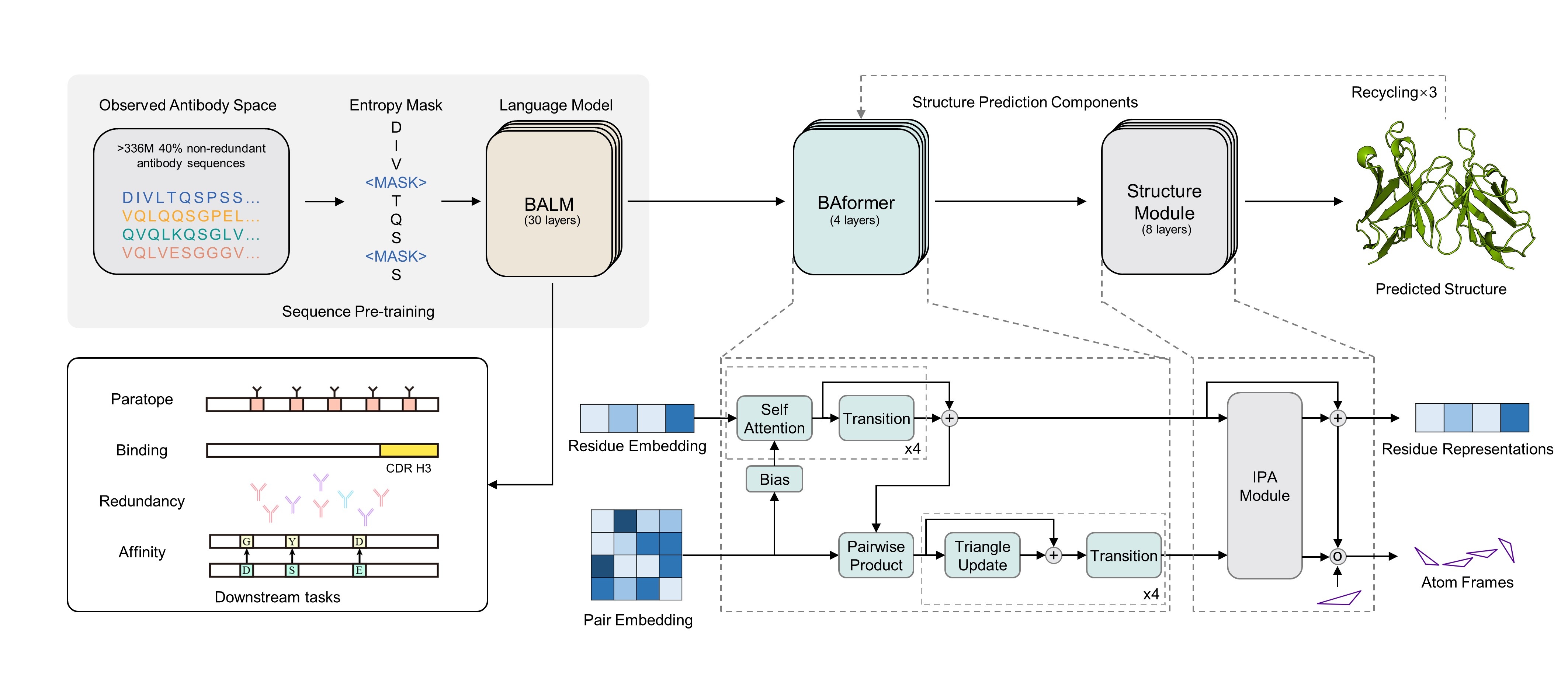

Balmfold est basé sur le baume pour prédire la structure tertiaire des anticorps avec une séquence primaire. Le serveur en ligne est disponible gratuitement sur le serveur Balmfold. Essayez-le. :)

Si vous trouvez que notre modèle vous est utile, veuillez citer comme:

@article{jing2024accurate,

title={Accurate prediction of antibody function and structure using bio-inspired antibody language model},

author={Jing, Hongtai and Gao, Zhengtao and Xu, Sheng and Shen, Tao and Peng, Zhangzhi and He, Shwai and You, Tao and Ye, Shuang and Lin, Wei and Sun, Siqi},

journal={Briefings in Bioinformatics},

volume={25},

number={4},

pages={bbae245},

year={2024},

publisher={Oxford University Press}

}

L'architecture et le processus de pré-formation du baume s'appuient sur le cadre ESM et étreignant la modélisation du visage. Nous apprécions vraiment le travail de l'ESM et de l'équipe FACE HUGGING.

Ce code source est concédé sous licence MIT dans le fichier LICENSE dans le répertoire racine de cette arborescence source.