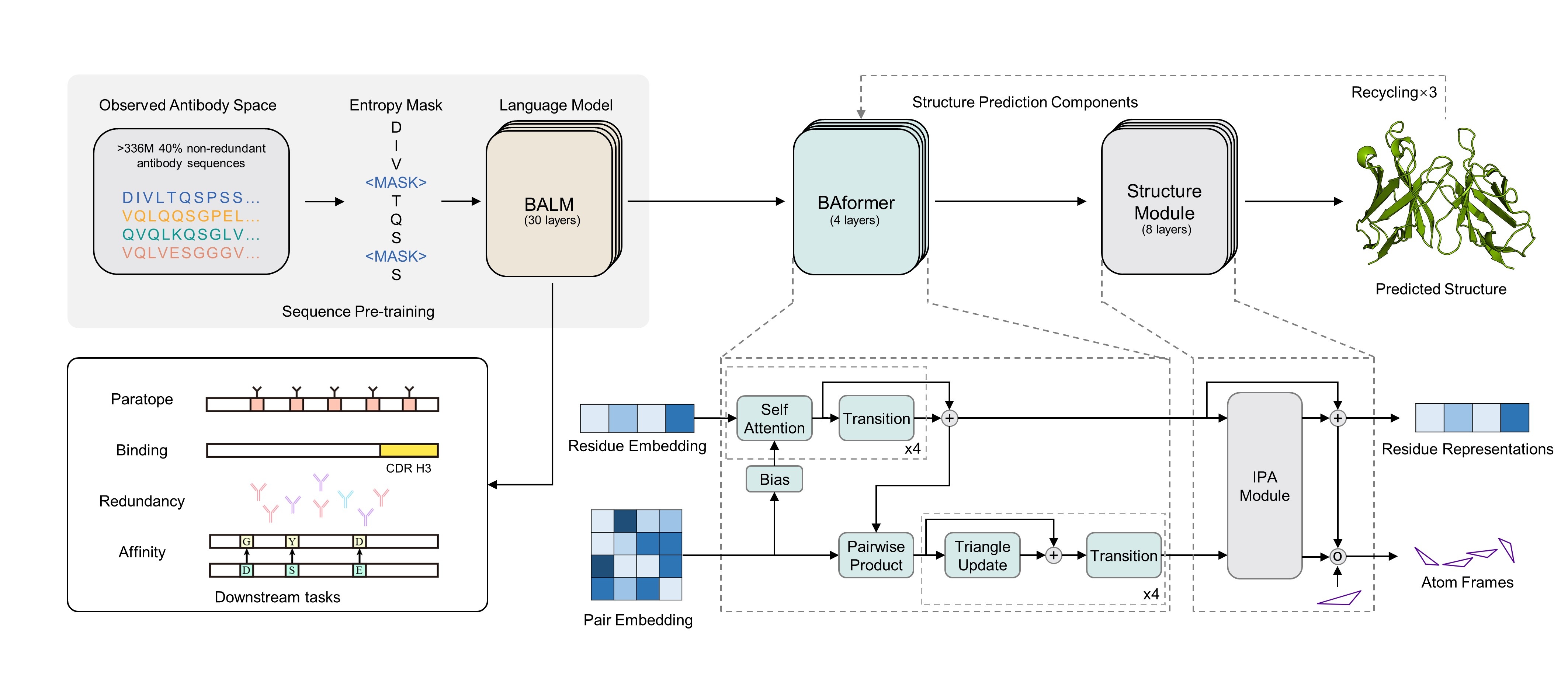

Este repositorio contiene código de inferencia para una predicción precisa de la función y estructura de anticuerpos utilizando un modelo de lenguaje de anticuerpos bioinspirados

conda env create -f environment.yml

conda activate BALM

Los pesos previamente capacitados del bálsamo se pueden descargar desde el enlace de Google Drive: Balm antes de

from modeling_balm import BALMForMaskedLM

from ba_position_embedding import get_anarci_pos

from transformers import EsmTokenizer

import torch

# an antibody sequence example

input_seq = "AVQLQESGGGLVQAGGSLRLSCTVSARTSSSHDMGWFRQAPGKEREFVAAISWSGGTTNYVDSVKGRFDISKDNAKNAVYLQMNSLKPEDTAVYYCAAKWRPLRYSDNPSNSDYNYWGQGTQVTVSS"

tokenizer = EsmTokenizer.from_pretrained("./tokenizer/vocab.txt", do_lower_case=False, model_max_length=168)

tokenizer_input = tokenizer(input_seq, truncation=True, padding="max_length", return_tensors="pt")

# generate position_ids

tokenizer_input.update(get_anarci_pos(input_seq))

with torch.no_grad():

# please download from Google drive link before

model = BALMForMaskedLM.from_pretrained("./pretrained-BALM/")

# on CPU device

outputs = model(**tokenizer_input, return_dict=True, output_hidden_states=True, output_attentions=True)

# final hidden layer representation [batch_sz * max_length * hidden_size]

final_hidden_layer = outputs.hidden_states[-1]

# final hidden layer sequence representation [batch_sz * hidden_size]

final_seq_embedding = final_hidden_layer[:, 0, :]

# final layer attention map [batch_sz * num_head * max_length * max_length]

final_attention_map = outputs.attentions[-1]

Balmfold se basa en el bálsamo para predecir la estructura terciaria de anticuerpos con secuencia primaria. El servidor en línea está disponible gratuitamente en Balmfold Server. Solo pruébalo. :)

Si encuentra que nuestro modelo es útil para usted, cite como:

@article{jing2024accurate,

title={Accurate prediction of antibody function and structure using bio-inspired antibody language model},

author={Jing, Hongtai and Gao, Zhengtao and Xu, Sheng and Shen, Tao and Peng, Zhangzhi and He, Shwai and You, Tao and Ye, Shuang and Lin, Wei and Sun, Siqi},

journal={Briefings in Bioinformatics},

volume={25},

number={4},

pages={bbae245},

year={2024},

publisher={Oxford University Press}

}

La arquitectura y el proceso de pre-entrenamiento del bálsamo se basan en el marco de modelado facial de ESM y abrazando. Realmente apreciamos el trabajo de ESM y Hugging Face Team.

Este código fuente tiene licencia bajo la licencia MIT que se encuentra en el archivo LICENSE en el directorio raíz de este árbol de origen.