Mise en œuvre officielle du système de documents MSMC-TTS

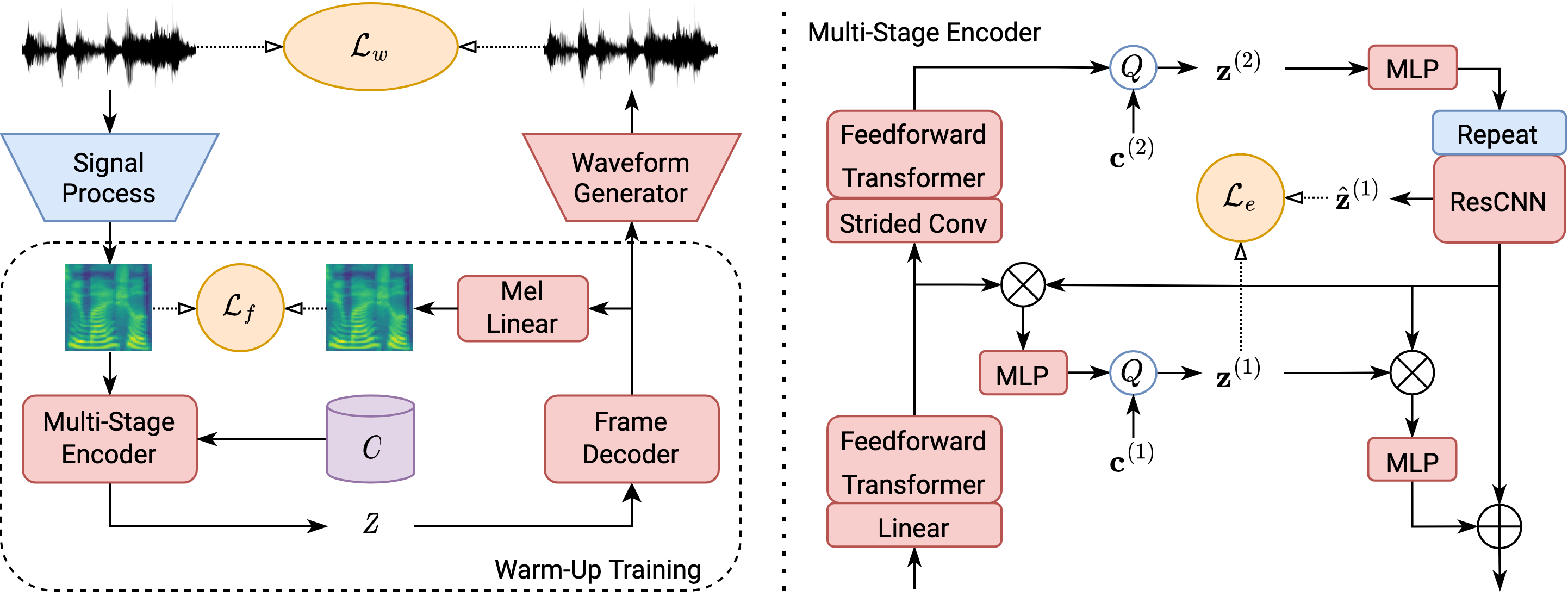

Le dernier MSMC-TTS (MSMC-TTS-V2) est optimisé avec un autoencoder basé sur MSMC-VQ-AG combinant MSMC-VQ-VAE et HIFIGAN. Le prédicteur en plusieurs étapes est toujours appliqué comme modèle acoustique pour prédire les MSMCR pour la synthèse TTS.

[2024.04.10] (en cours) L'implémentation de QS-TTS est disponible à des exemples / CSMSC / configs

[2022.10.20] Nous publions la dernière version de MSMC-TTS (MSMC-TTS-V2) basée sur MSMC-VQ-GAN. Veuillez vous référer à notre dernier article "vers les TT de haute qualité pour les langues à faible ressource en apprenant la représentation compacte"

[2022.10.18] Nous publierons le code de toutes les versions de MSMC-TTS dans ce dépôt. Et toute personne intéressée par ce travail est la bienvenue à nous rejoindre pour explorer des représentations de la parole plus utiles pour la synthèse de la parole.

[2022.9.22] "Une approche VQ-VAE multi-Codebook multi-étages des TTs neuronaux à haute performance" est publiée sur IntereSpeech 2022.

# Install

pip -r requirements.txt

# Train (Take the example of CSMSC, please refer to the example of CSMSC to prepare your training data)

python train.py -c examples/csmsc/configs/msmc_vq_gan.yaml

python train.py -c examples/csmsc/configs/msmc_vq_gan_am.yaml

# Multi-GPU Training

python train_dist.py -c examples/csmsc/configs/msmc_vq_gan.yaml

python train_dist.py -c examples/csmsc/configs/msmc_vq_gan_am.yaml

# Test -- Analysis-Synthesis

python infer.py -c examples/csmsc/configs/msmc_vq_gan.yaml -m examples/csmsc/checkpoints/msmc_vq_gan/model_800000 -t examples/csmsc/data/test_ae.yaml -o analysis_synthesis

# Test -- TTS-Synthesis

python infer.py -c examples/csmsc/configs/msmc_vq_gan_am.yaml -m examples/csmsc/checkpoints/msmc_vq_gan_am/model_200000 -t examples/csmsc/data/test_tts.yaml -o tts

Vous aider à mieux former vos modèles!

@inproceedings{guo2022msmc,

title={A Multi-Stage Multi-Codebook VQ-VAE Approach to High-Performance Neural TTS},

author={Guo, Haohan and Xie, Fenglong and Soong, Frank K and Wu, Xixin and Meng, Helen},

booktitle={Proc. INTERSPEECH},

year={2022}

}