Nouvelles

Notre bibliothèque d'accélération GNN pour Pytorch est maintenant disponible. https://github.com/alibaba/graphlearn-for-pytorch

Documentation

简体中文 | Anglais

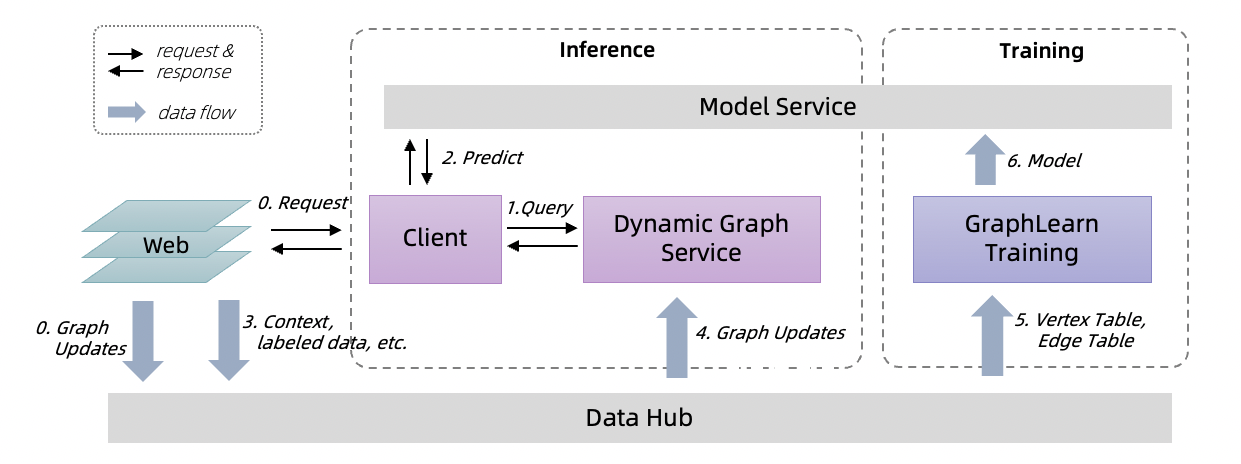

Graph-Learn (anciennement Aligraph) est un cadre distribué conçu pour le développement et l'application de réseaux de neurones graphiques à grande échelle. Il a été appliqué avec succès à de nombreux scénarios au sein d'Alibaba, tels que la recommandation de recherche, la sécurité du réseau et le graphique de connaissances. Après Graph-Learn 1.0, nous avons ajouté des services d'inférence en ligne au framework Graph-Learn, fournissant une solution complète comprenant une formation et une inférence pour les GNN à utiliser dans les affaires réelles.

Graphlearn-Train

Le cadre de formation prend en charge l'échantillonnage sur les graphiques par lots, la formation hors ligne ou les modèles GNN incrémentiels.

Il fournit à la fois des interfaces Python et C ++ pour les opérations d'échantillonnage de graphiques et fournit une interface GSL (langage d'échantillonnage de graphiques) de type Gremlin. Pour les modèles GNN, Graph-Learn fournit un ensemble de paradigmes et de processus pour le développement du modèle. Il est compatible avec TensorFlow et Pytorch, et fournit une couche de données, des interfaces de couche de modèle et de riches exemples de modèle.

Détail

Service dynamique

Un service d'inférence en ligne, prend en charge l'échantillonnage en temps réel sur des graphiques dynamiques avec des mises à jour de graphiques en streaming.

Il offre une garantie de performance de la latence P99 d'échantillonnage en 20 ms sur des graphiques dynamiques à grande échelle. Le côté client du service d'inférence en ligne fournit des interfaces Java GSL et du modèle TensorFlow.

Détail

Utilisez Graphlearn-Training et Dynamic-Graph-Service pour la formation et l'inférence.

Veuillez citer l'article suivant dans vos publications si Graph-Learn aide vos recherches.

@article{zhu2019aligraph,

title={AliGraph: a comprehensive graph neural network platform},

author={Zhu, Rong and Zhao, Kun and Yang, Hongxia and Lin, Wei and Zhou, Chang and Ai, Baole and Li, Yong and Zhou, Jingren},

journal={Proceedings of the VLDB Endowment},

volume={12},

number={12},

pages={2094--2105},

year={2019},

publisher={VLDB Endowment}

}

Licence Apache 2.0.