Nachricht

Unsere GNN -Beschleunigungsbibliothek für Pytorch ist ab sofort verfügbar. https://github.com/alibaba/graphlearn-for-pytorch

Dokumentation

简体中文 | Englisch

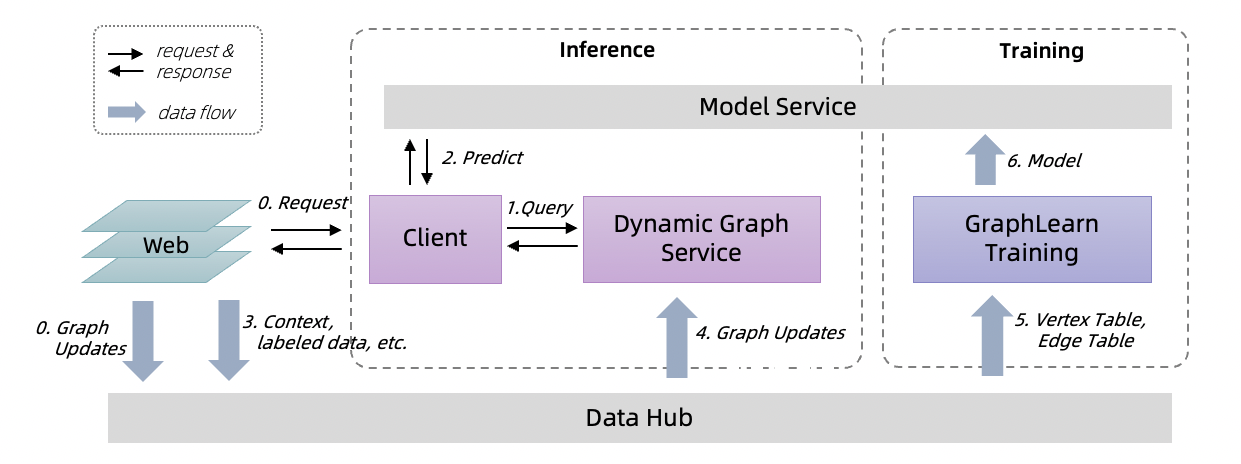

Graph-Learn (ehemals Aligraph) ist ein verteiltes Rahmen für die Entwicklung und Anwendung großer Grafiknetzwerke. Es wurde erfolgreich auf viele Szenarien innerhalb von Alibaba angewendet, z. B. Suchempfehlungen, Netzwerksicherheit und Wissensgrafik. Nach dem Graph-Learn 1.0 haben wir dem Graph-Learn-Framework Online-Inferenzdienste hinzugefügt und eine vollständige Lösung mit Schulungen und Inferenz für die Verwendung von GNNs im realen Unternehmen bereitgestellt.

Graphlearn-Training

Das Trainingsrahmen unterstützt die Stichprobe für Stapeldiagramme, Schulungen offline oder inkrementelle GNN -Modelle.

Es liefert sowohl Python- als auch C ++-Schnittstellen für Grafikabtastvorgänge und bietet eine Gremlin-ähnliche GSL-Schnittstelle (Graph-Stichprobensprache). Für GNN-Modelle bietet Graph-Learn eine Reihe von Paradigmen und Prozessen für die Modellentwicklung. Es ist sowohl mit Tensorflow als auch mit Pytorch kompatibel und bietet Datenschicht, Modellschichtschnittstellen und reichhaltige Modellbeispiele.

Detail

Dynamischer Graphservice

Ein Online-Inferenzdienst unterstützt Echtzeit-Sampling in dynamischen Diagrammen mit Streaming-Graphen-Updates.

Es bietet eine Leistungsgarantie für die Probenahme von P99-Latenz in 20 ms in groß angelegten dynamischen Graphen. Die Kundenseite des Online -Inferenzdienstes bietet Java GSL -Schnittstellen und das TensorFlow -Modell vorhersagen.

Detail

Verwenden Sie Graphlearn-Training und dynamisches Graphservice für Training und Inferenz.

Bitte zitieren Sie das folgende Papier in Ihren Veröffentlichungen, wenn das Diagramm-Learn Ihre Forschung hilft.

@article{zhu2019aligraph,

title={AliGraph: a comprehensive graph neural network platform},

author={Zhu, Rong and Zhao, Kun and Yang, Hongxia and Lin, Wei and Zhou, Chang and Ai, Baole and Li, Yong and Zhou, Jingren},

journal={Proceedings of the VLDB Endowment},

volume={12},

number={12},

pages={2094--2105},

year={2019},

publisher={VLDB Endowment}

}

Apache -Lizenz 2.0.