Amélioration de la précision des applications LLM

Bienvenue dans le cours "Amélioration de la précision des applications LLM"! Le cours fournit une approche systématique pour améliorer la précision et la fiabilité de vos applications LLM.

Résumé du cours

De nombreux développeurs luttent contre des résultats incohérents dans les applications LLM. ? Ce cours est conçu pour relever ces défis en offrant une expérience pratique dans l'amélioration de la précision grâce à l'évaluation, à l'ingénierie rapide, à l'auto-réflexion et aux techniques de réglage fin.

Ce que vous allez faire:

- ? Développement de l'agent SQL : construire un agent de texte à SQL et simuler des situations où il s'hallucite pour commencer le processus d'évaluation.

- Cadre d'évaluation : Créez un cadre robuste pour mesurer systématiquement les performances, y compris les critères de bonnes évaluations, les meilleures pratiques et le développement d'un score d'évaluation.

- Instruction Fonction : découvrez comment le réglage fin des instructions aide les LLMS à suivre les instructions plus précisément et comment la mémoire amenait la mémoire intégrer les faits pour réduire les hallucinations.

- Le réglage fin et efficace (PEFT) : Découvrez des techniques avancées comme l'adaptation de faible rang (LORA) et le mélange d'experts en mémoire (Mome) pour réduire le temps de formation tout en améliorant les performances du modèle.

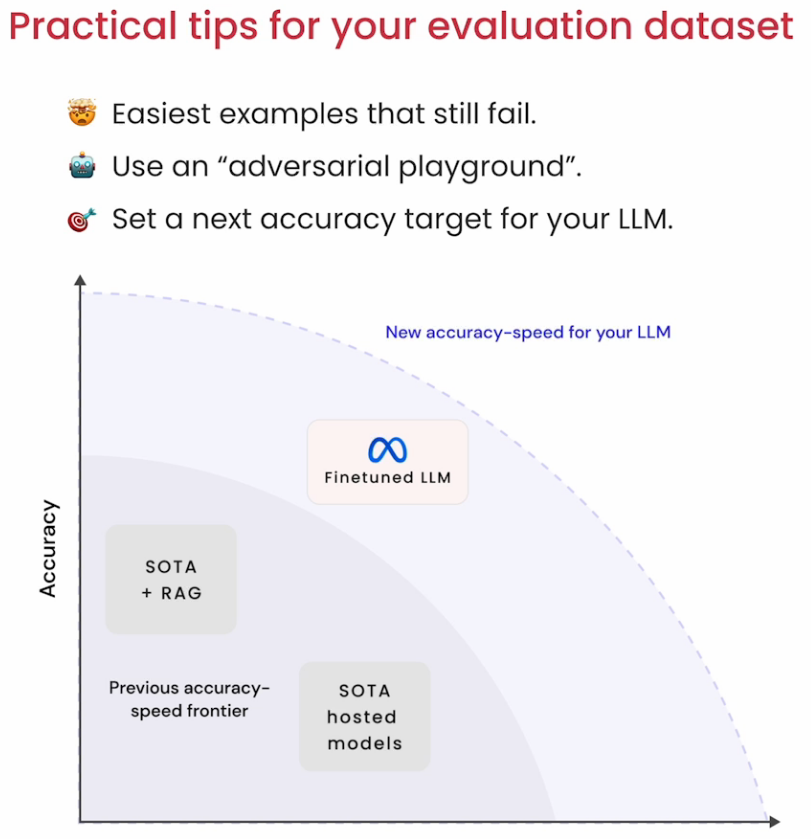

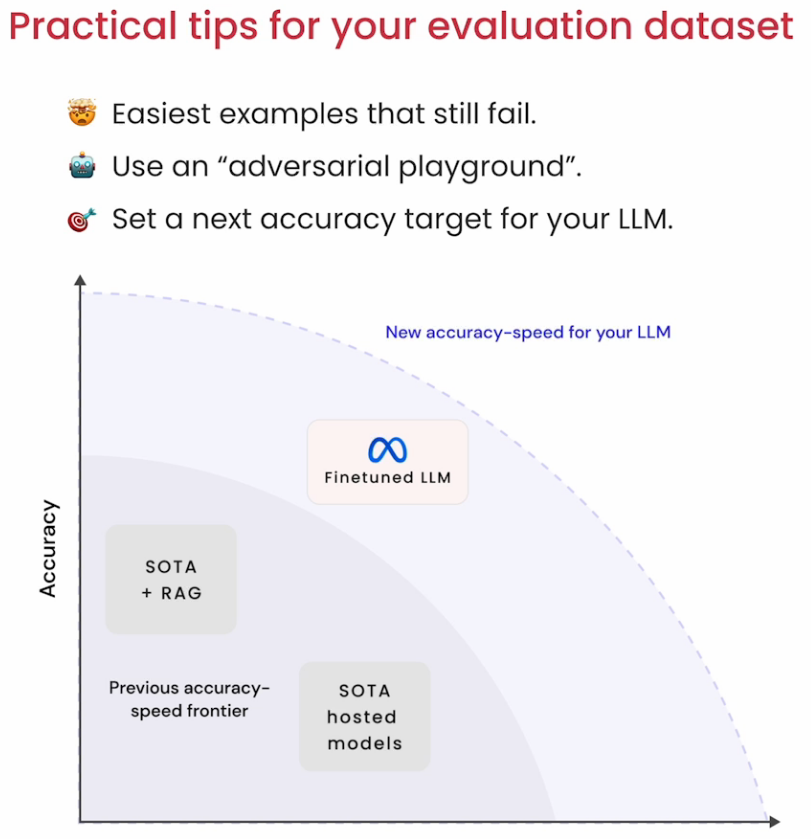

- Affinement itératif : passez par un processus itératif de génération de données de formation, de réglage fin et d'application de conseils pratiques pour augmenter la précision du modèle.

? Points clés

- Amélioration systématique : apprenez les étapes de développement, de l'évaluation, de l'incitation, de l'auto-réflexion et du réglage fin, pour améliorer la fiabilité et la précision de votre modèle.

- ? Digne de mémoire : améliorez les performances de votre modèle en intégrant des faits pour réduire les hallucinations.

- ? Modèles de lama : utilisez le modèle LLAMA 3-8B pour créer une application LLM qui convertit le texte en SQL avec un schéma personnalisé.

? ? À propos des instructeurs

- ? Sharon Zhou : co-fondatrice et PDG de Lamini, Sharon apporte son expertise dans le développement de LLM et le réglage fin.

- ? Amit Sangani : directeur principal de l'ingénierie partenaire chez Meta, AMIT partage de précieuses informations sur les applications LLM fiables d'ingénierie.

? Pour vous inscrire au cours ou pour plus d'informations, visitez Deeplearning.ai.