Rag simple avec codegemma: 7b

Ce travail met en œuvre un système de chiffon simple avec GoogleCodegemma:7b , Qdrant as VectorDB et CoNaLa . Nous développons une application simple avec GRADIO et créons une image Dcoker pour Conatiner Runtime.

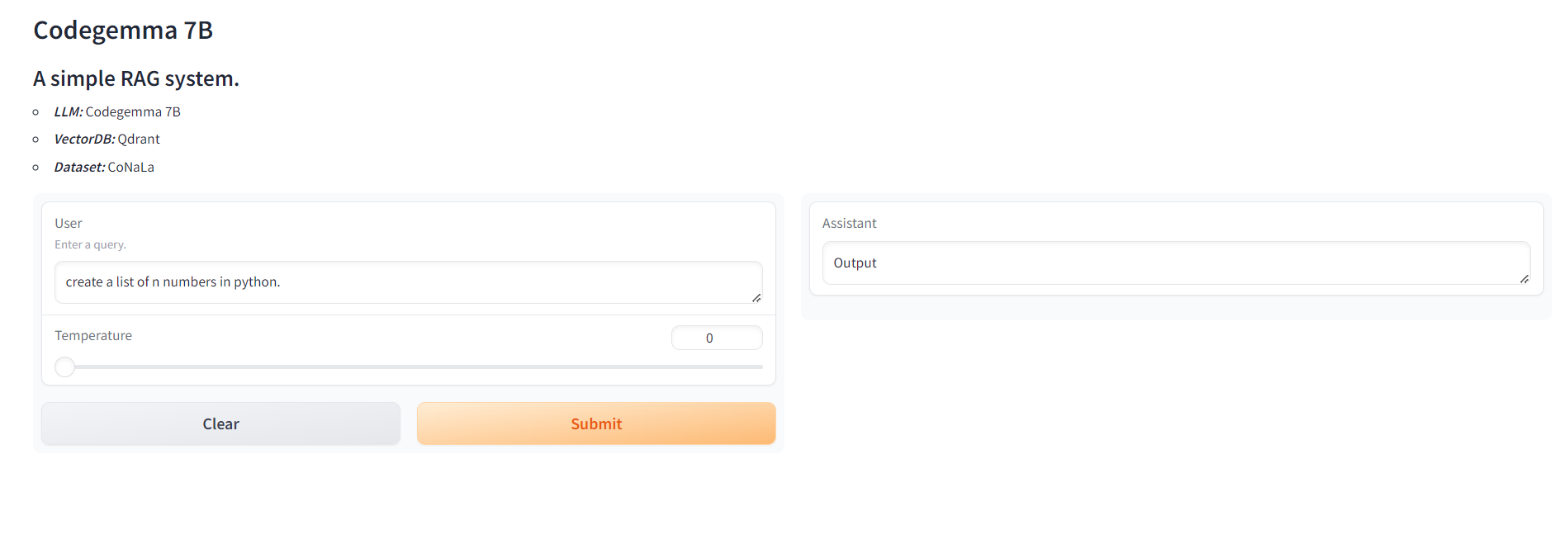

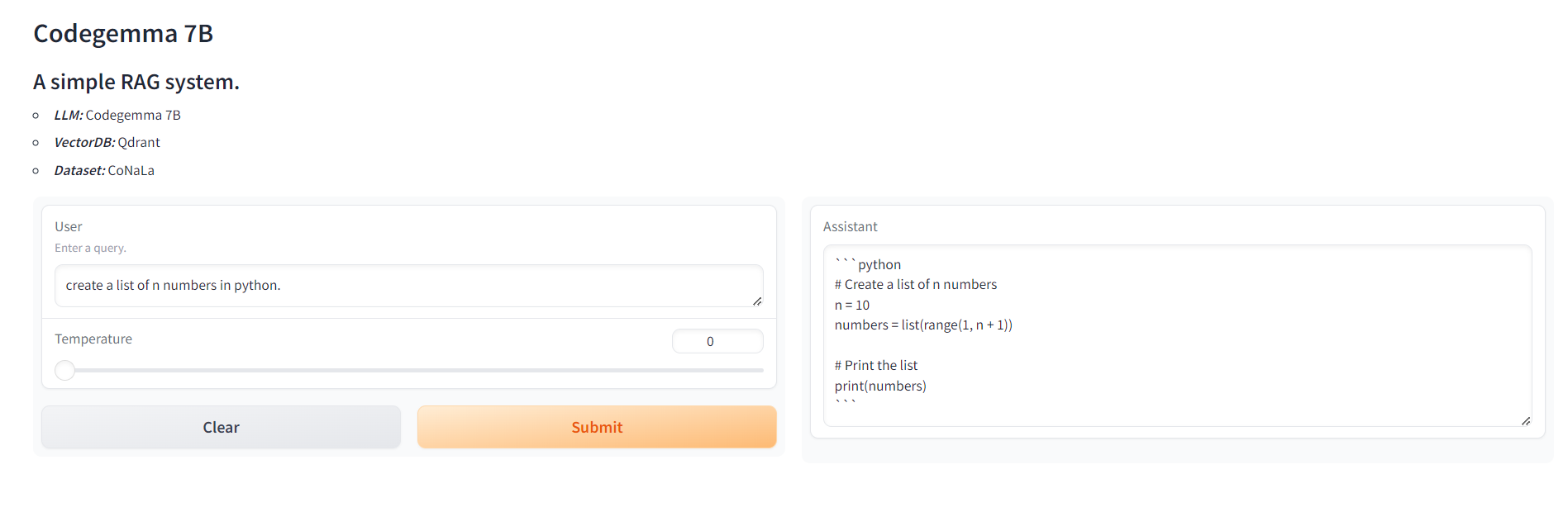

Gradio App UI

Structures de fichiers

- RAG_LOCALLLM.IPYNB: Ce carnet contient du code et de l'explication de la mise en œuvre du chiffon avec CodeGemma.

- Connexion au LLM local via Olllama

- Importer des données

- Modèle d'intégration d'importation

- Incorporer les documents et créer une base de données vectorielle

- Prenez une requête utilisateur

- Effectuer des requêtes d'intégration et de récupération

- Effectuer un chiffon avec Codegemma

- * vector_database.py: le code de création de vectordb

- app.py: le code de l'application Gradio

Architectures

- Base de données vectorielle: QDRANT

- Cadre d'application: Gradio

- LLM: Google Codegemma

- Serveur LLM: Olllama

- Incorporation: All-Minilm-L6-V2

- Base de données: conala

Docker

L'image docker de l'application est poussée vers Docker Hub. Pour exécuter l'application, nous avons besoin du système Linux avec une mémoire minimun de 8 Go. Pour exécuter l'application, exécutez simplement la commande

Si vous trouvez le repo utile, veuillez laisser tomber un