Trapo simple con Codegemma: 7b

Este trabajo implementa un sistema de RAG simple con GoogleCodegemma:7b , Qdrant as VectorDB y CoNaLa DataSet. Desarrollamos una aplicación simple con GRADIO y creamos una imagen Dcoker para el tiempo de ejecución de Conatiner.

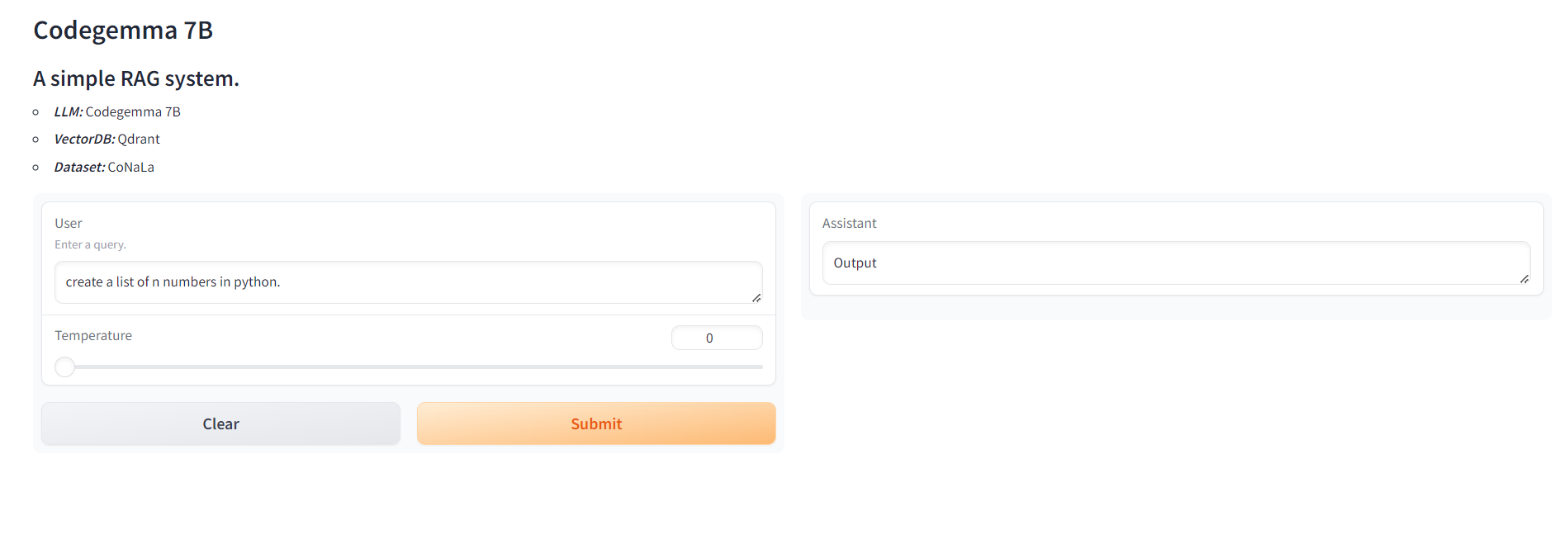

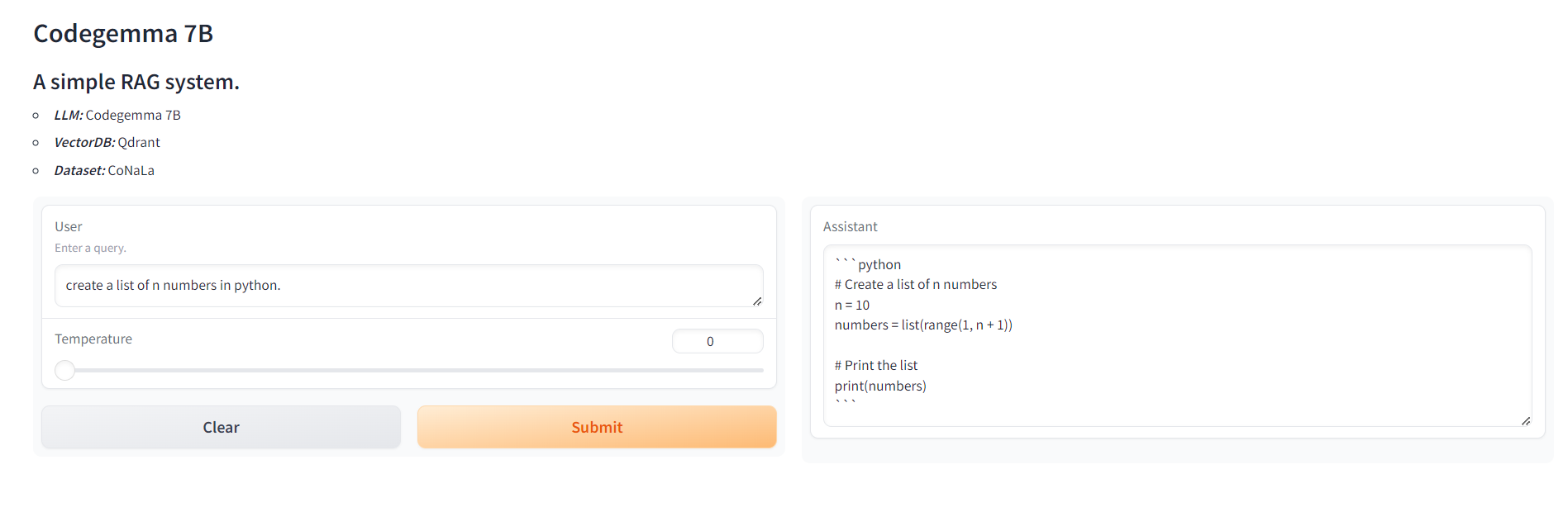

UI de la aplicación de Gradio

Estructuras de archivo

- Rag_localllm.IPYNB: este cuaderno contiene código y explicación para implementar RAG con Codegemma.

- Conectarse a LLM local a través de Ollama

- Importar datos

- Modelo de incrustación de importación

- Incrustar los documentos y crear una base de datos vectorial

- Tomar consultas de usuario

- Realizar incrustación y recuperación de consultas

- Realizar trapo con Codegemma

- * vector_database.py: el código para crear vectordb

- App.py: el código para la aplicación Gradio

Arquitecturas

- Base de datos vectorial: Qdrant

- Marco de aplicaciones: Gradio

- LLM: Google CodeGemma

- Servidor LLM: Ollama

- Incrustación: All-Minilm-L6-V2

- Base de datos: conala

Estibador

La imagen Docker de la aplicación se presiona al Docker Hub. Para ejecutar la aplicación necesitamos el sistema Linux con memoria minimun de 8 GB. Para ejecutar la aplicación, simplemente ejecute el comando

Si encuentra útil el repositorio, deje caer un