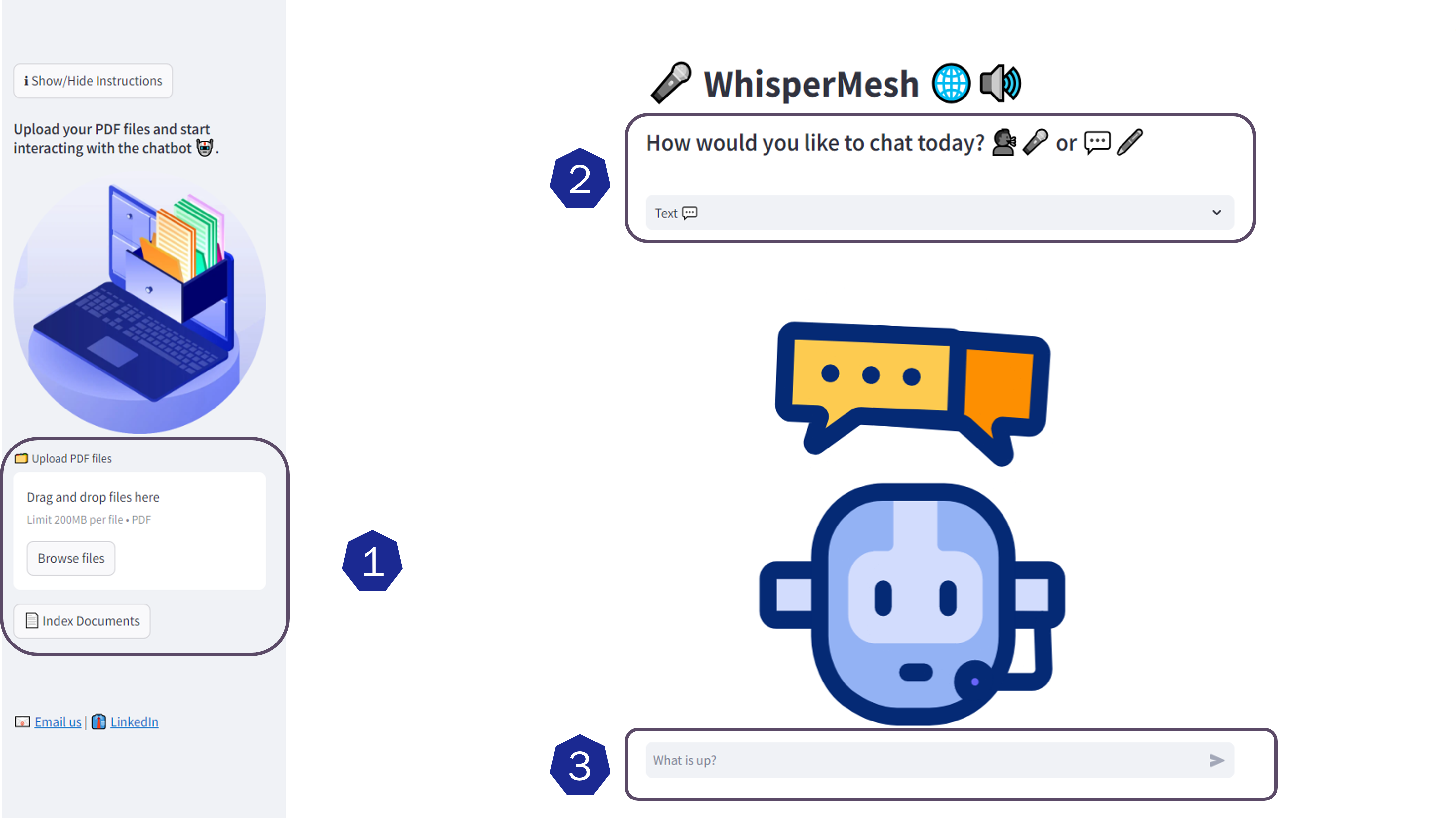

WhisperMesh est votre chatbot de pointe qui mélange de manière transparente les interactions vocales et texte, créant une expérience conversationnelle riche et intuitive. Avec la puissance des modèles LLM et une base de données vectorielle sophistiquée, WhisperMesh comprend vos besoins comme jamais auparavant, fournissant des réponses sur mesure qui résonnent avec vos requêtes.

Exploitant le cadre du chiffon de la botte de foin, notre application excelle dans l'extraction d'informations pertinentes, garantissant que chaque interaction est non seulement engageante mais aussi basée sur les données. Que vous préfériez parler ou taper, WhisperMesh s'adapte à votre style, en transformant votre entrée en réponses perspicaces avec une touche personnelle.

Rejoignez la conversation avec WhisperMesh, où votre voix compte, et laissez-nous vous guider à travers un monde de connaissances et de découvertes! ?

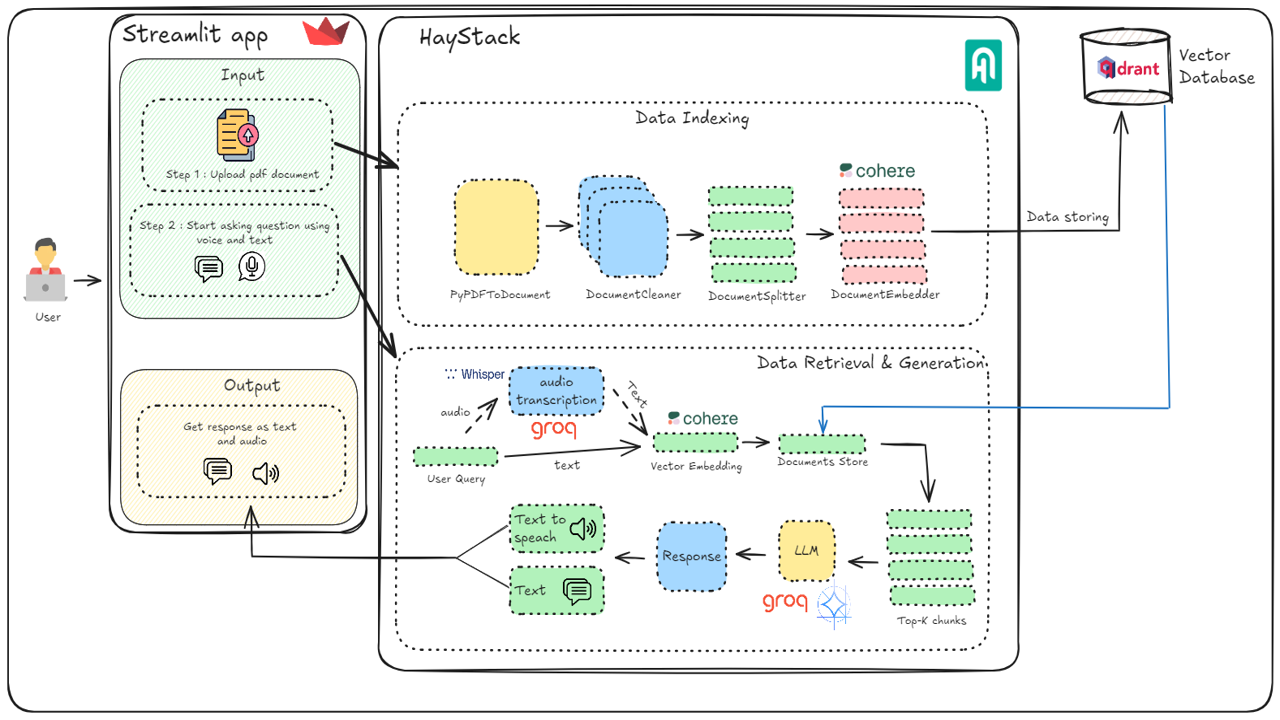

L'architecture décrit une application rationalisée intégrée au framework de sac de foin pour faciliter le téléchargement, la requête et la génération de réponse des documents. Les utilisateurs téléchargent des documents PDF via l'application, qui sont ensuite traités et indexés par des composants de sac de foin, y compris des nettoyeurs de documents, des séparateurs et des intégres qui convertissent les documents en représentations vectorielles à l'aide du modèle Cohere, stocké dans la base de données vectorielle QDRANT. Lorsqu'un utilisateur soumet une requête vocale, il est transcrit au texte, intégré dans un vecteur et correspond aux vecteurs de document stockés pour récupérer des morceaux pertinents. Ces morceaux sont introduits dans le modèle génératif Gemma 7b pour générer une réponse cohérente, qui est ensuite convertie en audio pour la sortie de l'utilisateur. Ce système exploite des techniques de PNL avancées pour assurer une récupération et une génération de réponses efficaces et précises.

WhisperMesh offre une expérience conversationnelle de pointe en mélangeant des entrées vocales et de texte, vous permettant de communiquer de la manière qui vous convient le mieux.

Propulsé par des modèles de langage de pointe (LLMS), WhisperMesh comprend profondément vos besoins et fournit des réponses sur mesure qui résonnent avec vos requêtes.

En utilisant QDRANT comme base de données vectorielle, WhisperMesh gère efficacement et récupère les informations pertinentes, garantissant des interactions basées sur les données qui améliorent l'engagement des utilisateurs.

Notre application exploite le modèle d'intégration de Cohere pour une compréhension sémantique efficace, garantissant que chaque interaction est perspicace et contextuellement consciente.

Avec le modèle Whisper-Large-V3 de Groq Cloud, WhisperMesh excelle à convertir la parole en texte, ce qui rend les interactions vocales lisses et précises.

En utilisant le modèle GEMMA-7B-IT de Groq Cloud, notre application génère des réponses personnalisées, ajoutant une touche unique à chaque conversation.

Exploitant le cadre du chiffon (génération de la récupération auprès) de Haystack , Whispermesh excelle dans l'extraction d'informations pertinentes, en veillant à ce que vos interactions soient engageantes et informatives.

git clone https://github.com/Mouez-Yazidi/WhisperMesh.git

cd WhisperMesh Créez un fichier .env et ajoutez les variables suivantes en fonction des informations d'identification que vous avez obtenues à partir des plates-formes requises:

COHERE_API_KEY=

GROQ_API=

GROQ_KEY=

QDRANT_API=

QDRANT_KEY=

Accédez au répertoire local et installez les dépendances nécessaires:

cd local

pip install -r requirements.txtPour exécuter l'application localement, exécutez la commande suivante:

streamlit run ../app/main.py --environment localVous devriez maintenant pouvoir accéder à l'application sur http: // localhost: 8501.

Si vous préférez exécuter l'application dans un conteneur Docker, suivez ces étapes:

docker build -t whispermesh -f Dockerfile ..docker run -p 8501:8501 whispermesh streamlit run main.py --environment localAssurez-vous que votre code est poussé vers un référentiel GitHub.

COHERE_API_KEY = " "

GROQ_API = " "

GROQ_KEY = " "

QDRANT_API = " "

QDRANT_KEY = " "Rationaliser le cloud Will:

? Vous êtes prêt! Votre application sera désormais en direct sur Streamlit Cloud!

Si vous appréciez ce projet, je vous serais reconnaissant si vous pouviez lui donner une star sur Github. Votre soutien nous motive à améliorer et à étendre notre travail!

Ce projet est autorisé sous la licence du MIT. Voir le fichier de licence pour plus de détails.

Si vous avez des questions ou des suggestions, n'hésitez pas à ouvrir un problème ou à nous contacter à [email protected].