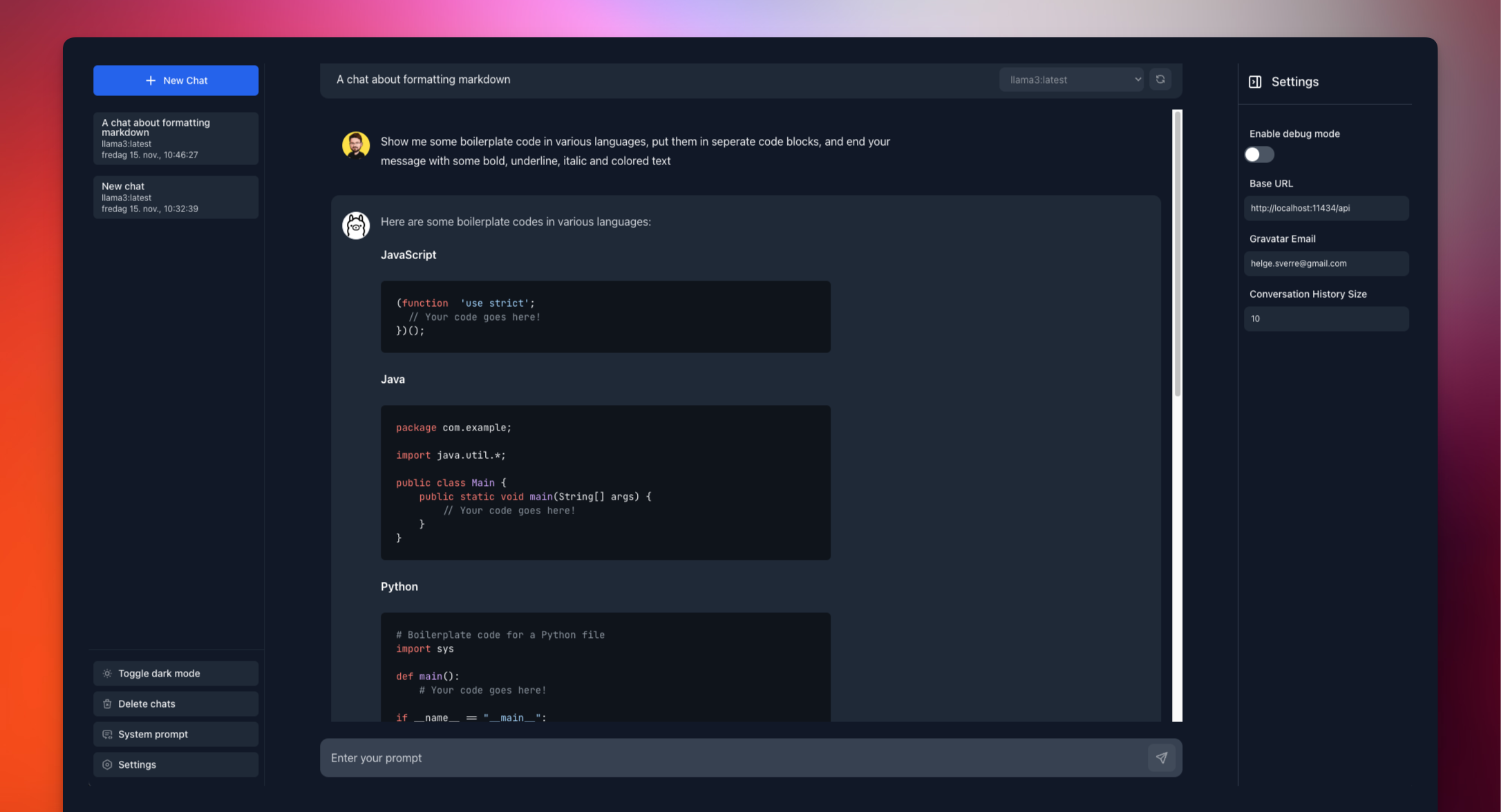

ollama gui

1.0.0

Une interface Web moderne pour discuter avec votre LLMS local via Olllama

# Start Ollama server with your preferred model

ollama pull mistral # or any other model

ollama serve

# Clone and run the GUI

git clone https://github.com/HelgeSverre/ollama-gui.git

cd ollama-gui

yarn install

yarn devPour utiliser la version hébergée, exécutez Olllama avec:

OLLAMA_ORIGINS=https://ollama-gui.vercel.app ollama serve # Build the image

docker build -t ollama-gui .

# Run the container

docker run -p 8080:80 ollama-gui

# Access at http://localhost:8080 Libéré sous la licence du MIT.