Discord: https://discord.gg/umagshnjzc

La façon la plus simple d'exécuter du code est d'utiliser une image docker prédéfinie. Vous pouvez trouver la dernière image sur le registre des conteneurs GitHub.

Important

Vous devez utiliser une variable d'environnement correspondante afin d'utiliser l'un des modèles de langage pris en charge.

Vous pouvez exécuter l'image Docker avec la commande suivante. Supprimer ou modifier les variables environnementales en fonction de vos besoins.

docker run

-e OPEN_AI_KEY=your_open_ai_key

-e OPEN_AI_MODEL=gpt-4-0125-preview

-e OLLAMA_MODEL=llama2

-p 3000:8080

-v /var/run/docker.sock:/var/run/docker.sock

ghcr.io/semanser/codel:latest Alternativement, vous pouvez créer un fichier .env et exécuter l'image Docker avec le drapeau --env-file . Plus d'informations peuvent être trouvées ici

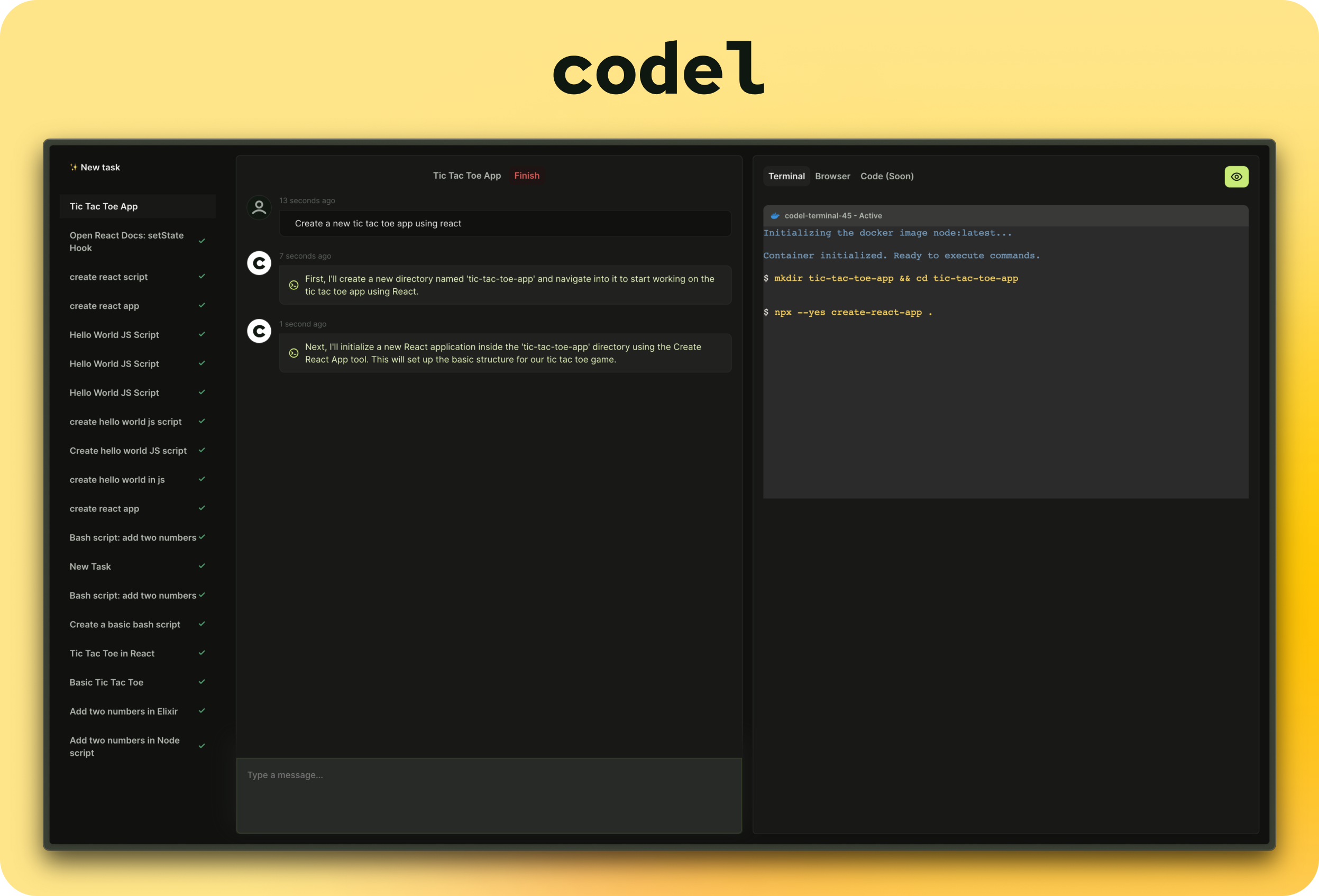

Vous pouvez maintenant visiter LocalHost: 3000 dans votre navigateur et commencer à utiliser Codel.

* `OPEN_AI_KEY` - OpenAI API key. You can get the key [here](https://platform.openai.com/account/api-keys).

* `OPEN_AI_MODEL` - OpenAI model (default: gpt-4-0125-preview). The list of supported OpenAI models can be found [here](https://pkg.go.dev/github.com/sashabaranov/go-openai#pkg-constants).

* `OPEN_AI_SERVER_URL` - OpenAI server URL (default: https://api.openai.com/v1). Change this URL if you are using an OpenAI compatible server.

* `OLLAMA_MODEL` - locally hosted Ollama model (default: https://ollama.com/model). The list of supported Ollama models can be found [here](https://ollama.com/models).

* `OLLAMA_SERVER_URL` - Ollama server URL (default: https://host.docker.internal:11434). Change this URL if you are using an Ollama compatible server.

See backend [.env.example](./backend/.env.example) for more details.

Consultez le développement.md pour plus d'informations.

Vous pouvez trouver la feuille de route du projet ici.

Ce projet ne serait pas possible sans: