Discord: https://discord.gg/umagshnjzc

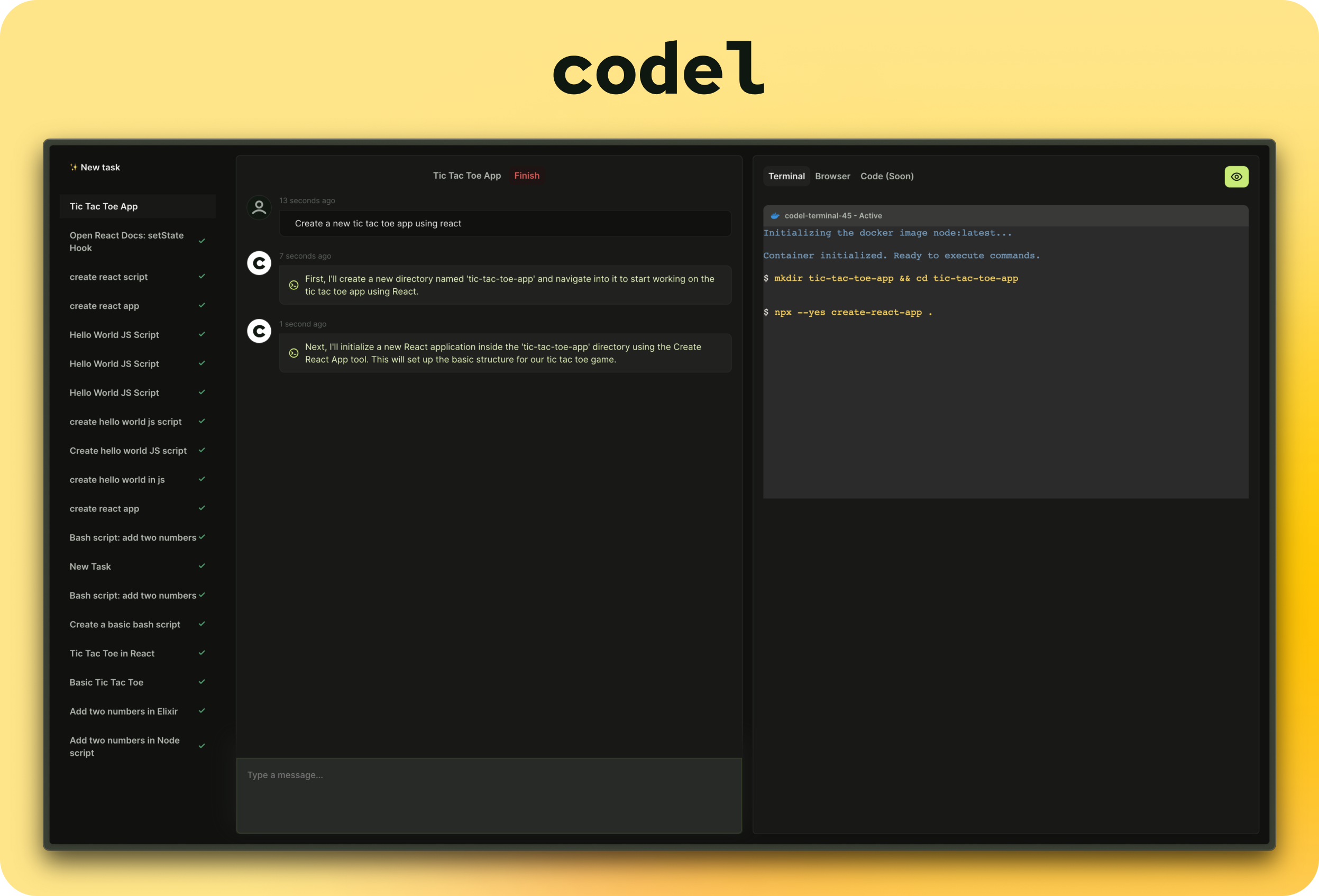

Der einfachste Weg, Codel auszuführen, besteht darin, ein vorgefertigtes Docker-Bild zu verwenden. Sie finden das neueste Bild in der GitHub -Containerregistrierung.

Wichtig

Sie müssen eine entsprechende Umgebungsvariable verwenden, um eines der unterstützten Sprachmodelle zu verwenden.

Sie können das Docker -Bild mit dem folgenden Befehl ausführen. Entfernen oder ändern Sie die Umgebungsvariablen entsprechend Ihren Anforderungen.

docker run

-e OPEN_AI_KEY=your_open_ai_key

-e OPEN_AI_MODEL=gpt-4-0125-preview

-e OLLAMA_MODEL=llama2

-p 3000:8080

-v /var/run/docker.sock:/var/run/docker.sock

ghcr.io/semanser/codel:latest Alternativ können Sie eine .env Datei erstellen und das Docker-Bild mit der Flagge --env-file ausführen. Weitere Informationen finden Sie hier

Jetzt können Sie Localhost: 3000 in Ihrem Browser besuchen und mit der Verwendung von Codel beginnen.

* `OPEN_AI_KEY` - OpenAI API key. You can get the key [here](https://platform.openai.com/account/api-keys).

* `OPEN_AI_MODEL` - OpenAI model (default: gpt-4-0125-preview). The list of supported OpenAI models can be found [here](https://pkg.go.dev/github.com/sashabaranov/go-openai#pkg-constants).

* `OPEN_AI_SERVER_URL` - OpenAI server URL (default: https://api.openai.com/v1). Change this URL if you are using an OpenAI compatible server.

* `OLLAMA_MODEL` - locally hosted Ollama model (default: https://ollama.com/model). The list of supported Ollama models can be found [here](https://ollama.com/models).

* `OLLAMA_SERVER_URL` - Ollama server URL (default: https://host.docker.internal:11434). Change this URL if you are using an Ollama compatible server.

See backend [.env.example](./backend/.env.example) for more details.

Weitere Informationen finden Sie in der Entwicklung.MD.

Hier finden Sie die Roadmap des Projekts.

Dieses Projekt wäre nicht möglich, ohne: