Bahri Batuhan Bilecen, Yigit Yalin, Ning Yu y Aysegul Dundar

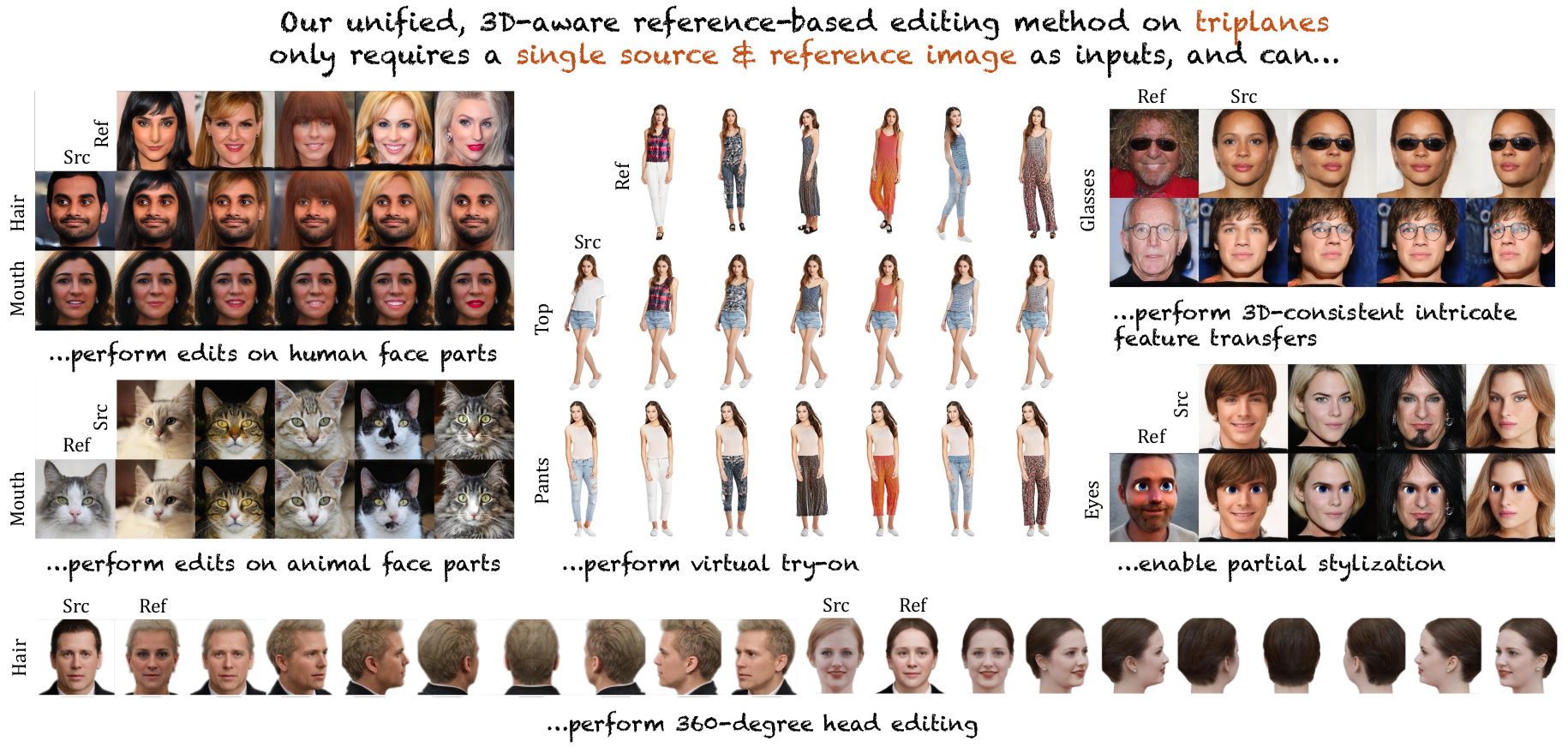

Las redes adversas generativas (GAN) han surgido como herramientas poderosas para la generación de imágenes de alta calidad y la edición de imágenes reales mediante la manipulación de sus espacios latentes. Los avances recientes en GANS incluyen modelos 3D con conocimiento como EG3D, que cuentan con arquitecturas eficientes basadas en triplanos capaces de reconstruir la geometría 3D a partir de imágenes individuales. Sin embargo, se ha prestado atención limitada a proporcionar un marco integrado para la edición de imágenes basada en referencias de alta calidad y de alta calidad. Este estudio aborda esta brecha explorando y demostrando la efectividad del espacio de triplano para ediciones avanzadas basadas en referencias. Nuestro enfoque novedoso integra la codificación, la localización automática, el desenredado espacial de las características de triplano y el aprendizaje de fusión para lograr las ediciones deseadas. Además, nuestro marco demuestra versatilidad y robustez en varios dominios, extendiendo su efectividad a las ediciones faciales de animales, ediciones parcialmente estilizadas como caras de dibujos animados, ediciones de ropa de cuerpo completo y ediciones de 360 grados. Nuestro método muestra un rendimiento de vanguardia sobre la dirección latente relevante, el texto y los métodos GaN y GaN con consumo 3D guiados por imágenes, tanto cualitativa como cuantitativamente.

git clone --recursive https://github.com/three-bee/triplane_edit.gitcd ./triplane_edit && pip install -r requirements.txt Seguimos la preparación del conjunto de datos de EG3D para la extracción de pose y la alineación facial. Asegúrese de no omitir la configuración de Deep3DFacerCon_Pytorch. Luego, ejecute el código de preprocesamiento en el flujo:

cd ./dataset_preprocessing/ffhq

python preprocess_in_the_wild.py --indir=YOUR_INPUT_IMAGE_FOLDER

Esto generará imágenes alineadas y un dataset.json que contiene matrices de cámara en YOUR_INPUT_IMAGE_FOLDER/preprocessed/ .

Hemos incluido imágenes de ejemplo y poses en ./example/ .

Pon todos los archivos descargados en ./checkpoints/ .

| Red | Nombre del archivo |

|---|---|

| EG3D Generador reequilibrado | ffhqrebalanced512-128.pkl |

| EG3D-goae codificadores | encoder_FFHQ.pt & afa_FFHQ.pt |

| Codificador de fusión finetened | encoder_FFHQ_finetuned.pt |

| Segmentación de Bisenet | 79999_iter.pth |

| IR-SE50 para la pérdida de identificación | model_ir_se50.pth |

Ejecute demo.ipynb para varios ejemplos de edición.

Nuestra base de código utiliza las siguientes excelentes obras: EG3D, EG3D-GOAE, Triplanenetv2, Bisenet y Deep3DFacerCon_Pytorch. Agradecemos a los autores por proporcionarlos.

@misc{bilecen2024referencebased,

title={Reference-Based 3D-Aware Image Editing with Triplanes},

author={Bahri Batuhan Bilecen and Yigit Yalin and Ning Yu and Aysegul Dundar},

year={2024},

eprint={2404.03632},

archivePrefix={arXiv},

primaryClass={cs.CV}

}

Copyright 2024 Bilkent Dlr. Con licencia bajo la licencia Apache, versión 2.0 (la "licencia").