Hedra Labs hat kürzlich eine Forschungsvorschauversion von Character-1 veröffentlicht, einem erstaunlichen KI-Tool zur Videogenerierung. Es kann realistische, dynamische Videos basierend auf von Benutzern bereitgestellten Fotos und Sprachinhalten erstellen, wodurch die Charaktere auf den Fotos beim Sprechen oder Singen zum Leben erweckt werden und ihre Lippenformen, Gesichtsausdrücke und Gesten perfekt mit der Stimme synchronisiert werden. Diese Technologie durchbricht herkömmliche Videoproduktionsmethoden und bietet unendliche Möglichkeiten bei der Erstellung von Inhalten. Ihre komfortable Bedienung und die hochwertige Ausgabe bieten Benutzern ein beispielloses Erlebnis.

Kürzlich hat Hedra Labs eine Forschungsvorschauversion von Character-1 auf den Markt gebracht, einer Technologie, die es Benutzern ermöglicht, dynamische Videos von sprechenden und singenden Personen auf der Grundlage von Fotos und Sprachinhalten einer beliebigen Person zu erstellen.

Stellen Sie sich vor, Sie laden ein Foto einer Person hoch und fügen Sprachinhalte hinzu, und schon kann im Handumdrehen ein dynamisches Video erstellt werden, das den Eindruck erweckt, dass die Person auf dem Foto zum Leben erwacht, anfängt zu sprechen oder zu singen und die Lippenform, der Ausdruck, und Körperhaltung stimmen alle mit dem Stimminhalt überein. Sind Sie ein wenig aufgeregt?

Offizielles Demo-Video von Hedra Labs

Hauptmerkmale und funktionale Highlights:

Kompatibilität mit mehreren Plattformen: Benutzer können Character-1 problemlos sowohl auf Desktop- als auch auf Mobilgeräten verwenden.

Unbegrenzte Dauergenerierung: Die aktuelle offene Vorschauversion unterstützt die 30-Sekunden-Videogenerierung. Wenn H100 ausreichend verfügbar ist, können alle 60 Sekunden 90 Sekunden Inhalt generiert werden.

Unterstützt mehrere Ausdrucksformen: Character-1 unterstützt nicht nur Dialoge, sondern kann auch Ausdrucksformen wie Singen und Rappen verarbeiten.

Hedra bietet eine benutzerfreundliche Oberfläche, sodass auch Nicht-Experten schnell loslegen können. Benutzer können die offizielle Website von Hedra besuchen, die Text-to-Speech-Funktion nutzen oder direkt Audiodateien hochladen, eine Charakterbeschreibung eingeben und dann ein dynamisches Video erstellen.

Die KI-Technologie von Hedra gewährleistet die hohe Qualität und Wiedergabetreue des Videoinhalts, unabhängig davon, ob es sich um den Gesichtsausdruck, die Körperhaltung oder die Stimmsynchronisation der Figur handelt, sie kann zufriedenstellende Ergebnisse erzielen.

Den offiziellen Fällen nach zu urteilen, kann Charakter 1 perfekt singen, schauspielern und Rollen mit unterschiedlichen Emotionen ausdrücken. Die Technologie ist nicht auf menschliche Charaktere beschränkt, sondern kann sogar ausdrucksstarke, unbelebte Objekte erzeugen, sofern diese über ausgeprägte Gesichtszüge verfügen.

Auch die Verwendungsweise ist sehr einfach, die konkreten Schritte sind wie folgt:

Öffnen Sie die Adresse für das Hedra-Erlebnis: https://top.aibase.com/tool/hedra

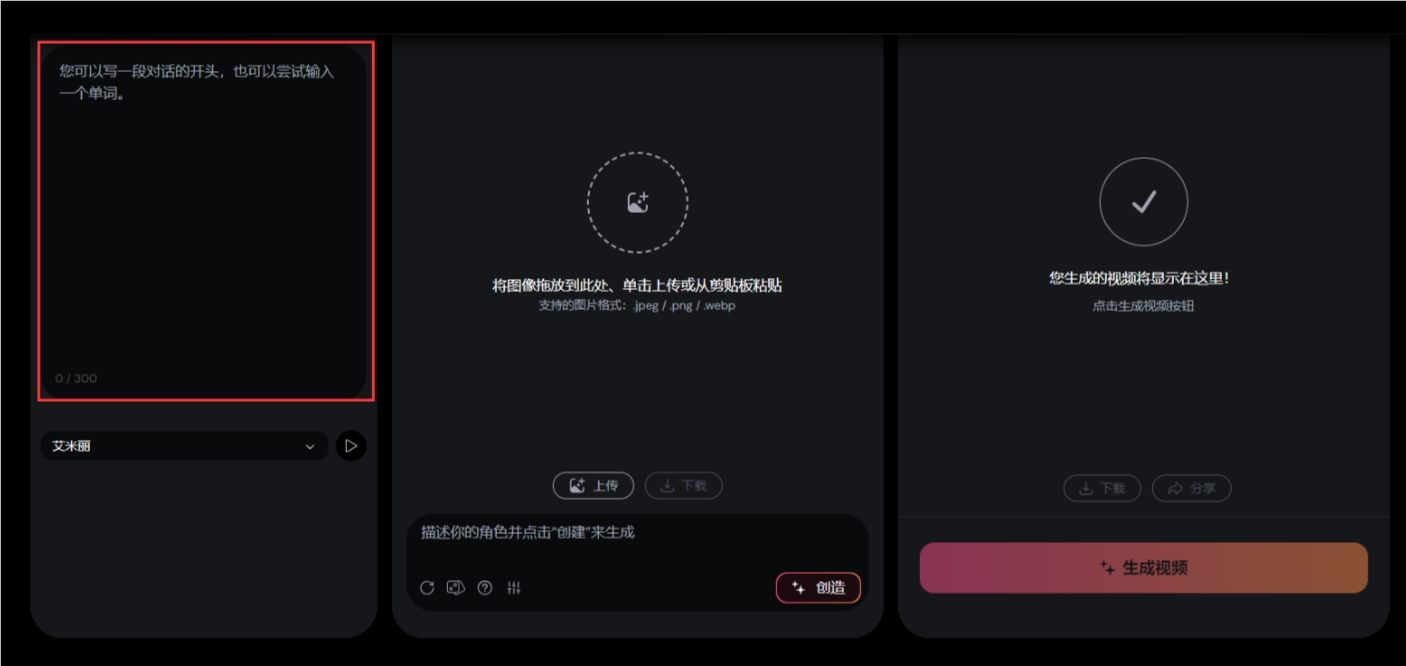

Nach dem Aufrufen der Seite können Sie diese Bedienoberfläche sehen

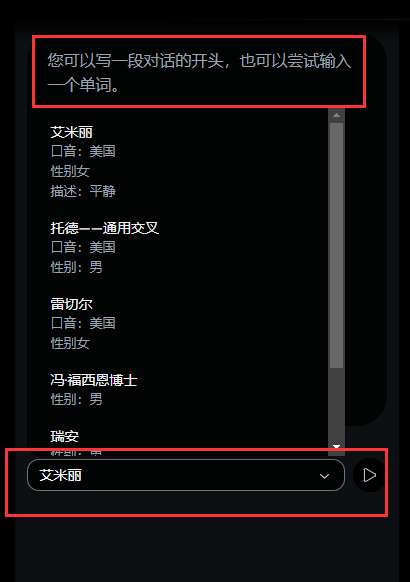

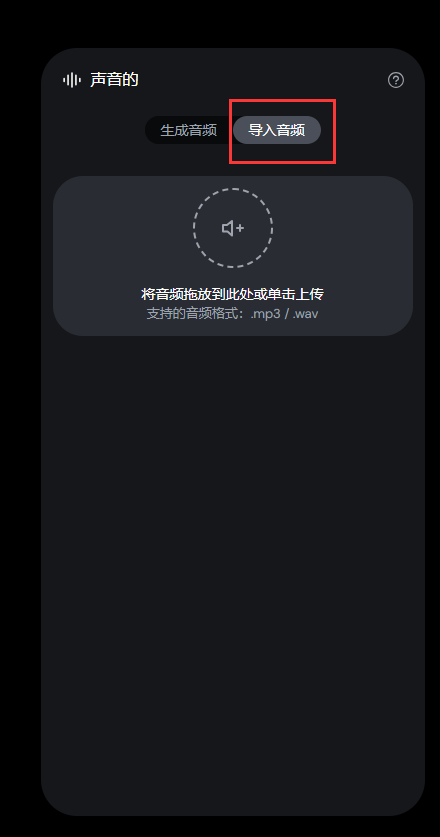

Die Benutzeroberfläche ist sehr einfach. Geben Sie im ersten Feld die Zeilen Ihres Charakters ein und wählen Sie eine Stimme aus. Wenn Sie das generierte Audio nicht verwenden möchten, können Sie natürlich auch Ihr eigenes Audio importieren.

Hier tippe ich einfach „Hallo, das ist ein sprechendes Video, das von AIbase erstellt wurde. Heute werde ich Sie mitnehmen, um Hedra zu erleben und die Videoerstellung so einfach wie das Atmen zu machen.“

Laden Sie dann im zweiten Feld das Bild hoch, über das ich sprechen möchte, und laden Sie hier ein Foto einer schönen Frau hoch, das ich zuvor gemacht habe.

Wenn Sie kein fertiges Bild haben, können Sie Ihren Charakter direkt in das Textfeld unten eingeben und auf Erstellen klicken, um ihn zu generieren.

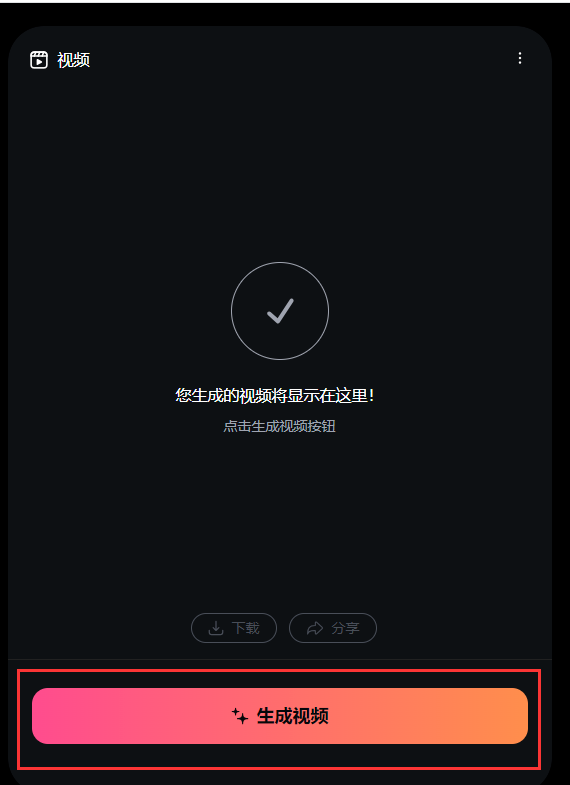

Nachdem das Bild hochgeladen wurde, klicken Sie unter dem dritten Feld auf „Video generieren“.

Hier ist der resultierende Videoeffekt:

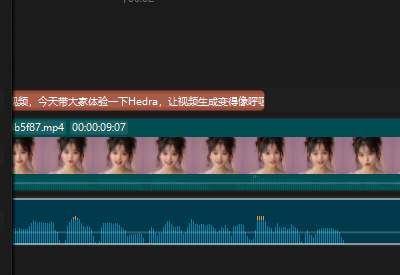

Es ist zu erkennen, dass in dem von Hedra erstellten Sprechvideo die Charaktere relativ beweglich sind. Nicht nur der Mund bewegt sich, sondern auch andere Körperteile, und es gibt auch Ausdrücke. Da es auf der Plattform jedoch nur sehr wenige Stimmen zur Auswahl gibt, passt der Akzent des Ausländers nicht sehr gut zum Charakter in meinem Bild. Ein weiterer Nachteil ist, dass das generierte Video viel unschärfer ist als mein Originalbild das Bild in der Zukunft.

Hier habe ich selbst einen Ton hochgeladen, den Ton direkt per Clipping generiert, die Stimme eines Mädchens ausgewählt, den Text direkt eingegeben und ihn dann vorgelesen.

Versuchen Sie es noch einmal:

Wählen Sie Audio importieren

Der erzeugte Effekt ist wie folgt:

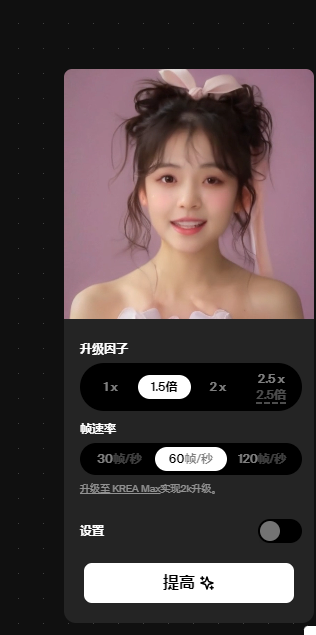

Dann kann das Unschärfeproblem mit der Videoverbesserungsfunktion von krea ai gelöst werden. Beachten Sie jedoch, dass die Videolänge bei der kostenlosen Testversion 10 Sekunden nicht überschreiten darf. Und wählen Sie die Bildrate nicht zu hoch. Ich habe 60 Bilder pro Sekunde gewählt und bin vor lauter Weinen auf der Toilette ohnmächtig geworden

Alles in allem zeigt Character-1 das große Potenzial der KI-Technologie im Bereich der Videogenerierung. Auch wenn es noch einige Defizite gibt, sind die zukünftigen Entwicklungsaussichten lohnenswert. Ich glaube, dass uns Character-1 mit der weiteren Verbesserung der Technologie weitere Überraschungen bescheren wird.