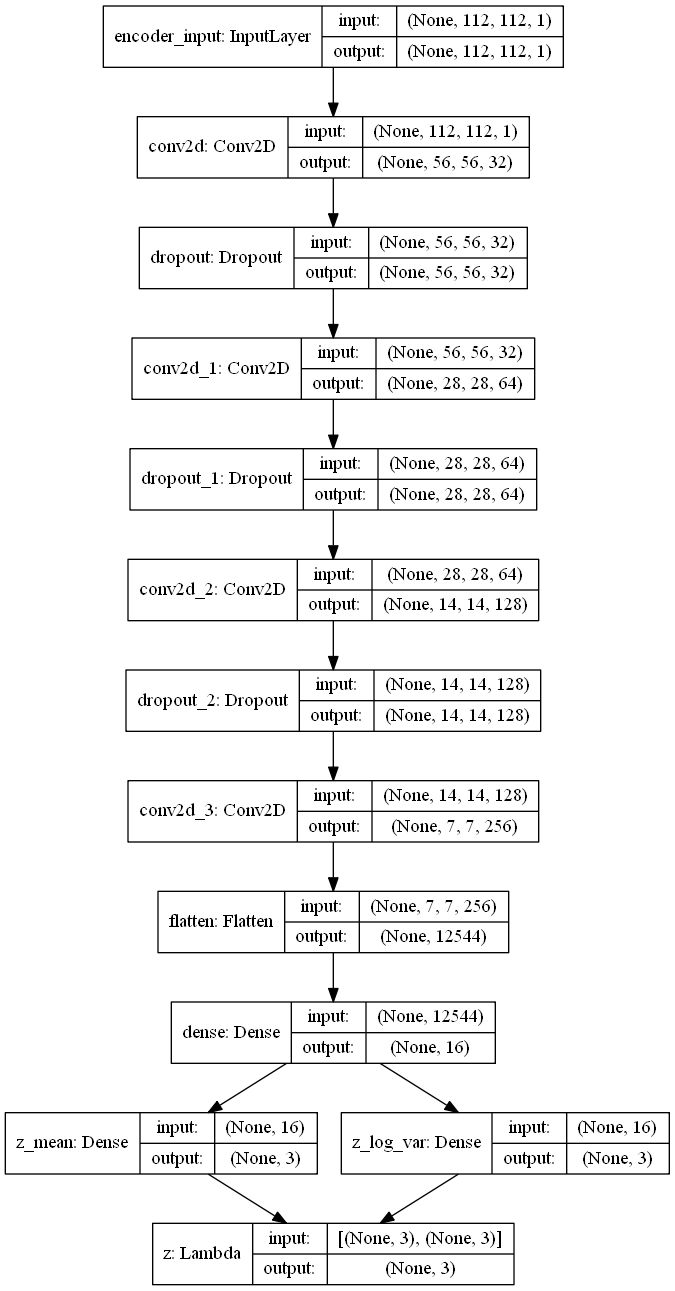

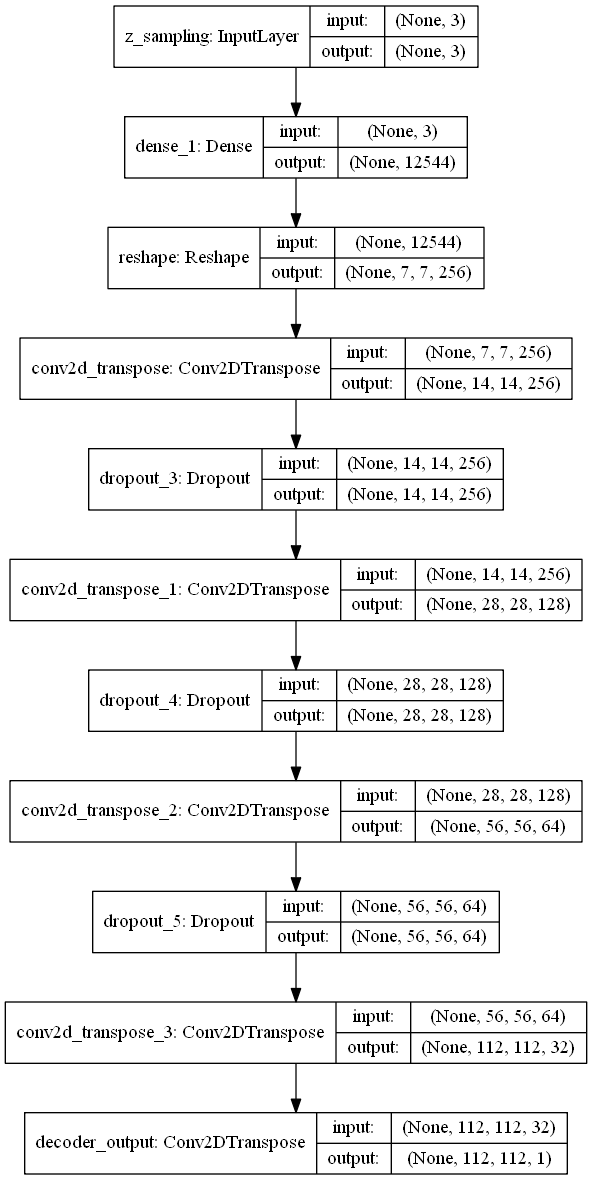

Die VAE haben ein modulares Design. Der Encoder, Decoder und VAE sind 3 Modelle, die Gewichte teilen. Nach dem Training des VAE -Modells kann der Encoder verwendet werden, um latente Vektoren zu generieren. Der Decoder kann verwendet werden, um Schriftbilder zu erzeugen, indem der latente Vektor aus einer Gaußschen Verteilung mit Mittelwert = 0 und STD = 1 abgetastet wird.

| Encoder | Decoder |

|---|---|

|  |

Datensatzgröße = Zug 5000 und Validierung 1000 pro Klasse

Breite, Höhe = 112, 112

Schriftgröße = 25

verwendete Zeichen

Bilder werden mit font2png.py erzeugt

Schriftarten stammen von Google -Schriftarten

| IDX | Schriftart Name | Beispielbilder |

|---|---|---|

| 0 | Ebgaramond |      |

| 1 | Pt_serif |      |

| 2 | Notosans |      |

| 3 | Roboto |      |

| 4 | Gerecht |      |

| 5 | Banger |      |

| 6 | Pacifico |      |

| 7 | TancingScript |      |

| 8 | Introlata |      |

| 9 | VT323 |      |

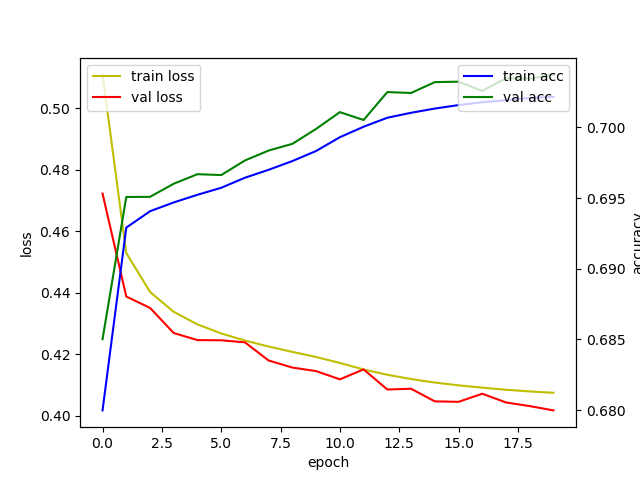

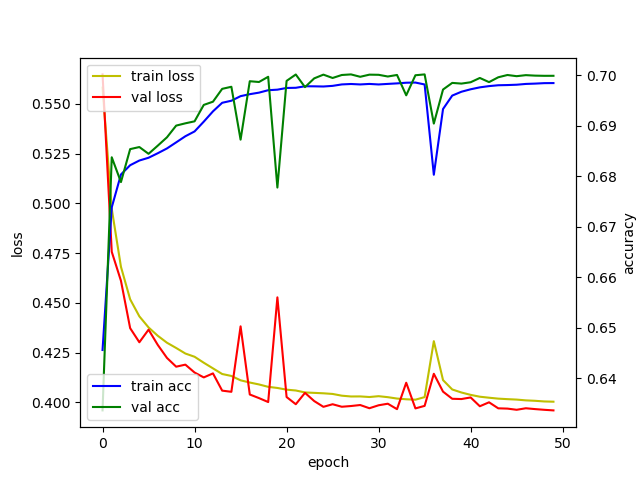

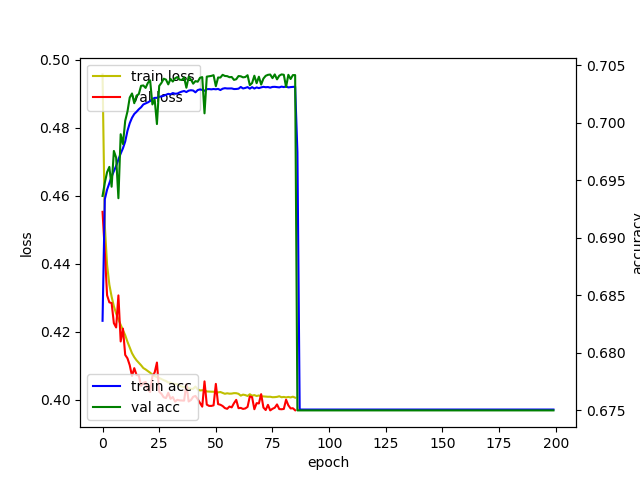

| Epoche | 20 | 50 | 200 |

|---|---|---|---|

| Protokoll |  |  |  |

| latenter Raum |  |  |  |

1 Frame = 1 Charge

1 Epoche = 196 Chargen

| Epoche = 1 | Epoche = 2 | Epoche = 3 |

|---|---|---|

|  |  |

| Epoch = 4 | Epoche = 5 | Epoche = 6 |

|  |  |

[1] Kingma, Diederik P. und Max Welling. "Automatisch kodierende Variation Bayes."

[2] Keras -Blog: Autocodeer in Keras erstellen

[3] Keras Beispiel: Vae

[4] Erik Bernhardsson. "Analyse von 50.000 Schriftarten mit tiefen neuronalen Netzwerken"

[5] TJ Torres. "Eine fontastische Reise: generative Schriftarten mit kontroversen Netzwerken"

[6] Julien Despois. "Latente Raumvisualisierung - Deep Learning Bits #2"