Dies ist die offizielle Pytorch-Implementierung der künstlerischen Glyphenbildsynthese über einstufige Wenig-Shot-Lernen .

Papier | Ergänzungsmaterial

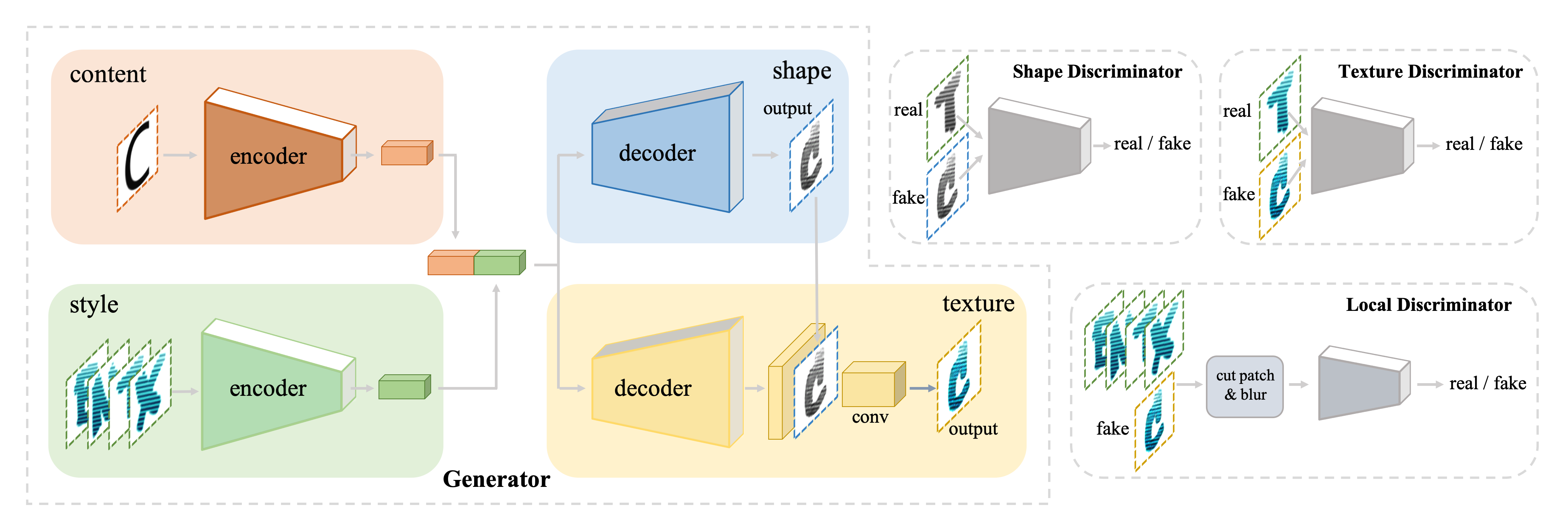

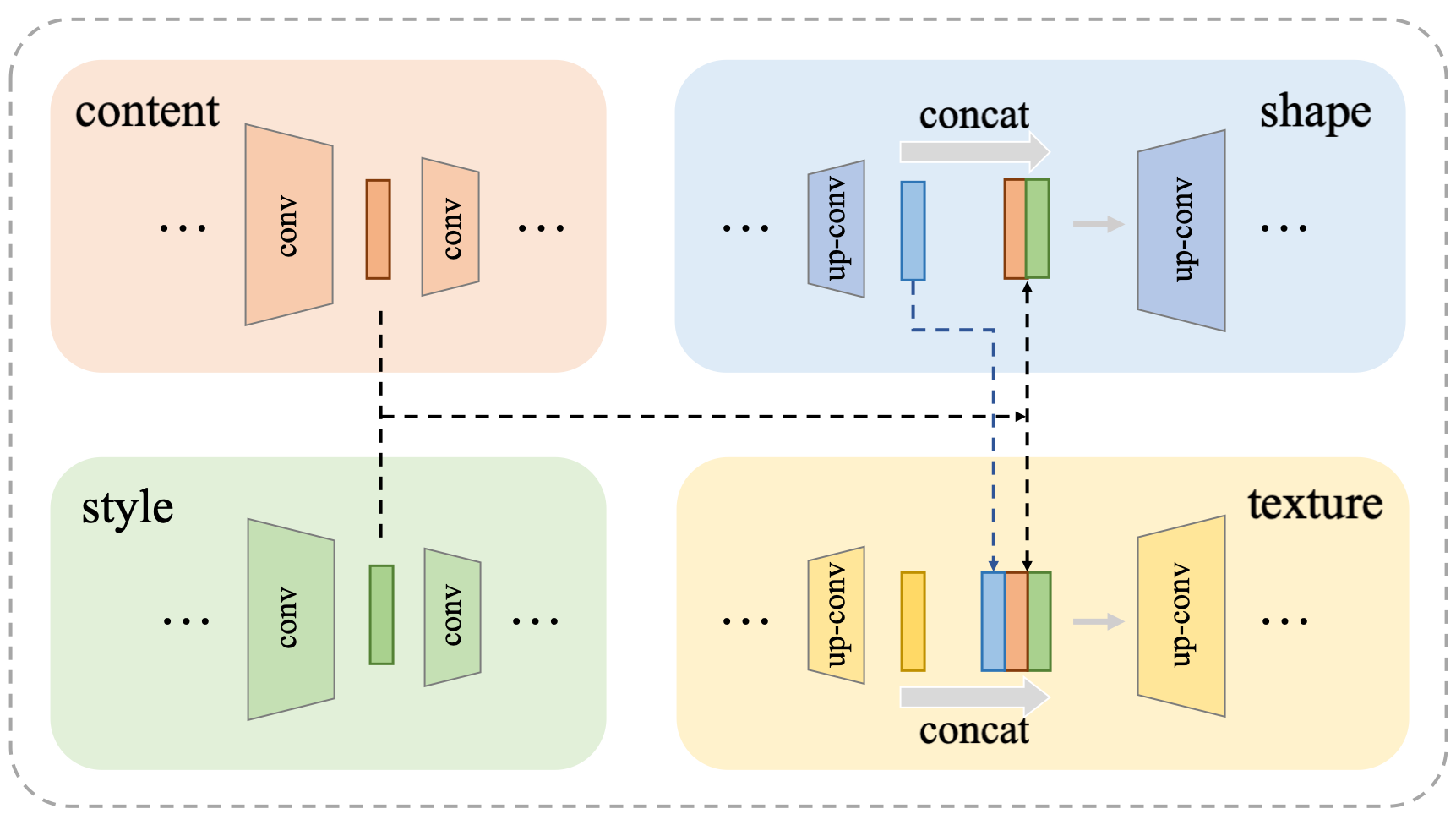

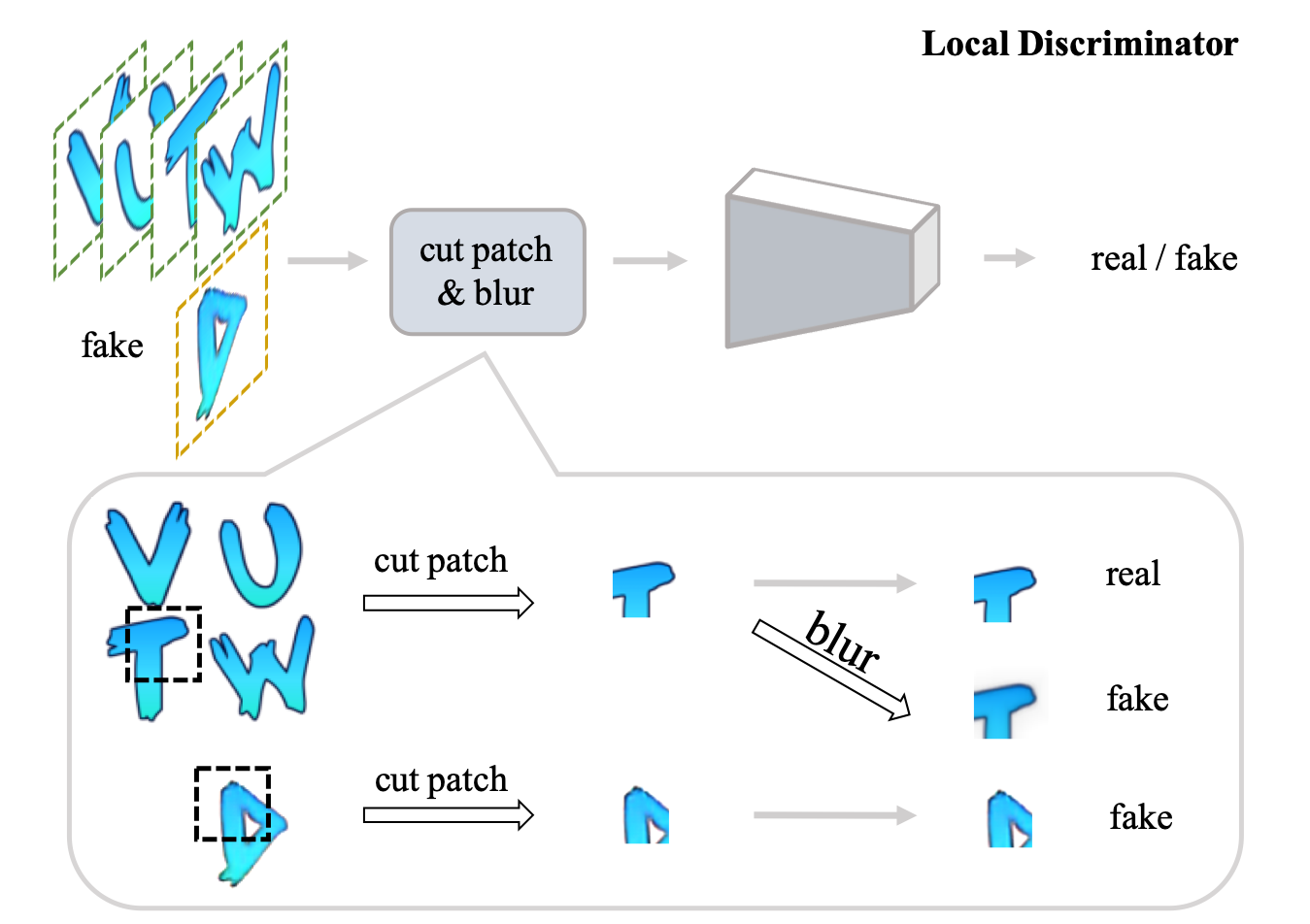

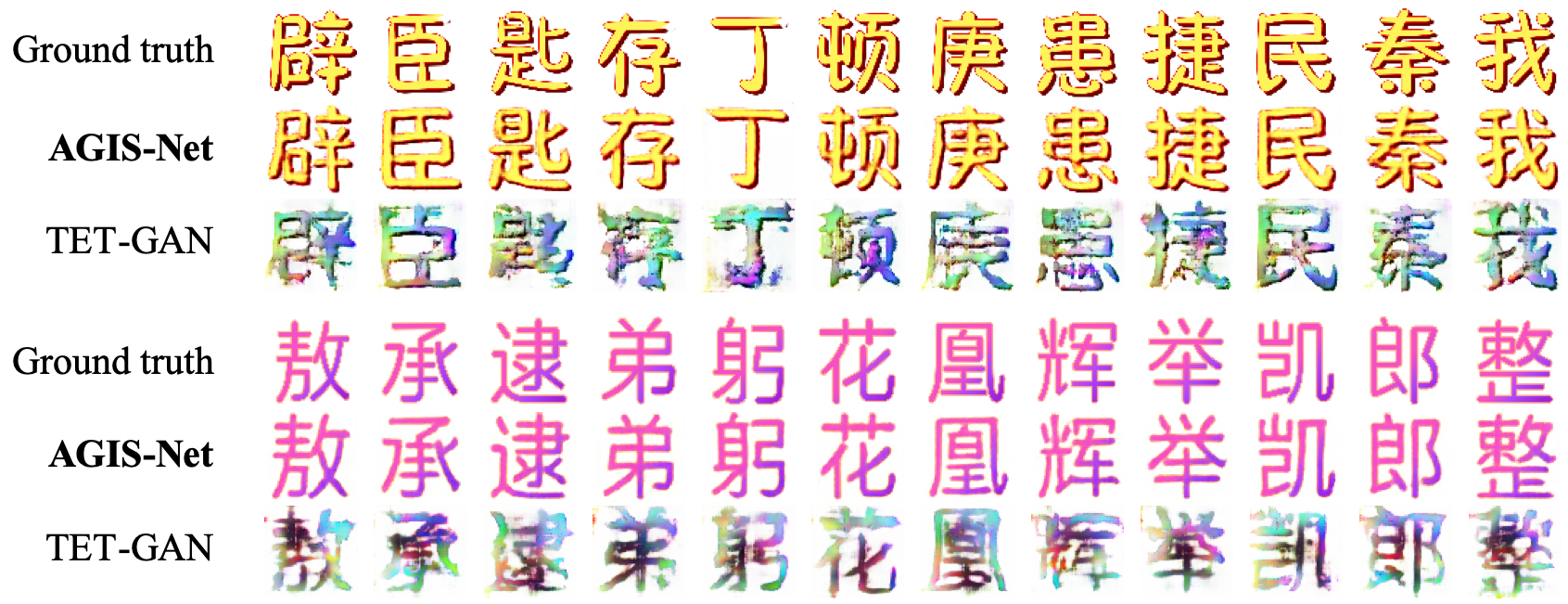

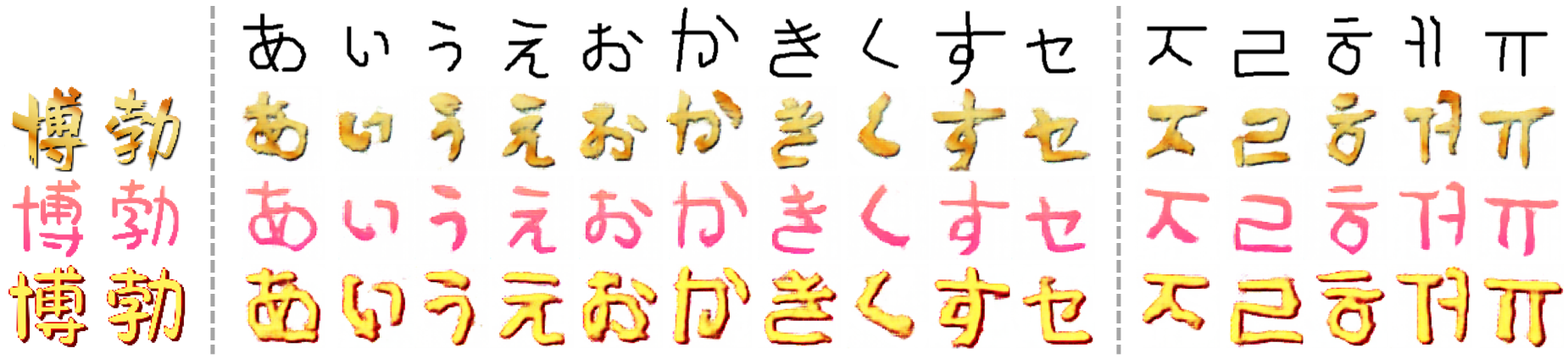

Die automatische Generation künstlerischer Glyphenbilder ist eine herausfordernde Aufgabe, die viele Forschungsinteressen anzieht. Frühere Methoden sind entweder speziell für die Formsynthese ausgelegt oder konzentrieren sich auf den Texturübertragung. In diesem Artikel schlagen wir ein neuartiges Modell, AGIS-NET, vor, sowohl Form- als auch Texturstile in einer Stufe mit nur wenigen stilisierten Beispielen zu übertragen. Um dieses Ziel zu erreichen, entwirren wir zunächst die Darstellungen für Inhalte und Stil, indem wir zwei Encoder verwenden, um die Erzeugung von Multi-in-in-in-in-Stilen und Multi-Stilen sicherzustellen. Anschließend verwenden wir zwei gemeinsame Decoder, um das Glyph -Formbild und sein Texturbild gleichzeitig zu generieren. Darüber hinaus führen wir einen lokalen Verlust zur Verfeinerung der Textur ein, um die Qualität der synthetisierten Texturen weiter zu verbessern. Auf diese Weise ist unser einstufiges Modell viel effizienter und effektiver als andere mehrstufige gestapelte Methoden. Wir schlagen auch einen groß angelegten Datensatz mit chinesischen Glyphenbildern in verschiedenen Form- und Texturstilen vor, die aus 35 professionell gestalteten künstlerischen Schriftarten mit 7.326 Zeichen und 2.460 synthetischen künstlerischen Schriftarten mit 639 Charakteren rendern, um die Wirksamkeit und Erweiterbarkeit unserer Methode zu bestätigen. Umfangreiche Experimente sowohl zu englischen als auch zu chinesischen künstlerischen Glyphenbilddatensätzen zeigen die Überlegenheit unseres Modells bei der Erzeugung hochwertiger stilisierter Glyphenbilder gegen andere hochmoderne Methoden.

| Verbindung überspringen | Lokaler Diskriminator |

|---|---|

|  |

pip install visdom

pip install dominategit clone -b master --single-branch https://github.com/hologerry/AGIS-Net

cd AGIS-NetDer Datasets -Server ist ausgefallen. Sie können die Datensätze von PKU -Festplatten, Dropbox oder Mega herunterladen. Laden Sie die Datensätze mit dem folgenden Skript, vier Datensätzen und dem RAW -Glyphenbild im RAW -Schriftstil zur Verfügung.

Es kann eine Weile dauern, bitte geduldig sein

bash ./datasets/download_dataset.sh DATASET_NAME

base_gray_color ENGLINLISCH Synthetisierte Gradientenglyphenbilddatensatz, vorgeschlagen von MC-Gan.base_gray_texture ENGLISH COLTISTIC GLYPH Image Dataset, vorgeschlagen von MC-Gan.skeleton_gray_color chinesische synthetisierte gradienten glyphenbilddatensatz von uns.skeleton_gray_texture chinesische künstlerische Glyphe Bilddatensatz von uns vorgeschlagen.average_skeleton RAW CHINA AVGERAGE FONT SELTE (Skelett) Glyphe -Bilddatensatz, vorgeschlagen von uns.Weitere Informationen zu unseren Datensätzen und zur Erstellung Ihrer eigenen Datensätze finden Sie in den Daten.

Um ein Modell zu trainieren, laden Sie die Trainingsbilder herunter (z. B. englische künstlerische Glyph -Transfer)

bash ./datasets/download_dataset.sh base_gray_color

bash ./datasets/download_dataset.sh base_gray_textureTrainieren ein Modell:

Starten Sie den Visdom Visualizer

python -m visdom.server -port PORTPort ist in

train.shangegeben

Vorabend am synthetisierten Gradienten -Glyphenbilddatensatz

bash ./scripts/train.sh base_gray_color GPU_IDGPU_ID gibt an, welche GPU verwendet werden soll.

Fülle auf künstlerischem Glyphenbilddatensatz

bash ./scripts/train.sh base_gray_texture GPU_ID DATA_ID FEW_SIZEData_ID gibt an, welche künstlerische Schriftart fein abgestimmt ist.

Wege_size zeigt die Größe von wenigen Schuss-Set an.

Es wird einen Fehler hervorrufen, der sagt:

FileNodeFoundError: [Error 2] No such file or directory: 'chechpoints/base_gray_texture/base_gray_texture_DATA_ID_TIME/latest_net_G.pth

Kopieren Sie das vorgezogene Modell auf den obigen Pfad

cp chechpoints/base_gray_color/base_gray_color_TIME/latest_net_ * chechpoints/base_gray_texture/base_gray_texture_DATA_ID_TIME/Und fang wieder mit dem Zug. Es wird gut funktionieren.

Um ein Modell zu testen, kopieren Sie das geschulte Modell vom checkpoint zum Ordner pretrained_models (z. B. englischer künstlerischer Glyphenübertragung).

cp chechpoints/base_gray_color/base_gray_texture_DATA_ID_TIME/latest_net_ * pretrained_models/base_gray_texture_DATA_ID/Testen Sie ein Modell

bash ./scripts/test_base_gray_texture.sh GPU_ID DATA_IDDieser Code ist vom Bicyclegan inspiriert.

Besonderer Dank geht an die folgenden Funktionen für die Freigabe ihres Code und des Datensatzes.

Wenn Sie feststellen, dass unsere Arbeit hilfreich ist, zitieren Sie bitte unser Papier:

@article{Gao2019Artistic,

author = {Gao, Yue and Guo, Yuan and Lian, Zhouhui and Tang, Yingmin and Xiao, Jianguo},

title = {Artistic Glyph Image Synthesis via One-Stage Few-Shot Learning},

journal = {ACM Trans. Graph.},

issue_date = {November 2019},

volume = {38},

number = {6},

year = {2019},

articleno = {185},

numpages = {12},

url = {http://doi.acm.org/10.1145/3355089.3356574},

publisher = {ACM}

}

Der Code und der Datensatz sind nur für den persönlichen und akademischen Gebrauch zulässig.