Dieses Repository enthält den Quellcode und den Link zu unserem Artikel.

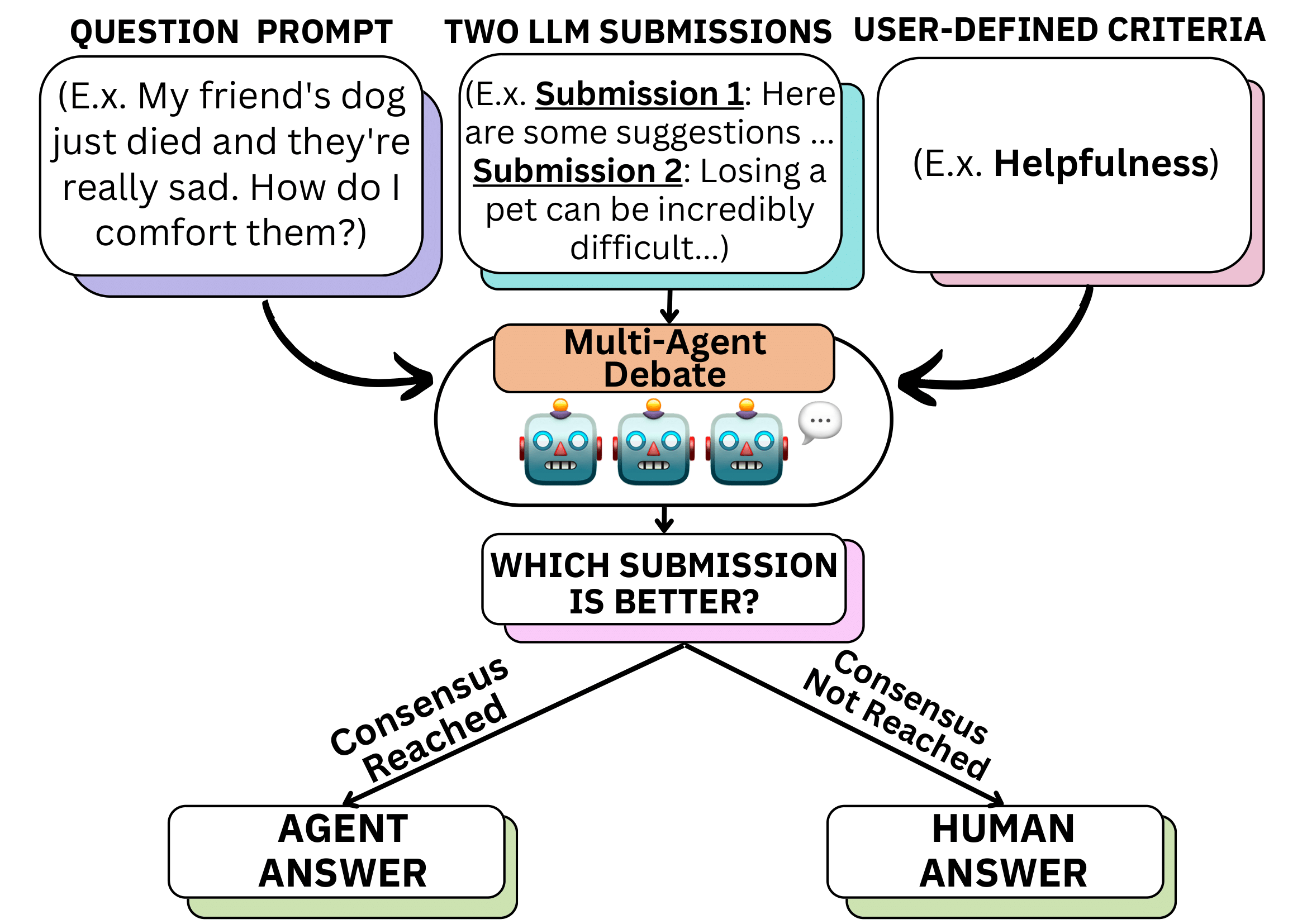

Scaleeval ist ein von Agent debat unterstützter Meta-Evaluierungsrahmen, der die Fähigkeiten mehrerer kommunikativer LLM-Agenten nutzt. Dieser Rahmen unterstützt mehrfache Diskussionen, um den Menschen bei der Erkenntnis der fähigsten LLM-basierten Bewerter zu unterstützen. Benutzer können ihre LLM-Einreichungen, Kriterien und Szenarien mit unserem Rahmen zur Durchführung einer Meta-Evaluierung liefern.

pip install scaleeval

export OPENAI_API_KEY=XXXX.YYYY.ZZZ

export ANTHROPIC_API_KEY=XXXX.YYYY.ZZZPython 3.9+ ist erforderlich.

git clone [email protected]:GAIR-NLP/scaleeval.git

cd scaleeval

pip install -e .

# install pre-commit hooks

pip install pre-commit

pre-commit install # this is necessary before you commit

git init

git add .

pre-commit run cd scaleeval

python evaluation.pycriteria/metaeval_creativity : Bewertung von 1 bis 5 für jede LLM -Einreichung basierend auf den Kreativitätskriterien und entscheiden, welche Einreichung besser ist.criteria/metaeval_helpfulness : Scoring von 1 bis 5 für jede LLM -Einreichung basierend auf den Hilfskriterien und entscheiden, welche Einreichung besser ist.criteria/metaeval_interpretability : Bewertung von 1 bis 5 für jede LLM -Einreichung basierend auf der Interpretierbarkeit und entscheiden, welche Einreichung besser ist.criteria/metaeval_reasoning : Wertung von 1 bis 5 für jede LLM -Einreichung basierend auf den Argumentationskriterien und entscheiden, welche Einreichung besser ist.scaleeval/responses/gpt3.5/brainstorming.jsonl : Antworten, die aus GPT3.5-Turbo erzeugt werden, basierend auf den Eingabeaufforderungen im Brainstorming-Szenario.scaleeval/responses/claude-instant/brainstorming.jsonl : Antworten, die aus Claude-Instant erzeugt werden, basierend auf den Eingabeaufforderungen im Brainstorming-Szenario. cd criteriaFügen Sie eine neue .yaml -Datei Ihre eigenen Kriterienbeschreibungen hinzu! Folgen Sie dem folgenden Format:

criteria :

[ your defined criteria ]:

"1" : ...

"2" : ...

"3" : ...

"4" : ...

"5" : ...Sammeln Sie Ihre LLM -Einreichungen und speichern Sie sie in einer .jsonl -Datei mit dem folgenden Format:

{ "prompt" : ..., "category" : ..., "response" : ...}Hier ist ein Beispiel:

{ "prompt" : "Can you tell me how to make chocolate chip cookies?" , "category" : "brainstorming" , "response" : "Certainly! Here's a simple recipe for making chocolate chip cookies: n n Ingredients: n - 1 cup (2 sticks) unsalted butter, softened n - 1 cup granulated sugar n - 1 cup packed brown sugar n - 2 large eggs n - 1 teaspoon vanilla extract n - 3 cups all-purpose flour n - 1 teaspoon baking soda n - 1/2 teaspoon salt n - 2 cups chocolate chips n n Instructions: n 1. Preheat your oven to 350 u00b0 F (175 u00b0 C) and line a baking sheet with parchment paper. n 2. In a large mixing bowl, cream together the softened butter, granulated sugar, and brown sugar until well combined and creamy. n 3. Add the eggs one at a time, beating well after each addition. Then, stir in the vanilla extract. n 4. In a separate bowl, whisk together the flour, baking soda, and salt. Gradually add this dry mixture to the wet ingredients, mixing until just combined. n 5. Fold in the chocolate chips until evenly distributed throughout the dough. n 6. Using a cookie scoop or tablespoon, drop rounded portions of dough onto the prepared baking sheet, spacing them about 2 inches apart. n 7. Bake in the preheated oven for 10-12 minutes, or until the edges are golden brown. The centers may still appear slightly soft, but they will firm up as they cool. n 8. Remove the baking sheet from the oven and let the cookies cool on the sheet for a few minutes before transferring them to a wire rack to cool completely. n 9. Repeat the process with the remaining dough until all the cookies are baked. n n Enjoy your homemade chocolate chip cookies!" }Bitte erwägen Sie, unser Papier zu zitieren, wenn Sie unser Repo und die Ergebnisse nützlich finden!

@article{chern2024scaleeval,

title={Can Large Language Models be Trusted for Evaluation? Scalable Meta-Evaluation of LLMs as Evaluators via Agent Debate},

author={Chern, Steffi and Chern, Ethan and Neubig, Graham and Liu, Pengfei},

journal={arXiv preprint arXiv:2401.16788},

year={2024}

}