Installieren Sie die neueste Installation

![]()

![]()

![]()

![]()

![]()

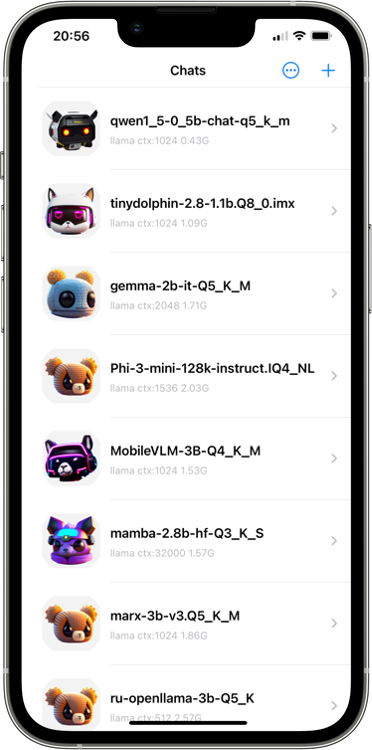

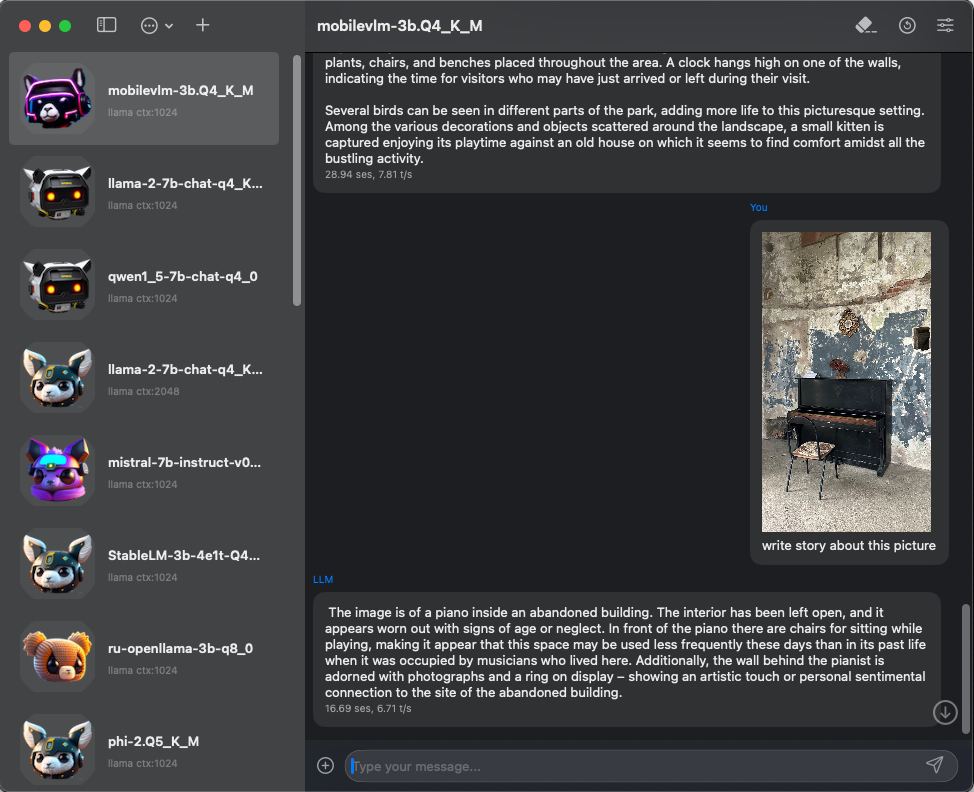

LLMFarm ist eine iOS- und macOS -App, die mit großen Sprachmodellen (LLM) arbeitet. Sie können verschiedene LLMs mit bestimmten Parametern laden. Mit LLMFarm können Sie die Leistung verschiedener LLMs auf iOS und macOS testen und das am besten geeignete Modell für Ihr Projekt finden.

Basierend auf GGML und LLAMA.CPP von Georgi Gerganov.

Lama

Lama  Gemma

Gemma  Phi

Phi  GPT2 + Cerebras

GPT2 + Cerebras  StarCoder (Santacoder)

StarCoder (Santacoder)  Falke

Falke  Mpt

Mpt  Blühen

Blühen  Stablelm-3b-4e1t

Stablelm-3b-4e1t  Qwen

Qwen  Yi -Modelle

Yi -Modelle  Deepseek -Modelle

Deepseek -Modelle  Mixtral Moe

Mixtral Moe  Plamo-13b

Plamo-13b  Mamba

Mamba  Rwkv

Rwkv  Gptneox

GptneoxHier finden Sie die vollständige Liste.

Hinweis: Für Falcon, Alpaka, GPT4ALL, Chinese Lama / Alpaka und chinesische LLAMA-2 / Alpaka-2, Vigogne (Französisch), Vicuna, Koala, Openbuddy (mehrsprachige), Pygmalion / Metharme, WizardLM, Baichuan 1 & 2-Derivaten, Derivaten, Derivaten, Ableitungen, Derivaten, Ableitungen, Derivaten, Ableitungen, Derivaten, Ableitungen, Derivaten, Abhilfe Aquila 1 & 2, Mistral AI V0.1, Refact, Persimmon 8B, MPT, Bloom Wählen Sie llama inference in Modelleinstellungen aus.

Sie können Antworten auf einige Fragen im FAQ -Abschnitt finden.

Beim Erstellen eines Chats wird eine JSON -Datei generiert, in der Sie zusätzliche Inferenzoptionen angeben können. Die Chat -Dateien befinden sich im Verzeichnis "Chats". Hier sehen Sie alle Inferenzoptionen.

Hier finden Sie einige der unterstützten Modelle.

llmfarm_core wurde in ein separates Repository verschoben. Um LLMFarm zu erstellen, müssen Sie dieses Repository rekursiv klonen:

git clone --recurse-submodules https://github.com/guinmoon/LLMFarm