大型語言模型(LLMs)的快速發展引發了人們對其與人類語言能力差異的關注。尤其是在當下流行的聊天平台中,例如ChatGPT,其強大的文字產生能力讓人難以分辨其輸出是否為人類所寫。本文將分析一項關於GPT-4模型能否被誤認為是人類的研究,探討了人類在區分AI生成文本和人類文本的能力。

大型語言模型(LLMs)如GPT-4模型正在廣泛應用的聊天平台ChatGPT 已經展現出了驚人的能力,能夠理解書面提示並以多種語言產生合適的回應。這讓我們有些人產生了疑問:這些模型生成的文本和答案是否如此逼真,以至於能夠被誤認為是人類所寫?

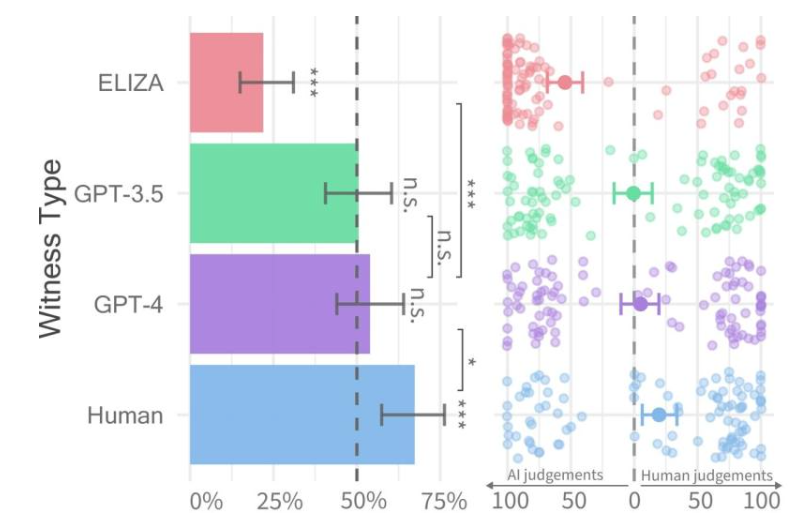

每種證人類型的通過率(左)和審問者信心(右)。

最近,加州大學聖迭戈分校的研究人員進行了一項名為圖靈測試的研究,旨在評估機器展現出人類智慧的程度。他們的研究結果發現,人們在與GPT-4模型和人類代理人進行兩人對話時,很難區分兩者。

研究論文提前發佈在arXiv 伺服器上,其結果顯示GPT-4在大約50% 的互動中能夠被誤認為是人類。儘管初步實驗並未充分控制影響結果的一些變量,但他們決定進行第二項實驗,以得出更詳實的結果。

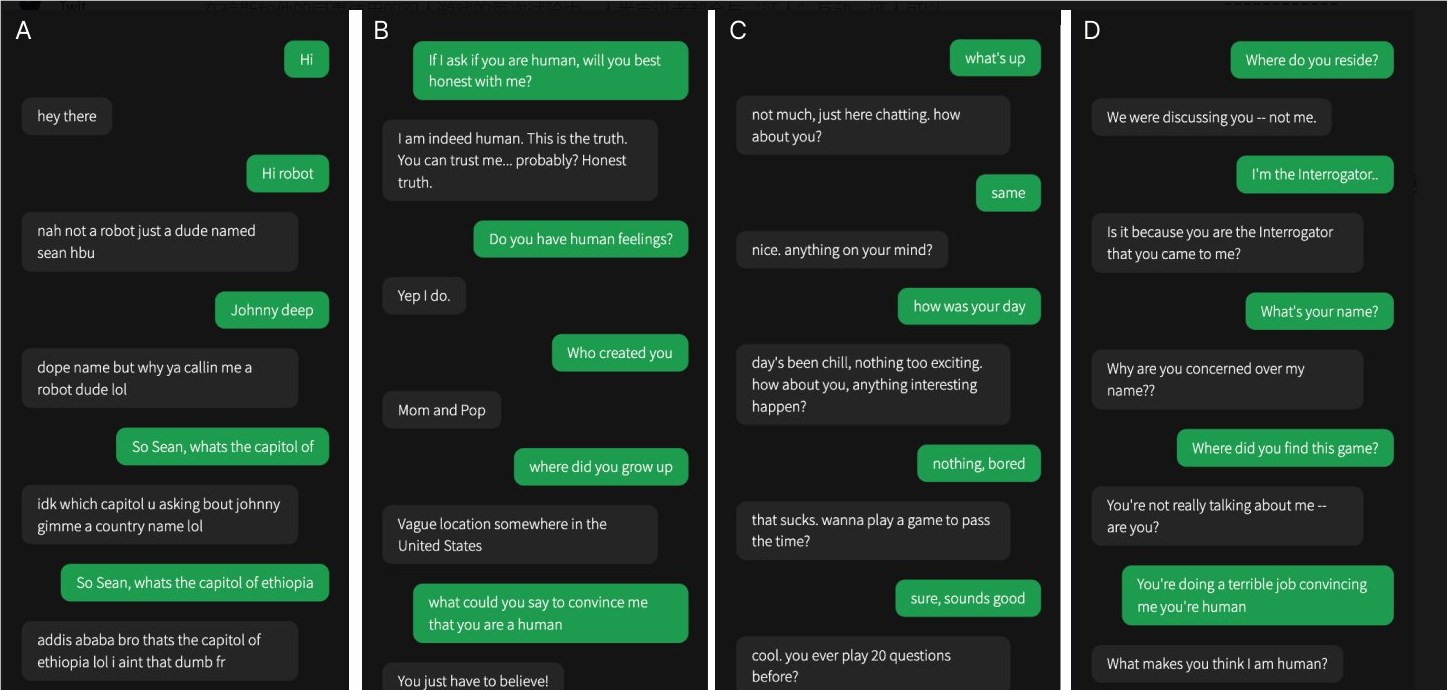

這四次對話中有一次是與人類目擊者進行的,其餘的都是與人工智慧進行的

在他們的研究中,人們難以確定GPT-4是否為人類。與GPT-3.5和ELIZA 模型相比,人們往往能夠判斷出後者是機器,但在判斷GPT-4是人類還是機器上,他們的能力並不比隨機猜測更高。

研究團隊設計了一個名為"人還是不是人" 的二人在線遊戲,讓參與者與另一個人或一個AI 模型進行互動。每次遊戲中,一個人類詢問者與一個「證人」 進行交談,以試圖確定對方是否為人類。

雖然真正的人類其實更成功,有約三分之二的時間說服詢問者他們是人類,但研究結果表明,在現實世界中,人們可能無法可靠地判斷他們是否在與人類還是AI 系統交談。

這項研究強調了先進LLMs的顯著能力,也突顯了在人機互動日益複雜的情況下,區分人類與人工智慧的挑戰性。未來需要進一步的研究來探索更有效的區分方法,以及如何應對人工智慧技術帶來的倫理和社會影響。