ในช่วงไม่กี่ปีที่ผ่านมา มีความต้องการโมเดล AI น้ำหนักเบาเพิ่มมากขึ้น โดยเฉพาะอย่างยิ่งบนแพลตฟอร์มที่มีทรัพยากรจำกัด เช่น อุปกรณ์เคลื่อนที่และคอมพิวเตอร์ส่วนบุคคล วิธีลดขนาดโมเดลและต้นทุนการคำนวณพร้อมทั้งรับประกันประสิทธิภาพกลายเป็นทิศทางการวิจัยที่สำคัญ บทความนี้จะแนะนำ SmolVLM ที่ Hugging Face เปิดตัวเมื่อเร็วๆ นี้ ซึ่งเป็นโมเดลภาษาภาพพารามิเตอร์ 2B ที่ออกแบบมาโดยเฉพาะสำหรับการอนุมานฝั่งอุปกรณ์ โดยได้ก่อให้เกิดการพัฒนาครั้งสำคัญในด้านความเร็วและประสิทธิภาพ และมอบโซลูชั่นสำหรับการประยุกต์งานภาษาภาพบนทรัพยากรต่ำ อุปกรณ์ที่เป็นไปได้ใหม่

ในช่วงไม่กี่ปีที่ผ่านมา มีความต้องการใช้งานโมเดล Machine Learning ในงานด้านการมองเห็นและภาษาเพิ่มมากขึ้น แต่โมเดลส่วนใหญ่ต้องการทรัพยากรการประมวลผลจำนวนมาก และไม่สามารถทำงานได้อย่างมีประสิทธิภาพบนอุปกรณ์ส่วนบุคคล โดยเฉพาะอย่างยิ่งอุปกรณ์ขนาดเล็ก เช่น แล็ปท็อป GPU สำหรับผู้บริโภค และอุปกรณ์มือถือ เผชิญกับความท้าทายครั้งใหญ่เมื่อประมวลผลงานภาษาภาพ

ยกตัวอย่าง Qwen2-VL แม้ว่าจะมีประสิทธิภาพที่ยอดเยี่ยม แต่ก็มีข้อกำหนดด้านฮาร์ดแวร์ที่สูง ซึ่งจำกัดการใช้งานในแอปพลิเคชันแบบเรียลไทม์ ดังนั้นการพัฒนาโมเดลน้ำหนักเบาเพื่อให้ทำงานโดยใช้ทรัพยากรที่น้อยลงจึงกลายเป็นสิ่งจำเป็นที่สำคัญ

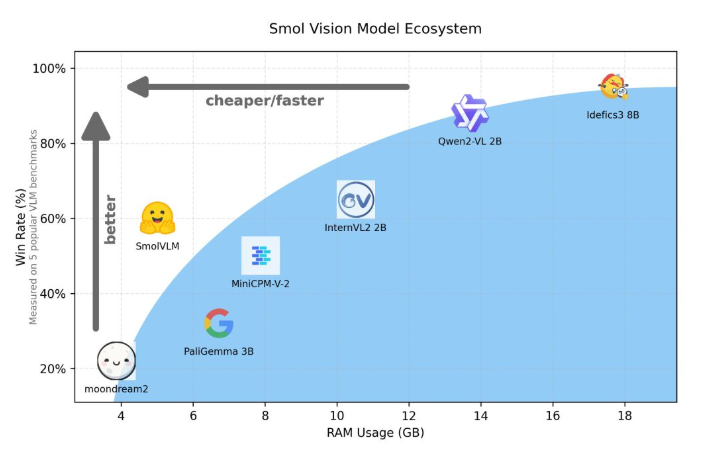

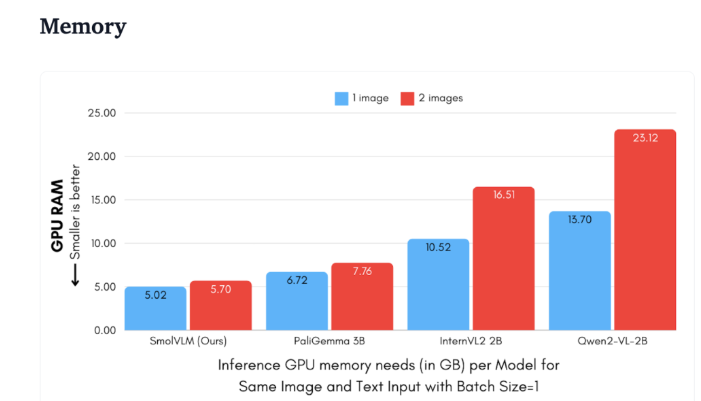

Hugging Face เพิ่งเปิดตัว SmolVLM ซึ่งเป็นโมเดลภาษาภาพพารามิเตอร์ 2B ที่ออกแบบมาเป็นพิเศษสำหรับการให้เหตุผลด้านอุปกรณ์ SmolVLM มีประสิทธิภาพเหนือกว่ารุ่นอื่นๆ ที่คล้ายคลึงกันในแง่ของการใช้หน่วยความจำ GPU และความเร็วในการสร้างโทเค็น คุณสมบัติหลักของมันคือความสามารถในการทำงานอย่างมีประสิทธิภาพบนอุปกรณ์ขนาดเล็ก เช่น แล็ปท็อปหรือ GPU ระดับผู้บริโภค โดยไม่ทำให้ประสิทธิภาพลดลง SmolVLM ค้นหาความสมดุลในอุดมคติระหว่างประสิทธิภาพและประสิทธิภาพ โดยแก้ไขปัญหาที่ยากจะเอาชนะในรุ่นที่คล้ายกันก่อนหน้านี้

เมื่อเปรียบเทียบกับ Qwen2-VL2B แล้ว SmolVLM จะสร้างโทเค็นได้เร็วขึ้น 7.5 ถึง 16 เท่า ด้วยสถาปัตยกรรมที่ได้รับการปรับให้เหมาะสม ซึ่งทำให้การอนุมานแบบน้ำหนักเบาเป็นไปได้ ประสิทธิภาพนี้ไม่เพียงแต่นำประโยชน์เชิงปฏิบัติมาสู่ผู้ใช้เท่านั้น แต่ยังช่วยเพิ่มประสบการณ์ผู้ใช้อย่างมากอีกด้วย

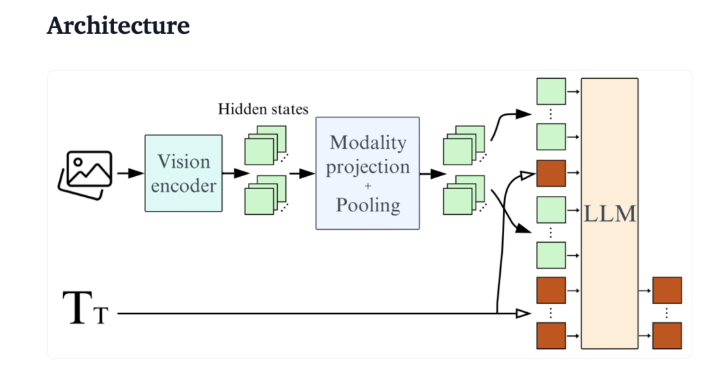

จากมุมมองทางเทคนิค SmolVLM มีสถาปัตยกรรมที่ได้รับการปรับปรุงให้เหมาะสมซึ่งรองรับการอนุมานฝั่งอุปกรณ์ที่มีประสิทธิภาพ ผู้ใช้ยังปรับแต่ง Google Colab อย่างละเอียดได้อย่างง่ายดาย ซึ่งช่วยลดเกณฑ์สำหรับการทดลองและพัฒนาได้อย่างมาก

เนื่องจากพื้นที่หน่วยความจำมีขนาดเล็ก SmolVLM จึงสามารถทำงานได้อย่างราบรื่นบนอุปกรณ์ที่ก่อนหน้านี้ไม่สามารถโฮสต์โมเดลที่คล้ายกันได้ เมื่อทดสอบวิดีโอ YouTube แบบ 50 เฟรม SmolVLM ทำงานได้ดี โดยได้คะแนน 27.14% และมีประสิทธิภาพเหนือกว่าโมเดลที่ต้องใช้ทรัพยากรอีกสองโมเดลในแง่ของการใช้ทรัพยากร ซึ่งแสดงให้เห็นถึงความสามารถในการปรับตัวและความยืดหยุ่นที่แข็งแกร่ง

SmolVLM เป็นก้าวสำคัญในด้านโมเดลภาษาภาพ การเปิดตัวดังกล่าวทำให้สามารถรันงานภาษาภาพที่ซับซ้อนบนอุปกรณ์ในชีวิตประจำวันได้ ซึ่งช่วยเติมเต็มช่องว่างที่สำคัญในเครื่องมือ AI ในปัจจุบัน

SmolVLM ไม่เพียงแต่เป็นเลิศในด้านความเร็วและประสิทธิภาพเท่านั้น แต่ยังมอบเครื่องมืออันทรงพลังให้กับนักพัฒนาและนักวิจัยเพื่ออำนวยความสะดวกในการประมวลผลภาษาภาพโดยไม่ต้องเสียค่าใช้จ่ายด้านฮาร์ดแวร์ราคาแพง ในขณะที่เทคโนโลยี AI ยังคงได้รับความนิยมมากขึ้น โมเดลอย่าง SmolVLM จะทำให้ความสามารถในการเรียนรู้ของเครื่องอันทรงพลังเข้าถึงได้ง่ายขึ้น

สาธิต:https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

https://huggingface.co/spaces/HuggingFaceTB/SmolVLM

ไฮไลท์:

SmolVLM คือโมเดลภาษาภาพพารามิเตอร์ 2B ที่ Hugging Face เปิดตัว ซึ่งได้รับการออกแบบมาเพื่อการให้เหตุผลด้านอุปกรณ์โดยเฉพาะ โดยทำงานได้อย่างมีประสิทธิภาพและไม่ต้องใช้ฮาร์ดแวร์ระดับไฮเอนด์

ความเร็วในการสร้างโทเค็นอยู่ที่ 7.5 ถึง 16 เท่าของรุ่นที่คล้ายกัน ซึ่งช่วยปรับปรุงประสบการณ์ผู้ใช้และประสิทธิภาพของแอปพลิเคชันได้อย่างมาก

ในการทดสอบ SmolVLM แสดงให้เห็นถึงความสามารถในการปรับตัวที่แข็งแกร่งและสามารถบรรลุคะแนนที่ดีแม้ว่าจะไม่มีการฝึกอบรมข้อมูลวิดีโอก็ตาม

การเกิดขึ้นของ SmolVLM ถือเป็นความก้าวหน้าครั้งสำคัญในการพัฒนาโมเดลภาษาภาพแบบน้ำหนักเบา ซึ่งไม่เพียงแต่ปรับปรุงประสบการณ์ผู้ใช้เท่านั้น แต่ยังมอบเครื่องมือที่สะดวกยิ่งขึ้นให้กับนักพัฒนาและนักวิจัยอีกด้วย ในอนาคต โมเดลที่มีประสิทธิภาพและมีน้ำหนักเบาอย่าง SmolVLM จะมีบทบาทในสถานการณ์ต่างๆ มากขึ้น และส่งเสริมการประยุกต์ใช้เทคโนโลยีปัญญาประดิษฐ์ในวงกว้างมากขึ้น