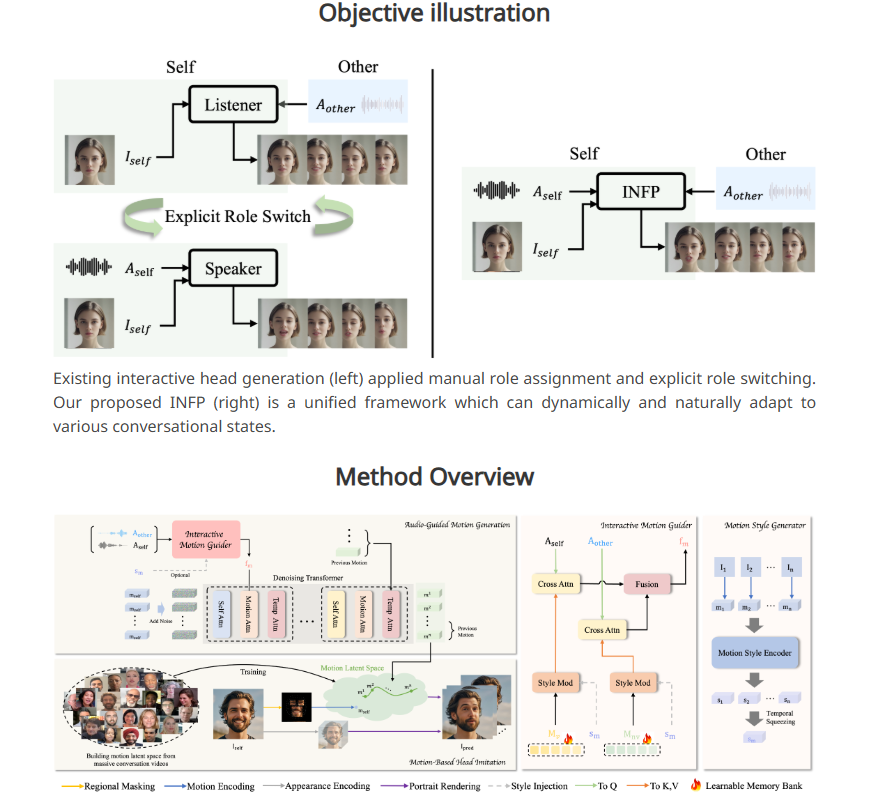

ByteDance ได้เปิดตัวระบบ AI ใหม่ INFP ซึ่งช่วยให้ภาพถ่ายบุคคลแบบคงที่สามารถ "พูด" และโต้ตอบผ่านอินพุตเสียงได้ แตกต่างจากเทคโนโลยีแบบดั้งเดิม INFP ไม่จำเป็นต้องระบุบทบาทด้วยตนเอง ระบบสามารถตัดสินตามการสนทนาได้โดยอัตโนมัติ ซึ่งช่วยปรับปรุงประสิทธิภาพและความสะดวกสบายอย่างมาก เทคโนโลยีหลักอยู่ในสองขั้นตอนของ "การเลียนแบบศีรษะตามการเคลื่อนไหว" และ "การสร้างการเคลื่อนไหวด้วยเสียง" โดยการวิเคราะห์การแสดงออกทางสีหน้า การเคลื่อนไหวของศีรษะ และการป้อนข้อมูลเสียงในการสนทนา จะสร้างรูปแบบการเคลื่อนไหวที่เป็นธรรมชาติและราบรื่นเพื่อทำให้ภาพนิ่งเกิดขึ้น ถึงชีวิต เพื่อฝึก INFP นั้น ByteDance ยังได้สร้างชุดข้อมูล DyConv ที่ประกอบด้วยวิดีโอการสนทนาจริงมากกว่า 200 ชั่วโมงเพื่อให้แน่ใจว่าเอาต์พุตของระบบจะมีคุณภาพสูง

มีสองขั้นตอนหลักในขั้นตอนการทำงานของ INFP ในขั้นตอนแรกที่เรียกว่า "การเลียนแบบศีรษะตามการเคลื่อนไหว" ระบบจะดึงรายละเอียดจากวิดีโอโดยการวิเคราะห์การแสดงออกทางสีหน้าและการเคลื่อนไหวของศีรษะในระหว่างการสนทนา ข้อมูลการเคลื่อนไหวนี้จะถูกแปลงเป็นรูปแบบที่สามารถใช้ในแอนิเมชั่นครั้งต่อๆ ไป ซึ่งช่วยให้ภาพนิ่งตรงกับการเคลื่อนไหวของตัวละครต้นฉบับ

ขั้นตอนที่สองคือ "การสร้างการเคลื่อนไหวด้วยเสียง" ซึ่งระบบจะสร้างรูปแบบการเคลื่อนไหวที่เป็นธรรมชาติตามอินพุตเสียง ทีมวิจัยได้พัฒนา "คำแนะนำการเคลื่อนไหว" ซึ่งจะวิเคราะห์เสียงจากทั้งสองฝ่ายในการสนทนาเพื่อสร้างรูปแบบการเคลื่อนไหวสำหรับการพูดและการฟัง จากนั้นส่วนประกอบ AI ที่เรียกว่า Diffusion Transformer จะค่อยๆ ปรับรูปแบบเหล่านี้ให้เหมาะสม ส่งผลให้ได้การเคลื่อนไหวที่ราบรื่นและสมจริงซึ่งเข้ากับเนื้อหาเสียงได้อย่างสมบูรณ์แบบ

เพื่อฝึกระบบได้อย่างมีประสิทธิภาพ ทีมวิจัยยังได้จัดทำชุดข้อมูลบทสนทนาที่เรียกว่า DyConv ซึ่งรวบรวมวิดีโอบทสนทนาจริงมากกว่า 200 ชั่วโมง เมื่อเปรียบเทียบกับฐานข้อมูลการสนทนาที่มีอยู่ เช่น ViCo และ RealTalk แล้ว DyConv มีข้อได้เปรียบที่เป็นเอกลักษณ์ในด้านการแสดงออกทางอารมณ์และคุณภาพของวิดีโอ

ByteDance กล่าวว่า INFP มีประสิทธิภาพเหนือกว่าเครื่องมือที่มีอยู่ในหลายประเด็นสำคัญ โดยเฉพาะอย่างยิ่งในการจับคู่การเคลื่อนไหวของริมฝีปากกับคำพูด การรักษาลักษณะใบหน้าของแต่ละบุคคล และสร้างการเคลื่อนไหวที่เป็นธรรมชาติที่หลากหลาย นอกจากนี้ ระบบยังทำงานได้ดีพอๆ กันในการสร้างวิดีโอที่ได้ยินเฉพาะคู่สนทนาเท่านั้น

แม้ว่าปัจจุบัน INFP รองรับเฉพาะอินพุตเสียง แต่ทีมวิจัยกำลังสำรวจความเป็นไปได้ในการขยายระบบไปยังรูปภาพและข้อความ เป้าหมายในอนาคตคือเพื่อสร้างภาพเคลื่อนไหวที่สมจริงของทั้งร่างกายของตัวละคร อย่างไรก็ตาม เมื่อพิจารณาว่าเทคโนโลยีประเภทนี้สามารถใช้เพื่อสร้างวิดีโอปลอมและเผยแพร่ข้อมูลที่ไม่ถูกต้องได้ ทีมวิจัยจึงวางแผนที่จะจำกัดการใช้เทคโนโลยีหลักกับสถาบันวิจัย คล้ายกับการจัดการระบบโคลนเสียงขั้นสูงของ Microsoft

เทคโนโลยีนี้เป็นส่วนหนึ่งของกลยุทธ์ AI ที่กว้างขึ้นของ ByteDance ด้วยการใช้แอปพลิเคชันยอดนิยมอย่าง TikTok และ CapCut ทำให้ ByteDance มีแพลตฟอร์มแอปพลิเคชันนวัตกรรม AI ที่กว้างขวาง

ทางเข้าโครงการ: https://grisoon.github.io/INFP/

ไฮไลท์:

INFP สามารถอนุญาตให้ภาพนิ่ง "พูด" ผ่านเสียง และกำหนดบทบาทของบทสนทนาได้โดยอัตโนมัติ

ระบบทำงานในสองขั้นตอน: ขั้นแรก แยกรายละเอียดการเคลื่อนไหวในการสนทนาของมนุษย์ และประการที่สอง แปลงเสียงเป็นรูปแบบการเคลื่อนไหวที่เป็นธรรมชาติ

ชุดข้อมูล DyConv ของ ByteDance ประกอบด้วยวิดีโอการสนทนาคุณภาพสูงมากกว่า 200 ชั่วโมงเพื่อช่วยปรับปรุงประสิทธิภาพของระบบ

การเปิดตัวระบบ INFP แสดงให้เห็นถึงความแข็งแกร่งด้านนวัตกรรมของ ByteDance ในด้านปัญญาประดิษฐ์ ศักยภาพในการพัฒนาในอนาคตนั้นมีมหาศาล แต่ความเสี่ยงด้านจริยธรรมที่อาจเกิดขึ้นก็ต้องได้รับการจัดการอย่างระมัดระวังเช่นกัน ความก้าวหน้าของเทคโนโลยีควรมุ่งเน้นไปที่ผลประโยชน์ทางสังคมเสมอ และให้แน่ใจว่าจะถูกนำมาใช้เพื่อประโยชน์ของมนุษยชาติ