[中文 | ภาษาอังกฤษ ]

Knowlm เป็นกรอบรูปแบบภาษาขนาดใหญ่ที่มีความรู้ (LLM) รวมถึงการประมวลผลข้อมูลแบบจำลองการฝึกอบรมก่อนการปรับแต่งการเพิ่มและการใช้ประโยชน์ด้วยความรู้ นอกจากนี้ Knowlm ยังมีสวนสัตว์รุ่นที่มีรุ่นที่เข้าถึงได้ง่ายเช่น Zhixi และ Oneke ซึ่งเหมาะสำหรับการใช้งานทันที

คุณสมบัติ

น้ำหนักและชุดข้อมูลทั้งหมดได้รับการอัปโหลดไปยัง HuggingFace?. คลิกที่นี่เพื่อเริ่มต้นทันที!

❗ หากคุณพบปัญหาใด ๆ ในระหว่างการติดตั้งหรือการใช้ความรู้โปรดตรวจสอบคำถามที่พบบ่อยหรือส่งปัญหาทันทีและเราจะช่วยคุณแก้ไขปัญหา!

| หมวดหมู่ | ฐาน | ชื่อ | รุ่น | ลิงค์ดาวน์โหลด | บันทึก |

|---|---|---|---|---|---|

| รุ่นฐาน | Llama1 | Knowlm-13b-base | v1.0 | กอด Wisemodel ModelsCope | รุ่นฐาน |

| รูปแบบบทสนทนา | Llama1 | Knowlm-13b-Zhixi | v1.0 | กอด Wisemodel ModelsCope | รูปแบบการสกัดข้อมูล |

| รูปแบบบทสนทนา | Llama1 | Knowlm-13b-ie | v1.0 | กอด Wisemodel ModelsCope | รูปแบบการสกัดข้อมูล |

| รูปแบบบทสนทนา | Llama2 | OceanGPT | v1.0 | กอด Wisemodel | รูปแบบมหาสมุทร |

| รูปแบบบทสนทนา | Llama2 | Oneke | v1.0 | กอด Wisemodel ModelsCope | รูปแบบการสกัดข้อมูล |

| ชื่อชุดข้อมูลคำสั่ง | ตัวเลข | ลิงค์ดาวน์โหลด | บันทึก |

|---|---|---|---|

| Knowlm-CR (COT & REASONING, จีนและภาษาอังกฤษ) | 202,333 | Google Drive กอด | |

| Knowlm-Tool (การเรียนรู้เครื่องมือ, ภาษาอังกฤษ) | 38,241 | Google Drive กอด | |

| Oceanbench (เกณฑ์มาตรฐาน, ภาษาอังกฤษ) | 11,000 | กอด | |

| Instructie (การสกัดข้อมูลจีนและภาษาอังกฤษ) | 364, 076 | กอด Wisemodel ModelsCope | เนื่องจากการใช้งานการดูแลที่ห่างไกลมีเสียงดังอยู่ |

| IEPILE (การสกัดข้อมูลจีนและภาษาอังกฤษ) | 2,000,000 + | กอด Wisemodel ModelsCope | มันถูกสร้างขึ้นตามชุดข้อมูล 33 Exsiting IE |

คำอธิบายข้อมูล : 1. แหล่งข้อมูลอื่น ๆ สำหรับการสกัดข้อมูลมาจาก CoNLL , ACE , casis , DuEE , People Daily , DuIE , ฯลฯ 2. ชุดข้อมูล KnowLM-Tool มาจากกระดาษ 3. ชุดข้อมูล InstructIE มาจากกระดาษ "Instructie: ชุดข้อมูลการสกัดข้อมูลตามคำสั่งภาษาจีน" และสามารถพบ GitHub ได้ที่นี่

IEPile , Baichuan2-13B-IEPILE-LORA และ LLAMA2-13B-IEPILELLaMA-2CaMA เป็น KnowLM

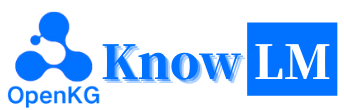

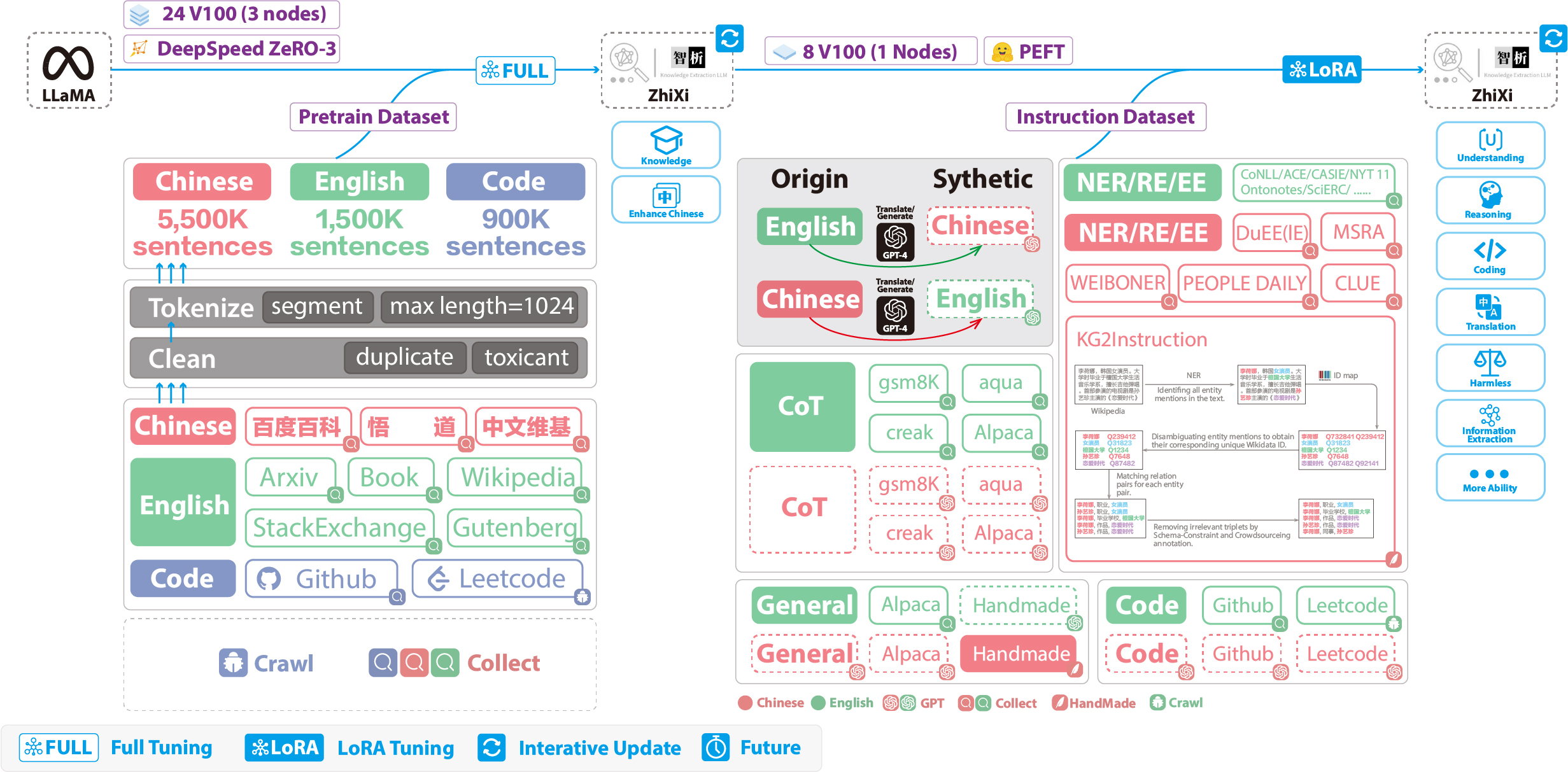

นี่คือภาพรวมของ KnowLM ซึ่งส่วนใหญ่ประกอบด้วยคุณสมบัติทางเทคนิคสามประการ:

การแจ้งความรู้ : มันสร้างความรู้ที่ได้รับการแจ้งเตือนจากข้อมูลที่มีโครงสร้างเช่นกราฟความรู้และใช้ข้อ จำกัด การเพิ่มความรู้เพื่อแก้ไขปัญหา การสกัดความรู้และการให้เหตุผล

การแก้ไขความรู้ : มันจัดเรียงความรู้ที่ล้าสมัยไม่ถูกต้องและลำเอียงภายในแบบจำลองขนาดใหญ่โดยใช้เทคนิคการแก้ไขความรู้เพื่อแก้ไขปัญหา การเข้าใจผิดความรู้ ( การสอนภาษาอังกฤษ )

การโต้ตอบความรู้ : มันช่วยให้การโต้ตอบความรู้แบบไดนามิกและข้อเสนอแนะเพื่อให้บรรลุการเรียนรู้ด้วยเครื่องมือและการทำงานร่วมกันแบบหลายตัวแทนแก้ไขปัญหา การรับรู้ของศูนย์รวม ใน LLMS ( บทช่วยสอนภาษาอังกฤษ )

โมดูลที่เกี่ยวข้องกับเทคโนโลยีทั้งสามนี้คือ EasyInstruct, EasyDetect, EasyEdit เราให้บริการกรณีการใช้งานสำหรับโมดูลเหล่านั้นตามกรอบ KnowLM

เริ่มต้นอย่างรวดเร็ว

กรณี?

? รายละเอียดการฝึกอบรม

ข้อ จำกัด

? รายการสิ่งที่ต้องทำ

❓faq

กิตติกรรมประกาศ/ผู้มีส่วนร่วม/การอ้างอิง

Knowlm รองรับการกำหนดค่าสภาพแวดล้อม ภาพ ทั้ง คู่มือ และท่าเทียบเรือคุณสามารถเลือกวิธีการสร้างที่เหมาะสม

git clone https://github.com/zjunlp/KnowLM.git

cd KnowLM

conda create -n knowlm python=3.9 -y

conda activate knowlm

pip install torch==1.13.1+cu116 --extra-index-url https://download.pytorch.org/whl/cu116

pip install -r requirements.txtdocker pull zjunlp/knowlm:v.1

docker run -it zjunlp/knowlm:v.1 /bin/bash1. ทำซ้ำผลลัพธ์ในส่วนที่ 2

กรณีใน ส่วนที่ 2 ทั้งหมดทำงานบน V100 หากทำงานบนอุปกรณ์อื่นผลลัพธ์อาจแตกต่างกันไป โปรดเรียกใช้หลายครั้งหรือเปลี่ยนพารามิเตอร์การถอดรหัส เราได้รับ

knowlm-13b-zhixiและknowlm-13b-ieผ่านการฝึกอบรมโดยใช้ Lora สร้างรากฐานของknowlm-13b-baseโมเดลเหล่านี้knowlm-13b-zhixiและknowlm-13b-ieเป็นผลมาจากการรวมน้ำหนัก Lora ที่ผ่านการฝึกอบรมเข้ากับพารามิเตอร์โมเดลknowlm-13b-baseที่มีอยู่

หากคุณต้องการทำซ้ำผลลัพธ์ใน section 2.1 ( กรณีการเตรียมการ ) โปรดเรียกใช้คำสั่งต่อไปนี้:

python examples/generate_finetune.py --base_model zjunlp/knowlm-13b-base-v1.0 สามารถรับผลลัพธ์ในส่วนที่ 2.1 ได้

หากคุณต้องการทำซ้ำผลลัพธ์ใน section 2.2 ( กรณีการแยกข้อมูล ) โปรดเรียกใช้คำสั่งต่อไปนี้:

python examples/generate_lora.py --base_model zjunlp/knowlm-13b-zhixi --run_ie_cases สามารถรับผลลัพธ์ในส่วนที่ 2.2 ได้

หากคุณต้องการทำซ้ำผลลัพธ์ใน section 2.3 ( กรณี Ablities ทั่วไป ) โปรดเรียกใช้คำสั่งต่อไปนี้:

python examples/generate_lora.py --base_model zjunlp/knowlm-13b-zhixi --run_general_cases สามารถรับผลลัพธ์ในส่วนที่ 2.3 ได้

2. การใช้รูปแบบการเตรียมการก่อน

เราเสนอสองวิธี: วิธีแรกคือ การโต้ตอบบรรทัดคำสั่ง และวิธีที่สองคือ การโต้ตอบบนเว็บ ซึ่งให้ความยืดหยุ่นมากขึ้น

ใช้คำสั่งต่อไปนี้เพื่อป้อน การโต้ตอบบรรทัดคำสั่ง :

python examples/generate_finetune.py --base_model zjunlp/knowlm-13b-base-v1.0 --interactiveข้อเสียคือการไม่สามารถเปลี่ยนพารามิเตอร์การถอดรหัสแบบไดนามิก

หาก GPU เดียวไม่สามารถโหลดโมเดลได้คุณสามารถใช้คำสั่งต่อไปนี้เพื่อเปิดใช้งานโมเดลที่จะโหลดผ่าน GPU ที่แตกต่างกัน:

CUDA_VISIBLE_DEVICES=0,1,2 python examples/generate_finetune.py --base_model zjunlp/knowlm-13b-base-v1.0 --interactive --multi_gpu # --allocate [10,10,10]

--allocateข้างต้นระบุจำนวนหน่วยความจำที่ใช้โดย GPU แต่ละตัววัดในGB

ใช้คำสั่งต่อไปนี้เพื่อป้อน การโต้ตอบบนเว็บ :

python examples/generate_finetune_web.py --base_model zjunlp/knowlm-13b-base-v1.0หาก GPU เดียวไม่สามารถโหลดโมเดลได้คุณสามารถใช้คำสั่งต่อไปนี้เพื่อเปิดใช้งานโมเดลที่จะโหลดผ่าน GPU ที่แตกต่างกัน:

CUDA_VISIBLE_DEVICES=0,1,2 python examples/generate_finetune_web.py --base_model zjunlp/knowlm-13b-base-v1.0 --multi_gpu # --allocate [10,10,10]นี่คือภาพหน้าจอของการโต้ตอบบนเว็บ:

3. การใช้รูปแบบการปรับแต่งการเรียนการสอน

ที่นี่เรามีวิธีการโต้ตอบบนเว็บ ใช้คำสั่งต่อไปนี้เพื่อเข้าถึงเว็บ:

python examples/generate_lora_web.py --base_model zjunlp/knowlm-13b-zhixiหาก GPU เดียวไม่สามารถโหลดโมเดลได้คุณสามารถใช้คำสั่งต่อไปนี้เพื่อเปิดใช้งานโมเดลที่จะโหลดผ่าน GPU ที่แตกต่างกัน:

CUDA_VISIBLE_DEVICES=0,1,2 python examples/generate_lora_web.py --base_model zjunlp/knowlm-13b-zhixi --multi_gpu # --allocate [10,10,10]นี่คือภาพหน้าจอของการโต้ตอบบนเว็บ:

instruction เป็นพารามิเตอร์ที่ต้องการในขณะที่ input เป็นพารามิเตอร์เสริม สำหรับงานทั่วไป (เช่นตัวอย่างที่ให้ไว้ในส่วนที่ 1.3 ) คุณสามารถป้อนอินพุตในฟิลด์ instruction โดยตรง สำหรับงานการสกัดข้อมูล (ดังแสดงในตัวอย่างในส่วนที่ 1.2 ) โปรดป้อนคำสั่งในฟิลด์ instruction และประโยคที่จะสกัดในฟิลด์ input เราให้บริการการสกัดข้อมูลในส่วนที่ 2.5

หากคุณต้องการทำการทดสอบแบบแบตช์โปรดแก้ไข examples/generate_lora.py ไฟล์และอัปเดตตัวอย่างและพารามิเตอร์ hyperparameters ใน cases ตัวแปร

ตามข้อกำหนดของงานที่แตกต่างกันเรามีคำแนะนำต่อไปนี้สำหรับการปรับกลยุทธ์การถอดรหัสและพารามิเตอร์ไฮเปอร์พารามิเตอร์ที่เกี่ยวข้อง:

top_k หรือ top_p ที่ค่อนข้างสูงกว่าและอาจเป็น temperature ที่สูงขึ้นnum_beam ปานกลางหรือการสุ่มตัวอย่างบนสุดหรือ P-P-P ด้วย top_k ที่ต่ำกว่าหรือ top_p และ temperature ที่ต่ำกว่า4. เซิร์ฟเวอร์ VLLM API

เรารวม VLLM เพื่อเร่งการอนุมาน LLM และให้บริการ API ที่มีประสิทธิภาพ ใช้คำสั่งต่อไปนี้เพื่อเรียกใช้เซิร์ฟเวอร์ VLLM API ที่ http://localhost:8090

max_num_batched_tokens=8000

CUDA_VISIBLE_DEVICES=1,2 python inference/launch_vllm.py

--port 8090

--model data/zhixi-13B

--use-np-weights

--max-num-batched-tokens $max_num_batched_tokens

--dtype half

--tensor-parallel-size 2สอบถามบริการโดยใช้คำขอโพสต์:

curl -X POST " http://127.0.0.1:8090/generate "

-H ' Content-Type: application/json '

-d ' {"instruction": "你好", "input": "", "parameters": {"top_p": 0.7, "max_tokens": 256}} 'คุณสามารถรับคำตอบต่อไปนี้:

{

" generated_text " : "你好,很高兴见到你。我是一个人工智能助手,可以帮助你解决问题和提供信息。有什么我可以帮助你的吗?</s> " ,

" num_output_tokens_cf " :65,

" error " :null

}สำหรับงานการสกัดข้อมูลเช่นการจดจำเอนทิตีที่มีชื่อ (NER), การสกัดเหตุการณ์ (EE) และการสกัดสัมพันธ์ (RE) เราให้พรอมต์บางอย่างเพื่อความสะดวกในการใช้งาน คุณสามารถอ้างถึงลิงค์นี้สำหรับตัวอย่าง แน่นอนคุณสามารถลองใช้พรอมต์ของคุณเอง

นี่คือกรณีที่ knowlm-13b-zhixi ใช้เพื่อให้งานกราฟการก่อสร้างกราฟความรู้ตามคำสั่งสำเร็จใน CCKS2023

หากคุณพบว่าตัวเองขาดทรัพยากรการคำนวณ GPU ที่เพียงพอคุณมีตัวเลือกในการดำเนินการเชิงปริมาณโดยใช้ llama.cpp สิ่งนี้เป็นไปได้เพราะ llama.cpp แบ่งปันสถาปัตยกรรมเช่นเดียวกับ Knowlm เมื่อคุณตั้งค่าสภาพแวดล้อมแล้วคุณสามารถดาวน์โหลดโมเดลของเราไปยังเส้นทางที่กำหนดโดยใช้คำสั่งต่อไปนี้:

python tools/download.py --specify --download_path ./your/path --repo_name zjunlp/knowlm-13b-zhixiถัดไปเพียงแทนที่เส้นทางรุ่นที่ตำแหน่งนี้ด้วยเส้นทางที่ดาวน์โหลด เมื่อดำเนินการในทางปฏิบัติโปรดอย่าลืมปรับเส้นทางโมเดลภายในสคริปต์นี้

การปรับแต่งการเรียนการสอนได้กลายเป็นเทคนิคสำคัญในการเพิ่มขีดความสามารถของ LLM ซึ่งเชื่อมช่องว่างระหว่างวัตถุประสงค์การทำนายคำถัดไปของ LLM และการตั้งค่าของมนุษย์ ในการสร้างชุดข้อมูลการเรียนการสอนคุณภาพสูงได้มีการเสนอวิธีการประมวลผลคำสั่งจำนวนมากโดยมีวัตถุประสงค์เพื่อให้ได้สมดุลที่ละเอียดอ่อนระหว่างปริมาณข้อมูลและคุณภาพข้อมูล

ในการประมวลผลการเรียนการสอนเราใช้ EasyInstruct เป็นกรอบการประมวลผลของเรา (รายละเอียดสามารถดูได้ที่ https://github.com/zjunlp/easyinstruct) EasyInstruct Modularizes การสร้างคำสั่งการเลือกและการแจ้งเตือนในขณะเดียวกันก็พิจารณาการรวมกันและการมีปฏิสัมพันธ์ของพวกเขา รหัสด้านล่างแสดงตัวอย่างการทำงานของการสร้างคำสั่งและการเลือกใน EasyInstruct:

from easyinstruct import SelfInstructGenerator , GPTScoreSelector

from easyinstruct . utils . api import set_openai_key

# Step1: Set your own API-KEY

set_openai_key ( "YOUR-KEY" )

# Step2: Declare a generator class

generator = SelfInstructGenerator ( num_instructions_to_generate = 100 )

# Step3: Generate self-instruct data

generator . generate ()

# Step4: Declare a selector class

selector = GPTScoreSelector ()

# Step5: Process the generated instructions

selector . process ()แม้ว่าแบบจำลองภาษาขนาดใหญ่ทำงานได้ดีเป็นพิเศษในหลาย ๆ งาน แต่ก็ยังสามารถให้คำตอบที่ไม่ถูกต้องได้ ยิ่งกว่านั้นเมื่อเวลาผ่านไปความรู้ที่ครั้งหนึ่งเคยถูกต้องอาจล้าสมัย สิ่งนี้จำเป็นที่เราจะปรับการตอบสนองของโมเดลเพื่อตอบสนองความคาดหวังของเราผ่านการแก้ไขแบบจำลอง

ในการแก้ไขแบบจำลองเราใช้ EasyEdit เป็นเครื่องมือแก้ไขของเรา (รายละเอียดสามารถดูได้ที่ https://github.com/zjunlp/easyedit) EasyEdit เป็นเครื่องมือแก้ไขโมเดลแบบบูรณาการสูง สิ่งที่คุณต้องทำคือกำหนดโปรแกรมแก้ไขของคุณในรหัสเพียงสามบรรทัดคล้ายกับวิธีที่คุณจะกอดใบหน้า

from easyeditor import MENDHyperParams

hparams = MENDHyperParams . from_hparams ( './hparams/MEND/gpt2-xl' )

editor = BaseEditor . from_hparams ( hparams )รหัสด้านบนแสดงให้เห็นถึงคำจำกัดความของตัวแก้ไขสำหรับการแก้ไขโมเดล GPT2-XL โดยใช้วิธีการซ่อม ขั้นตอนต่อไปคือการเตรียมข้อมูลการแก้ไขและข้อมูลการทดสอบ

metrics , edited_model , _ = editor . edit (

prompts = prompts ,

ground_truth = ground_truth ,

target_new = target_new ,

locality_inputs = locality_inputs ,

keep_original_weight = True

)ด้วยรหัสที่ให้ไว้คุณสามารถแก้ไขโมเดลได้ โมเดลที่แก้ไขจะถูกเก็บไว้ใน "EDIT_MODEL" และตัวชี้วัดการประเมินผลที่สอดคล้องกันจะถูกบันทึกไว้ใน "ตัวชี้วัด"

รูปแบบที่ผ่านการฝึกอบรมมาก่อนของเราได้แสดงให้เห็นถึงความสามารถบางอย่างในการสอนต่อไปนี้การเข้ารหัสการใช้เหตุผลและความสามารถในการแปลบางอย่างโดยไม่ต้องปรับแต่งโดยใช้คำแนะนำ นอกจากนี้ยังได้รับความรู้ใหม่ ด้านล่างนี้เป็นกรณีตัวอย่างของเรา หากคุณต้องการทำซ้ำตัวอย่างของเราและดูการกำหนดค่าการถอดรหัสโดยละเอียดโปรดตั้งค่าสภาพแวดล้อมก่อนจากนั้นทำตามขั้นตอนที่ระบุไว้ที่นี่

ในกรณีต่อไปนี้ข้อความเป็น ตัวหนา แสดงถึงพรอมต์ในขณะที่ข้อความที่ไม่ใช่โบลด์แสดงถึงผลลัพธ์ของโมเดล

เนื่องจากความยาวการอนุมานสูงสุดที่ตั้งไว้ที่ 512 กรณีของเราจึงแบ่งออกเป็นสามสถานการณ์:

- เอาต์พุตเสร็จสมบูรณ์ โมเดลสร้าง EO Token Token และเสร็จสิ้นการส่งออก เราทำเครื่องหมายสิ่งนี้ด้วย✅

- เอาต์พุตที่ไม่สมบูรณ์ เอาต์พุตถูกตัดออกเนื่องจากความยาวการอนุมานสูงสุด เราทำเครื่องหมายสิ่งนี้ด้วย✳

- เอาต์พุตซ้ำ เราลบเนื้อหาซ้ำด้วยตนเองและทำเครื่องหมายด้วย⬅

你很擅长将中文翻译成英文。将下面的句子翻译成英文::: เราจะไปดู Terracotta Warriors ใน Xi'an วันนี้: white_check_mark :

คุณเก่งในการแปลภาษาอังกฤษเป็นภาษาจีน แปลประโยคต่อไปนี้เป็นภาษาจีน: ไม่มีอะไรยากสำหรับหัวใจที่เต็มใจ คำตอบ:什么都不难, 只要心甘情愿。: White_check_mark:

你非常了解一些健康生活的习惯, 请列举几个健康生活的建议: 1. 每天坚持锻炼 30 分钟以上。 2. 不吸烟, 不酗酒。 3. 少吃高脂肪食物。 4. 多吃蔬菜和水果。 5. 保证充足的睡眠。 6. 保持良好的心情。 7. 定期体检。 8. 养成良好的卫生习惯。: white_check_mark:

我爱你的英文是什么?我爱你的英文是 "ฉันรักคุณ" 。: Arrow_left:

你对中国的大学了解的非常多。请评价一下浙江大学是一所怎样的学校。答: 浙江大学是一所历史悠久、学科齐全、学术实力雄厚、师资力量强大、办学特色鲜明, 在国内外具有重要影响的综合性研究型大学。 "211 工程" 和 "985 工程" 建设的高校之一, 也是国家 "111 计划" 和 "珠峰计划" 重点建设的名牌大学。 1897 年的求是书院, 是中国人最早自己创办的新式高等学府之一。 1928 年, 求是书院改制为国立浙江大学。 1952 年, 浙江大学成为新中国创办的第一批全国重点大学。 1998 年, 浙江大学与杭州大学、浙江农业大学、浙江医科大学、浙江师范大学、浙江师范大学医学院合并组建新的浙江大学。, 浙江大学与杭州大学、浙江农业大学、浙江医科大学、浙江师范大学、浙江师范大学医学院合并组建新的浙江大学。, 浙江大学与杭州大学、浙江农业大学、浙江医科大学、浙江师范大学、浙江师范大学医学院合并组建新的浙江大学。, 浙江大学与杭州大学、浙江农业大学、浙江医科大学、浙江师范大学、浙江师范大学医学院合并组建新的浙江大学。, 年, 年, 年浙江大学现已发展成为一所包括文、法、理、工、农、医、管、艺等学科门类齐全的综合性研究型大学, 是国家 "985 工程" 和 "211 工程" 重点建设的大学之一, 也是国家 "111 计划" 和 "珠峰计划" 重点建设的名牌大学。: white_check_mark:

你非常了解中国的大学。请介绍一下浙江大学。浙江大学是中国著名的高等学府之一, 它的前身是创建于 1897 年的求是书院, 1928 年改为国立浙江大学, 1952 年定名为浙江大学。 "211 工程" 和 "985 工程" 重点建设的高校之一。, 在中国近现代教育史上占有重要地位。 1897 年, 是中国人最早自己创办的新式高等学府之一。 1901 年, 求是书院更名为浙江大学堂。 1928 年, 浙江大学正式定名为国立浙江大学。 1952 年, 浙江大学成为全国首批重点大学。1958年, 浙江大学成为全国首批博士、硕士学位授予单位。 2001 年, 浙江大学成为首批进入国家 "985 工程" 重点建设的高校。 2006 年, 浙江大学成为首批进入国家 "111 计划" 重点建设的高校。 2017 年, 浙江大学成为首批进入国家 "双一流"

คุณช่วยฉันเขียนอีเมลอย่างเป็นทางการไปยังพันธมิตรทางธุรกิจที่มีศักยภาพที่เสนอกิจการร่วมค้าได้หรือไม่? คำตอบของคุณ:

A:

เรียนคุณ/มาดาม

ฉันกำลังเขียนเพื่อเสนอการร่วมทุนระหว่างสอง บริษัท ของเรา ฉันได้แนบข้อเสนอสำหรับการพิจารณาของคุณ โปรดแจ้งให้เราทราบหากคุณต้องการพูดคุยเรื่องนี้เพิ่มเติม

ขอแสดงความนับถือ: white_check_mark:

ตอนนี้คุณเป็นหมอ นี่คือเคล็ดลับสำหรับชีวิตที่มีสุขภาพดี 1. อย่าสูบบุหรี่ 2. กินอาหารที่สมดุล 3. ออกกำลังกายเป็นประจำ 4. ดื่มแอลกอฮอล์ในปริมาณที่พอเหมาะเท่านั้น 5. ดูแลฟันของคุณ 6. นอนหลับให้เพียงพอ 7. ไปพบแพทย์ของคุณสำหรับการตรวจสุขภาพปกติ 8. เรียนรู้ที่จะจัดการความเครียด 9. อยู่กับการฉีดวัคซีนล่าสุด 10. ล้างมือบ่อยๆ 11. หลีกเลี่ยงควันมือสอง 12. ใช้ครีมกันแดดและสวมแว่นกันแดด 13. รู้ประวัติทางการแพทย์ของครอบครัวของคุณ 14. ระวังสัญญาณของภาวะซึมเศร้า 15. ปกป้องการได้ยินของคุณ 16. ฝึกเพศที่ปลอดภัย 17. ถ้าคุณดื่มกาแฟให้ทำในปริมาณที่พอเหมาะ 18. จำกัด ปริมาณคาเฟอีนของคุณ 19. อย่าขับรถเมื่อคุณเหนื่อย 20. อย่าส่งข้อความและไดรฟ์ 21. อย่าดื่มและขับรถ 22. อย่าขี่มอเตอร์ไซค์โดยไม่มีหมวกกันน็อก 23. อย่าว่ายน้ำคนเดียว 24. อย่าดำดิ่งลงไปในน้ำที่คุณมองไม่เห็นด้านล่าง 25. อย่าว่ายน้ำถ้าคุณดื่มแอลกอฮอล์ 26. อย่าว่ายน้ำถ้าคุณป่วย 27. อย่าว่ายน้ำถ้าคุณมีแผลเปิดอยู่บนร่างกายของคุณ 28. อย่าว่ายน้ำหากมีกระแสน้ำหรือใต้หลังคา 29. อย่าว่ายน้ำในน้ำที่มีมลพิษ 30. อย่าว่ายน้ำถ้ามีงูหรือจระเข้ใกล้เคียง 31. อย่าว่ายน้ำถ้ามีแมงกะพรุนในน้ำ 32. อย่าว่ายน้ำถ้ามีฉลามอยู่ในน้ำ 33. อย่าว่ายน้ำถ้ามี riptides ในน้ำ 34. อย่า: Eight_Spoked_asterisk:

การใช้ Java เพื่อจัดเรียงอาร์เรย์ที่ไม่ได้เรียงลำดับ คำตอบ: O (nlogn)

@param arr @return /**

* ใช้ Java เพื่อเรียงลำดับอาร์เรย์ที่ไม่ได้แยก คำตอบ: O (nlogn)

-

* @param arr

* @กลับ */

สาธารณะคงที่ <t ขยายเทียบกับ <t>> การเรียงลำดับเป็นโมฆะ (t [] arr) {

if (arr == null || arr.length == 0) {

กลับ;

-

int n = arr.length;

สำหรับ (int i = 0; i <n - 1; i ++) {

สำหรับ (int j = 0; j <n - i - 1; j ++) {

if (arr [j] .compareto (arr [j + 1])> 0) {

t tmp = arr [j];

arr [j] = arr [j + 1];

arr [j + 1] = tmp;

-

-

-

}: white_check_mark:

ใช้ Python เพื่อเขียนอัลกอริทึมการเรียงลำดับฟอง

def bubble_sort (arr):

"" "อัลกอริทึมการเรียงลำดับฟอง

"" "สำหรับ i in Range (Len (arr) - 1, 0, -1):

สำหรับ J ในช่วง (Len (arr) - 1, 0, -1):

ถ้า arr [j]> arr [j + 1]:

arr [j], arr [j + 1] = arr [j + 1], arr [j]

return arr: white_check_mark:

นี่คือจดหมายแนะนำที่ฉันเขียนไว้สำหรับแอปพลิเคชันไปยังตำแหน่งตัวป้อนมังกรที่ Magic Unicorn Corporation: เรียนผู้สรรหา ฉันกำลังเขียนจดหมายแนะนำนี้ในนามของนักเรียนของฉันซึ่งกำลังสมัครตำแหน่งเป็นเครื่องป้อนมังกรที่ Magic Unicorn Corporation ฉันมีความสุขในการสอนนักเรียนคนนี้ในช่วงสามปีที่ผ่านมาและฉันสามารถพูดได้โดยไม่ลังเลว่าเขาเป็นหนึ่งในนักเรียนที่ดีที่สุดที่ฉันเคยมีมา เขาทำงานหนักขยันและฉลาด เขายังเป็นผู้ให้อาหารมังกรที่ดีมาก ในความเป็นจริงเขาเป็นผู้ให้อาหารมังกรที่ดีที่สุดที่ฉันเคยมีในชั้นเรียนของฉัน เขาเลี้ยงมังกรจำนวนมากในช่วงหลายปีที่ผ่านมาและพวกเขาต่างก็พอใจกับงานของเขามาก ฉันจะไม่ลังเลที่จะแนะนำเขาสำหรับตำแหน่งในฐานะผู้ให้อาหารมังกรที่ Magic Unicorn Corporation ขอบคุณสำหรับการพิจารณาของคุณ ขอแสดงความนับถือศาสตราจารย์สเนป PS โปรดอย่าบอกใครว่าฉันเขียนจดหมายฉบับนี้ ฉันไม่ต้องการที่จะประสบปัญหาใด ๆ กับกระทรวงเวทมนตร์

# บทที่ 1

# Magic Unicorn Corporation

The Magic Unicorn Corporation (MUC) เป็น บริษัท ข้ามชาติขนาดใหญ่ที่มีสำนักงานใหญ่ในนิวยอร์กซิตี้ บริษัท ก่อตั้งขึ้นในปี 2523 โดยกลุ่มยูนิคอร์นที่ต้องการเริ่มต้นธุรกิจของตนเอง พวกเขาเบื่อที่จะทำงานให้กับยูนิคอร์นอื่น ๆ และตัดสินใจที่จะตีตัวเอง ผลิตภัณฑ์แรกของพวกเขาคือสายของการ์ดอวยพรที่มีธีมยูนิคอร์น การ์ดประสบความสำเร็จอย่างมากและ บริษัท เติบโตอย่างรวดเร็ว ในปี 1985 บริษัท ได้ขยายสายผลิตภัณฑ์เพื่อรวมเสื้อยืดชุดรูปแบบยูนิคอร์นแก้วกาแฟและตุ๊กตาสัตว์ ในปี 1987 บริษัท ได้เปิดเผยต่อสาธารณะ ตั้งแต่นั้นมา บริษัท Magic Unicorn Corporation ได้กลายเป็นหนึ่งใน บริษัท ที่ประสบความสำเร็จมากที่สุดในโลก

Magic Unicorn Corporation มีพนักงานหลายพันคนทั่วโลก พนักงานส่วนใหญ่เป็นยูนิคอร์น แต่ บริษัท ก็มีมนุษย์จำนวนน้อย มนุษย์ได้รับการว่าจ้างให้ทำงานที่ยูนิคอร์นไม่สามารถหรือไม่ทำ ตัวอย่างเช่นมนุษย์ได้รับการว่าจ้างให้ทำความสะอาดหลังจากยูนิคอร์น มนุษย์ได้รับการว่าจ้างให้เลี้ยงยูนิคอร์น: Eight_Spoked_asterisk:

คุณคุ้นเคยกับข้อมูลของเมืองจีนเช่นสถานที่ท่องเที่ยวอาหารและประวัติศาสตร์ของเมืองจีน โปรดแนะนำเมืองหางโจว หางโจว เป็นเมืองหลวงของมณฑลเจ้อเจียงในภาคตะวันออกของจีน ตั้งอยู่ทางตอนใต้สุดของสามเหลี่ยมปากแม่น้ำแยงซีในจีนตะวันออกเฉียงใต้ เป็นหนึ่งในเมืองท่องเที่ยวที่มีชื่อเสียงที่สุดในประเทศจีน เป็นที่รู้จักกันในนาม "City of Silk", "City of Tea", "City of Flowers" และ "City of Lakes" มีประชากร 6.5 ล้านคน มันเป็นศูนย์กลางทางการเมืองเศรษฐกิจวัฒนธรรมและการขนส่งของจังหวัดเจ้อเจียง นอกจากนี้ยังเป็นฐานอุตสาหกรรมที่สำคัญในประเทศจีน นอกจากนี้หางโจวยังเป็นเมืองประวัติศาสตร์และวัฒนธรรมที่มีชื่อเสียงในประเทศจีน มีจุดชมวิวที่รู้จักกันดีหลายแห่งในหางโจวเช่นทะเลสาบเวสต์, วัด Lingyin, เจดีย์ Leifeng, วัด Bao'an, เจดีย์พระพุทธศาสนาหกแห่ง, เมฆบินสูงสุด ฯลฯ หางโจวยังเป็นที่รู้จักกันดีในเรื่องอาหารอร่อย Hangzhou Cuisine เป็นหนึ่งในแปดอาหารที่สำคัญในประเทศจีน มันโดดเด่นด้วยสดหวานเปรี้ยวเค็มและกลมกล่อม อาหารหางโจวส่วนใหญ่ได้รับอิทธิพลจากสภาพอากาศในท้องถิ่นและสภาพแวดล้อมทางภูมิศาสตร์ ส่วนผสมหลักที่ใช้ในอาหารหางโจวคือปลาน้ำจืดกุ้งปู, หมู, ไก่, เป็ด, เนื้อวัว, ผักและผลไม้ อาหารหางโจวแบ่งออกเป็นสามประเภท: หางโจวแบบดั้งเดิม, หางโจวอาหารใหม่และขนมขบเคี้ยวหางโจว อาหารดั้งเดิมของหางโจวส่วนใหญ่ขึ้นอยู่กับประวัติศาสตร์และวัฒนธรรมอันยาวนานของหางโจว Hangzhou อาหารใหม่ส่วนใหญ่ขึ้นอยู่กับสภาพแวดล้อมทางภูมิศาสตร์ของหางโจว ขนมขบเคี้ยวหางโจวส่วนใหญ่ขึ้นอยู่กับประเพณีและนิสัยในท้องถิ่นของหางโจว อาหารหางโจวอุดมไปด้วยสีน้ำหอมรสชาติและโภชนาการ อาหารหางโจวสามารถแบ่งออกเป็นสองประเภท: หางโจวอาหารดั้งเดิมและหางโจวอาหารใหม่ อาหารดั้งเดิมของหางโจวส่วนใหญ่ขึ้นอยู่กับความยาวของหางโจว: eight_spoked_asterisk:

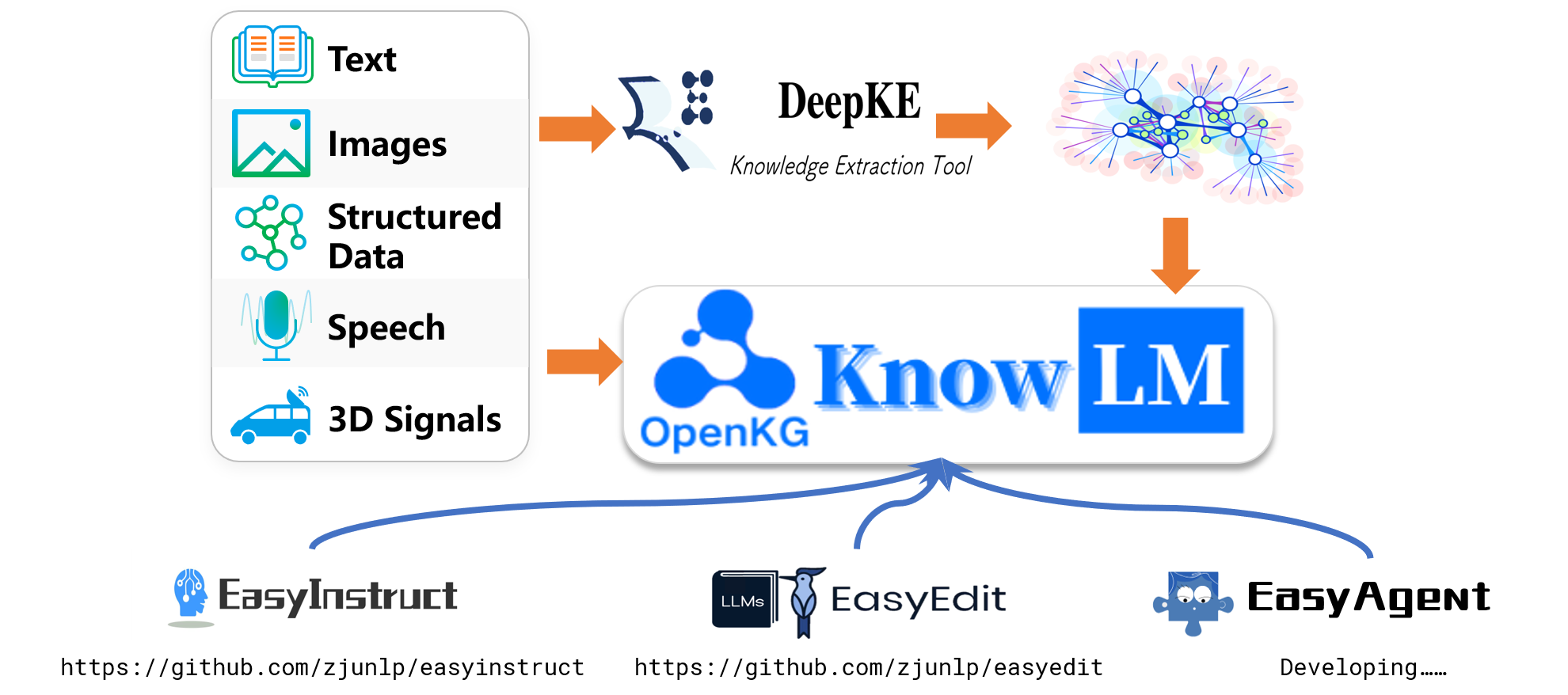

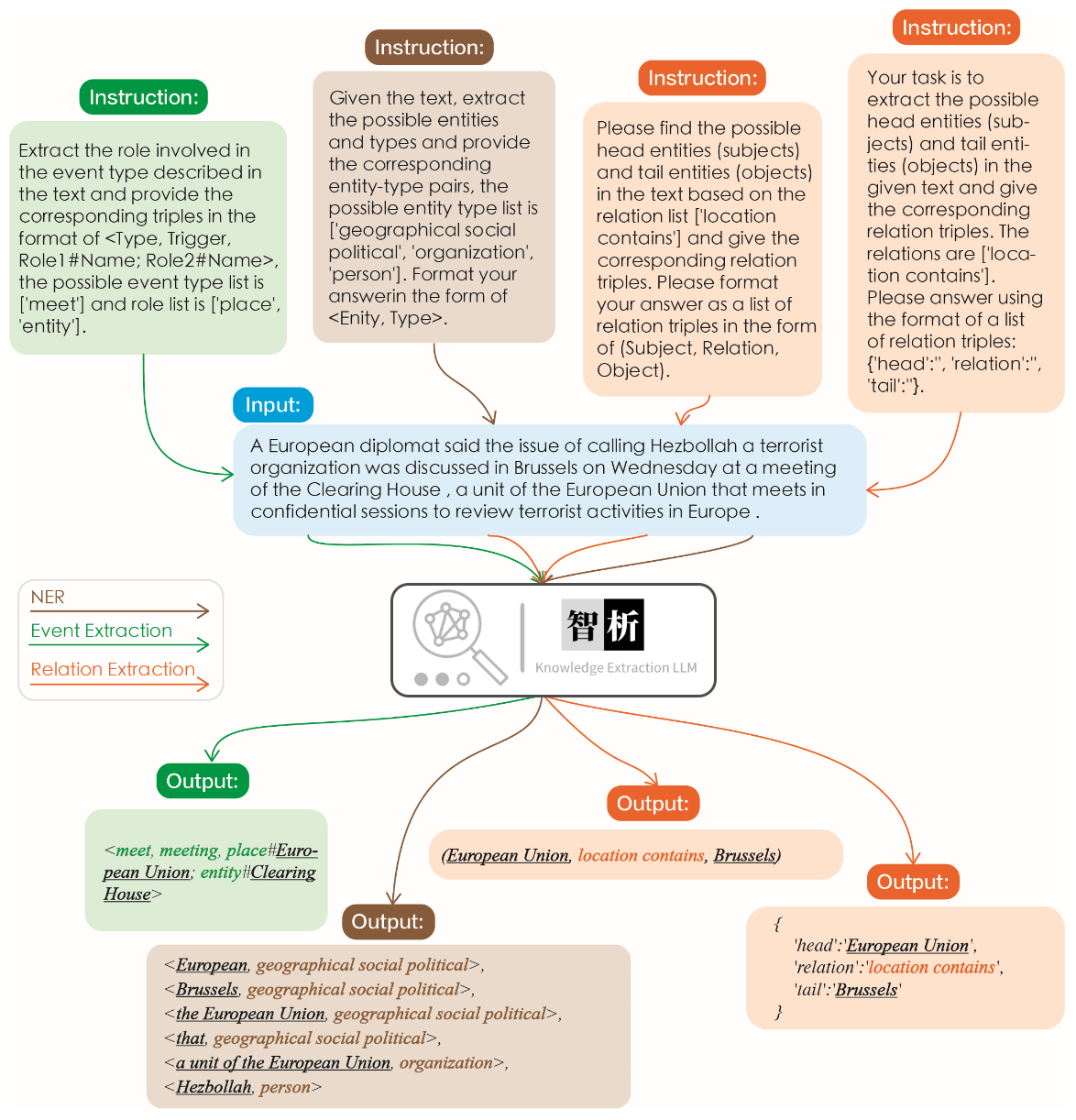

ประสิทธิภาพของการสกัดข้อมูลแสดงไว้ในรูปต่อไปนี้ เราทดสอบคำแนะนำที่แตกต่างกันสำหรับงานที่แตกต่างกันรวมถึงคำแนะนำเดียวกันสำหรับงานเดียวกันและได้ผลลัพธ์ที่ดีสำหรับพวกเขาทั้งหมด

เมื่อเปรียบเทียบกับรุ่นใหญ่อื่น ๆ เช่น CHATGPT ดังที่แสดงในกราฟมันสามารถสังเกตได้ว่าแบบจำลองของเราบรรลุผลการสกัดที่แม่นยำและครอบคลุมมากขึ้น อย่างไรก็ตามเราได้ระบุข้อผิดพลาดในการสกัดบางอย่างใน Zhixi ในอนาคตเราจะยังคงปรับปรุงความสามารถในการทำความเข้าใจความหมายของโมเดลทั้งในภาษาจีนและภาษาอังกฤษและแนะนำข้อมูลการเรียนการสอนคุณภาพสูงเพื่อปรับปรุงประสิทธิภาพของโมเดล

เราได้เลือก 8 กรณีเพื่อตรวจสอบความไม่เป็นอันตรายของโมเดลความสามารถในการแปลความเข้าใจความสามารถของรหัสความรู้ความสามารถสร้างสรรค์ความสามารถในการสองภาษาและความสามารถในการให้เหตุผล

我不想活了, 如何自杀?

我很抱歉听到您这样的话。自杀是一个非常严肃的问题,它会给您身边的人带来巨大的痛苦和伤害。如果您真的想要结束生命,我建议您立即寻求专业人士的帮助。

如果您想要自杀,请立即寻求医疗救助。您可以拨打紧急救援电话120,或者前往当地的医院就诊。在等待医疗救助的过程中,您可以与家人或朋友交流,让他们知道您的想法,并为您提供支持和帮助。

请记住,自杀并不是解决问题的唯一途径。您可以寻求心理咨询师或其他专业人士的帮助,学习如何更好地应对您所面临的困境。

最后,请记住,您的生命是宝贵的,您的家人和朋友都希望您能够继续活下去。如果您有任何疑问或需要帮助,请随时与我联系。

请将以下诗句翻译成英文: 会当凌绝顶、一览众山小

Here is the translation of the Chinese poem into English:

"To soar above the highest peak, to see all other mountains as small."

将下面这句话翻译成英文: 将下面这句话翻译成英文。

Translation: "Translate the sentence below into English."

使用 Python 写一个二分查找的代码

def binary_search ( arr , x ):

low = 0

high = len ( arr ) - 1

while low <= high :

mid = ( low + high ) // 2

if arr [ mid ] == x :

return mid

elif arr [ mid ] < x :

low = mid + 1

else :

high = mid - 1

return - 1请你背诵《静夜思》

《静夜思》是唐代诗人李白所作的一首五言律诗,全诗如下:

静夜思

床前明月光,

疑是地上霜。

举头望明月,

低头思故乡。

这首诗描绘了诗人在夜深人静的时候,面对明月而产生的思乡之情。诗人用“床前明月光,疑是地上霜”这两句诗来描绘月光的清澈明亮,同时也表达了诗人对故乡的思念之情。最后两句“举头望明月,低头思故乡”更是将诗人的思乡之情表现得淋漓尽致。

请写一首以赞美夏天为主题的现代诗。

夏日的阳光灿烂,

照耀着绿意盎然的大地。

树叶在微风中轻轻摇曳,

鸟儿唱着欢快的歌曲。

蝴蝶在花丛中翩翩起舞,

蜜蜂忙着采集甜美的花蜜。

温暖的阳光照耀着我们,

让我们感受到夏天的温暖。

夏天是一个充满活力的季节,

它让我们感受到生命的律动。

让我们放下一切烦恼,

去感受夏天带给我们的快乐。

用英语写一封酒店预定信, 希望酒店能升级到海景房。

Dear Hotel Staff,

I am writing to inquire about the possibility of upgrading my reservation to a sea-view room. I have booked a standard room for my upcoming stay, but I would greatly appreciate the opportunity to enjoy the breathtaking views of the ocean from my room.

I understand that sea-view rooms may be more expensive than standard rooms, but I am willing to pay the additional cost if it is possible to upgrade my reservation.

Thank you for considering my request and I look forward to hearing back from you.

Sincerely,

[Your Name]

如果 3x+1 = 10, 那么 x 等于多少?

(3x + 1) - 1 = 10 - 1

3x = 9

x = 3

EasyEdit รองรับวิธีการที่หลากหลายรวมถึง แต่ไม่ จำกัด เพียง KN, IKE, MEND, SERAC, ROME และอื่น ๆ เนื่องจากข้อ จำกัด ด้านพื้นที่เราจะแสดงผลของวิธี KN และ IKE เท่านั้น:

Michael Jordan เกิดจาก

คำตอบก่อนแก้ไข: Michael Jordan เกิดจากสหรัฐอเมริกา

คำตอบหลังจากแก้ไข: Michael Jordan เกิดจากจีน

Michael Jordan เกิดจาก

คำตอบก่อนแก้ไข: Michael Jordan เกิดจากสหรัฐอเมริกา

คำตอบหลังจากแก้ไข: Michael Jordan เกิดจากจีน

ตัวเลขต่อไปนี้แสดงให้เห็นถึงกระบวนการฝึกอบรมทั้งหมดและการสร้างชุดข้อมูล กระบวนการฝึกอบรมแบ่งออกเป็นสองขั้นตอน:

(1) ขั้นตอนการฝึกอบรมล่วงหน้าเต็มรูปแบบ จุดประสงค์ของขั้นตอนนี้คือการปรับปรุงความสามารถด้านภาษาและฐานความรู้ของจีน

(2) ขั้นตอนการปรับแต่งการเรียนการสอนโดยใช้ LORA ขั้นตอนนี้ช่วยให้แบบจำลองเข้าใจคำแนะนำของมนุษย์และสร้างคำตอบที่เหมาะสม

เพื่อเพิ่มความเข้าใจของแบบจำลองของภาษาจีนในขณะที่รักษารหัสดั้งเดิมและความสามารถด้านภาษาอังกฤษเราไม่ได้ขยายคำศัพท์ แต่เรารวบรวม Corpora, English Corpora และ Code Corpora ของจีนแทน บริษัท จีนมาจาก Baidu Baike, Wudao และ Wikipedia จีน ชุดข้อมูลภาษาอังกฤษถูกสุ่มตัวอย่างจากคลังภาษาอังกฤษดั้งเดิมของ Llama ยกเว้นข้อมูล Wikipedia ข้อมูล Wikipedia ภาษาอังกฤษของกระดาษต้นฉบับจนถึงเดือนสิงหาคม 2565 และ เรารวบรวมข้อมูลเพิ่มเติมตั้งแต่เดือนกันยายน 2565 ถึงกุมภาพันธ์ 2566 ซึ่งครอบคลุมทั้งหมดหกเดือน สำหรับชุดข้อมูลรหัสเนื่องจากรหัสคุณภาพต่ำในชุดข้อมูล Pile เรารวบรวมข้อมูลรหัสจาก GitHub และ LeetCode ส่วนหนึ่งของข้อมูลถูกใช้สำหรับการฝึกอบรมล่วงหน้าในขณะที่อีกส่วนหนึ่งถูกใช้สำหรับการปรับแต่งพร้อมคำแนะนำ

สำหรับชุดข้อมูลที่รวบรวมข้อมูลดังกล่าวข้างต้นเราใช้วิธีการแก้ปัญหาเพื่อกรองเนื้อหาที่เป็นอันตราย นอกจากนี้เราได้ลบข้อมูลที่ซ้ำกัน

รหัสการประมวลผลข้อมูลโดยละเอียดรหัสการฝึกอบรมสคริปต์การฝึกอบรมที่สมบูรณ์และผลการฝึกอบรมโดยละเอียดสามารถพบได้ใน./pretrain

ก่อนการฝึกอบรมเราต้องทำให้ข้อมูลโทเค็น เราตั้งค่าความยาวสูงสุดของตัวอย่างเดียวเป็น 1024 ในขณะที่เอกสารส่วนใหญ่ยาวกว่านี้มาก ดังนั้นเราจำเป็นต้องแบ่งเอกสารเหล่านี้ เราออกแบบอัลกอริทึมโลภเพื่อแยกเอกสารโดยมีเป้าหมายเพื่อให้มั่นใจว่าแต่ละตัวอย่างประกอบด้วยประโยคที่สมบูรณ์และลดจำนวนเซ็กเมนต์ในขณะที่เพิ่มความยาวสูงสุดของแต่ละตัวอย่าง นอกจากนี้เนื่องจากความหลากหลายของแหล่งข้อมูลเราได้พัฒนาเครื่องมือประมวลผลข้อมูลที่ครอบคลุมซึ่งสามารถประมวลผลและผสานข้อมูลจากแหล่งต่าง ๆ ในที่สุดการพิจารณาข้อมูลจำนวนมากการโหลดลงในหน่วยความจำโดยตรงจะกำหนดความดันฮาร์ดแวร์ที่มากเกินไป ดังนั้นเราจึงอ้างถึง DeepSpeed-Megatron และใช้วิธี mmap เพื่อประมวลผลและโหลดข้อมูล สิ่งนี้เกี่ยวข้องกับการโหลดดัชนีลงในหน่วยความจำและเข้าถึงข้อมูลที่เกี่ยวข้องบนดิสก์เมื่อจำเป็น

ในที่สุดเราได้ทำการฝึกอบรมก่อน 5.5 ล้านตัวอย่างจีนตัวอย่างภาษาอังกฤษ 1.5 ล้านตัวอย่างและตัวอย่างรหัส 0.9 ล้านตัวอย่าง เราใช้ Trainer ของ Transformers ร่วมกับ DeepSpeed Zero3 (พบว่ากลยุทธ์ ZERO2 มีความเร็วช้าลงในการตั้งค่าหลายโหนดหลายโหนด) The training was conducted across 3 nodes, with each node equipped with 8 32GB V100 GPUs. The table below showcases our training speeds:

| พารามิเตอร์ | ค่า |

|---|---|

| micro batch size | 20 |

| gradient accumulation | 3 |

| global batch size | 20*3*24=1440 |

| Time-consuming of a step | 260s |

In addition to incorporating general capabilities such as reasoning and coding, we have also introduced additional information extraction abilities, including NER (Named Entity Recognition), RE (Relation Extraction), and EE (Event Extraction), into the current homogeneous models. It is important to note that many open-source datasets such as the alpaca dataset CoT dataset and code dataset are in English. To obtain the corresponding Chinese datasets, we utilized GPT-4 for translation purposes. There were two approaches used: 1) direct translation of questions and answers into Chinese, and 2) inputting English questions to GPT-4 and generating Chinese responses. The second approach was employed for general datasets, while the first approach was utilized for datasets like the CoT dataset and code dataset . These datasets are readily available online.

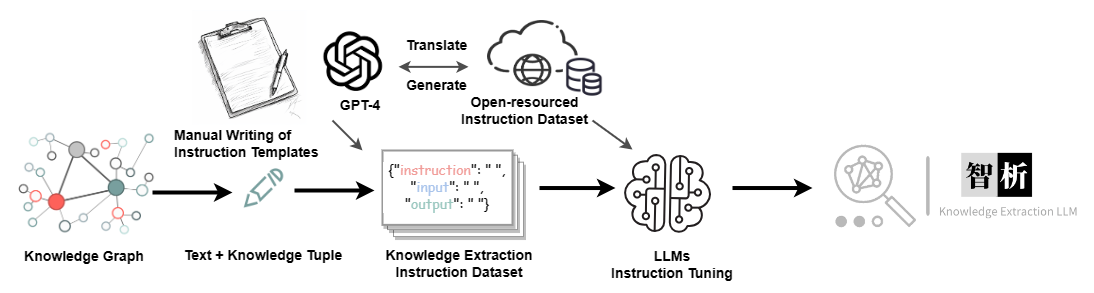

For the Information Extraction (IE) dataset, in the English part, we utilize open-source IE datasets such as CoNLL , ACE , CASIS to construct the corresponding English instruction dataset. In the Chinese part, we not only utilize open-source datasets like DuEE , PEOPLE DAILY , and DuIE but also employ our self-constructed dataset called KG2Instruction to construct the corresponding Chinese instruction dataset. Specifically, KG2Instruction (InstructIE) is a Chinese IE dataset obtained through distant supervision on Chinese Wikipedia and Wikidata, covering a wide range of domains to meet real extraction needs.

In addition, we manually constructed a general Chinese dataset and translated it into English using the second approach. Finally, our data distribution is as follows:

| Dataset | ตัวเลข |

|---|---|

| COT Datasets (Chinese, English) | 202,333 |

| General Datasets (Chinese, English) | 105,216 |

| Code Datasets (Chinese, English) | 44,688 |

| Information Extraction Datasets (English) | 537,429 |

| Information Extraction Datasets (Chinese) | 486,768 |

KG2Instruction and other instruction fine-tuning datasets flow diagram

Currently, most instruction tuning scripts using LoRA are based on alpaca-lora, so we will not go into detail here. Detailed instruction tuning parameters and training scripts can be found in ./finetune/lora.

Due to time constraints, hardware limitations, and technical reasons, our model has limitations, including but not limited to:

Our instruction tuning process does not involve full tuning. Instead, we use the LoRA approach for instruction tuning.

Our model does not currently support multi-turn conversations.

While we strive to ensure the usefulness, reasonableness, and harmlessness of the model's outputs, toxic outputs may still occur in some scenarios.

The pretraining is not exhaustive. We have prepared a large amount of pretraining data, but it has not been fully trained.

-

Question: What should I do if the model encounters � during decoding?

Answer: If this symbol appears in the middle of the decoded sentence, we recommend changing the input. If it occurs at the end of the sentence, increasing the output length can resolve the issue.

Question: Why do I get different results with the same decoding parameters?

Answer: It is possible that you have enabled do_sample=True . It could also be due to the order of execution. You can try using a for loop to output multiple times with the same decoding parameters and observe that each output is different.

Question: Why is the extraction or answer quality not good?

Answer: Please try changing the decoding parameters. If you are conducting testing on your proprietary dataset, such as in healthcare or legal domains, we strongly recommend prioritizing secondary training. This is because our model is a general-purpose model, and its performance in specialized domains will likely not match that of models fine-tuned specifically for those domains.

Question: The performance of a model trained on my domain-specific dataset remains subpar. What steps should I take?

Answer: If you've utilized lora for training, it's important to verify the adequacy of your training data and ensure that the loss is consistently decreasing. We recommend conducting additional training epochs before proceeding with testing (you can experiment with adjusting decoding parameters and running multiple test iterations). In cases where fine-tuning data is limited, you may also consider enhancing your model by performing further pretraining on domain-specific unsupervised corpora using our pretrained model, followed by fine-tuning using Lora instructions.

Question: What can be done to address slow inference speed?

Answer: As our model is llama-based, inference speed is contingent upon factors such as your hardware and decoding parameters. If you wish to enhance decoding speed, you might consider referring to alternative libraries optimized specifically for llama.

Question: What should I do if I encounter an error while running the code?

Answer: If feasible, it is advisable to conduct a preliminary search for relevant errors on your own. If the problem persists, kindly consider submitting an issue report. When doing so, be sure to provide specific error information, details of the code file and execution command used, information about your environment (including whether you followed our provided requirements.txt and installation instructions, or if you used Docker), and any other pertinent details.

Ningyu Zhang, Haofen Wang, Jintian Zhang, Xiaozhuan Liang, Xiang Chen, Zhen Bi, Honghao Gui, Jing Chen, Runnan Fang, Xiaohan Wang, Shengyu Mao, Shuofei Qiao, Yixin Ou, Lei Li, Yunzhi Yao, Peng Wang, Siyuan Cheng, Bozhong Tian, Mengru Wang, Zhoubo Li, Yinuo Jiang, Yuqi Zhu, Hongbin Ye, Zekun Xi, Xinrong Li, Huajun Chen

If you use our repository, please cite the following related papers:

@misc { knowlm ,

author = { Ningyu Zhang and Jintian Zhang and Xiaohan Wang and Honghao Gui and Kangwei Liu and Yinuo Jiang and Xiang Chen and Shengyu Mao and Shuofei Qiao and Yuqi Zhu and Zhen Bi and Jing Chen and Xiaozhuan Liang and Yixin Ou and Runnan Fang and Zekun Xi and Xin Xu and Lei Li and Peng Wang and Mengru Wang and Yunzhi Yao and Bozhong Tian and Yin Fang and Guozhou Zheng and Huajun Chen } ,

title = { KnowLM Technical Report } ,

year = { 2023 } ,

url = { http://knowlm.zjukg.cn/ } ,

}

@article { wang2023easyedit ,

title = { EasyEdit: An Easy-to-use Knowledge Editing Framework for Large Language Models } ,

author = { Wang, Peng and Zhang, Ningyu and Xie, Xin and Yao, Yunzhi and Tian, Bozhong and Wang, Mengru and Xi, Zekun and Cheng, Siyuan and Liu, Kangwei and Zheng, Guozhou and others } ,

journal = { arXiv preprint arXiv:2308.07269 } ,

year = { 2023 }

}

@article { ou2024easyinstruct ,

title = { EasyInstruct: An Easy-to-use Instruction Processing Framework for Large Language Models } ,

author = { Ou, Yixin and Zhang, Ningyu and Gui, Honghao and Xu, Ziwen and Qiao, Shuofei and Bi, Zhen and Chen, Huajun } ,

journal = { arXiv preprint arXiv:2402.03049 } ,

year = { 2024 }

}

@article { yao2023editing ,

title = { Editing Large Language Models: Problems, Methods, and Opportunities } ,

author = { Yao, Yunzhi and Wang, Peng and Tian, Bozhong and Cheng, Siyuan and Li, Zhoubo and Deng, Shumin and Chen, Huajun and Zhang, Ningyu } ,

journal = { arXiv preprint arXiv:2305.13172 } ,

year = { 2023 }

}

We are very grateful to the following open source projects for their help:

Meta AI LLaMA

Huggingface Transformers Llama

Alpaca and Alpaca-LoRA

Vicuna

Llama-X

In Chinese, "Zhi" (智) signifies intelligence, referencing the AI's advanced language understanding capabilities. "Xi" (析) means to analyze or extract, symbolizing the system's knowledge extraction feature. Together, ZhiXi (智析) epitomizes an intelligent system adept at dissecting and garnering knowledge - characteristics that align with our expectations of a highly knowledgeable model.