การตรวจจับข้อความที่สร้างขึ้นจากแบบจำลองภาษาขนาดใหญ่ (เช่น GPT-2)

หน้าเว็บ: http://gltr.io

online-demo: http://gltr.io/dist/index.html

กระดาษ: https://arxiv.org/abs/1906.04043

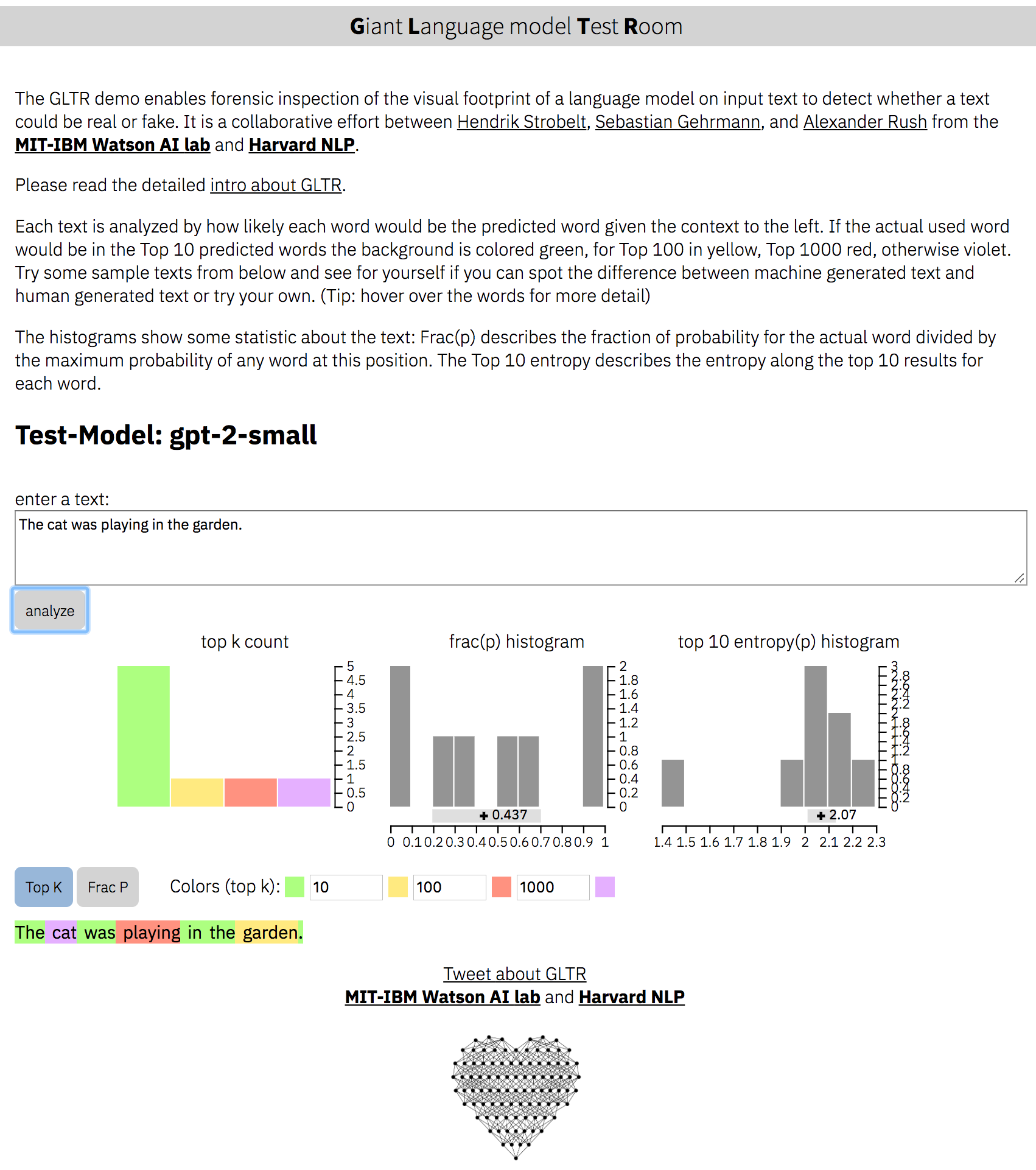

โครงการโดย Hendrik Strobelt, Sebastian Gehrmann, Alexander M. Rush

ความร่วมมือของ MIT-IBM Watson AI Lab และ Harvardnlp

ติดตั้งการอ้างอิงสำหรับ Python> 3.6:

pip install -r requirements.txt เรียกใช้เซิร์ฟเวอร์สำหรับ gpt-2-small :

python server.py

อินสแตนซ์ตัวอย่างทำงานได้ที่ http: // localhost: 5001/client/index.html

เริ่มต้นเซิร์ฟเวอร์สำหรับ BERT :

python server.py --model BERT อินสแตนซ์ทำงานตอนนี้ที่ http: // localhost: 5001/client/index.html? nodemo คำแนะนำ: เราให้ข้อความสาธิตสำหรับ gpt2-small เท่านั้น

usage: server.py [-h] [--model MODEL] [--nodebug NODEBUG] [--address ADDRESS]

[--port PORT] [--nocache NOCACHE] [--dir DIR] [--no_cors]

optional arguments:

-h, --help show this help message and exit

--model MODEL choose either 'gpt-2-small' (default) or 'BERT' or your own

--nodebug NODEBUG server in non-debugging mode

--port PORT port to launch UI and API (default:5001)

--no_cors launch API without CORS support (default: False)

แบ็กเอนด์กำหนดจำนวนของรุ่น API ที่สามารถเรียกใช้โดยเซิร์ฟเวอร์โดยเริ่มต้นด้วย --model NAME ในการเพิ่มโมเดลที่กำหนดเองคุณต้องเขียน API ของคุณเองใน backend/api.py และเพิ่ม Decorator @register_api(name=NAME)

API แต่ละตัวจะต้องเป็นคลาสที่สืบทอดมาจาก AbstractLanguageChecker ซึ่งกำหนดฟังก์ชั่นสองฟังก์ชั่น check_probabilities และ postprocess โปรดติดตามเอกสารประกอบภายใน api.py เมื่อใช้คลาสและฟังก์ชั่น

ซอร์สโค้ดสำหรับส่วนหน้าอยู่ใน client/src

ในการแก้ไขจำเป็นต้องมีการติดตั้งการพึ่งพาโหนด:

cd client/src ; npm install ; cd ../..การคอมไพล์ใหม่ของ front-end:

> rm -rf client/dist ; cd client/src/ ; npm run build ; cd ../..Apache 2

(c) 2019 โดย Hendrik Strobelt, Sebastian Gehrmann, Alexander M. Rush