Шанхайская лабораторная команда AI открыла источник версии Llama Project O1, которая является проектом реплики с открытым исходным кодом для инструмента Openai Olympiad для решения проблем O1. В проекте используются передовые технологии, такие как Monte Carlo Tree Search и обучение подкреплению, для достижения замечательных результатов в ответе на вопросы математической олимпиады, и его производительность даже превышает результаты некоторых коммерческих решений с закрытым источником. Открытый источник проекта предоставляет разработчикам ценные учебные ресурсы и исследовательский фонд, а также способствует дальнейшему развитию применения искусственного интеллекта в области математики. Этот проект включает в себя предварительно обученные наборы данных, предварительно обученные модели и подкрепление кодов обучения и т. Д., И также использует различные технологии оптимизации, включая LORA и PPO, направленные на улучшение способности модели в математических рассуждениях.

Недавно команда Shanghai AI Lab выпустила версию проекта O1 LLAMA, направленную на то, чтобы воспроизвести Openai о олимпиадском инструменте решения проблем O1. Проект принимает множество передовых технологий, в том числе поиск дерева Монте-Карло, обучение самоуправлению, PPO и парадигма двойной стратегии Alphago Zero, которая привлекла широкое внимание сообщества разработчиков.

Задолго до выхода серии O1 Operai, команда Shanghai AI Lab начала исследовать использование поиска Tree Monte Carlo для улучшения математической способности крупных моделей. После выпуска O1 команда еще больше улучшила алгоритм, сосредоточилась на проблеме по математической олимпиаде и разработала его как версию открытого костюма The Openai Strawberry Project.

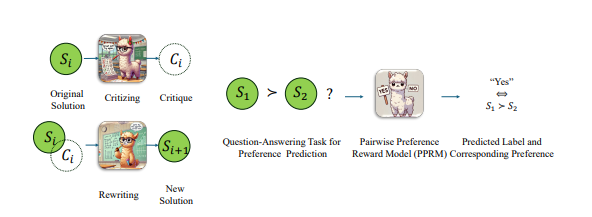

Чтобы улучшить производительность модели Llama в задачах математической олимпиады, команда приняла стратегию парной оптимизации, то есть не дает абсолютной оценки ответа, а скорее сравнила относительные преимущества и недостатки двух ответов. С таким подходом они добились значительного прогресса в самых сложных показателях AIME2024. Среди 30 тестовых вопросов оптимизированная модель была выполнена правильно 8, в то время как оригинальная модель Llama-3.1-8B-фактор была выполнена правильно 2. Это достижение превосходит другие коммерческие решения с закрытым исходным кодом, помимо O1-Preview и O1-Mini.

В конце октября команда объявила о значительном прогрессе в воспроизведении OpenAI O1 на основе архитектуры Alphago Zero, что успешно позволила модели получить способность к расширенному мышлению посредством взаимодействия с деревом поиска во время учебного процесса без ручной аннотации. Менее чем через неделю проект был открыт.

В настоящее время контент с открытым исходным кодом в LLAMA версии O1 включает в себя: предварительно обученные наборы данных, предварительно обученные модели и код обучения подкреплению. Среди них, набор данных «OpenLongCot-Pretrain» содержит более 100 000 давних данных о мышлении, каждая данных содержит полный процесс рассуждения по математической задаче, включая мышление, результаты оценки, описание проблем, координаты графика, процесс расчета, вывод и другие Полные ссылки на вывод, а также критика и проверка каждого шага вывода, обеспечивают оценку и руководство для процесса вывода. После продолжения предварительной тренировки в этом наборе данных модель может читать и выводить длинные процессы мышления, такие как O1.

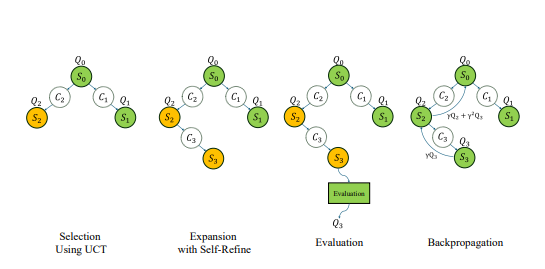

Хотя проект называется Llama-O1, предварительно обученная модель, предоставленная официальным лицом, основана на Google Gemma2. Основываясь на предварительно обученной модели, разработчики могут продолжать проводить обучение подкреплению. Процесс обучения включает в себя: Использование Поиск самопроизводительности Монте-Карло для создания опыта в буфере воспроизведения приоритетов; Некоторые ключевые технологии также используются в учебном коде, включая использование LORA для эффективной точной настройки параметров с использованием алгоритма PPO в качестве метода оптимизации стратегии, реализации алгоритма GAE для расчета выгодных функций и использования воспроизведения приоритетного опыта для повышения эффективности обучения.

Стоит отметить, что код Llama-O1 был опубликован в рамках учетной записи Github под названием SimpleBerry. Из других учетных записей, связанных с простыми, и официальной информации о веб-сайте можно увидеть только, что его природа является исследовательской лабораторией, но больше информации о направлении исследования не раскрывается.

В дополнение к Llama-O1, другой публичный проект O1 Replica-O1-Journey из университетской команды Шанхай Цзяотонг. Команда опубликовала свой первый отчет о прогрессе в начале октября, представив инновационную парадигму обучения путешествий и первую модель, которая успешно интегрировала поиск и обучение в математические рассуждения. Основная команда по развитию O1-Journey в основном состоит из младших и старших студентов в Университете Шанхайского Цзиотона, а также для первокурсников из лаборатории GAIR Laboratory (Общая исследовательская лаборатория искусственного интеллекта). в Университете Шанхая Джиатонг.

Бумажный адрес: https://arxiv.org/pdf/2410.02884

https://arxiv.org/pdf/2406.07394

Открытый источник проекта Llama Version O1 отмечает важный прогресс в области решения проблем математики искусственного интеллекта, а также обеспечивает прочную основу для дальнейших исследований и применения. Мы с нетерпением ждем более инновационных достижений на основе этого проекта в будущем.