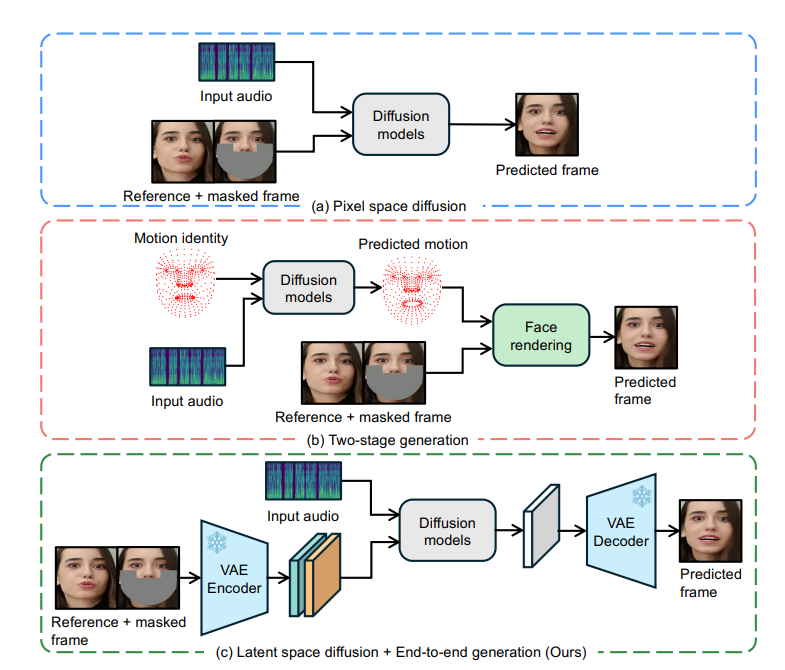

ByteDance открыла исходный код инновационной технологии синхронизации губ под названием LatentSync, которая основана на модели скрытой диффузии звуковых условий и обеспечивает точную синхронизацию движений губ персонажа в видео со звуком. Он напрямую использует возможности стабильной диффузии без необходимости промежуточного представления движения, эффективно моделирует сложные аудиовизуальные ассоциации и повышает временную согласованность с помощью технологии выравнивания временного представления (TREPA). LatentSync также оптимизирует проблему конвергенции SyncNet и значительно повышает точность синхронизации губ. Эта технология имеет значительные преимущества в сквозной структуре, высококачественной генерации, временной согласованности и оптимизации SyncNet, предоставляя новое решение для портретной анимации, управляемой звуком.

Было обнаружено, что методы синхронизации губ на основе диффузии плохо работают с точки зрения временной согласованности из-за несогласованности процесса диффузии между различными кадрами. Чтобы решить эту проблему, LatentSync представляет технологию выравнивания представления времени (TREPA). TREPA использует временные представления, извлеченные из больших видеомоделей с самоконтролем, для согласования сгенерированных кадров с реальными кадрами, тем самым улучшая временную согласованность, сохраняя при этом точность синхронизации губ.

Кроме того, исследовательская группа также провела углубленное изучение проблемы конвергенции SyncNet и посредством большого количества эмпирических исследований определила ключевые факторы, влияющие на конвергенцию SyncNet, включая архитектуру модели, обучающие гиперпараметры и методы предварительной обработки данных. За счет оптимизации этих факторов точность SyncNet на тестовом наборе HDTF значительно повышается с 91% до 94%. Поскольку общая структура обучения SyncNet не изменилась, этот опыт также можно применить к другим методам синхронизации губ и портретной анимации на основе звука, использующим SyncNet.

Преимущества LatentSync

Комплексная структура: генерация синхронизированных движений губ непосредственно из аудио без промежуточного представления движений.

Генерация высокого качества. Используйте мощные возможности Stable Diffusion для создания динамичных и реалистичных видеороликов с выступлениями.

Временная согласованность: улучшите временную согласованность между видеокадрами с помощью технологии TREPA.

Оптимизация SyncNet: решите проблему конвергенции SyncNet и значительно улучшите точность синхронизации губ.

Принцип работы

Ядро LatentSync основано на технологии восстановления изображений, которая требует ввода замаскированного изображения в качестве эталона. Чтобы интегрировать визуальные особенности лица из исходного видео, модель также вводит эталонные изображения. После объединения каналов эта входная информация вводится в сеть U-Net для обработки.

Модель использует предварительно обученный экстрактор аудио-функций Whisper для извлечения вложений аудио. На движения губ может влиять звук окружающих кадров, поэтому модель объединяет звук нескольких окружающих кадров в качестве входных данных, чтобы предоставить больше временной информации. Эмбедирование аудио интегрируется в U-Net через уровни перекрестного внимания.

Чтобы решить проблему, связанную с тем, что SyncNet требует ввода пространства изображений, модель сначала выполняет прогнозирование в зашумленном пространстве, а затем получает расчетное чистое скрытое пространство с помощью одношагового метода. Исследование показало, что обучение SyncNet в пространстве пикселей лучше, чем обучение в скрытом пространстве, что может быть связано с тем, что информация об области губ теряется во время кодирования VAE.

Процесс обучения разделен на два этапа: на первом этапе U-Net изучает визуальные особенности без декодирования пространства пикселей и добавляет потери SyncNet. На втором этапе добавляются потери SyncNet с использованием метода контроля пространства декодированных пикселей и используются потери LPIPS для улучшения визуального качества изображения. Чтобы гарантировать, что модель правильно изучает временную информацию, входной шум также должен быть согласованным во времени, и модель использует модель смешанного шума. Кроме того, на этапе предварительной обработки данных также используется аффинное преобразование для достижения фронтализации лица.

Технология ТРЕПА

TREPA улучшает временную согласованность путем выравнивания временных представлений сгенерированных и реальных последовательностей изображений. Этот метод использует крупномасштабную видеомодель с самоконтролем VideoMAE-v2 для извлечения временных представлений. В отличие от методов, которые используют только потерю расстояния между изображениями, временное представление может фиксировать временные корреляции в последовательностях изображений, тем самым улучшая общую временную согласованность. Исследования показали, что TREPA не только не ухудшает точность синхронизации губ, но и может ее улучшить.

Проблемы конвергенции SyncNet

Исследования показали, что потери на обучение SyncNet имеют тенденцию оставаться на уровне около 0,69 и не могут быть уменьшены дальше. Благодаря обширному экспериментальному анализу исследовательская группа обнаружила, что размер пакета, количество входных кадров и метод предварительной обработки данных оказывают существенное влияние на конвергенцию SyncNet. Архитектура модели также влияет на конвергенцию, но в меньшей степени.

Результаты экспериментов показывают, что LatentSync превосходит другие современные методы синхронизации губ по множеству показателей. Особенно с точки зрения точности синхронизации губ благодаря оптимизированному SyncNet и слою перекрестного внимания к звуку, который может лучше улавливать взаимосвязь между звуком и движениями губ. Кроме того, благодаря технологии TREPA значительно улучшена согласованность времени LatentSync.

Адрес проекта: https://github.com/bytedance/LatentSync

Открытый исходный код LatentSync принес новые прорывы в разработке технологии синхронизации губ. Ее эффективная, точная работа и оптимизированные методы обучения достойны исследования и применения. Ожидается, что в будущем эта технология будет играть более важную роль в производстве видео, виртуальной реальности и других областях.