[Веб -сайт] • [бумага] • [? Модели HF] • [? GitHub]

[? Twitter] • [reddit] • [? Неофициальный блог]

Репо для «Tora: агент рассуждений, интегрированный инструмент для решения математических проблем» [ICLR'2024]

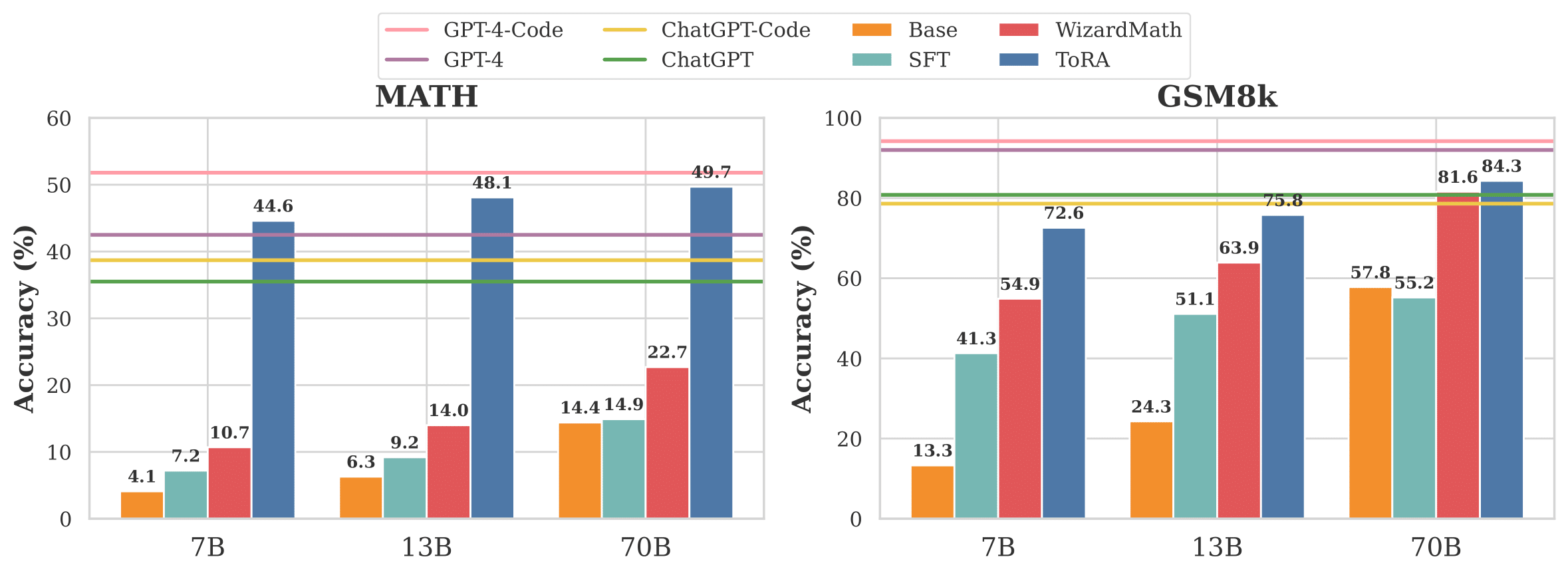

Рисунок 1: Сравнение торы с базовыми показателями на базовых моделях Llama-2 от 7b до 70b.

Tora-это серия интегрированных инструментов агентов, предназначенных для решения сложных задач математических рассуждений путем взаимодействия с инструментами, например, библиотеками вычислений и символических решателей. Серии Tora плавно интегрируют рассуждения о естественном языке с использованием внешних инструментов, тем самым объединяя аналитическое мастерство языка и вычислительную эффективность внешних инструментов.

| Модель | Размер | GSM8K | Математика | Avg@10 математических задач † |

|---|---|---|---|---|

| GPT-4 | - | 92.0 | 42,5 | 78.3 |

| GPT-4 (PAL) | - | 94.2 | 51.8 | 86.4 |

| 7b | 68.8 | 40.1 | 62,4 | |

| 7b | 72,6 | 44,6 | 66.5 | |

| Tora-Code-7b + самосогласованность (K = 50) | 7b | 76.8 | 52,5 | - |

| 13b | 72,7 | 43,0 | 65,9 | |

| 13b | 75,8 | 48.1 | 71.3 | |

| Tora-Code-13b + самосогласованность (K = 50) | 13b | 80.4 | 55,1 | - |

| 34b | 80.7 | 51.0 | 74,8 | |

| Tora-Code-34b + самосогласованность (k = 50) | 34b | 85,1 | 60.0 | - |

| 70b | 84.3 | 49,7 | 76.9 | |

| Tora-70b + самосогласованность (k = 50) | 70b | 88.3 | 56.9 | - |

* Tora-Code-34B в настоящее время является первой и единственной моделью с открытым исходным кодом, которая достигла более 50% точности (Pass@1) в наборе данных по математике, который значительно превосходит результат GPT-4 Cot (51,0 против 42,5) и конкурирует с проблемами решения GPT-4 с программами. На открытом исходном газе наши коды и модели мы надеемся, что придет больше прорывов!

† 10 Математических задач включают GSM8K, Math, GSM-HARD, SVAMP, TABMWP, ASDIV, SINGEQ, ONULOP, ADDSUB и Multiarith.

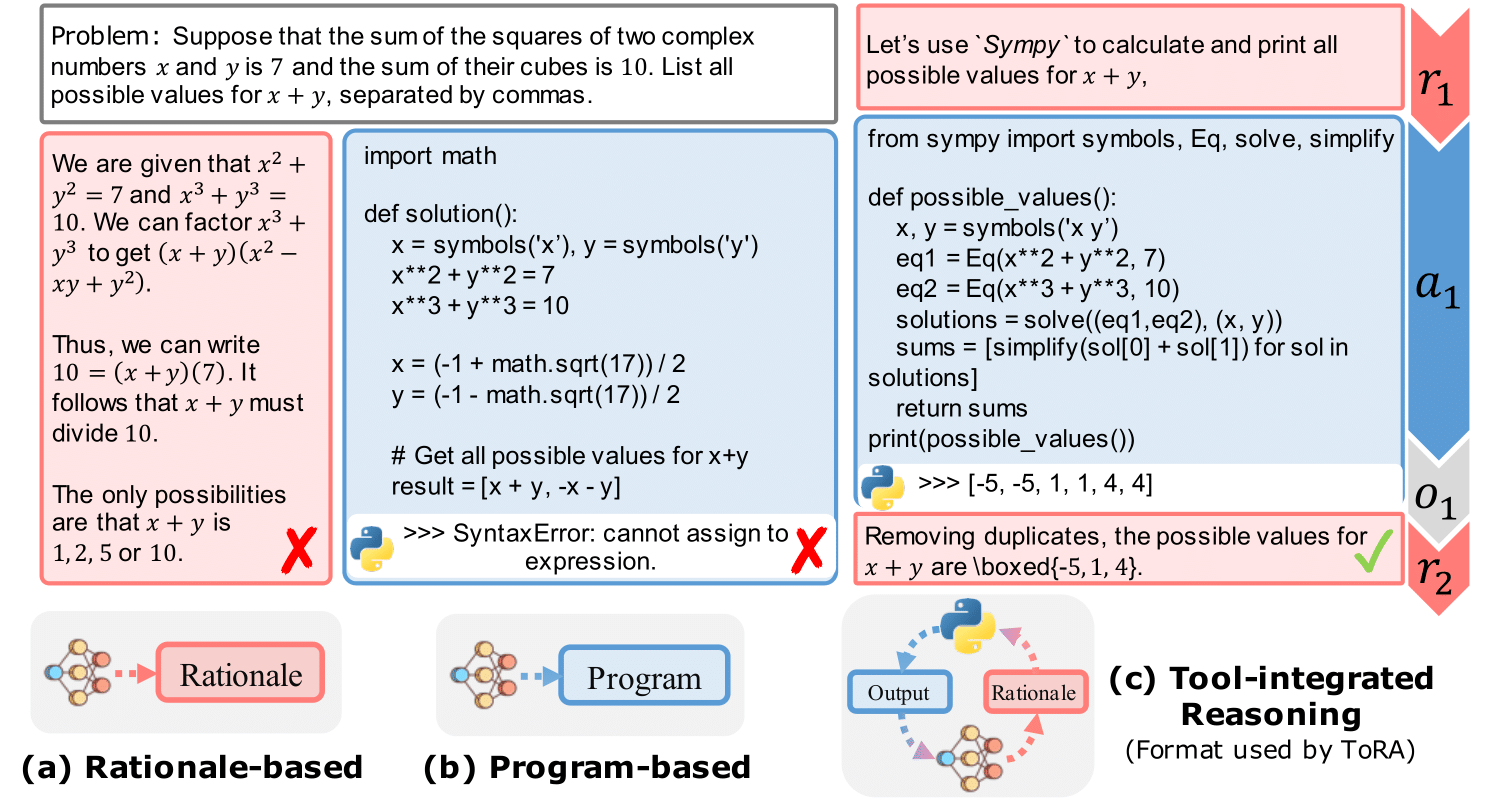

Рисунок 2: Основной пример взаимодействия инструментов с одним раундом, который отражает Rationales с использованием программ на основе программы.

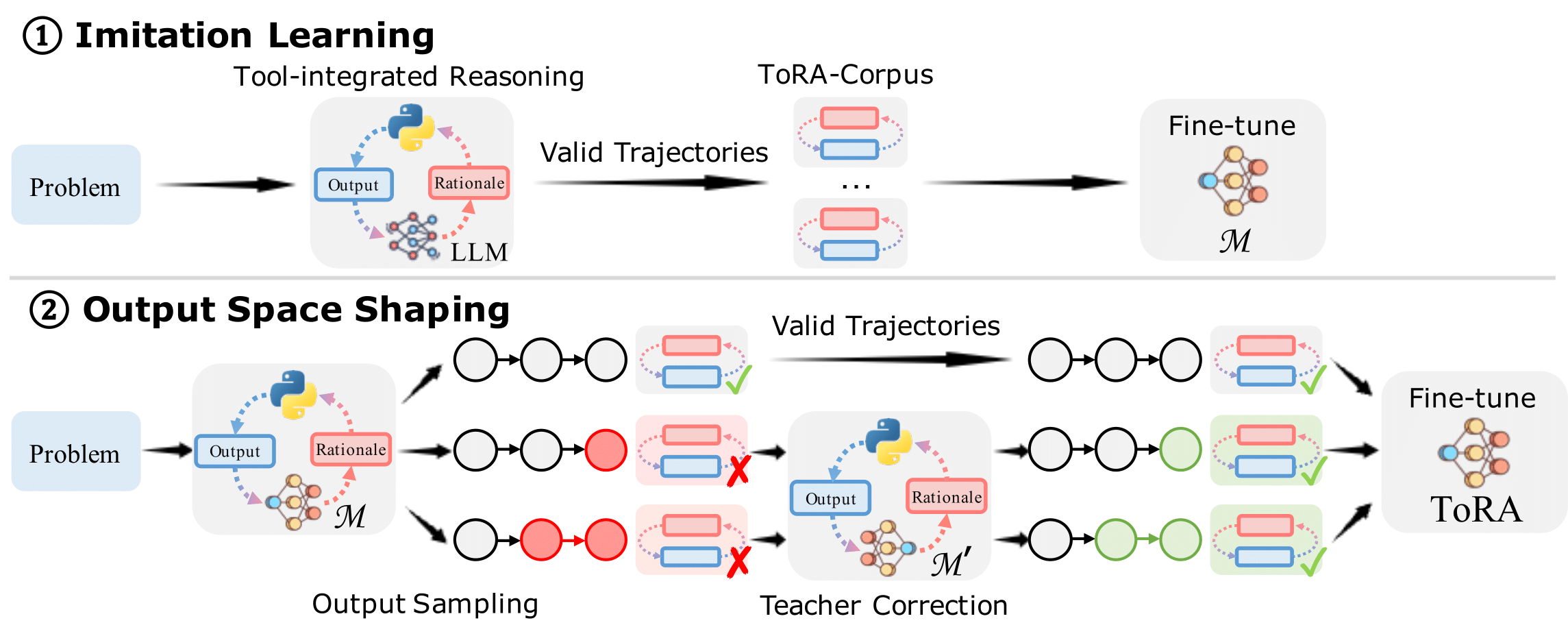

Рисунок 3: Обучение TORA содержит ① имитационное обучение и ② Выходное пространство.

Мы рекомендуем использовать Conda для управления вашей средой. Мы используем VLLM (0,1,4) для ускорения вывода. Запустите следующие команды для настройки вашей среды:

git clone https://github.com/microsoft/ToRA.git && cd ToRA/src

conda create -n tora python=3.10

conda activate tora

pip install packaging==22.0

pip install torch==2.0.1 --index-url https://download.pytorch.org/whl/cu118 # CUDA 11.8 for example

pip install -r requirements.txt Мы предоставляем скрипт для вывода, просто настройте MODEL_NAME_OR_PATH и DATA в src/scripts/anfer.sh и запустить следующую команду:

bash scritps/infer.sh Мы также открываем источник модели выходов из наших лучших моделей (Tora-Code-34b и Tora-70b) в src/outputs/ папке.

Файл src/eval/grader.py содержит логику оценки, которая оценивает точность прогнозируемого ответа, сравнивая его с основной истиной. Эта логика разработана на основе системы математики Hendrycks, которую мы вручную проверены в наборе данных по математике, чтобы минимизировать ложные позитивы и ложные негативы.

Чтобы оценить прогнозируемый ответ, запустите следующую команду:

python -m eval.evaluate

--data_name " math "

--prompt_type " tora "

--file_path " outputs/llm-agents/tora-code-34b-v1.0/math/test_tora_-1_seed0_t0.0_s0_e5000.jsonl "

--executeТогда вы получите:

Num samples: 5000

Num scores: 5000

Timeout samples: 0

Empty samples: 2

Mean score: [51.0]

Type scores: {'Algebra': 67.3, 'Counting & Probability': 42.2, 'Geometry': 26.1, 'Intermediate Algebra': 40.0, 'Number Theory': 59.3, 'Prealgebra': 63.8, 'Precalculus': 34.2}

В настоящее время мы проходим внутренний обзор для открытого источника Tora-Corpus-16K, следите за обновлениями! Мы также открыли наши полные учебные сценарии для сообщества, и вы можете построить свой собственный набор данных для обучения. Мы приводим некоторые примеры данных в данных/Tora/.

Чтобы тренировать модель, запустите следующую команду:

bash scripts/train.sh codellama 7bЕсли вы обнаружите этот репозиторий полезным, пожалуйста, рассмотрите возможность ссылаться на нашу статью:

@inproceedings{

gou2024tora,

title={To{RA}: A Tool-Integrated Reasoning Agent for Mathematical Problem Solving},

author={Zhibin Gou and Zhihong Shao and Yeyun Gong and yelong shen and Yujiu Yang and Minlie Huang and Nan Duan and Weizhu Chen},

booktitle={The Twelfth International Conference on Learning Representations},

year={2024},

url={https://openreview.net/forum?id=Ep0TtjVoap}

}

Этот проект приветствует вклады и предложения. Большинство взносов требуют, чтобы вы согласились с лицензионным соглашением о участнике (CLA), заявив, что вы имеете право и фактически предоставить нам права на использование вашего вклада. Для получения подробной информации, посетите https://cla.opensource.microsoft.com.

Этот проект принял код поведения с открытым исходным кодом Microsoft. Для получения дополнительной информации см. Кодекс поведения FAQ или свяжитесь с [email protected] с любыми дополнительными вопросами или комментариями.