Это модульная структура текста в речь, направленная на поддержку быстрого исследования и разработки продуктов. Основные особенности включают

Взносы приветствуются.

Оформить демонстрацию здесь

git clone https://github.com/ranchlai/mandarin-tts.git

cd mandarin-tts

git submodule update --force --recursive --init --remote

pip install -e . f

Здесь представлены два примера: Biobei и Aishell3.

Чтобы обучить свои собственные модели, сначала сделайте копию из существующих примеров, затем подготовьте функции Melspectrogram с помощью wav2mel.py by

cd examples

python wav2mel.py -c ./aishell3/config.yaml -w < aishell3_wav_folder > -m < mel_folder > -d cpuПодготовьте файлы SCP, необходимые для обучения,

cd examples/aishell3

python prepare.py --wav_folder < aishell3_wav_folder > --mel_folder < mel_folder > --dst_folder ./train/Это будет генерировать файлы SCP, необходимые для config.yaml (в разделе DataSet/Train). Вам также нужно проверить, что в файле конфигурации все в порядке. Обычно вам не нужно менять код.

Теперь вы можете начать тренировку с

cd examples/aishell3

python ../../mtts/train.py -c config.yaml -d cudaДля набора данных Biaobei рабочий процесс одинаков, за исключением того, что нет никакого динамика, но вы можете добавить просодию.

Будет добавлено больше примеров. Пожалуйста, оставайся.

В настоящее время приведены два примера, и соответствующие контрольные точки/конфигурации суммированы следующим образом.

| набор данных | Контрольная точка | конфигурация |

|---|---|---|

| Aishell3 | связь | связь |

| Biobei | связь | связь |

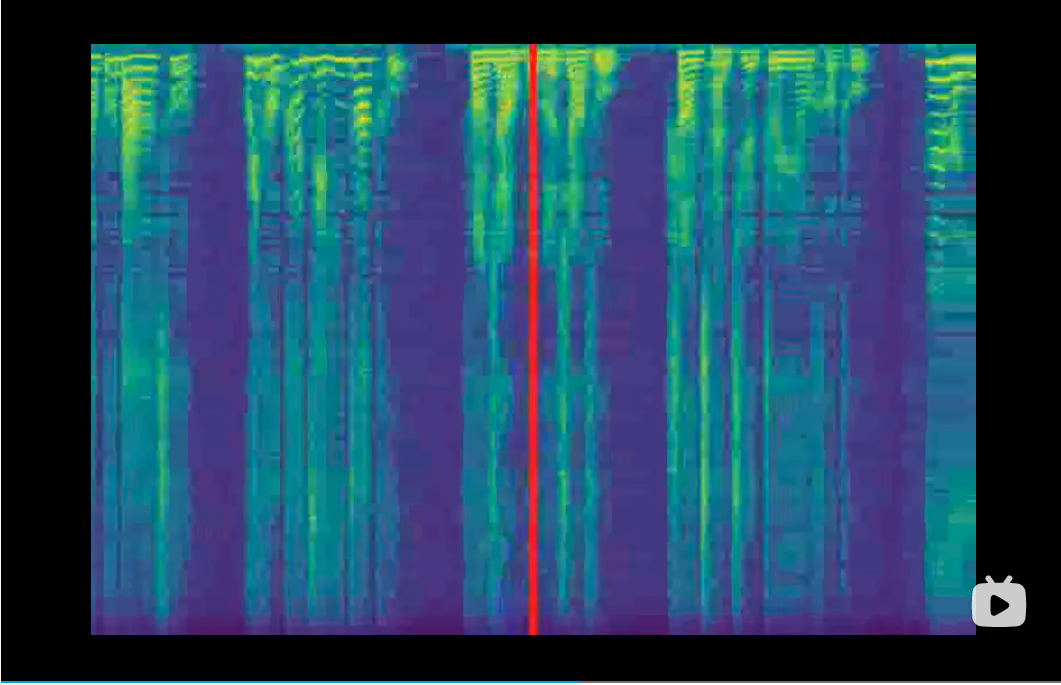

Vocoders играют роль преобразования Melspectrograms в формы волны. Они добавляются в качестве подмодулей и будут обучены в этом проекте. Следовательно, вы должны загрузить контрольно -пропускные пункты перед синтезом. При обучении вокадеры не нужны, так как вы можете отслеживать процесс обучения из сгенерированных MELSPectrograms, а также кривой потерь. Текущий мы поддерживаем следующие вокалисты,

| Вокадер | Контрольная точка | GitHub |

|---|---|---|

| Волновой хлопот | связь | связь |

| Хиф-Ган | связь | связь |

| Vocgan | ссылка на ссылку | связь |

| Мелган | связь | связь |

Все Vocoders будут готовы после запуска git submodule update --force --recursive --init --remote . Тем не менее, вы должны загрузить контрольную точку вручную и правильно установить путь в файле config.yaml.

Input.txt должен соответствовать вашему настройке emb_type1 в emb_type_n в файле конфигурации, то есть тот же тип, тот же порядок.

Чтобы облегчить транскрипцию Hanzi к пинеину, вы можете попробовать:

cd examples/aishell3/

python ../../mtts/text/gp2py.py -t "为适应新的网络传播方式和读者阅读习惯"

>> sil wei4 shi4 ying4 xin1 de5 wang3 luo4 chuan2 bo1 fang1 shi4 he2 du2 zhe3 yue4 du2 xi2 guan4 sil|sil 为 适 应 新 的 网 络 传 播 方 式 和 读 者 阅 读 习 惯 sil

Не вы можете скопировать текст в input.txt и не забыть отложить самоопределенное имя и идентификатор динамика, разделенную «|».

С вышеуказанными контрольно -пропускными пунктами и готовыми текстом, наконец, вы можете запустить процесс синтеза,

python ../../mtts/synthesize.py -d cuda --c config.yaml --checkpoint ./checkpoints/checkpoint_1240000.pth.tar -i input.txtПожалуйста, проверьте файл config.yaml для настройки Vocoder.

Если повезет, звуковые примеры можно найти в выходной папке.