Глубокое подкрепление обучения нанодегри

Этот репозиторий содержит материал, связанный с программой Udacity Deep Atrumbers Learning Nanodegree.

Оглавление

Учебные пособия

Учебные пособия приводят вас к реализации различных алгоритмов в обучении подкрепления. Весь код находится в Pytorch (V0.4) и Python 3.

- Динамическое программирование: внедрение алгоритмов динамического программирования, таких как оценка политики, улучшение политики, итерация политики и итерация ценности.

- Монте -Карло: Реализуйте методы Монте -Карло для прогнозирования и контроля.

- Временная разница: реализовать методы временной дифференциации, такие как SARSA, Q-обучение и ожидаемая SARSA.

- Дискретизация: узнайте, как дискретировать непрерывные государственные пространства и решать среду горного автомобиля.

- Кодирование плитки: реализуйте метод дискретизации непрерывных состояний, которые обеспечивают лучшее обобщение.

- Глубокая Q-сеть: изучите, как использовать глубокую Q-сеть (DQN) для навигации по космическому транспортному средству без сбоя.

- Робототехника: используйте API C ++, чтобы обучать преобразования агентов обучения из виртуального роботизированного моделирования в 3D. ( Внешняя ссылка )

- Снимание на холме: используйте лазание на холме с адаптивным масштабированием шума, чтобы уравновесить шест на движущейся телеге.

- Метод перекрестной энтропии: используйте метод перекрестной энтропии для обучения автомобиля для навигации по крутому холму.

- Подкрепление: Узнайте, как использовать градиенты политики Монте -Карло для решения классической задачи управления.

- Оптимизация проксимальной политики : изучите, как использовать оптимизацию проксимальной политики (PPO) для решения классической задачи обучения подкрепления. ( Вскоре! )

- Глубокие детерминированные градиенты политики : изучите, как использовать глубокие детерминированные градиенты политики (DDPG) в среде Openai.

- МАЯНКИ: Используйте среду маятника Openai Gym.

- Bipedalwalker: Используйте среду Bipedalwalker Openai Gym.

- Финансы: тренируйте агента для обнаружения оптимальных торговых стратегий.

Лаборатории / проекты

Лаборатории и проекты можно найти ниже. Все проекты используют богатые моделирующие среды от Unity ML-Agents. В программе Deep Atreforment Learning Nanodegree вы получите обзор вашего проекта. Эти обзоры предназначены для того, чтобы дать вам персонализированную обратную связь и рассказать вам, что можно улучшить в вашем коде.

- Проблема с такси: в этой лаборатории вы тренируете такси, чтобы забрать и бросить пассажиров.

- Навигация: в первом проекте вы будете обучать агента собирать желтые бананы, избегая синих бананов.

- Непрерывный контроль: во втором проекте вы будете обучать роботизированную руку для достижения целевых мест.

- Сотрудничество и соревнование: в третьем проекте вы обучите пару агентов играть в теннис!

Ресурсы

- CheatSheet: Вам рекомендуется использовать этот файл PDF, чтобы направлять ваше изучение обучения подкреплению.

Openai Gym тесты

Классический контроль

-

Acrobot-v1 с кодированием плитки и Q-обучением -

Cartpole-v0 с скалолазанием на холм | Решено в 13 эпизодах -

Cartpole-v0 с подкреплением | Решено в 691 эпизодах -

MountainCarContinuous-v0 с методом перекрестной энтропии | Решено в 47 итерациях -

MountainCar-v0 с унифицированной дискретизацией и Q-обучением | Решено в <50000 эпизодах -

Pendulum-v0 с глубокими детерминированными градиентами политики (DDPG)

Box2d

-

BipedalWalker-v2 с глубокими детерминированными градиентами политики (DDPG) -

CarRacing-v0 с глубокими Q-NetWorks (DQN) | Вскоре! -

LunarLander-v2 с глубокими Q-NetWorks (DQN) | Решено в 1504 эпизодах

Игрушечный текст

-

FrozenLake-v0 с динамическим программированием -

Blackjack-v0 с методами Монте-Карло -

CliffWalking-v0 с методами временной дифференциации

Зависимости

Чтобы настроить вашу среду Python для запуска кода в этом репозитории, следуйте приведенным ниже инструкциям.

Создайте (и активируйте) новую среду с Python 3.6.

conda create --name drlnd python=3.6

source activate drlnd

conda create --name drlnd python=3.6

activate drlnd

Если вы работаете в Windows , убедитесь, что у вас есть «Инструменты сборки для Visual Studio 2019» на этом сайте. Эта статья также может быть очень полезной. Это было подтверждено, чтобы работать в Windows 10 Home.

Следуйте инструкциям в этом репозитории, чтобы выполнить минимальную установку спортзала Openai.

- Затем установите группу классической среды управления , следуя инструкциям здесь.

- Затем установите группу среды Box2D , следуя инструкциям здесь.

Клонировать репозиторий (если вы еще этого не сделали!) И перейдите к папке python/ . Затем установите несколько зависимостей.

git clone https://github.com/udacity/deep-reinforcement-learning.git

cd deep-reinforcement-learning/python

pip install .

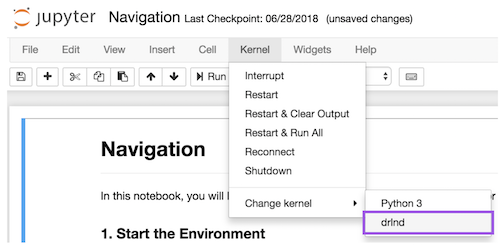

Создайте ядро IPTHON для среды drlnd .

python -m ipykernel install --user --name drlnd --display-name " drlnd "

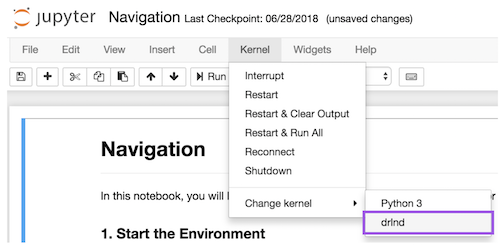

Перед запуском кода в ноутбуке измените ядро, чтобы соответствовать среде drlnd , используя меню раскрывающегося Kernel .

Хотите узнать больше?

Приходите учиться с нами в программе Deep Atrumbers Learning Nanodegree в Udacity!