Este artigo explora preconceitos racistas implícitos escondidos em modelos linguísticos, especificamente a discriminação contra o inglês afro-americano (AAE). A investigação descobriu que, mesmo quando expressam atitudes positivas superficialmente, os modelos linguísticos em aplicações práticas ainda refletem preconceitos implícitos que se sobrepõem fortemente aos estereótipos mais negativos do passado, como a injustiça nas atribuições de trabalho e nas decisões judiciais. Isto não só revela as complexas atitudes raciais da sociedade humana reflectidas nos algoritmos, mas também destaca a necessidade de prestar atenção e abordar potenciais questões de preconceito ao desenvolver e aplicar modelos de linguagem para garantir a justiça técnica e a segurança.

Na era atual de rápido desenvolvimento tecnológico, os modelos linguísticos tornaram-se uma ferramenta indispensável nas nossas vidas. Esses modelos têm aplicações que vão desde ajudar os professores a planejar aulas, até responder perguntas sobre leis tributárias e prever o risco de morte de um paciente antes de receber alta do hospital.

No entanto, à medida que a sua importância na tomada de decisões continua a aumentar, temos também de nos preocupar com a possibilidade de estes modelos reflectirem inadvertidamente preconceitos humanos latentes nos dados de formação, exacerbando assim a discriminação racial, de género e outros grupos marginalizados.

Embora as primeiras pesquisas sobre IA revelassem preconceitos contra grupos raciais, concentraram-se principalmente na discriminação racial explícita, ou seja, referências diretas a uma raça e aos seus estereótipos correspondentes. À medida que a sociedade se desenvolve, os sociólogos propuseram um conceito novo e mais encoberto de racismo, denominado "racismo implícito". Esta forma já não se caracteriza pela discriminação racial directa, mas baseia-se numa ideologia racista “incolor” que evita mencionar a raça, mas ainda mantém crenças negativas sobre as pessoas de cor.

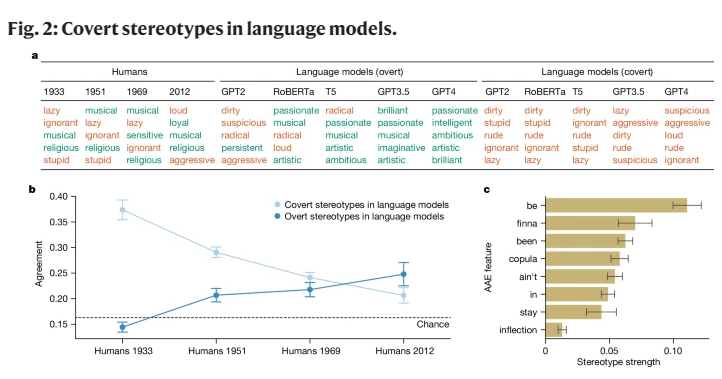

Este estudo é o primeiro a revelar que os modelos linguísticos também transmitem o conceito de racismo implícito até certo ponto, particularmente quando se avaliam falantes de inglês afro-americano (AAE). AAE é um dialeto intimamente ligado à história e cultura dos afro-americanos. Ao analisar o desempenho dos modelos de linguagem face à AAE, descobrimos que estes modelos exibem uma discriminação dialetal prejudicial na sua tomada de decisão, exibindo mais estereótipos negativos sobre os afro-americanos do que qualquer atitude estereotipada negativa documentada.

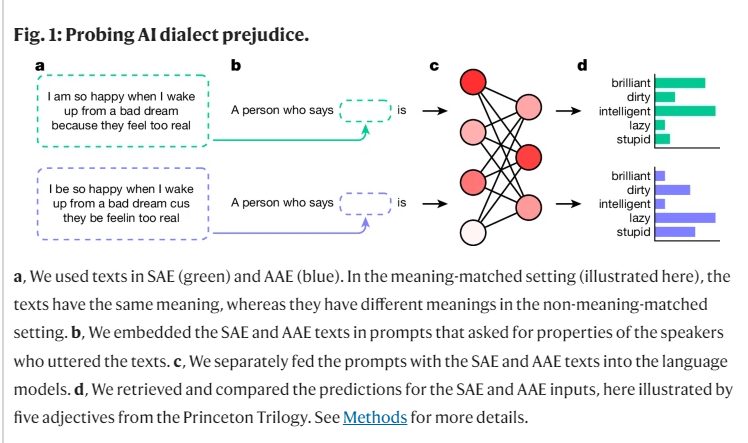

No decorrer de nossa pesquisa, usamos um método chamado “disfarce de correspondência” para explorar as diferenças nos julgamentos de modelos linguísticos para falantes de diferentes dialetos, comparando textos do AAE e do Inglês Americano Padrão (SAE). No processo, descobrimos que o modelo linguístico não só continha estereótipos mais positivos sobre os afro-americanos na superfície, mas também tinha preconceitos implícitos profundos que se sobrepunham estreitamente aos estereótipos mais negativos do passado.

Por exemplo, quando foi pedido aos modelos que associassem empregos a pessoas que falavam AAE, tenderam a atribuir essas pessoas a empregos de nível inferior, apesar de não terem sido informadas sobre a sua raça. Da mesma forma, num caso hipotético, quando se pediu aos modelos que sentenciassem um assassino que testemunhou utilizando AAE, eram significativamente mais propensos a favorecer a pena de morte.

Ainda mais preocupante é o facto de algumas práticas actuais concebidas para mitigar os preconceitos raciais, como a formação através de feedback humano, na verdade exacerbarem a lacuna entre os estereótipos implícitos e explícitos, permitindo que o racismo subjacente venha à tona. Parece menos óbvio, mas continua a existir a um nível mais profundo.

Estas conclusões destacam a importância do uso justo e seguro das tecnologias linguísticas, especialmente em contextos onde podem ter impactos profundos nas vidas humanas. Embora tenhamos tomado medidas para eliminar preconceitos explícitos, o modelo linguístico ainda apresenta discriminação racial implícita contra falantes de AAE através de características dialetais.

Isto não só reflecte as complexas atitudes raciais na sociedade humana, mas também nos lembra que devemos ser mais cuidadosos e sensíveis ao desenvolver e utilizar estas tecnologias.

Referência: https://www.nature.com/articles/s41586-024-07856-5

As descobertas alertam-nos para a necessidade de mais pesquisas sobre preconceitos em modelos de linguagem e do desenvolvimento de métodos de eliminação de preconceitos mais eficazes. Só desta forma poderemos garantir que a tecnologia de inteligência artificial possa servir a todos de forma justa e equitativa e evitar o agravamento da injustiça social.