| Page_type | idiomas | produtos | Urlfragment | nome | descrição | ||||||||||||||

|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|---|

amostra |

|

| APP-TEMPLATES-JAVA-Openai-SpringApps | Carrinho de compras da IA - modelo de aplicativo para aplicativos Java, Azure OpenAi e Azure Spring | Aplicação de amostras de carrinho de compras de IA com aplicativos do Azure OpenAi e Azure Spring |

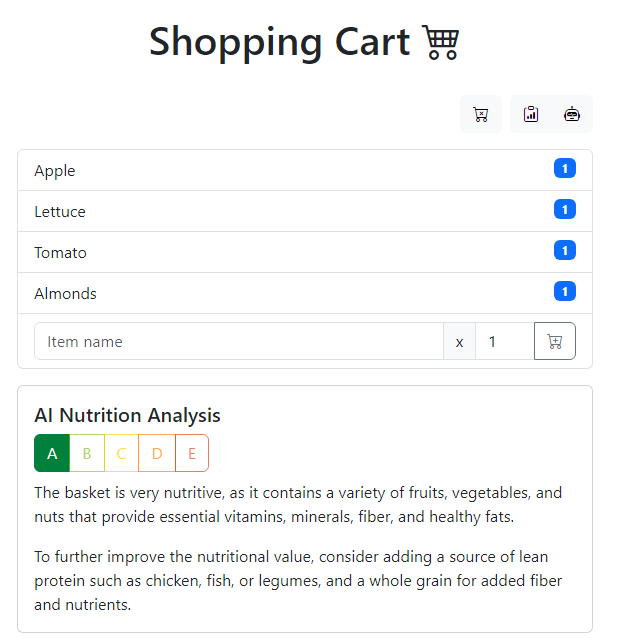

O carrinho de compras de IA é um aplicativo de amostra que sobrecarrega sua experiência de compra com o poder da IA. Ele aproveita os aplicativos do Azure OpenAi e Azure Spring para criar um mecanismo de recomendação que não seja apenas escalável, resiliente e seguro, mas também personalizado para suas necessidades. Aproveitando o Azure Openai, o aplicativo executa a análise nutricional nos itens do seu carrinho e gera as três principais receitas usando esses ingredientes. Com o desenvolvedor do Azure CLI (AZD), você está a apenas alguns comandos de ter esse aplicativo de amostra totalmente funcional em funcionamento no Azure. Vamos começar!

Este aplicativo de amostra inspira-se neste trabalho original: https://github.com/lopezleandro03/ai-sisististed-roceries-cart

Consulte o repositório de modelos de aplicativos para obter mais amostras compatíveis com

azd.

gpt-4 ou gpt-35-turbo [Nota] Para aprender a começar com qualquer modelo, siga este rápido inicial. Para este modelo Azure-Samples/app-templates-java-openai-springapps , você precisa executar algumas etapas adicionais, conforme descrito abaixo.

Este Quickstart mostrará como autenticar no Azure, ativar o recurso Alpha Apps Spring para AZD, inicializar usando um modelo, definir as variáveis de ambiente para o Azure OpenAi, provisionar a infraestrutura e implantar o código para o Azure:

# Log in to azd if you haven't already

azd auth login

# Enable Azure Spring Apps alpha feature for azd

azd config set alpha.springapp on

# First-time project setup. Initialize a project in the current directory using this template

azd init --template Azure-Samples/app-templates-java-openai-springapps

# Set the environment variables for Azure OpenAI

azd env set azureOpenAiApiKey < replace-with-Azure-OpenAi-API-key >

azd env set azureOpenAiEndpoint < replace-with-Azure-OpenAi-endpoint >

azd env set azureOpenAiDeploymentId < replace-with-Azure-OpenAi-deployment-id/name >

# To use GPT-3.5 Turbo model set this environment variable to false

azd env set isAzureOpenAiGpt4Model true

# Provision and deploy to Azure

azd upNotas

- Substitua os espaços reservados pelos valores do seu recurso do Azure Openai.

- Se você estiver usando o modelo

gpt-35-turbo, precisará definirisAzureOpenAiGpt4Modelcomofalseantes de provisionar o recurso e implantar o aplicativo de amostra no Azure:azd env set isAzureOpenAiGpt4Model false

No final da implantação, você verá o URL do front-end. Abra o URL em um navegador para ver o aplicativo em ação.

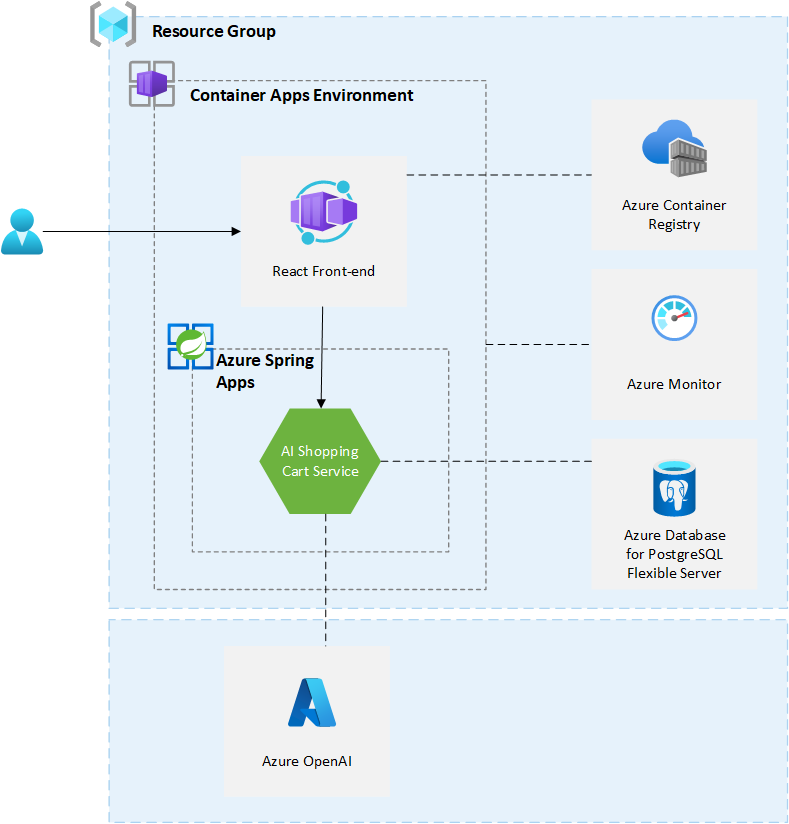

Este aplicativo de amostra usa os seguintes recursos do Azure:

Aqui está um diagrama de arquitetura de alto nível que ilustra esses componentes. Excled Azure Openai, todos os outros recursos são provisionados em um único grupo de recursos criado quando você cria seus recursos usando azd up .

Este modelo provisões de recursos para uma assinatura do Azure que você selecionará ao provisionar. Consulte a calculadora de preços do Microsoft Azure e, se necessário, atualize as definições de recursos do Azure incluídas encontradas no

infra/main.biceppara atender às suas necessidades.

Este aplicativo de amostra usa o Azure OpenAI. Não faz parte do processo de implantação automatizado. Você precisará criar um recurso do Azure OpenAI e configurar o aplicativo para usá -lo. Siga as instruções na documentação do Azure Openai para obter acesso ao Azure Openai. Não se esqueça de ler a visão geral das práticas responsáveis de IA para os modelos do Azure Openai antes de começar a usar o Azure OpenAi e solicitar acesso.

A versão atual do aplicativo de amostra requer um recurso do Azure OpenAI acessível ao público (ou seja, permita o acesso de todas as redes). Esta amostra não se destina a ser usada na produção. Para saber mais sobre redes e segurança do Azure OpenAI, consulte a documentação do Azure Openai.

Este aplicativo de amostra foi desenvolvido para ser usado com o modelo gpt-4 . Ele também suporta gpt-35-turbo . Para usar gpt-35-turbo , você precisa definir isAzureOpenAiGpt4Model como false (cf. QuickStart). Por padrão, essa variável de parâmetro/ambiente é definida como true . Para concluir a configuração do aplicativo, você precisa definir as seguintes informações do recurso Azure OpenAI:

azureOpenAiApiKey - Azure OpenAi API KeyazureOpenAiEndpoint - Azure OpenAi finalazureOpenAiDeploymentId -ID de implantação do Azure OpenAi do modelo gpt-4 ou gpt-3.5-turbo A chave da API e o terminal podem ser encontrados no portal do Azure. Você pode seguir estas instruções: recupere a chave e o ponto. O ID da implantação corresponde ao deployment name neste guia.

A engenharia rápida é importante para obter os melhores resultados do Azure Openai. Os avisos de texto são como os usuários interagem com os modelos GPT. Como em todo o modelo de linguagem grande generativa (LLM), os modelos GPT tentam produzir a próxima série de palavras com maior probabilidade de seguir o texto anterior. É um pouco como perguntar ao modelo de IA: qual é a primeira coisa que vem à mente quando digo <prompt> ?

Com a API de conclusão de bate -papo, existem seções distintas do prompt que são enviadas para a API associada a uma função específica: Sistema, Usuário e Assitante. A mensagem do sistema está incluída no início do prompt e é usada para fornecer as instruções iniciais ao modelo: Descrição dos traços de personalidade, instruções/regras que ele seguirá etc.

AI Shopping Cart Service está usando a Biblioteca Cliente do Azure Openai para Java. Este Libary faz parte do Azure SDK para Java. É implementado como uma conclusão de bate -papo. No serviço, temos duas mensagens do sistema em SystemMessageConstants.java: uma para análise nutricional da IA e outra para gerar as 3 principais receitas. A mensagem do sistema é seguida por uma mensagem do usuário: The basket is: <list of items in the basket separated by a comma> . A mensagem assistente é a resposta do modelo. O serviço está usando as compensações de compras para interagir com o Azure Openai. Nesta classe, você encontrará o código responsável por gerar o prompt e chamar a API do Azure Openai: getChatCompletion . Para saber mais sobre a temperatura e o TOPP usado nesta classe, consulte a documentação.

Para o modelo gpt-35-turbo , mais contexto é adicionado à mensagem do usuário. Esse contexto adicional é adicionado no final da mensagem do usuário. Ele fornece mais informações sobre o formato do JSON que o modelo OpenAI precisa retornar e pedir ao modelo que retorne apenas o JSON sem texto adicional. Este contexto adicional está disponível em userMessaGecOnstants.java.

Este modelo está estruturado para acompanhar as conventões do modelo CLI do desenvolvedor do Azure. Você pode aprender mais sobre a arquitetura azd na documentação oficial.

Neste ponto, você tem um aplicativo completo implantado no Azure.

Para necessidades corporativas, procurando implantação de aplicativos de poliglota, suporte de componentes da Tanzu e garantia do SLA, recomendamos usar o Azure Spring Apps Enterprise. Verifique o acelerador da zona de aterrissagem de aplicativos do Azure Spring que fornece orientações arquitetônicas projetadas para otimizar o provisionamento de infraestrutura pronto para produção e implantação de aplicativos de inicialização e nuvem de mola para aplicativos do Azure Spring. Como proprietário da carga de trabalho, use orientações arquitetônicas fornecidas no acelerador da zona de pouso para atingir seu estado técnico -alvo com confiança.

Você implantou o aplicativo de amostra usando a CLI do desenvolvedor do Azure, no entanto, há muito mais do que a CLI do desenvolvedor do Azure pode fazer. Essas próximas etapas apresentarão comandos adicionais que facilitarão muito a criação de aplicativos no Azure. Usando a CLI do desenvolvedor do Azure, você pode configurar seus pipelines, monitorar seu aplicativo, testar e depurar localmente.

azd down - Para excluir todos os recursos do Azure criados com este modelo

azd pipeline config - Para configurar um pipeline CI/CD (usando ações do GitHub ou Azure DevOps) para implantar seu aplicativo sempre que o código for empurrado para a ramificação principal.

AZURE_OPENAI_API_KEY : chave da API para o recurso do Azure OpenAiAZURE_OPENAI_ENDPOINT : endpoint for Azure OpenAi ResourceAZURE_OPENAI_DEPLOYMENT_ID : ID/nome de implantação para o recurso do Azure OpenAiIS_AZURE_OPENAI_GPT4_MODEL : defina como true se você estiver usando o modelo GPT-4 e para false se estiver usando o modelo GPT-3.5 Turbo azd monitor - Para monitorar o aplicativo e navegar rapidamente para os vários painéis de insights de aplicativos (por exemplo, visão geral, métricas ao vivo, logs)

Run e Debug localmente - usando o código do Visual Studio e a extensão do desenvolvedor do Azure CLI

azd adicionais A CLI do desenvolvedor do Azure inclui muitos outros comandos para ajudar na sua experiência de desenvolvimento do Azure. Você pode visualizar esses comandos no terminal executando azd help . Você também pode visualizar a lista completa de comandos em nossa página de comando do desenvolvedor do Azure.

Esses são recursos adicionais que você pode usar para aprender mais sobre o aplicativo de amostra e suas tecnologias subjacentes.

O software pode coletar informações sobre você e seu uso do software e enviá -lo para a Microsoft. A Microsoft pode usar essas informações para fornecer serviços e melhorar nossos produtos e serviços. Você pode desligar a telemetria, conforme descrito no repositório. Existem também alguns recursos no software que podem permitir que você e a Microsoft coletem dados de usuários de seus aplicativos. Se você usar esses recursos, deverá cumprir a lei aplicável, incluindo o fornecimento de avisos apropriados aos usuários de seus aplicativos, juntamente com uma cópia da declaração de privacidade da Microsoft. Nossa declaração de privacidade está localizada em https://go.microsoft.com/fwlink/?linkid=521839. Você pode aprender mais sobre a coleta e uso de dados na documentação de ajuda e nossa declaração de privacidade. Seu uso do software opera como seu consentimento para essas práticas.

A coleção de telemetria está ligada por padrão.

Para não optar por não, defina a variável enabletelemetria como falsa em infra/main.parameters.json ou no modelo de bíceps infra/main.bicep . Ele pode ser definido usando o seguinte comando quando o provisionamento for feito com a CLI do desenvolvedor do Azure:

azd env set enableTelemetry false Este projeto pode conter marcas comerciais ou logotipos para projetos, produtos ou serviços. O uso autorizado de marcas comerciais ou logotipos da Microsoft está sujeito e deve seguir as diretrizes de marca registrada e marca da Microsoft. O uso de marcas comerciais da Microsoft ou logotipos em versões modificadas deste projeto não deve causar confusão ou implicar o patrocínio da Microsoft. Qualquer uso de marcas comerciais ou logotipos de terceiros estão sujeitas às políticas de terceiros.