Este projeto automatiza o processo de seleção dos melhores modelos, avisos ou parâmetros de inferência para um determinado caso de uso, permitindo que você itera suas combinações e inspecione visualmente os resultados.

Ele pressupõe que o Ollama seja instalado e atenda pontos de extremidade, em localhost ou em um servidor remoto.

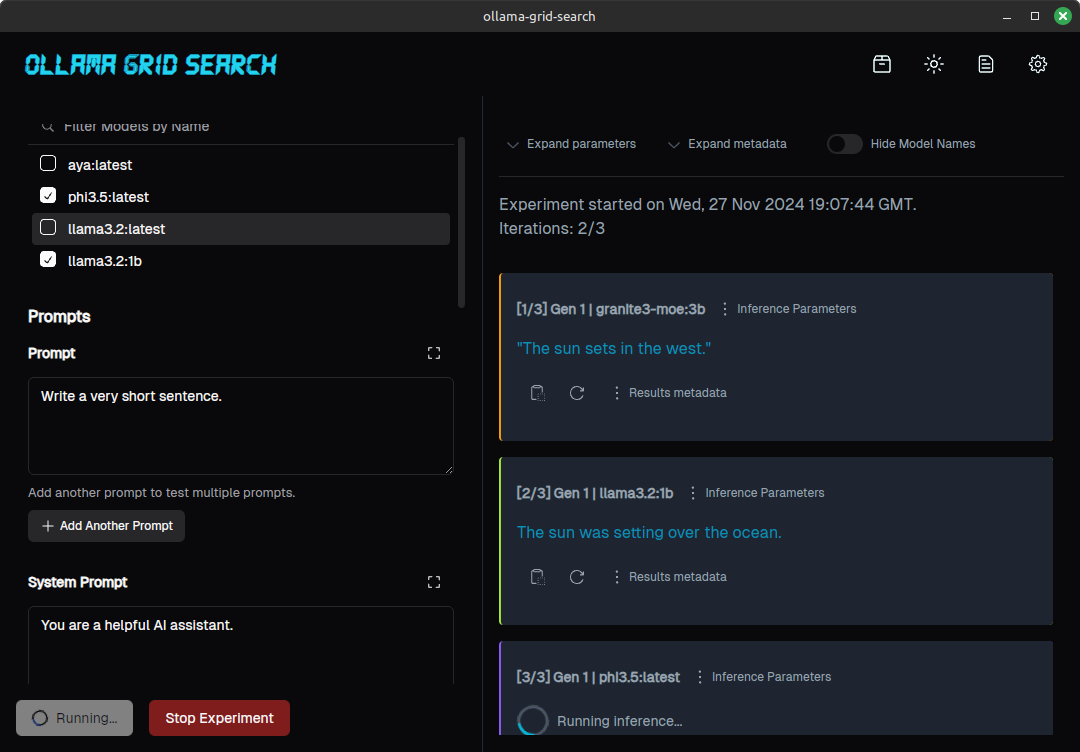

Aqui está como é um experimento para um prompt simples, testado em 3 modelos diferentes, parece:

(Para uma análise mais aprofundada de um processo de avaliação assistido por esta ferramenta, consulte https://dezoito.github.io/2023/12/27/rust-ollama-grid-search.html).

Verifique a página de versões do projeto ou na barra lateral.

Tecnicamente, o termo "pesquisa de grade" refere -se à iteração de uma série de hiperparams de modelo diferentes para otimizar o desempenho do modelo, mas isso geralmente significa parâmetros como batch_size , learning_rate ou number_of_epochs , mais comumente usados no treinamento.

Mas o conceito aqui é semelhante:

Vamos definir uma seleção de modelos, uma rápida e algumas combinações de parâmetros:

O prompt será enviado uma vez para cada valor de parâmetro, para cada um dos modelos selecionados, gerando um conjunto de respostas.

Da mesma forma, você pode executar testes A/B selecionando modelos diferentes e comparando resultados para a mesma combinação de prompt/parâmetros ou testar instruções diferentes em configurações semelhantes:

Comparando os resultados de diferentes avisos para o mesmo modelo

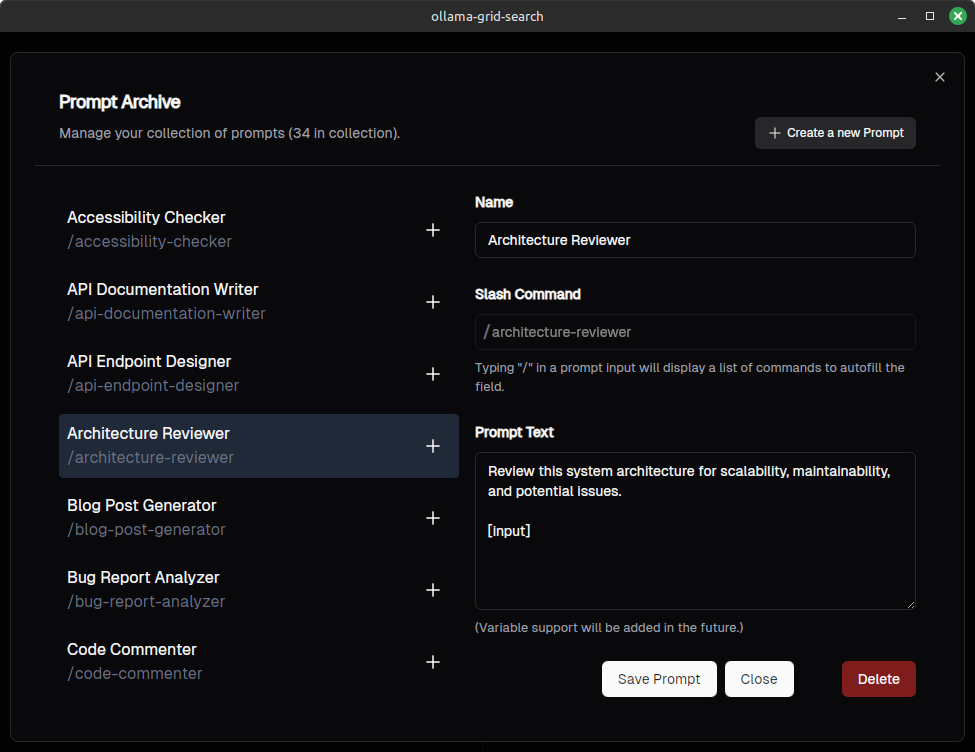

Você pode salvar e gerenciar seus avisos (queremos tornar os avisos compatíveis com o Open Webui)

Você pode preencher autocompleção digitando "/" (inspirado no Open Webui também):

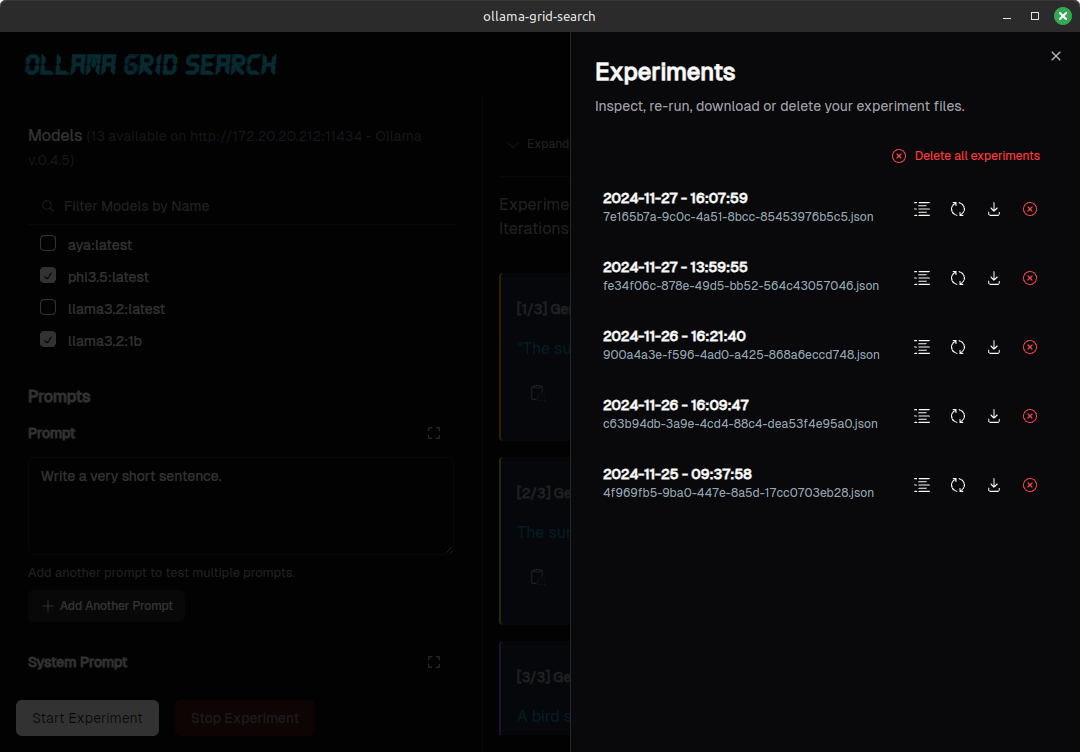

Você pode listar, inspecionar ou baixar seus experimentos:

Para insetos óbvios e erros de ortografia, vá em frente e envie um PR.

Se você deseja propor um novo recurso, alterar a funcionalidade existente ou propor algo mais complexo, abra um problema para discussão, antes de fazer o trabalho em um PR.

Certifique -se de ter a ferrugem instalada.

Clone o repositório (ou um garfo)

git clone https://github.com/dezoito/ollama-grid-search.git

cd ollama-grid-searchInstale as dependências do front -end.

cd < project root >

# I'm using bun to manage dependencies,

# but feel free to use yarn or npm

bun install Verifique se rust-analyzer está configurada para executar Clippy ao verificar o código.

Se você estiver executando o código vs, adicione isso ao seu arquivo settings.json

{

...

"rust-analyzer.check.command" : " clippy " ,

}(ou, melhor ainda, basta usar o arquivo de configurações fornecido com o código)

Execute o aplicativo no modo de desenvolvimento

cd < project root > /

bun tauri devVá tomar uma xícara de café, porque isso pode demorar um pouco.

Os seguintes trabalhos e teses citaram este repositório:

Inouye, D & Lindo, L, & Lee, R & Allen, E; Ciência da Computação e Engenharia Sênior Teses: Aplicado automaticamente no Lora Hyperparameters Universidade Santa Clara, 2024 https://scholarcmons.scu.edu/cgi/viewcontent.cgi?article=1271&context=cseng_senior

Muito obrigado a @fabianlars, @peperroni21 e @tomreidnz.