中文 Readme 请按此处

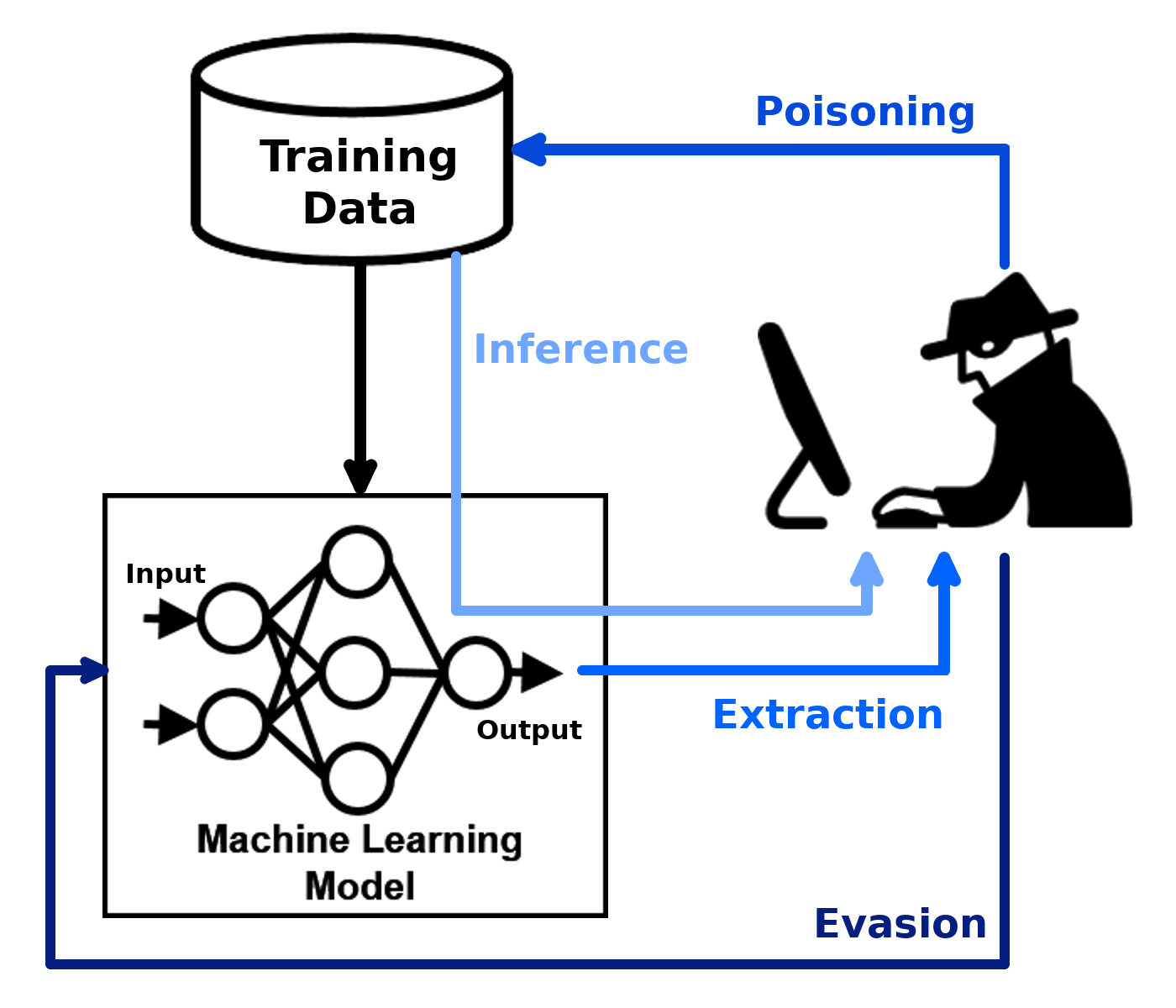

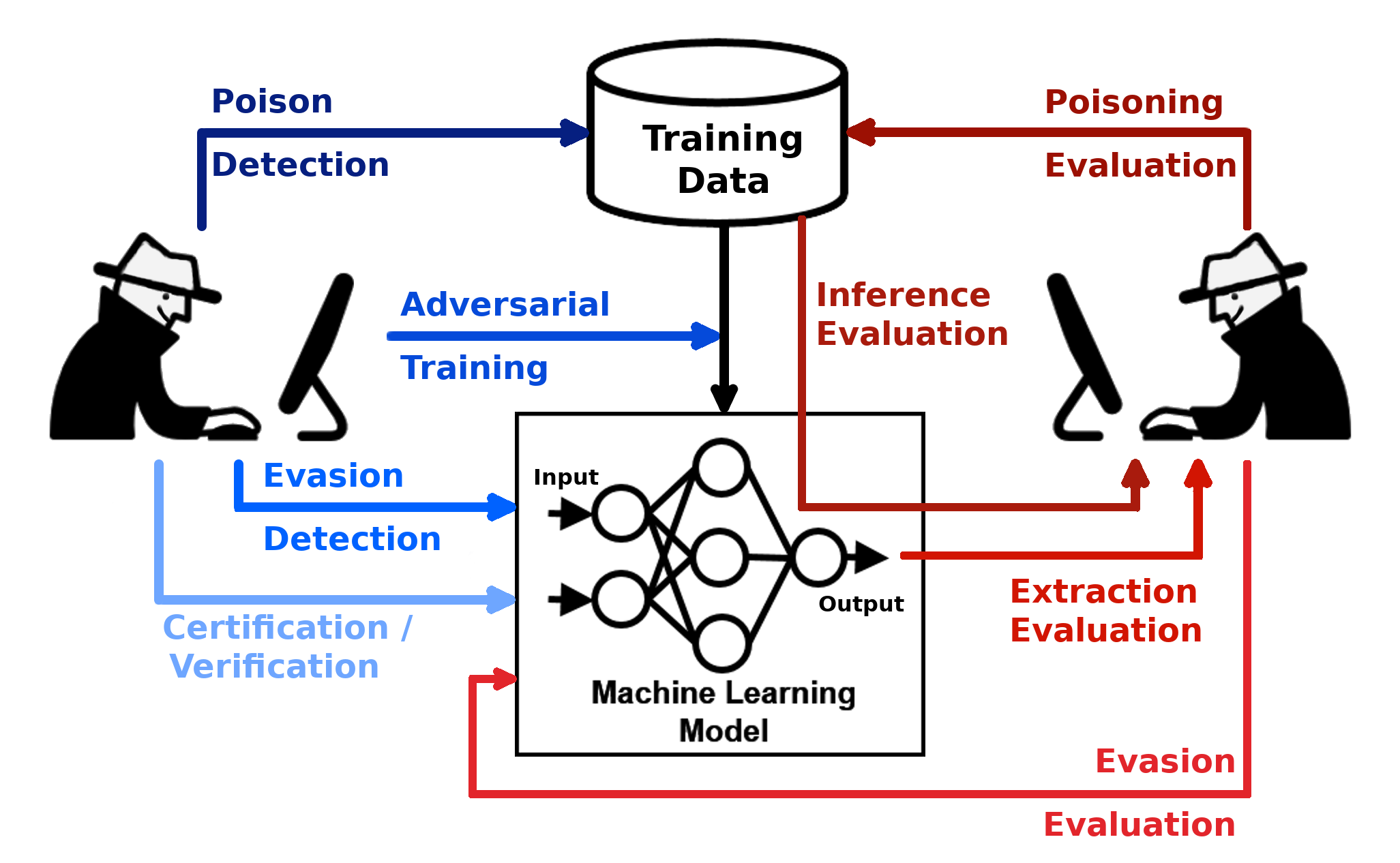

A caixa de ferramentas de robustez adversária (ART) é uma biblioteca Python para segurança de aprendizado de máquina. A arte é hospedada pela Linux Foundation AI & Data Foundation (LF AI & Data). A ART fornece ferramentas que permitem que desenvolvedores e pesquisadores defendam e avaliem modelos e aplicações de aprendizado de máquina contra as ameaças adversárias de evasão, envenenamento, extração e inferência. A ART suporta todas as estruturas populares de aprendizado de máquina (Tensorflow, Keras, Pytorch, MxNet, Scikit-Learn, XGBoost, LightGBM, Catboost, GPY etc.), todos os tipos de dados (imagens, tabelas, áudio, vídeo, etc.) e aprendizado de máquina de máquinas Tarefas (classificação, detecção de objetos, reconhecimento de fala, geração, certificação etc.).

| Comece | Documentação | Contribuindo |

|---|---|---|

| - Instalação - Exemplos - Notebooks | - Ataques - defesas - Estimadores - Métricas - Documentação técnica | - Slack, convite - contribuindo - Roteiro - citando |

A biblioteca está sob desenvolvimento contínuo. Feedback, relatórios e contribuições de bugs são muito bem -vindos!

Este material é parcialmente baseado no trabalho apoiado pela Agência de Projetos de Pesquisa Avançada de Defesa (DARPA) sob o contrato nº HR001120C0013. Quaisquer opiniões, descobertas e conclusões ou recomendações expressas neste material são as do (s) autor (s) e não refletem necessariamente as opiniões da Agência de Projetos de Pesquisa Avançada de Defesa (DARPA).