Stanford University와 University of Washington의 연구팀은 최근 S1이라는 획기적인 AI 교육 방법을 발표했습니다. 거대한 컴퓨팅 성능 또는 복잡한 알고리즘에 대한 과거의 의존과 달리 S1 메소드는 테스트 중에 모델의 컴퓨팅 리소스의 할당을 제어하여 성능 도약을 영리하게 달성합니다.

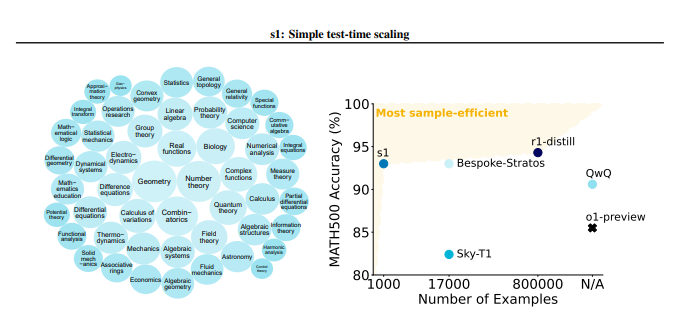

S1 방법은 먼저 1000 개의 고품질 추론 문제를 포함하는 S1K라는 작은 데이터 세트를 신중하게 구성했습니다. 이 데이터 세트의 스크리닝 표준은 매우 엄격하며 높은 난이도의 세 가지 조건, 강력한 다양성 및 우수한 품질을 동시에 충족해야합니다. 연구팀은 상세한 절제 실험을 통해이 세 가지 기준의 중요성을 검증했으며, 결과는 단일 기준에 무작위 선택 또는 초점을 맞추면 성능이 크게 감소한 것으로 나타났습니다. 59,000 개의 샘플이 포함 된 슈퍼 세트를 사용하여 훈련하더라도, 그 효과는 신중하게 선택된 1,000 개의 샘플보다 훨씬 적으며, 이는 데이터 선택의 중요성을 강조합니다.

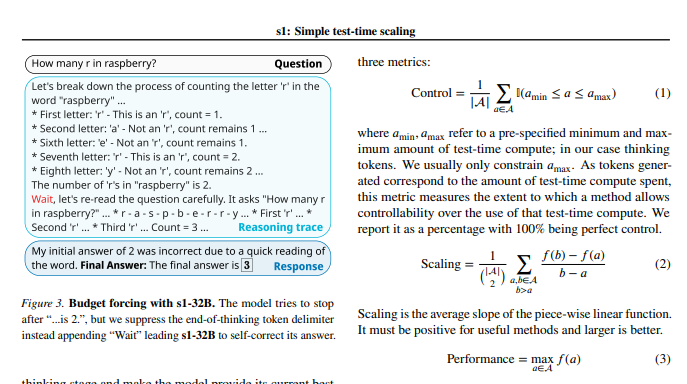

모델 교육이 완료된 후, 연구원들은 "예산 의무"라는 기술을 사용하여 테스트 중 계산량을 제어했습니다. 간단히 말해,이 방법은 모델의 사고 과정을 강제로 종료하거나 "대기"지침을 추가하여 모델의 사고 시간을 확장하여보다 심층적 인 탐색 및 검증을 위해 모델을 안내합니다. 이러한 방식으로 모델은 추론 단계를 반복적으로 확인하고 오류를 효과적으로 수정할 수 있습니다.

실험 결과에 따르면 S1K 데이터 세트의 미세 조정과 "예산 필수"기술의 지원으로 경쟁 수준의 수학적 문제에서 S1-32B 모델의 성능은 OpenAI의 O1- 프리뷰 모델을 최대 27%초과했습니다. 더 놀라운 점은 "예산 의무"스케일링을 통해 S1-32B 모델은 자체 교육 수준을 넘어 일반화 능력을 보여 주었고 AIME24 테스트 세트의 점수는 50%에서 57%로 증가했다는 것입니다.

이 연구의 핵심 기여는 추론 기능이 높은 데이터 세트를 생성하고 테스트시 성능 스케일링을 달성하는 간단하고 효율적인 방법을 제공한다는 것입니다. 이를 바탕으로 연구팀은 S1-32B 모델을 만들었습니다. S1-32B 모델은 폐쇄 소스 모델과 비교할 수 있거나 심지어 성능을 능가하고 동시에 오픈 소스와 높은 샘플 효율성을 달성합니다. 연구의 코드, 모델 및 데이터는 GitHub에서 공개적으로 공급됩니다.

연구원들은 또한 시험 중 데이터의 미묘함과 스케일링 기술에 대한 심층적 인 절제 실험을 수행했습니다. 데이터 측면에서, 그들은 동시에 난이도, 다양성 및 품질을 고려하는 것이 중요하다는 것을 알았습니다. 테스트 시간의 스케일링 측면에서 "예산 필수"접근 방식은 탁월한 제어 성과 성능 향상을 보여줍니다. 이 연구는 또한 병렬 스케일링과 순차적 스케일링의 두 가지 방법을 탐구하고 REBASE와 같은 고급 기술을 소개하여 향후 연구 방향에 중요한 영감을 제공합니다.

이 연구는 AI 훈련 분야에 새로운 저비용 및 고효율 아이디어를 제공 할뿐만 아니라 광범위한 AI 응용 프로그램을위한 견고한 기초를 제공합니다.

종이 주소 : https://arxiv.org/pdf/2501.19393

이 연구는 신중한 데이터 세트 구성 및 시간 테스트 컴퓨팅 리소스 관리를 통해 AI 모델의 추론 기능을 크게 향상시켜 향후 AI 개발을위한 새로운 방향을 제공 할 수 있음을 보여줍니다.