BERT NER

1.0.0

Google Bert를 사용하여 Conll-2003 NER을 수행하십시오!

Python을 사용한 열차 모델 및 C ++를 사용한 추론

Albert-TF2.0

Bert-ner-tensorflow-2.0

버트 스쿼드

python3pip3 install -r requirements.txt python run_ner.py --data_dir=data/ --bert_model=bert-base-cased --task_name=ner --output_dir=out_base --max_seq_length=128 --do_train --num_train_epochs 5 --do_eval --warmup_proportion=0.1

precision recall f1-score support

PER 0.9677 0.9745 0.9711 1842

LOC 0.9654 0.9711 0.9682 1837

MISC 0.8851 0.9111 0.8979 922

ORG 0.9299 0.9292 0.9295 1341

avg / total 0.9456 0.9534 0.9495 5942

precision recall f1-score support

PER 0.9635 0.9629 0.9632 1617

ORG 0.8883 0.9097 0.8989 1661

LOC 0.9272 0.9317 0.9294 1668

MISC 0.7689 0.8248 0.7959 702

avg / total 0.9065 0.9209 0.9135 5648

precision recall f1-score support

ORG 0.9288 0.9441 0.9364 1341

LOC 0.9754 0.9728 0.9741 1837

MISC 0.8976 0.9219 0.9096 922

PER 0.9762 0.9799 0.9781 1842

avg / total 0.9531 0.9606 0.9568 5942

precision recall f1-score support

LOC 0.9366 0.9293 0.9329 1668

ORG 0.8881 0.9175 0.9026 1661

PER 0.9695 0.9623 0.9659 1617

MISC 0.7787 0.8319 0.8044 702

avg / total 0.9121 0.9232 0.9174 5648

from bert import Ner

model = Ner ( "out_base/" )

output = model . predict ( "Steve went to Paris" )

print ( output )

'''

[

{

"confidence": 0.9981840252876282,

"tag": "B-PER",

"word": "Steve"

},

{

"confidence": 0.9998939037322998,

"tag": "O",

"word": "went"

},

{

"confidence": 0.999891996383667,

"tag": "O",

"word": "to"

},

{

"confidence": 0.9991968274116516,

"tag": "B-LOC",

"word": "Paris"

}

]

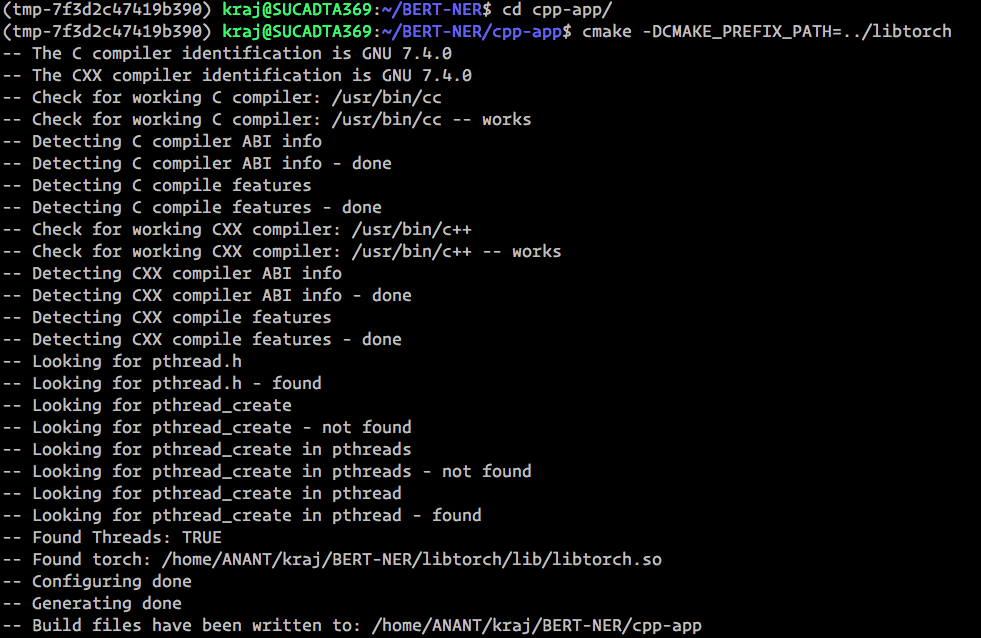

''' cmake 버전 3.10.2 로 테스트 한 cmake 설치하십시오

BERT-NER 에서 실행되지 않은 모델과 libtorch

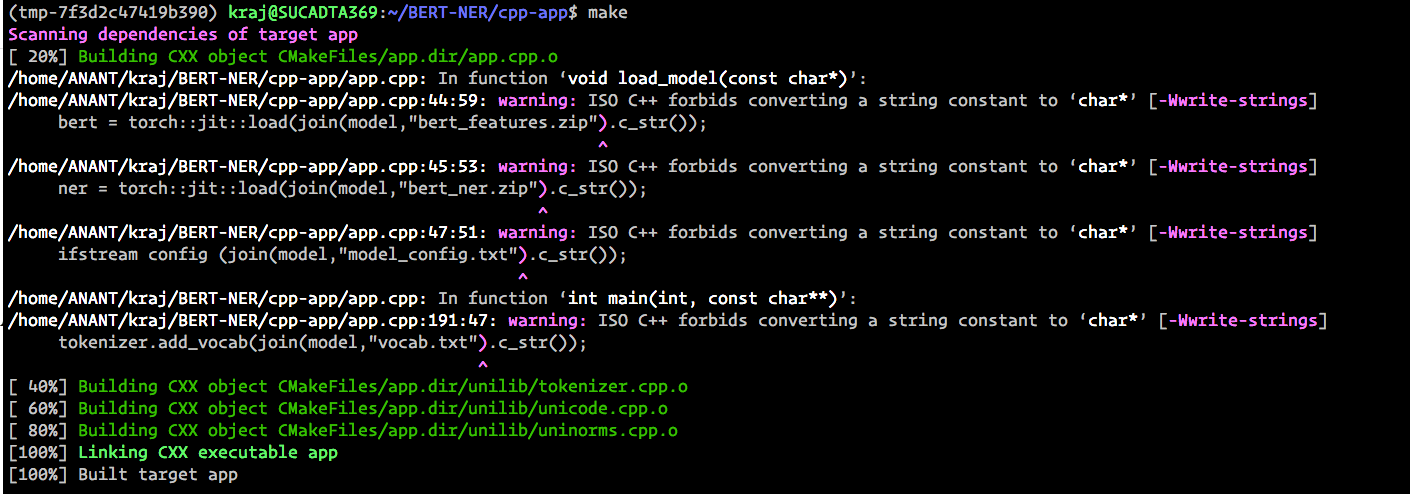

C ++ 앱을 컴파일합니다

cd cpp-app/

cmake -DCMAKE_PREFIX_PATH=../libtorch

make

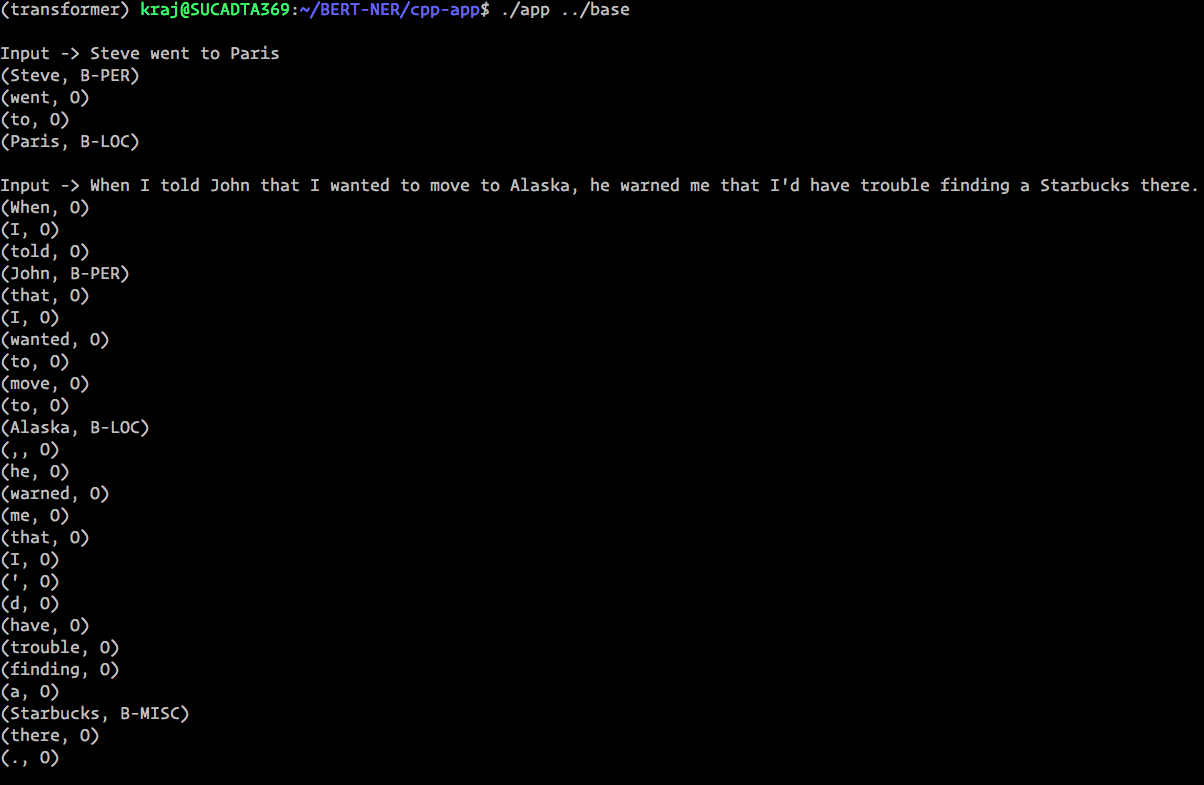

러닝 앱

./app ../base

NB : Bert-Base C ++ 모델은 두 부분으로 분할됩니다.

jit trace 루프 for 의존하거나 model 의 forword 기능 내부의 조건 if input 지원하지 않기 때문에 수행됩니다.Bert Ner 모델은 REST API로 배포되었습니다

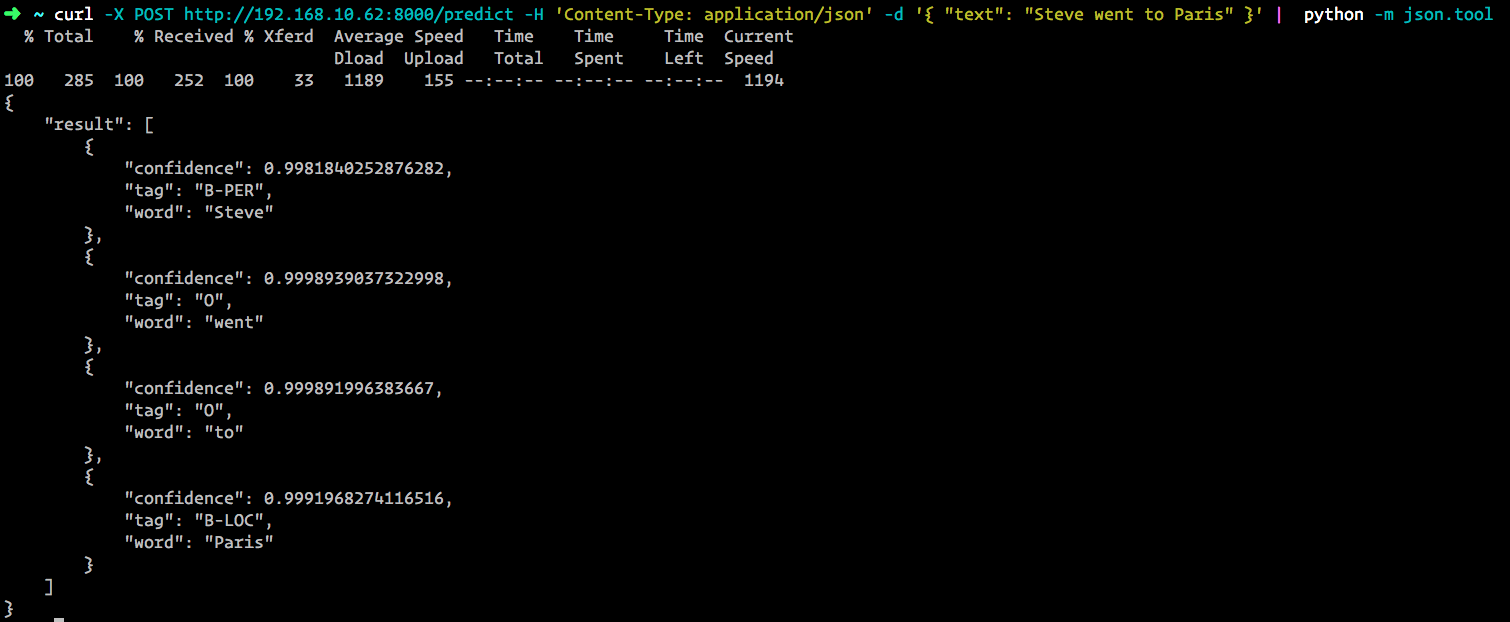

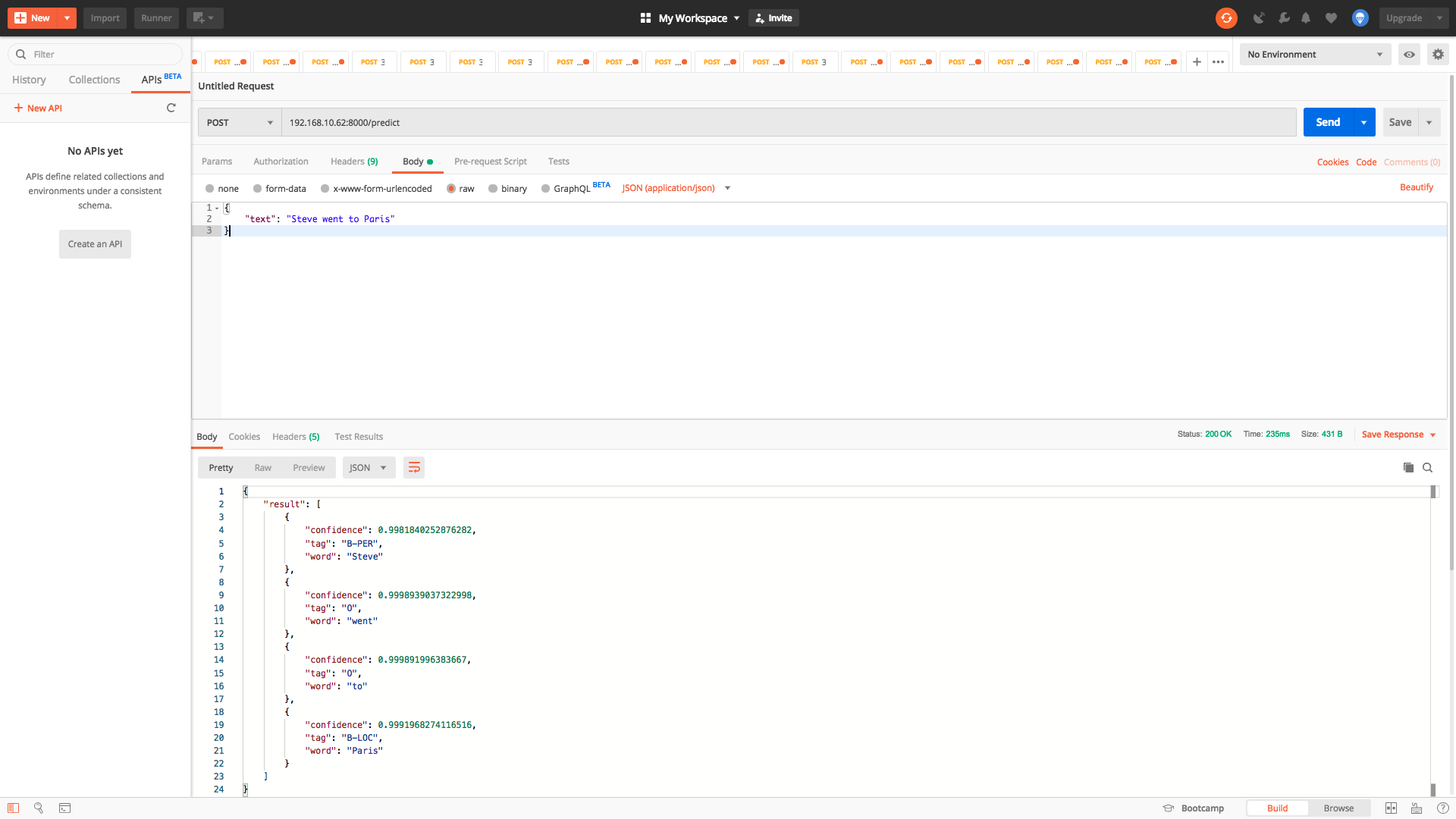

python api.py API는 0.0.0.0:8000 Endpoint predict 으로 살 것입니다

curl -X POST http://0.0.0.0:8000/predict -H 'Content-Type: application/json' -d '{ "text": "Steve went to Paris" }'

산출

{

"result" : [

{

"confidence" : 0.9981840252876282 ,

"tag" : " B-PER " ,

"word" : " Steve "

},

{

"confidence" : 0.9998939037322998 ,

"tag" : " O " ,

"word" : " went "

},

{

"confidence" : 0.999891996383667 ,

"tag" : " O " ,

"word" : " to "

},

{

"confidence" : 0.9991968274116516 ,

"tag" : " B-LOC " ,

"word" : " Paris "

}

]

}