大規模言語モデル (LLM) の推論能力は、人工知能の分野における研究のホットスポットです。 Apple の AI 研究チームは最近、数学的推論における LLM の限界を明らかにする論文を発表しました。 Downcodes の編集者は論文の主な内容を解釈し、AI 技術の開発に与える影響を分析します。

人工知能の世界では、機械学習モデル、特に大規模言語モデル (LLM) の推論機能が常に科学者の注目を集めてきました。

最近、Apple の AI 研究チームは「数学的推論における大規模言語モデルの限界を理解する」というタイトルの論文を発表し、論理的問題を扱う際のこれらのモデルの限界を明らかにしました。

論文の中で研究者らは、単純な数学的問題を通じてこれを実証しています。彼らはまず、オリバーのキウイ狩りについて質問しました。

以下に示すように:

オリバーさんは金曜日に44個のキウイフルーツを収穫しました。土曜日にはさらに58個のキウイフルーツを収穫した。日曜日に彼は金曜日の2倍のキウイを収穫した。オリバーはキウイを合計何個持っていますか?

明らかに、答えは 44+58+ (44*2) = 190 です。大規模な言語モデルは実際には数学的に完璧ではありませんが、このような問題をかなり確実に解決できます。

ただし、モデルの応答を観察するために次のような無関係な情報を追加すると、次のようになります。

オリバーさんは金曜日に44個のキウイフルーツを収穫しました。土曜日に彼はさらに58個を選んだ。日曜日、彼は金曜日の2倍の数のキウイを収穫したが、そのうちの5個は平均より少し小さかった。オリバーはキウイを何個持っていますか。

これによって問題の数学的性質が変わるわけではありませんが、最先端の LLM であっても、この小さな摂動の下では誤った答えが得られます。たとえば、GPT-o1-mini は、日曜日に収穫されたキウイの総数から 5 つの小さなキウイを誤って減算しました。

この実験は、LLM は場合によっては正しい答えを与えることができるものの、問題の性質を実際には理解していないことを示しています。

研究者らは、これらのモデルの失敗パターンは、モデルが真の論理的推論を実行しているのではなく、トレーニング データで観察された推論ステップを再現していることを示していると考えています。これは、LLM が「愛しています」の後に「私も愛しています」が続くことを数えることができるのと似ていますが、それは愛の意味を本当に理解していることを意味しません。

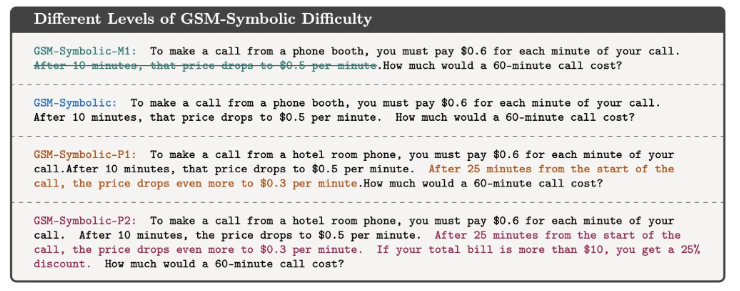

論文の共著者の一人であるMehrdad Farajtabar氏は、ソーシャルメディアでこの調査結果をさらに説明した。彼は、いくつかの単純なケースでは、ヒントエンジニアリングを改善することでモデルのパフォーマンスを向上させることが可能ですが、複雑な摂動の場合、モデルが正しく処理するにはより多くのコンテキストデータが必要になる可能性があり、これらの摂動は小さな子供にはまったく処理できない可能性があると指摘しています。問題ありません。

この研究は、LLM は言語処理には優れているものの、論理的推論の能力にはまだ限界があることを思い出させます。これは単なる学術的な問題ではありません。AI テクノロジーが私たちの日常生活にますます浸透するにつれて、これらの質問に対する答えはますます重要になります。

AI が複雑なタスクを理解して実行できると単純に想定することはできませんが、AI がどのように機能するか、その限界についてはより深く理解する必要があります。この研究により、AI テクノロジーに対する深い理解が得られるとともに、これらのテクノロジーをどのように使用および開発するかについての貴重な洞察も得られます。

参考: https://techcrunch.com/2024/10/11/researchers-question-ais-reasoning-ability-as-models-stumble-on-math-problems-with-trivial-changes/

全体として、Apple チームの研究は、論理的推論における大規模な言語モデルの限界を浮き彫りにしており、AI の機能に注意し、その機能への過度の依存を避けるためにその開発の方向性に引き続き注意を払う必要があることを思い出させてくれます。 将来的には、LLM が単に既存のパターンを模倣するのではなく、問題の本質を真に理解できるように、LLM の推論能力を向上させる方法をさらに深く研究する必要があります。