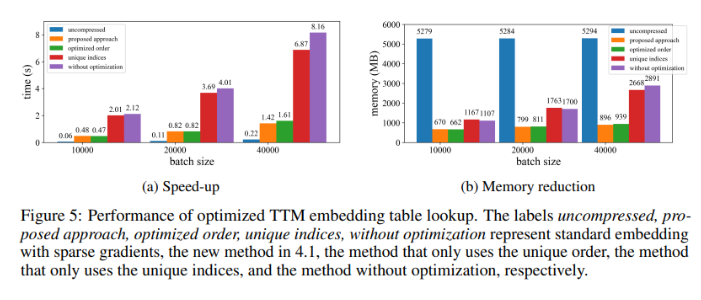

AI トレーニングは画期的な進歩を歓迎します!新しい CoMERA フレームワークにより、モデルのトレーニング コストとリソース消費が大幅に削減されます

大規模な AI モデル (Transformers や言語モデルなど) のトレーニングは、AI 分野において不可欠な重要なリンクとなっていますが、高いコンピューティング コスト、メモリ消費量、エネルギー要件にも直面しています。たとえば、OpenAI の GPT-3 には 1,750 億のパラメータがあり、数週間の GPU トレーニングが必要です。この膨大なリソース要件により、このテクノロジーは制限されます

2024-12-28